メタサイエンス

Metascience

☆ メタサイエンス(Metascienc; メタ研究とも呼ばれる)とは、科学的方法論を用いて科学そのものを研究することである。メタサイエンスは、非効率を減らしながら科学研究の質を高めようと するものである。研究がどのように行われているかを研究し、改善点を見つけるために研究手法を用いることから、「研究の研究」や「科学の科学」とも呼ばれ る。ジョン・イオアニディスの言葉を借りれば、「科学は人類に起こった最良のことである。 1966年、初期のメタ研究論文が、10誌の著名な医学雑誌に掲載された295本の論文の統計的手法を調査した。その結果、「読まれた報告のほぼ73%に おいて......結論の正当性が無効であるにもかかわらず、結論が導かれていた」ことが判明した。その後数十年にわたるメタ研究によって、多くの科学分 野における研究の方法論的欠陥、非効率性、不適切なやり方が発見された。特に医学やソフト・サイエンスの分野では、多くの科学研究が再現できなかった。再 現性の危機」という言葉は、問題意識の高まりの一環として、2010年代初頭に作られた[3]。 メタサイエンスによって明らかになった問題に対処するために、対策が実施されてきた。これらの対策には、科学的研究や臨床試験の事前登録のほか、方法論や 報告に関するガイドラインを発行するCONSORTやEQUATORネットワークのような組織の設立が含まれる。統計の誤用を減らし、学術界からの逆イン センティブを排除し、査読プロセスを改善し、学術出版システムに関するデータを体系的に収集し[4]、科学文献の偏向と闘い、科学的プロセスの全体的な質 と効率を高める努力が続けられている。このように、メタサイエンスはオープンサイエンス運動の基礎となる手法の大きな部分を占めている。

★メタサイエンスは、科学研究におこる「科学者たちの善意による誤用」を除去する免疫系システム(隠喩)である。

| Metascience (also

known as meta-research) is the use of scientific methodology to study

science itself. Metascience seeks to increase the quality of scientific

research while reducing inefficiency. It is also known as "research on

research" and "the science of science", as it uses research methods to

study how research is done and find where improvements can be made.

Metascience concerns itself with all fields of research and has been

described as "a bird's eye view of science".[1] In the words of John

Ioannidis, "Science is the best thing that has happened to human beings

... but we can do it better."[2] In 1966, an early meta-research paper examined the statistical methods of 295 papers published in ten high-profile medical journals. It found that "in almost 73% of the reports read ... conclusions were drawn when the justification for these conclusions was invalid." Meta-research in the following decades found many methodological flaws, inefficiencies, and poor practices in research across numerous scientific fields. Many scientific studies could not be reproduced, particularly in medicine and the soft sciences. The term "replication crisis" was coined in the early 2010s as part of a growing awareness of the problem.[3] Measures have been implemented to address the issues revealed by metascience. These measures include the pre-registration of scientific studies and clinical trials as well as the founding of organizations such as CONSORT and the EQUATOR Network that issue guidelines for methodology and reporting. There are continuing efforts to reduce the misuse of statistics, to eliminate perverse incentives from academia, to improve the peer review process, to systematically collect data about the scholarly publication system,[4] to combat bias in scientific literature, and to increase the overall quality and efficiency of the scientific process. As such, metascience is a big part of methods underlying the Open Science Movement. |

メタサイエンス(メタ研究とも呼ばれる)とは、科学的方法論を用いて科

学そのものを研究することである。メタサイエンスは、非効率を減らしながら科学研究の質を高めようとするものである。研究がどのように行われているかを研

究し、改善点を見つけるために研究手法を用いることから、「研究の研究」や「科学の科学」とも呼ばれる。ジョン・イオアニディスの言葉を借りれば、「科学

は人類に起こった最良のことである。 1966年、初期のメタ研究論文が、10誌の著名な医学雑誌に掲載された295本の論文の統計的手法を調査した。その結果、「読まれた報告のほぼ73%に おいて......結論の正当性が無効であるにもかかわらず、結論が導かれていた」ことが判明した。その後数十年にわたるメタ研究によって、多くの科学分 野における研究の方法論的欠陥、非効率性、不適切なやり方が発見された。特に医学やソフト・サイエンスの分野では、多くの科学研究が再現できなかった。再 現性の危機」という言葉は、問題意識の高まりの一環として、2010年代初頭に作られた[3]。 メタサイエンスによって明らかになった問題に対処するために、対策が実施されてきた。これらの対策には、科学的研究や臨床試験の事前登録のほか、方法論や 報告に関するガイドラインを発行するCONSORTやEQUATORネットワークのような組織の設立が含まれる。統計の誤用を減らし、学術界からの逆イン センティブを排除し、査読プロセスを改善し、学術出版システムに関するデータを体系的に収集し[4]、科学文献の偏向と闘い、科学的プロセスの全体的な質 と効率を高める努力が続けられている。このように、メタサイエンスはオープンサイエンス運動の基礎となる手法の大きな部分を占めている。 |

History John Ioannidis (2005), "Why Most Published Research Findings Are False"[5] Ioannidis JPA (2005) Why Most Published Research Findings Are False. PLoS Med 2(8): e124. doi:10.1371/journal.pmed.0020124 In 1966, an early meta-research paper examined the statistical methods of 295 papers published in ten high-profile medical journals. It found that, "in almost 73% of the reports read ... conclusions were drawn when the justification for these conclusions was invalid."[6] A paper in 1976 called for funding for meta-research: "Because the very nature of research on research, particularly if it is prospective, requires long periods of time, we recommend that independent, highly competent groups be established with ample, long term support to conduct and support retrospective and prospective research on the nature of scientific discovery".[7] In 2005, John Ioannidis published a paper titled "Why Most Published Research Findings Are False", which argued that a majority of papers in the medical field produce conclusions that are wrong.[5] The paper went on to become the most downloaded paper in the Public Library of Science[8][9] and is considered foundational to the field of metascience.[10] In a related study with Jeremy Howick and Despina Koletsi, Ioannidis showed that only a minority of medical interventions are supported by 'high quality' evidence according to The Grading of Recommendations Assessment, Development and Evaluation (GRADE) approach.[11] Later meta-research identified widespread difficulty in replicating results in many scientific fields, including psychology and medicine. This problem was termed "the replication crisis". Metascience has grown as a reaction to the replication crisis and to concerns about waste in research.[12] Many prominent publishers are interested in meta-research and in improving the quality of their publications. Top journals such as Science, The Lancet, and Nature, provide ongoing coverage of meta-research and problems with reproducibility.[13] In 2012 PLOS ONE launched a Reproducibility Initiative. In 2015 Biomed Central introduced a minimum-standards-of-reporting checklist to four titles. The first international conference in the broad area of meta-research was the Research Waste/EQUATOR conference held in Edinburgh in 2015; the first international conference on peer review was the Peer Review Congress held in 1989.[14] In 2016, Research Integrity and Peer Review was launched. The journal's opening editorial called for "research that will increase our understanding and suggest potential solutions to issues related to peer review, study reporting, and research and publication ethics".[15] |

歴史 ジョン・イオアニディス(2005年)「発表された研究結果のほとんどが誤りである理由」[5]。 Ioannidis JPA (2005) Why Most Published Research Findings Are False. PLoS Med 2(8): e124. doi:10.1371/journal.pmed.0020124 1966年、10誌の著名な医学雑誌に掲載された295の論文の統計的手法を調べた初期のメタ研究論文がある。その結果、「読まれた報告のほぼ73%にお いて......結論の正当性が無効であるにもかかわらず、結論が導かれている」ことが判明した[6]: 「科学的発見の本質に関するレトロスペクティブおよびプロスペクティブ研究を実施し、支援するために、十分な長期的支援を受けられる、独立した、非常に有 能なグループを設立することを推奨する。 [イオアニディスは、ジェレミー・ハウイックとデスピナ・コレツィとの関連研究で、医療介入のうち、GRADE(Grading of Recommendations Assessment, Development and Evaluation:推奨の評価・開発・評価の段階的評価)アプローチに従った「質の高い」エビデンスによって裏付けられているものは少数派であること を示した[11]。その後のメタ研究によって、心理学や医学を含む多くの科学分野において、結果の再現が広く困難であることが明らかになった。この問題は 「再現性の危機」と呼ばれた。メタサイエンスは、再現性の危機に対する反応として、また研究の無駄に対する懸念として発展してきた[12]。 多くの著名な出版社は、メタ研究と出版物の質の向上に関心を持っている。Science, The Lancet, Natureなどのトップジャーナルは、メタ研究や再現性の問題を継続的に取り上げている[13]。2015年にはBiomed Centralが4つのタイトルに最低基準報告チェックリストを導入した。 メタ研究の広範な領域における最初の国際会議は、2015年にエジンバラで開催されたResearch Waste/EQUATOR会議であり、査読に関する最初の国際会議は1989年に開催されたPeer Review Congressであった[14]。 2016年、Research Integrity and Peer Reviewが創刊された。同誌の巻頭論説は、「査読、研究報告、研究・出版倫理に関連する問題に対する理解を深め、潜在的な解決策を示唆する研究」を求 めている[15]。 |

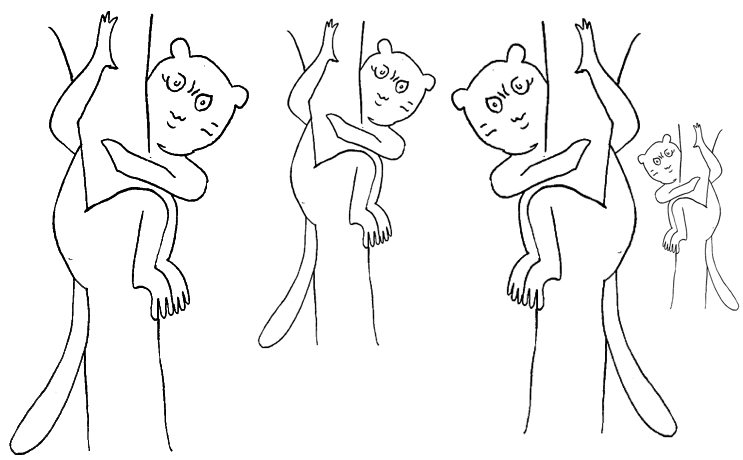

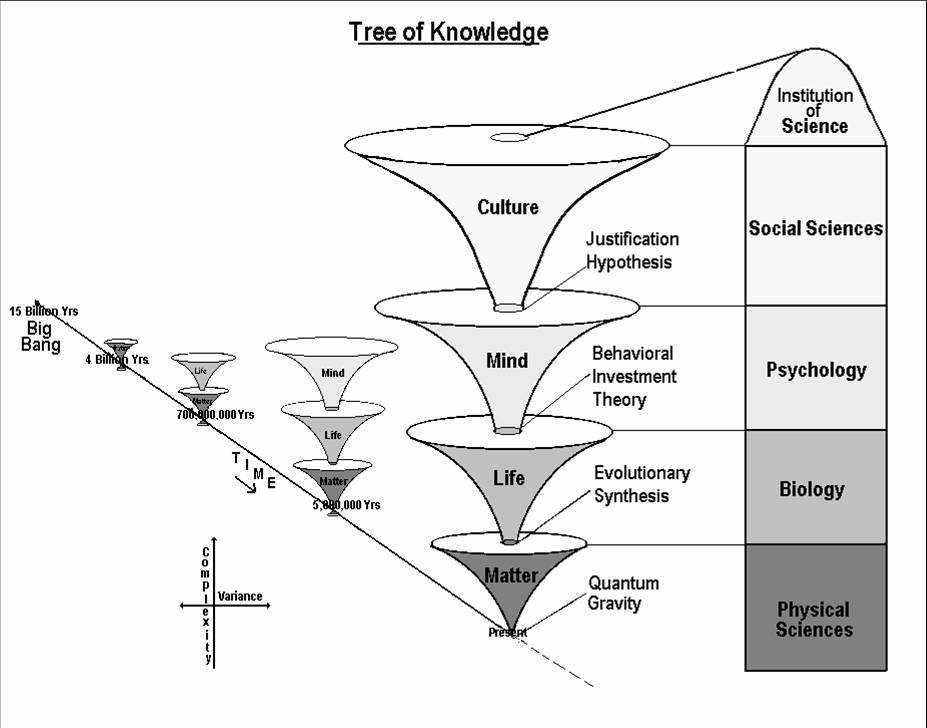

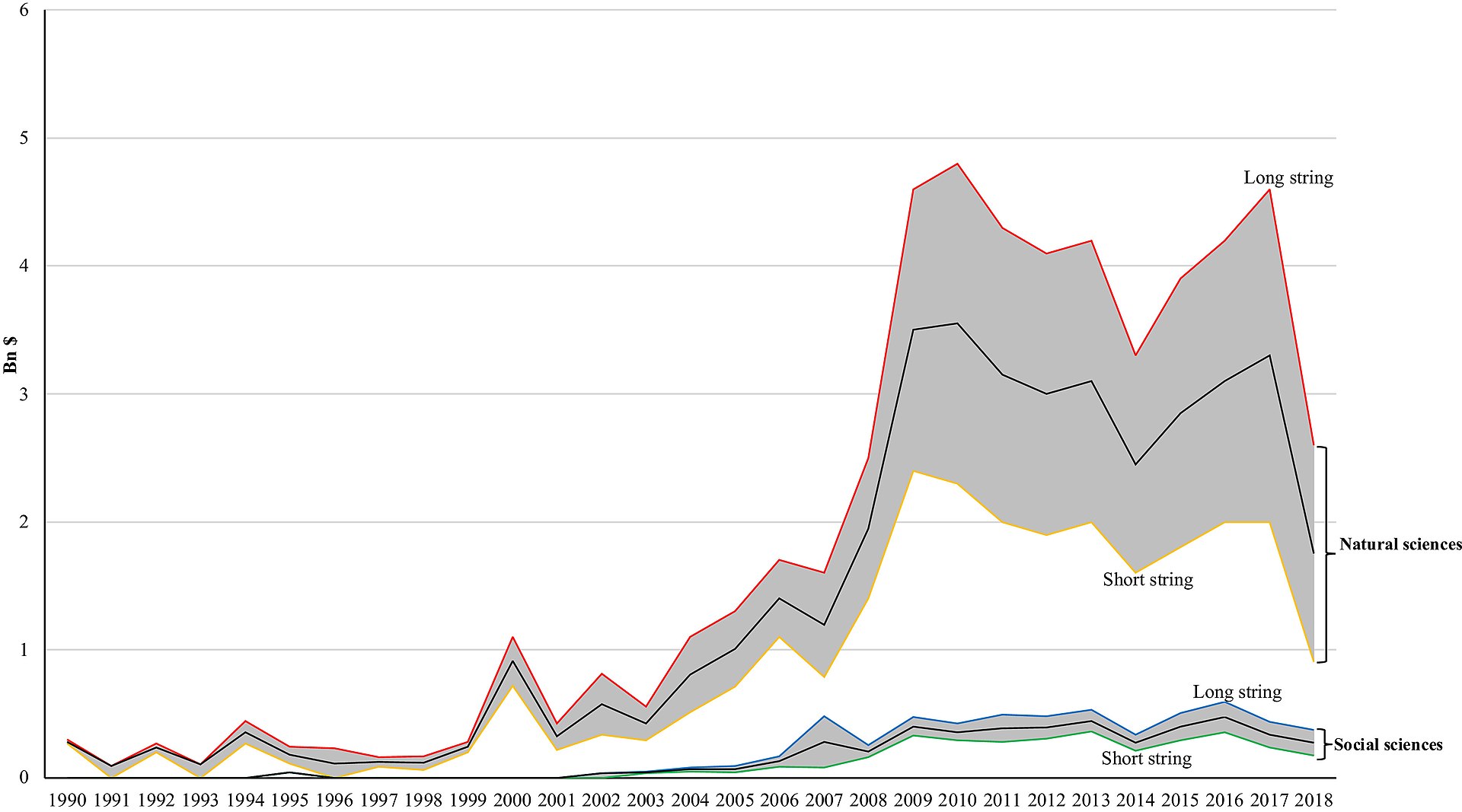

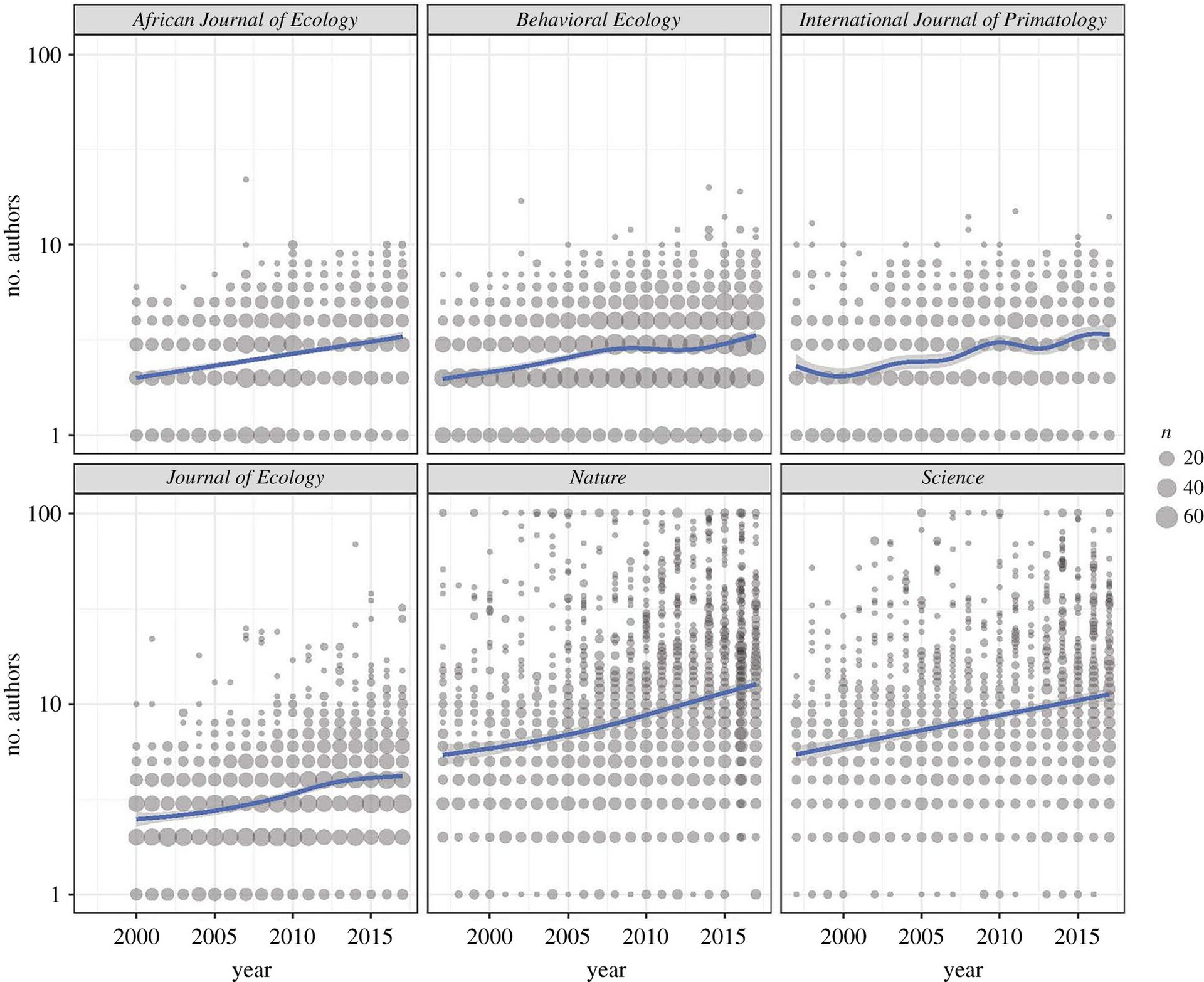

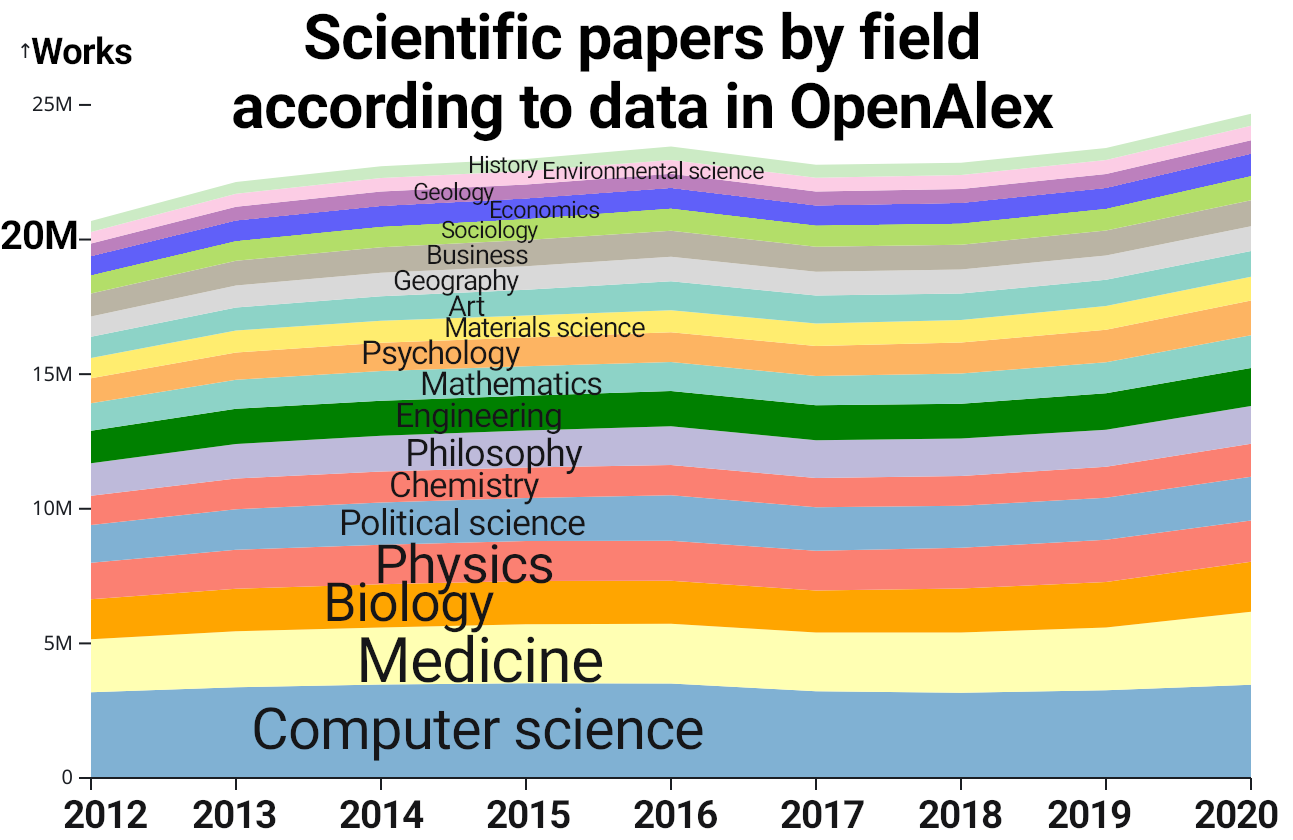

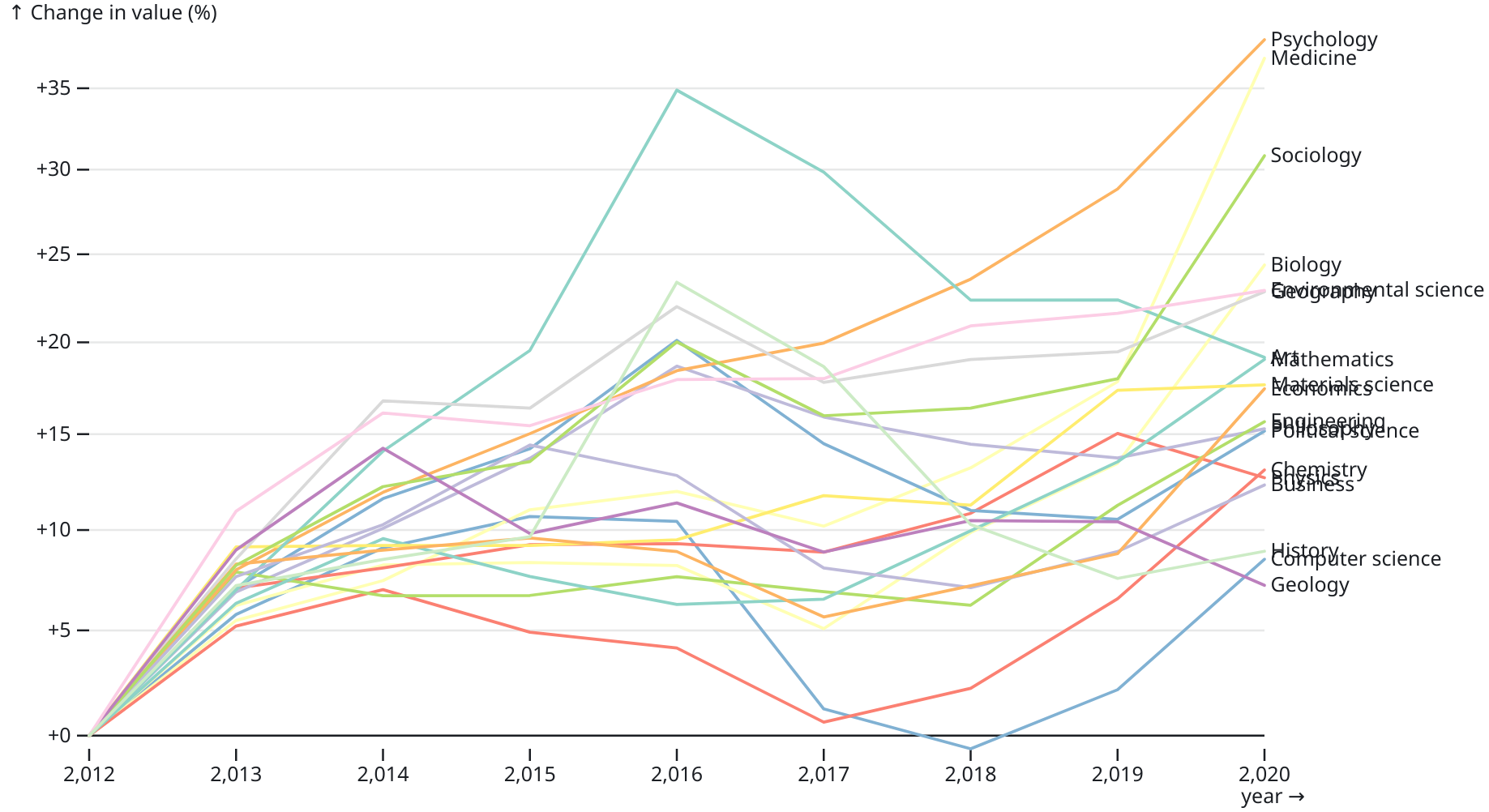

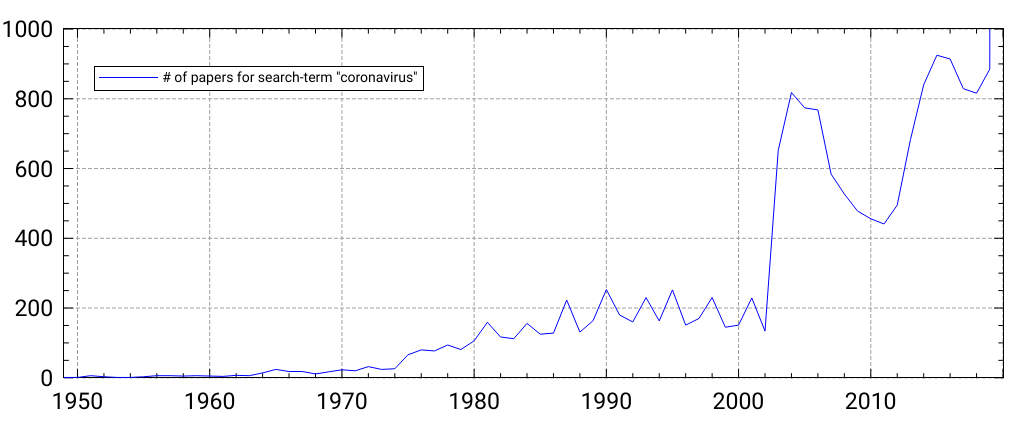

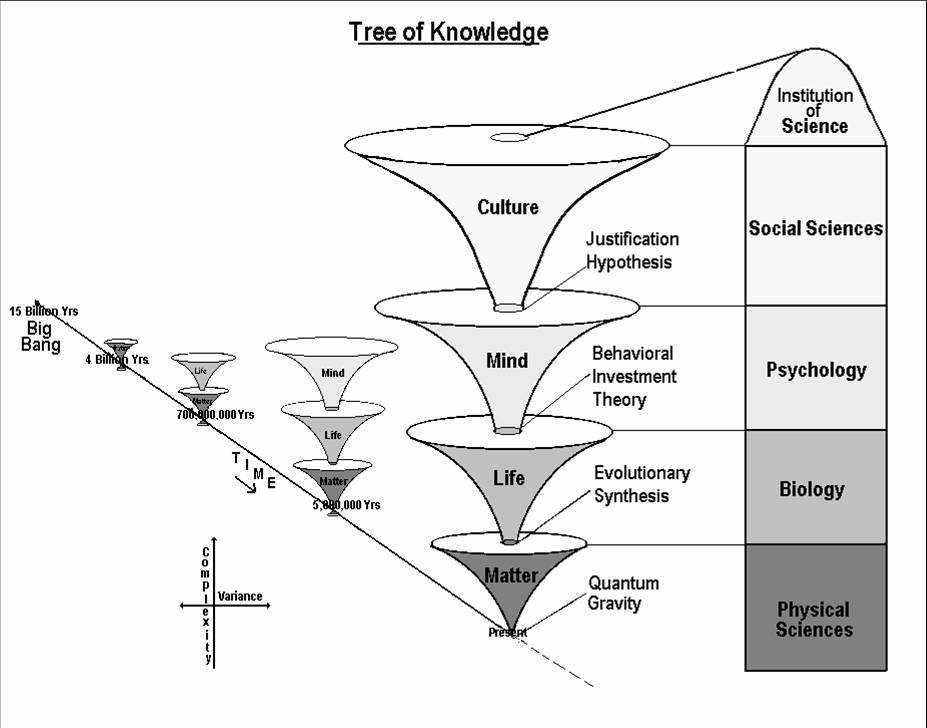

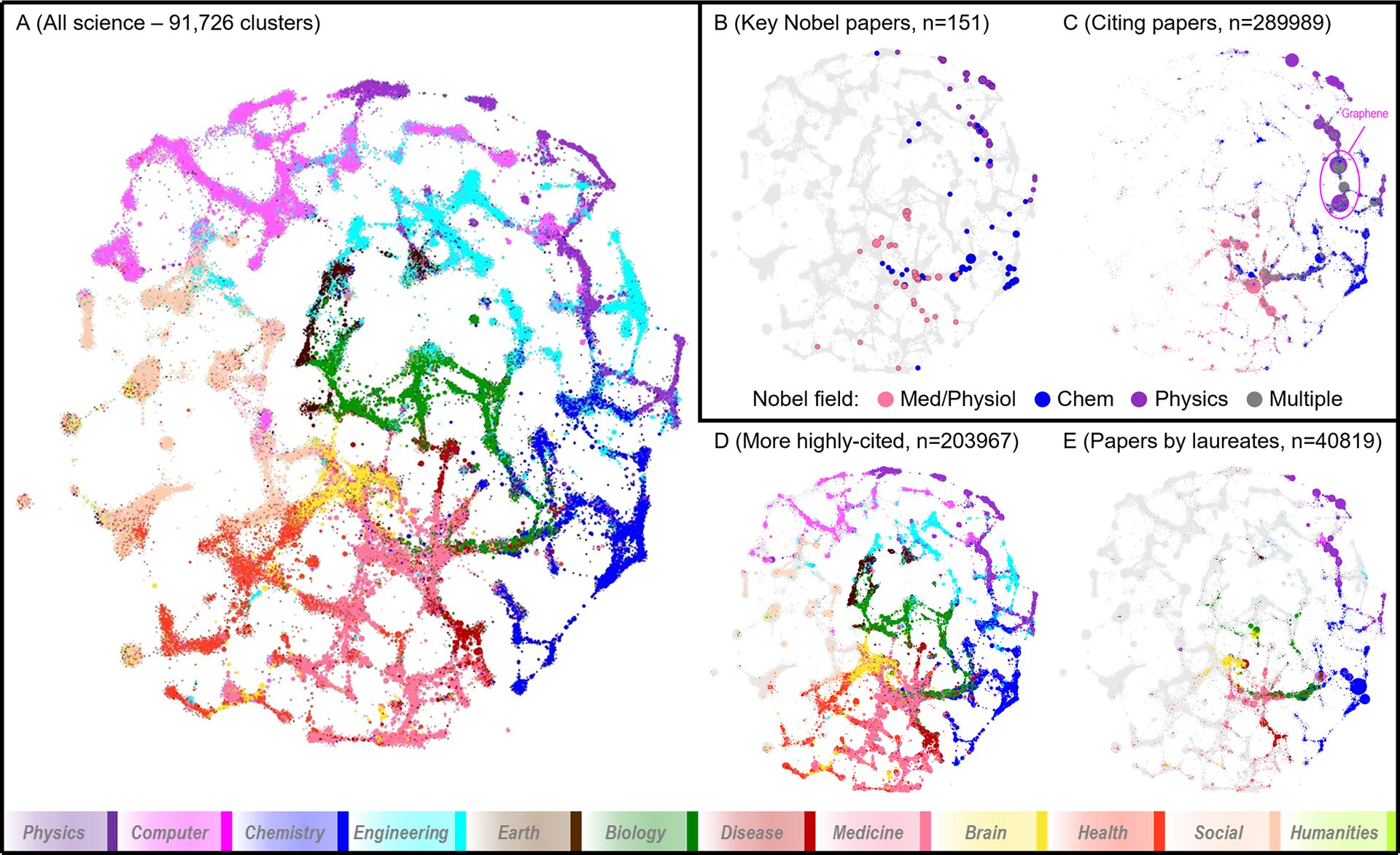

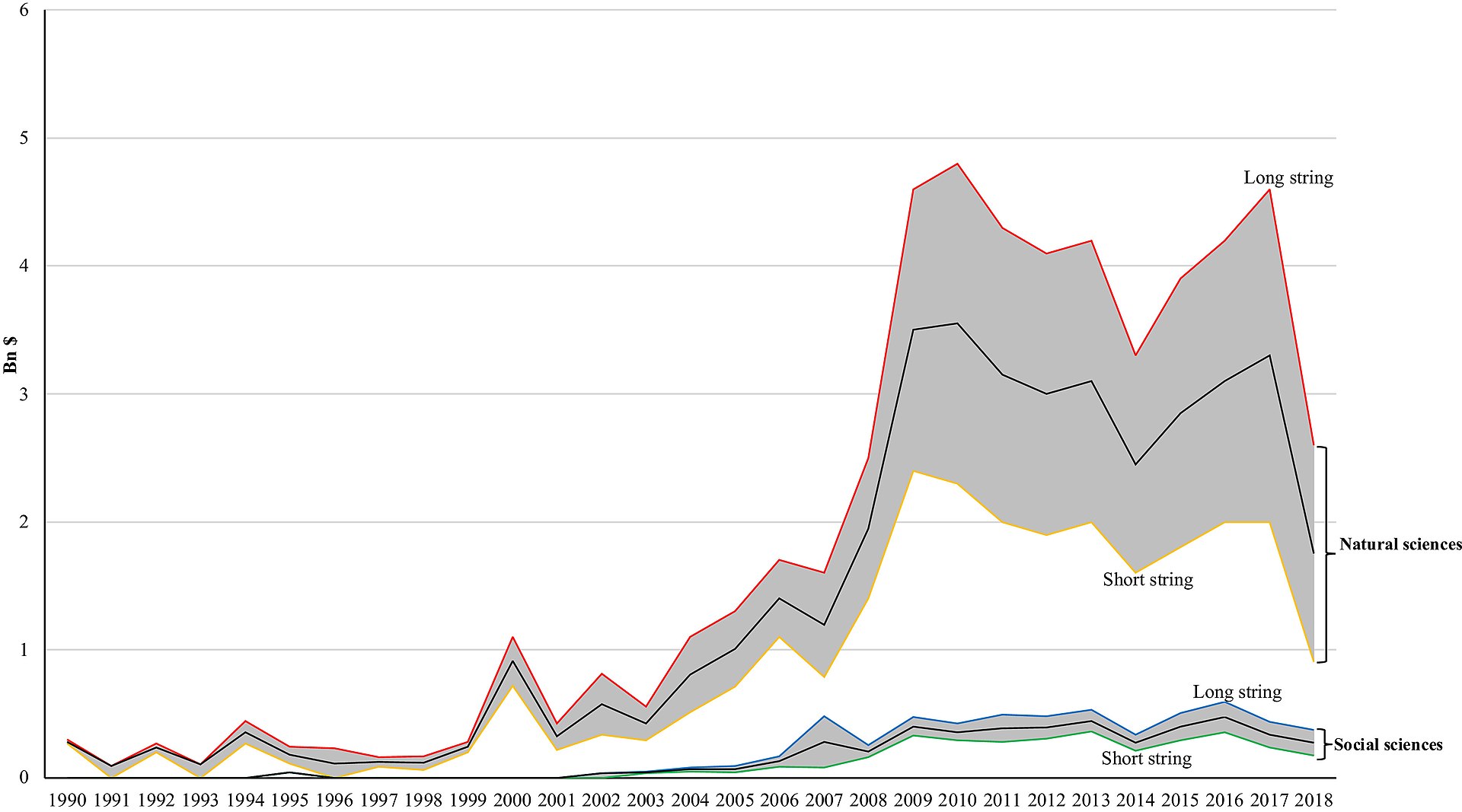

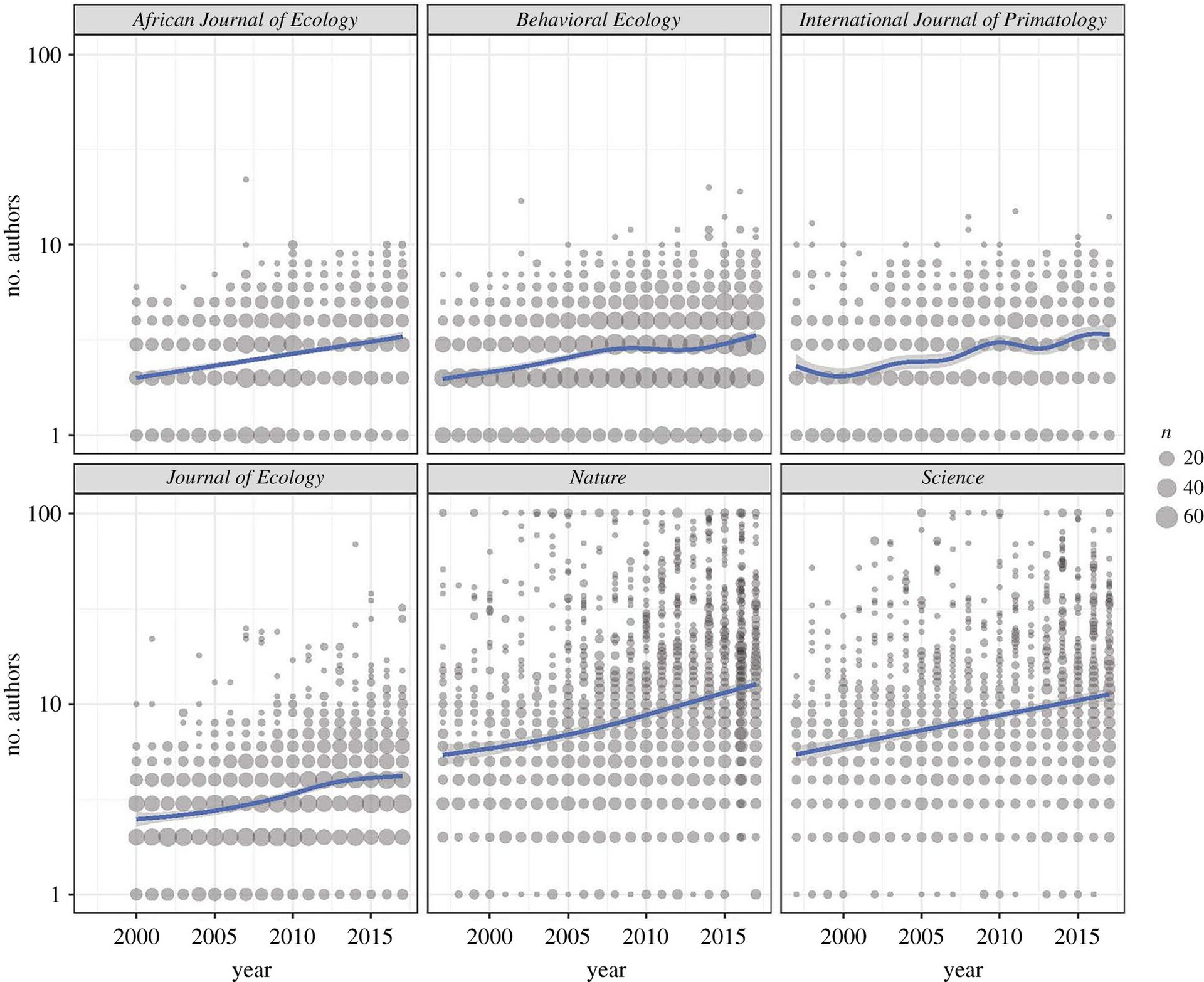

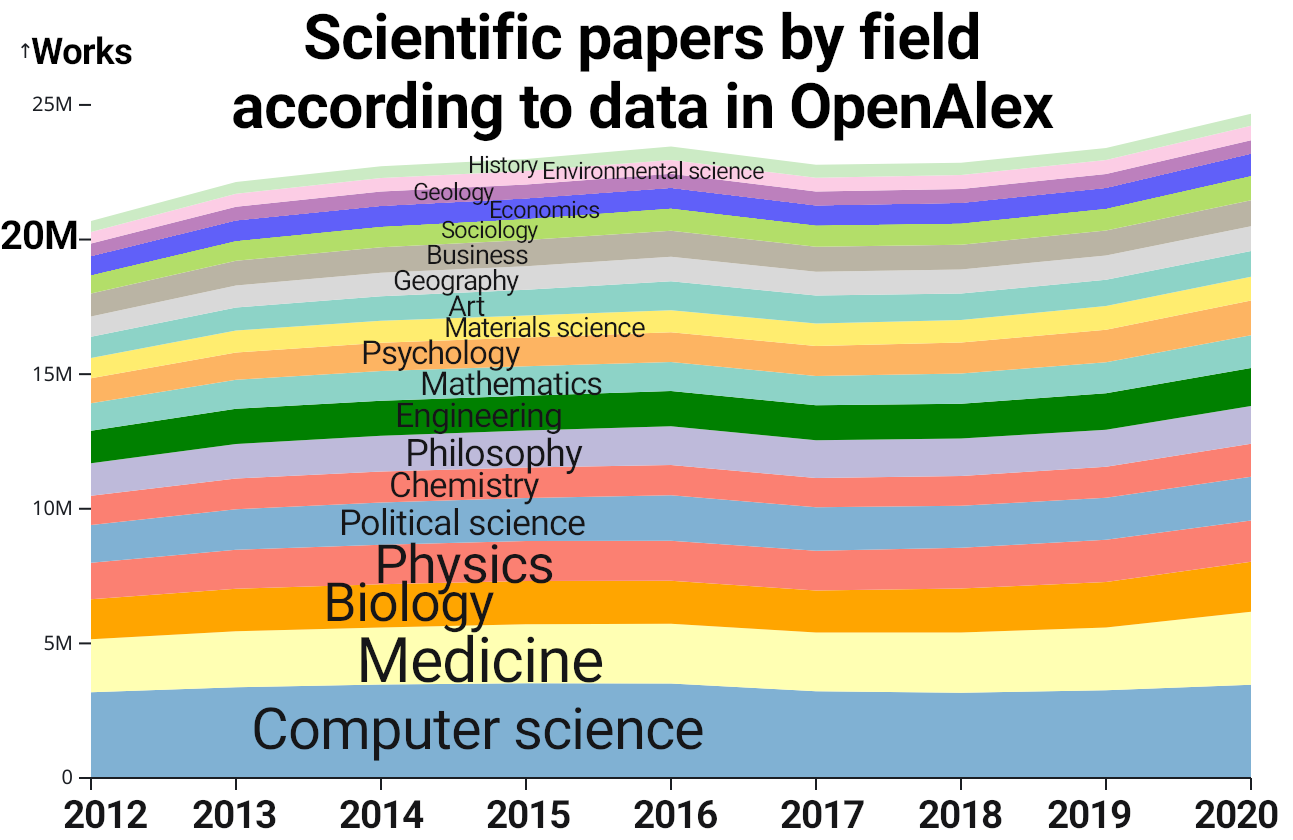

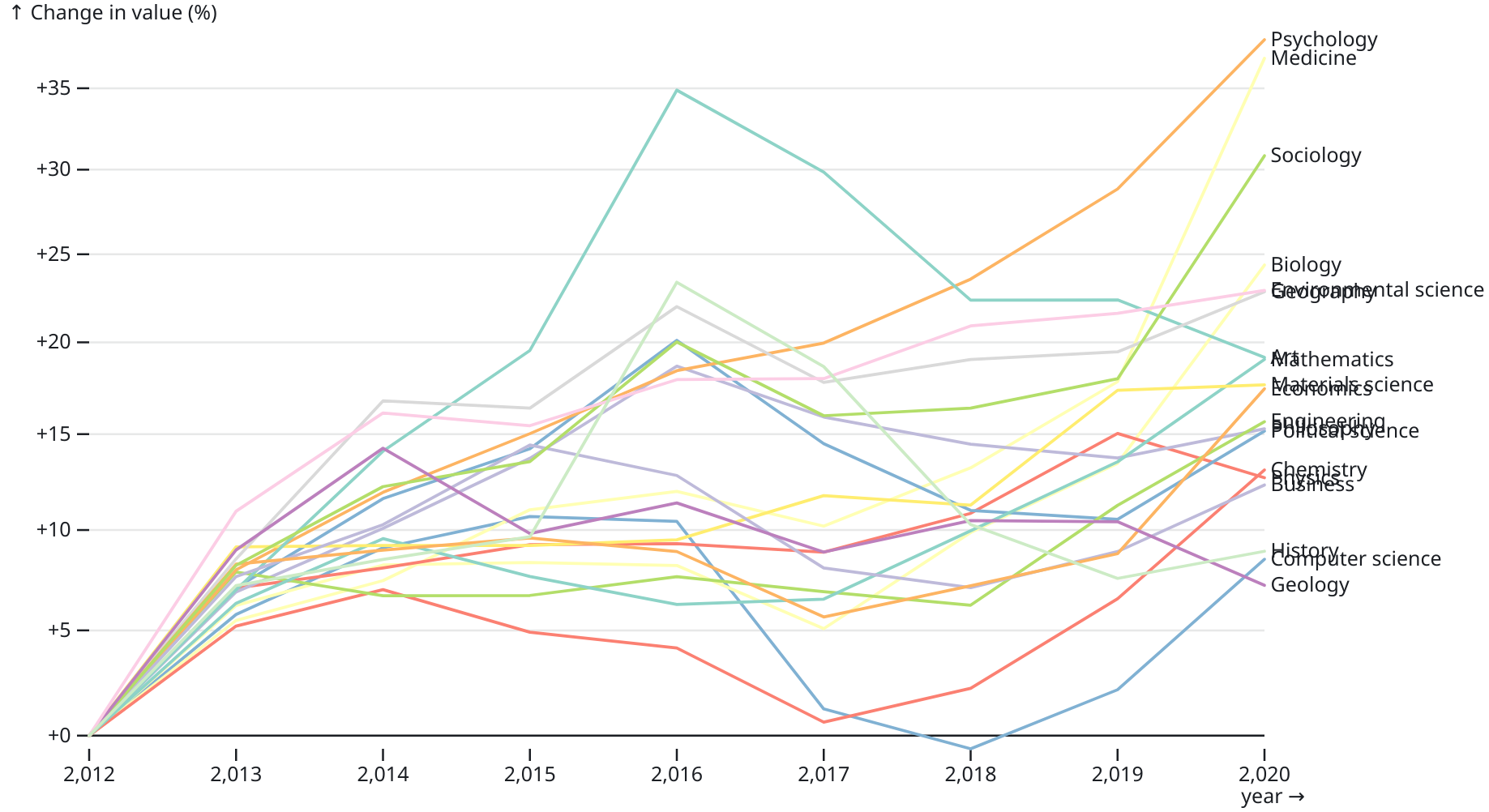

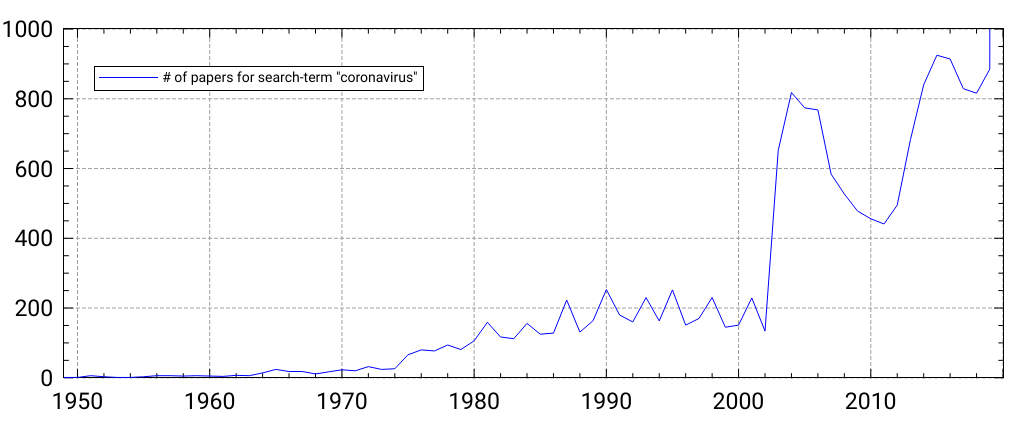

Fields and topics of meta-research An exemplary visualization of a conception of scientific knowledge generation structured by layers, with the "Institution of Science" being the subject of metascience Metascience can be categorized into five major areas of interest: Methods, Reporting, Reproducibility, Evaluation, and Incentives. These correspond, respectively, with how to perform, communicate, verify, evaluate, and reward research.[1] Methods Metascience seeks to identify poor research practices, including biases in research, poor study design, abuse of statistics, and to find methods to reduce these practices.[1] Meta-research has identified numerous biases in scientific literature.[16] Of particular note is the widespread misuse of p-values and abuse of statistical significance.[17] Scientific data science Scientific data science is the use of data science to analyse research papers. It encompasses both qualitative and quantitative methods. Research in scientific data science includes fraud detection[18] and citation network analysis.[19] Journalology Main article: Journalology Journalology, also known as publication science, is the scholarly study of all aspects of the academic publishing process.[20][21] The field seeks to improve the quality of scholarly research by implementing evidence-based practices in academic publishing.[22] The term "journalology" was coined by Stephen Lock, the former editor-in-chief of The BMJ. The first Peer Review Congress, held in 1989 in Chicago, Illinois, is considered a pivotal moment in the founding of journalology as a distinct field.[22] The field of journalology has been influential in pushing for study pre-registration in science, particularly in clinical trials. Clinical-trial registration is now expected in most countries.[22] Reporting Meta-research has identified poor practices in reporting, explaining, disseminating and popularizing research, particularly within the social and health sciences. Poor reporting makes it difficult to accurately interpret the results of scientific studies, to replicate studies, and to identify biases and conflicts of interest in the authors. Solutions include the implementation of reporting standards, and greater transparency in scientific studies (including better requirements for disclosure of conflicts of interest). There is an attempt to standardize reporting of data and methodology through the creation of guidelines by reporting agencies such as CONSORT and the larger EQUATOR Network.[1] Reproducibility Further information: Replication crisis and Reproducibility  Barriers to conducting replications of experiment in cancer research, The Reproducibility Project: Cancer Biology The replication crisis is an ongoing methodological crisis in which it has been found that many scientific studies are difficult or impossible to replicate.[23][24] While the crisis has its roots in the meta-research of the mid- to late 20th century, the phrase "replication crisis" was not coined until the early 2010s[25] as part of a growing awareness of the problem.[1] The replication crisis has been closely studied in psychology (especially social psychology) and medicine,[26][27] including cancer research.[28][29] Replication is an essential part of the scientific process, and the widespread failure of replication puts into question the reliability of affected fields.[30] Moreover, replication of research (or failure to replicate) is considered less influential than original research, and is less likely to be published in many fields. This discourages the reporting of, and even attempts to replicate, studies.[31][32] Evaluation and incentives See also: Academic journal § Prestige and ranking Metascience seeks to create a scientific foundation for peer review. Meta-research evaluates peer review systems including pre-publication peer review, post-publication peer review, and open peer review. It also seeks to develop better research funding criteria.[1] Metascience seeks to promote better research through better incentive systems. This includes studying the accuracy, effectiveness, costs, and benefits of different approaches to ranking and evaluating research and those who perform it.[1] Critics argue that perverse incentives have created a publish-or-perish environment in academia which promotes the production of junk science, low quality research, and false positives.[33][34] According to Brian Nosek, "The problem that we face is that the incentive system is focused almost entirely on getting research published, rather than on getting research right."[35] Proponents of reform seek to structure the incentive system to favor higher-quality results.[36] For example, by quality being judged on the basis of narrative expert evaluations ("rather than [only or mainly] indices"), institutional evaluation criteria, guaranteeing of transparency, and professional standards.[37] Contributorship Studies proposed machine-readable standards and (a taxonomy of) badges for science publication management systems that hones in on contributorship – who has contributed what and how much of the research labor – rather that using traditional concept of plain authorship – who was involved in any way creation of a publication.[38][39][40][41] A study pointed out one of the problems associated with the ongoing neglect of contribution nuanciation – it found that "the number of publications has ceased to be a good metric as a result of longer author lists, shorter papers, and surging publication numbers".[42] Assessment factors Factors other than a submission's merits can substantially influence peer reviewers' evaluations.[43] Such factors may however also be important such as the use of track-records about the veracity of a researchers' prior publications and its alignment with public interests. Nevertheless, evaluation systems – include those of peer-review – may substantially lack mechanisms and criteria that are oriented or well-performingly oriented towards merit, real-world positive impact, progress and public usefulness rather than analytical indicators such as number of citations or altmetrics even when such can be used as partial indicators of such ends.[44][45] Rethinking of the academic reward structure "to offer more formal recognition for intermediate products, such as data" could have positive impacts and reduce data withholding.[46] Recognition of training A commentary noted that academic rankings don't consider where (country and institute) the respective researchers were trained.[47] Scientometrics Main article: Scientometrics Scientometrics concerns itself with measuring bibliographic data in scientific publications. Major research issues include the measurement of the impact of research papers and academic journals, the understanding of scientific citations, and the use of such measurements in policy and management contexts.[48] Studies suggest that "metrics used to measure academic success, such as the number of publications, citation number, and impact factor, have not changed for decades" and have to some degrees "ceased" to be good measures,[42] leading to issues such as "overproduction, unnecessary fragmentations, overselling, predatory journals (pay and publish), clever plagiarism, and deliberate obfuscation of scientific results so as to sell and oversell".[49] Novel tools in this area include systems to quantify how much the cited-node informs the citing-node.[50] This can be used to convert unweighted citation networks to a weighted one and then for importance assessment, deriving "impact metrics for the various entities involved, like the publications, authors etc"[51] as well as, among other tools, for search engine- and recommendation systems. Science governance See also: Science policy and Science of science policy Science funding and science governance can also be explored and informed by metascience.[52] Incentives Various interventions such as prioritization can be important. For instance, the concept of differential technological development refers to deliberately developing technologies – e.g. control-, safety- and policy-technologies versus risky biotechnologies – at different precautionary paces to decrease risks, mainly global catastrophic risk, by influencing the sequence in which technologies are developed.[53][54] Relying only on the established form of legislation and incentives to ensure the right outcomes may not be adequate as these may often be too slow[55] or inappropriate. Other incentives to govern science and related processes, including via metascience-based reforms, may include ensuring accountability to the public (in terms of e.g. accessibility of, especially publicly-funded, research or of it addressing various research topics of public interest in serious manners), increasing the qualified productive scientific workforce, improving the efficiency of science to improve problem-solving in general, and facilitating that unambiguous societal needs based on solid scientific evidence – such as about human physiology – are adequately prioritized and addressed. Such interventions, incentives and intervention-designs can be subjects of metascience. Science funding and awards See also: Patent § Criticism  Cluster network of scientific publications in relation to Nobel prizes  Funding for climate research in the natural and technical sciences versus the social sciences and humanities[56] Scientific awards are one category of science incentives. Metascience can explore existing and hypothetical systems of science awards. For instance, it found that work honored by Nobel prizes clusters in only a few scientific fields with only 36/71 having received at least one Nobel prize of the 114/849 domains science could be divided into according to their DC2 and DC3 classification systems. Five of the 114 domains were shown to make up over half of the Nobel prizes awarded 1995–2017 (particle physics [14%], cell biology [12.1%], atomic physics [10.9%], neuroscience [10.1%], molecular chemistry [5.3%]).[57][58] A study found that delegation of responsibility by policy-makers – a centralized authority-based top-down approach – for knowledge production and appropriate funding to science with science subsequently somehow delivering "reliable and useful knowledge to society" is too simple.[52] Measurements show that allocation of bio-medical resources can be more strongly correlated to previous allocations and research than to burden of diseases.[59] A study suggests that "[i]f peer review is maintained as the primary mechanism of arbitration in the competitive selection of research reports and funding, then the scientific community needs to make sure it is not arbitrary".[43] Studies indicate there to is a need to "reconsider how we measure success" (see #Factors of success and progress).[42] Funding data Funding information from grant databases and funding acknowledgment sections can be sources of data for scientometrics studies, e.g. for investigating or recognition of the impact of funding entities on the development of science and technology.[60] Research questions and coordination Main article: Research question § Aggregated research questions and coordination Risk governance Main article: Biosecurity § Future Science communication and public use See also: Science § Science and the public It has been argued that "science has two fundamental attributes that underpin its value as a global public good: that knowledge claims and the evidence on which they are based are made openly available to scrutiny, and that the results of scientific research are communicated promptly and efficiently".[61] Metascientific research is exploring topics of science communication such as media coverage of science, science journalism and online communication of results by science educators and scientists.[62][63][64][65] A study found that the "main incentive academics are offered for using social media is amplification" and that it should be "moving towards an institutional culture that focuses more on how these [or such] platforms can facilitate real engagement with research".[66] Science communication may also involve the communication of societal needs, concerns and requests to scientists. Alternative metrics tools Alternative metrics tools can be used not only for help in assessment (performance and impact)[59] and findability, but also aggregate many of the public discussions about a scientific paper in social media such as reddit, citations on Wikipedia, and reports about the study in the news media which can then in turn be analyzed in metascience or provided and used by related tools.[67] In terms of assessment and findability, altmetrics rate publications' performance or impact by the interactions they receive through social media or other online platforms,[68] which can for example be used for sorting recent studies by measured impact, including before other studies are citing them. The specific procedures of established altmetrics are not transparent[68] and the used algorithms can not be customized or altered by the user as open source software can. A study has described various limitations of altmetrics and points "toward avenues for continued research and development".[69] They are also limited in their use as a primary tool for researchers to find received constructive feedback. (see above) Societal implications and applications It has been suggested that it may benefit science if "intellectual exchange—particularly regarding the societal implications and applications of science and technology—are better appreciated and incentivized in the future".[59] Knowledge integration Primary studies "without context, comparison or summary are ultimately of limited value" and various types[additional citation(s) needed] of research syntheses and summaries integrate primary studies.[70] Progress in key social-ecological challenges of the global environmental agenda is "hampered by a lack of integration and synthesis of existing scientific evidence", with a "fast-increasing volume of data", compartmentalized information and generally unmet evidence synthesis challenges.[71] According to Khalil, researchers are facing the problem of too many papers – e.g. in March 2014 more than 8,000 papers were submitted to arXiv – and to "keep up with the huge amount of literature, researchers use reference manager software, they make summaries and notes, and they rely on review papers to provide an overview of a particular topic". He notes that review papers are usually (only)" for topics in which many papers were written already, and they can get outdated quickly" and suggests "wiki-review papers" that get continuously updated with new studies on a topic and summarize many studies' results and suggest future research.[72] A study suggests that if a scientific publication is being cited in a Wikipedia article this could potentially be considered as an indicator of some form of impact for this publication,[68] for example as this may, over time, indicate that the reference has contributed to a high-level of summary of the given topic. Science journalism Science journalists play an important role in the scientific ecosystem and in science communication to the public and need to "know how to use, relevant information when deciding whether to trust a research finding, and whether and how to report on it", vetting the findings that get transmitted to the public.[73] Science education Some studies investigate science education, e.g. the teaching about selected scientific controversies[74] and historical discovery process of major scientific conclusions,[75] and common scientific misconceptions.[76] Education can also be a topic more generally such as how to improve the quality of scientific outputs and reduce the time needed before scientific work or how to enlarge and retain various scientific workforces. Science misconceptions and anti-science attitudes Further information: Science § Anti-science attitudes, Media literacy, and Misinformation § Countermeasures Many students have misconceptions about what science is and how it works.[77] Anti-science attitudes and beliefs are also a subject of research.[78][79] Hotez suggests antiscience "has emerged as a dominant and highly lethal force, and one that threatens global security", and that there is a need for "new infrastructure" that mitigates it.[80] Evolution of sciences Scientific practice  Number of authors of research articles in six journals through time[37]  Trends of diversity of work cited, mean number of self-citations, and mean age of cited work may indicate papers are using "narrower portions of existing knowledge".[81] Metascience can investigate how scientific processes evolve over time. A study found that teams are growing in size, "increasing by an average of 17% per decade".[59] (see labor advantage below)  ArXiv's yearly submission rate growth over 30 years[82] It was found that prevalent forms of non-open access publication and prices charged for many conventional journals – even for publicly funded papers – are unwarranted, unnecessary – or suboptimal – and detrimental barriers to scientific progress.[61][83][84][85] Open access can save considerable amounts of financial resources, which could be used otherwise, and level the playing field for researchers in developing countries.[86] There are substantial expenses for subscriptions, gaining access to specific studies, and for article processing charges. Paywall: The Business of Scholarship is a documentary on such issues.[87] Another topic are the established styles of scientific communication (e.g. long text-form studies and reviews) and the scientific publishing practices – there are concerns about a "glacial pace" of conventional publishing.[88] The use of preprint-servers to publish study-drafts early is increasing and open peer review,[89] new tools to screen studies,[90] and improved matching of submitted manuscripts to reviewers[91] are among the proposals to speed up publication. Science overall and intrafield developments  A visualization of scientific outputs by field in OpenAlex.[92] A study can be part of multiple fields[clarification needed] and lower numbers of papers is not necessarily detrimental[49] for fields.  Change of number of scientific papers by field according to OpenAlex[92]  Number of PubMed search results for "coronavirus" by year from 1949 to 2020 Studies have various kinds of metadata which can be utilized, complemented and made accessible in useful ways. OpenAlex is a free online index of over 200 million scientific documents that integrates and provides metadata such as sources, citations, author information, scientific fields and research topics. Its API and open source website can be used for metascience, scientometrics and novel tools that query this semantic web of papers.[93][94][95] Another project under development, Scholia, uses metadata of scientific publications for various visualizations and aggregation features such as providing a simple user interface summarizing literature about a specific feature of the SARS-CoV-2 virus using Wikidata's "main subject" property.[96] Subject-level resolutions Beyond metadata explicitly assigned to studies by humans, natural language processing and AI can be used to assign research publications to topics – one study investigating the impact of science awards used such to associate a paper's text (not just keywords) with the linguistic content of Wikipedia's scientific topics pages ("pages are created and updated by scientists and users through crowdsourcing"), creating meaningful and plausible classifications of high-fidelity scientific topics for further analysis or navigability.[97] Growth or stagnation of science overall Further information: Scientific method § History, and Philosophy of science  Rough trend of scholarly publications about biomarkers according to Scholia; biomarker-related publications may not follow closely the number of viable biomarkers.[98]  The CD index for papers published in Nature, PNAS, and Science and Nobel-Prize-winning papers[81]  The CD index may indicate a "decline of disruptive science and technology".[81] [81]Park, Michael; Leahey, Erin; Funk, Russell J. (January 2023). "Papers and patents are becoming less disruptive over time". Nature. 613 (7942): 138–144. Bibcode:2023Natur.613..138P. doi:10.1038/s41586-022-05543-x. ISSN 1476-4687. PMID 36600070. S2CID 255466666. Metascience research is investigating the growth of science overall, using e.g. data on the number of publications in bibliographic databases. A study found segments with different growth rates appear related to phases of "economic (e.g., industrialization)" – money is considered as necessary input to the science system – "and/or political developments (e.g., Second World War)". It also confirmed a recent exponential growth in the volume of scientific literature and calculated an average doubling period of 17.3 years.[99] However, others have pointed out that is difficult to measure scientific progress in meaningful ways, partly because it's hard to accurately evaluate how important any given scientific discovery is. A variety of perspectives of the trajectories of science overall (impact, number of major discoveries, etc) have been described in books and articles, including that science is becoming harder (per dollar or hour spent), that if science "slowing today, it is because science has remained too focused on established fields", that papers and patents are increasingly less likely to be "disruptive" in terms of breaking with the past as measured by the "CD index",[81] and that there is a great stagnation – possibly as part of a larger trend[100] – whereby e.g. "things haven't changed nearly as much since the 1970s" when excluding the computer and the Internet. Better understanding of potential slowdowns according to some measures could be a major opportunity to improve humanity's future.[101] For example, emphasis on citations in the measurement of scientific productivity, information overloads,[100] reliance on a narrower set of existing knowledge (which may include narrow specialization and related contemporary practices) based on three "use of previous knowledge"-indicators,[81] and risk-avoidant funding structures[102] may have "toward incremental science and away from exploratory projects that are more likely to fail".[103] The study that introduced the "CD index" suggests the overall number of papers has risen while the total of "highly disruptive" papers as measured by the index hasn't (notably, the 1998 discovery of the accelerating expansion of the universe has a CD index of 0). Their results also suggest scientists and inventors "may be struggling to keep up with the pace of knowledge expansion".[104][81] Various ways of measuring "novelty" of studies, novelty metrics,[103] have been proposed to balance a potential anti-novelty bias – such as textual analysis[103] or measuring whether it makes first-time-ever combinations of referenced journals, taking into account the difficulty.[105] Other approaches include pro-actively funding risky projects.[59] (see above) Topic mapping Science maps could show main interrelated topics within a certain scientific domain, their change over time, and their key actors (researchers, institutions, journals). They may help find factors determine the emergence of new scientific fields and the development of interdisciplinary areas and could be relevant for science policy purposes.[106] (see above) Theories of scientific change could guide "the exploration and interpretation of visualized intellectual structures and dynamic patterns".[107] The maps can show the intellectual, social or conceptual structure of a research field.[108] Beyond visual maps, expert survey-based studies and similar approaches could identify understudied or neglected societally important areas, topic-level problems (such as stigma or dogma), or potential misprioritizations.[additional citation(s) needed] Examples of such are studies about policy in relation to public health[109] and the social science of climate change mitigation[110] where it has been estimated that only 0.12% of all funding for climate-related research is spent on such despite the most urgent puzzle at the current juncture being working out how to mitigate climate change, whereas the natural science of climate change is already well established.[110] There are also studies that map a scientific field or a topic such as the study of the use of research evidence in policy and practice, partly using surveys.[111] Controversies, current debates and disagreement  Percent of all citances in each field that contain signals of disagreement[112] Some research is investigating scientific controversy or controversies, and may identify currently ongoing major debates (e.g. open questions), and disagreement between scientists or studies.[additional citation(s) needed] One study suggests the level of disagreement was highest in the social sciences and humanities (0.61%), followed by biomedical and health sciences (0.41%), life and earth sciences (0.29%); physical sciences and engineering (0.15%), and mathematics and computer science (0.06%).[112] Such research may also show, where the disagreements are, especially if they cluster, including visually such as with cluster diagrams. Challenges of interpretation of pooled results See also: Clinical trial § Trial design Further information: Meta-analysis § Challenges Studies about a specific research question or research topic are often reviewed in the form of higher-level overviews in which results from various studies are integrated, compared, critically analyzed and interpreted. Examples of such works are scientific reviews and meta-analyses. These and related practices face various challenges and are a subject of metascience. Various issues with included or available studies such as, for example, heterogeneity of methods used may lead to faulty conclusions of the meta-analysis.[113] Knowledge integration and living documents Various problems require swift integration of new and existing science-based knowledge. Especially setting where there are a large number of loosely related projects and initiatives benefit from a common ground or "commons".[96] Evidence synthesis can be applied to important and, notably, both relatively urgent and certain global challenges: "climate change, energy transitions, biodiversity loss, antimicrobial resistance, poverty eradication and so on". It was suggested that a better system would keep summaries of research evidence up to date via living systematic reviews – e.g. as living documents. While the number of scientific papers and data (or information and online knowledge) has risen substantially,[additional citation(s) needed] the number of published academic systematic reviews has risen from "around 6,000 in 2011 to more than 45,000 in 2021".[114] An evidence-based approach is important for progress in science, policy, medical and other practices. For example, meta-analyses can quantify what is known and identify what is not yet known[70] and place "truly innovative and highly interdisciplinary ideas" into the context of established knowledge which may enhance their impact.[59] (see above) Factors of success and progress It has been hypothesized that a deeper understanding of factors behind successful science could "enhance prospects of science as a whole to more effectively address societal problems".[59] Novel ideas and disruptive scholarship Two metascientists reported that "structures fostering disruptive scholarship and focusing attention on novel ideas" could be important as in a growing scientific field citation flows disproportionately consolidate to already well-cited papers, possibly slowing and inhibiting canonical progress.[115][116] A study concluded that to enhance impact of truly innovative and highly interdisciplinary novel ideas, they should be placed in the context of established knowledge.[59] Mentorship, partnerships and social factors Other researchers reported that the most successful – in terms of "likelihood of prizewinning, National Academy of Science (NAS) induction, or superstardom" – protégés studied under mentors who published research for which they were conferred a prize after the protégés' mentorship. Studying original topics rather than these mentors' research-topics was also positively associated with success.[117][118] Highly productive partnerships are also a topic of research – e.g. "super-ties" of frequent co-authorship of two individuals who can complement skills, likely also the result of other factors such as mutual trust, conviction, commitment and fun.[119][59] Study of successful scientists and processes, general skills and activities The emergence or origin of ideas by successful scientists is also a topic of research, for example reviewing existing ideas on how Mendel made his discoveries,[120] – or more generally, the process of discovery by scientists. Science is a "multifaceted process of appropriation, copying, extending, or combining ideas and inventions" [and other types of knowledge or information], and not an isolated process.[59] There are also few studies investigating scientists' habits, common modes of thinking, reading habits, use of information sources, digital literacy skills, and workflows.[121][122][123][124][125] Labor advantage A study theorized that in many disciplines, larger scientific productivity or success by elite universities can be explained by their larger pool of available funded laborers.[126][127] The study found that university prestige was only associated with higher productivity for faculty with group members, not for faculty publishing alone or the group members themselves. This is presented as evidence that the outsize productivity of elite researchers is not from a more rigorous selection of talent by top universities, but from labor advantages accrued through greater access to funding and the attraction of prestige to graduate and postdoctoral researchers. Ultimate impacts Success in science (as indicated in tenure review processes) is often measured in terms of metrics like citations, not in terms of the eventual or potential impact on lives and society,[128] which awards (see above) sometimes do. Problems with such metrics are roughly outlined elsewhere in this article and include that reviews replace citations to primary studies.[70] There are also proposals for changes to the academic incentives systems that increase the recognition of societal impact in the research process.[129] Progress studies A proposed field of "Progress Studies" could investigate how scientists (or funders or evaluators of scientists) should be acting, "figuring out interventions" and study progress itself.[130] The field was explicitly proposed in a 2019 essay and described as an applied science that prescribes action.[131] As and for acceleration of progress A study suggests that improving the way science is done could accelerate the rate of scientific discovery and its applications which could be useful for finding urgent solutions to humanity's problems, improve humanity's conditions, and enhance understanding of nature. Metascientific studies can seek to identify aspects of science that need improvement, and develop ways to improve them.[72] If science is accepted as the fundamental engine of economic growth and social progress, this could raise "the question of what we – as a society – can do to accelerate science, and to direct science toward solving society's most important problems."[132] However, one of the authors clarified that a one-size-fits-all approach is not thought to be right answer – for example, in funding, DARPA models, curiosity-driven methods, allowing "a single reviewer to champion a project even if his or her peers do not agree", and various other approaches all have their uses. Nevertheless, evaluation of them can help build knowledge of what works or works best.[102] |

メタ研究の分野とトピック メタサイエンスの主題である「科学の制度」を中心に、層によって構造化された科学的知識生成の概念を例示的に視覚化したものである。 メタサイエンスは5つの主要分野に分類できる: 方法」、「報告」、「再現性」、「評価」、「インセンティブ」である。これらはそれぞれ、研究の実施方法、伝達方法、検証方法、評価方法、報奨方法に対応している[1]。 方法 メタサイエンスは、研究の偏り、不十分な研究デザイン、統計の濫用など、劣悪な研究慣行を特定し、これらの慣行を削減する方法を見出そうとするものである。 科学的データ科学 科学的データ科学とは、研究論文を分析するためにデータ科学を利用することである。定性的手法と定量的手法の両方が含まれる。科学的データサイエンスの研究には、不正検出[18]や引用ネットワーク分析などがある[19]。 ジャーナロジー 主な記事 ジャーナロジー 出版科学としても知られるジャーナロジーは、学術出版プロセスのあらゆる側面を研究する学問である[20][21]。この分野は、学術出版においてエビデ ンスに基づく実践を実施することにより、学術研究の質を向上させようとするものである[22]。ジャーナロジー」という用語は、BMJ誌の元編集長ス ティーブン・ロックによって作られた。1989年にイリノイ州シカゴで開催された第1回査読会議は、ジャーナロジーを別個の分野として確立する上で極めて 重要な出来事であったと考えられている[22]。ジャーナロジーの分野は、科学、特に臨床試験における試験の事前登録を推進する上で影響力を持っている。 現在では、ほとんどの国で臨床試験の登録が期待されている[22]。 報告 メタ研究によって、特に社会科学と健康科学にお いて、研究の報告、説明、普及、一般化における不十分な慣行が明ら かになっている。不十分な報告は、科学的研究結果の正確な解釈、研究の再現、著者の偏見や利益相反の特定を困難にしている。解決策としては、報告基準の導 入、科学研究の透明性の向上(利益相反の開示要件の改善を含む)などがある。CONSORTやより大規模なEQUATORネットワークなどの報告機関によ るガイドラインの作成を通じて、データと方法論の報告を標準化しようとする試みがある[1]。 再現性 さらに詳しい情報 再現性の危機と再現性  がん研究における再現実験実施の障壁、The Reproducibility Project: がん生物学 再現性の危機とは、現在進行中の方法論的危機であり、多くの科学的研究の再現が困難または不可能であることが判明している[23][24]。この危機の ルーツは20世紀半ばから後半のメタ研究にあるが、「再現性の危機」という言葉は、問題意識の高まりの一環として2010年代初頭[25]になるまで作ら れなかった。 [1]再現性の危機は、がん研究を含む心理学(特に社会心理学)や医学[26][27]で綿密に研究されてきた[28][29]。 さらに、研究の複製(または複製に失敗すること)は、オリジナルの研究よりも影響力が低いとみなされ、多くの分野で発表される可能性が低くなる。そのため、研究の報告や再現の試みさえも抑制される[31][32]。 評価とインセンティブ 以下も参照のこと: 学術雑誌§名声とランキング メタサイエンスは、査読の科学的基盤を作ろうとしている。メタ・リサーチは、出版前査読、出版後査読、公開査読などの査読システムを評価している。また、より良い研究助成基準の開発も目指している[1]。 メタサイエンスは、より良いインセンティブ制度を通じて、より良い研究を促進することを目指している。これには、研究およびそれをパフォーマビティティと 評価するさまざまなアプローチの正確性、有効性、コスト、および便益の研究が含まれる。 [33][34]ブライアン・ノセックによると、「我々が直面している問題は、インセンティブシステムが、研究を正しく行うことよりも、研究を出版するこ とにほぼ完全に焦点を当てていることである」[35]。 貢献度 研究では、科学論文管理システムのための機械可読の標準と(分類法の)バッジが提案されている。このシステムでは、従来のオーサーシップの概念(出版物の 作成に何らかの形で関与した人)ではなく、コントリビューターシップ(誰が、研究の労力に対して、何を、どれだけ貢献したか)に焦点が当てられている。 [38][39][40][41]ある研究は、貢献度評価が無視され続けていることに関連する問題の一つを指摘している。それは、「著者リストが長くな り、論文が短くなり、出版数が急増した結果、出版数は良い指標ではなくなっている」というものである[42]。 評価要素 投稿論文の長所以外の要因も、査読者の評価に大きな影響を与える可能性がある[43]。しかし、そのような要因も、研究者の先行論文の信憑性や公共の利益 との整合性に関する実績の利用など、重要な場合がある。とはいえ、査読を含む評価制度は、被引用数や altmetricsのような分析的指標ではなく、実力、実社会におけるプラスのインパ クト、進歩、公共的有用性を志向する、あるいはそのような指標を部分的な指標とし て用いることができるとしても、そのような指標を志向する仕組みや基準を実質的 に欠いている可能性がある[44][45]。 トレーニングの評価 学術ランキングは、それぞれの研究者がどこで(国や研究所)訓練を受けたかを考慮していないとの解説がある[47]。 サイエントロメトリクス 主な記事 サイエントロメトリクス サイエントロメトリクスは、科学出版物の書誌データを測定することに関係している。主な研究課題には、研究論文や学術雑誌の影響度の測定、科学的引用の理 解、政策や経営におけるそのような測定値の利用が含まれる[48]。 [48]研究によれば、「論文数、被引用数、インパクトファクターなど、学術的成功を測定するために使用される指標は、何十年も変わっておらず」、ある程 度まで良い指標であることを「やめて」おり[42]、「過剰生産、不必要な断片化、過剰販売、略奪的ジャーナル(有料出版)、巧妙な盗用、販売や過剰販売 のための科学的結果の意図的な難読化」などの問題を引き起こしている[49]。 この分野の新しいツールには、被引用ノードが引用ノードにどれだけ情報を与えているかを定量化するシステムが含まれる[50]。これは、重み付けされてい ない引用ネットワークを重み付けされたものに変換し、「出版物や著者など、関係する様々な主体に対する影響度指標」[51]を導き出す重要性評価のために 使用することができる。 科学ガバナンス こちらも参照のこと: 科学政策、科学政策の科学 科学資金と科学ガバナンスもまた、メタサイエンスによって探求され、情報を得ることができる[52]。 インセンティブ 優先順位付けのような様々な介入が重要になることがある。例えば、差 別的技術開発という概念は、技術が開発される順序に影響を与えることで、主に地球規模の破局的リスク を低減するために、制御技術、安全技術、政策技術とリスクの高いバイオ技術など、異なる予防的ペー スで意図的に技術を開発することを指している[53][54]。 正しい結果を確保するために、確立された形の法律やインセンティブだけに頼ることは、多くの場合時間がかかりすぎ たり[55]、不適切であったりするため、適切ではないかもしれない。 メタ科学に基づく改革を含め、科学とそれに関連するプロセ スを管理するためのその他のインセンティブには、公衆に対する説明 責任の確保(特に公的資金による研究へのアクセスや、公衆の関心事である 様々な研究テーマへの真摯な取り組みなど)、有能で生産的な科学者の増員、 一般的な問題解決を向上させるための科学の効率改善、確かな科学的証拠に基づ く明確な社会的ニーズ(例えばヒトの生理学など)が適切に優先され、 取り組まれるようにすることなどがある。このような介入、インセンティブ、介入デザインは、メタ科学の対象となりうる。 科学資金と賞 以下も参照のこと: 特許 § 批判  ノーベル賞に関連する科学論文のクラスター・ネットワーク  自然科学・技術科学と社会科学・人文科学における気候変動研究への資金提供[56]。 科学賞は、科学へのインセンティブの一つのカテゴリーである。Metascienceは、科学賞の既存のシステムや仮説的なシステムを調査することができ る。例えば、メタサイエンスは、科学がDC2およびDC3分類システムに従って分類できる114/849の領域のうち、少なくとも1つのノーベル賞を受賞 したのは36/71に過ぎず、ノーベル賞によって栄誉を受けた研究はわずかな科学分野に集まっていることを発見した。114領域のうち5領域が、1995 年から2017年に授与されたノーベル賞の半分以上を占めていることが示された(素粒子物理学[14%]、細胞生物学[12.1%]、原子物理学 [10.9%]、神経科学[10.1%]、分子化学[5.3%])[57][58]。 ある研究では、知識生産と適切な資金提供に対する政策決定者の責任(中央集権的な権威に基づくトップダウン的アプローチ)を科学に委譲し、科学がその後何らかの形で「信頼できる有用な知識」を社会に提供するというのは、単純すぎるという結果が出ている[52]。 測定によれば、生物医学的資源の配分は、疾病の負担よりも、過去の配分や研究に強く相関する可能性がある[59]。 ある研究は、「査読が研究報告や資金提供の競争的選択における仲裁の主要なメカニズムとして維持されるのであれば、科学界はそれが恣意的なものでないことを確認する必要がある」と示唆している[43]。 成功の測定方法を再考」する必要があることを示す研究もある(#成功と進歩の要因を参照)[42]。 資金データ 助成金データベースや研究助成の謝辞欄から得られる研究助成情報は、サイエントロメトリックス研究のデータ源となり得る。 研究課題と調整 主な記事 リサーチクエスチョン§ 集計されたリサーチクエスチョンと調整 リスクガバナンス 主な項目 バイオセキュリティ 科学コミュニケーションと一般利用 も参照のこと: 科学 § 科学と公共 科学には、世界的な公共財としての価値を支える2つの基本的属性がある。すなわち、知識の主張とその根拠となる証拠が公開され、精査されること、そして科 学研究の結果が迅速かつ効率的に伝達されることである」[61]と主張されている。メタ科学的研究では、科学に関するメディア報道や科学ジャーナリズム、 科学教育者や科学者による結果のオンライン伝達など、科学コミュニケーションに関するトピックが探求されている。 [62][63][64][65]ある研究では、「学者がソーシャルメディアを利用する主なインセンティブは増幅」であり、「このような(あるいはそのよ うな)プラットフォームが、研究との真の関わりをどのように促進できるかに、より焦点を当てる組織文化へと移行する」べきであるとしている[66]。科学 コミュニケーションには、社会的ニーズ、懸念、要望を科学者に伝えることも含まれる。 代替測定ツール 代替メトリクス・ツールは、評価(パフォーマン スとインパクト)[59]やファインダビリティに役立つ だけでなく、redditのようなソーシャルメディアにおけ る科学論文に関する公開討論、Wikipediaにおける引用、ニュー スメディアにおける研究に関する報道の多くを集約するこ とができる。 [67]評価とファインダビリティの観点から、altmetricsは、ソーシャルメディアや他のオンラインプラットフォームを通じて受けたインタラク ションによって、出版物のパフォーマンスやインパクトを評価する[68]。確立されたオルトメトリクスの具体的な手順は透明性がなく[68]、使用されて いるアルゴリズムは、オープンソースソフトウェアのようにユーザーがカスタマイズしたり変更したりすることはできない。ある研究は、altmetrics の様々な限界を説明し、「継続的な研究と開発の道筋」を指摘している[69]。また、研究者が建設的なフィードバックを得るための主要なツールとしての利 用にも限界がある。(上記参照) 社会的意味合いと応用 知的交流、特に科学技術の社会的意味合いや応用に関する交流が、今後よりよく評価され、インセンティブが付与される」ことが、科学に利益をもたらす可能性が示唆されている[59]。 知識の統合 地球環境アジェンダの主要な社会生態学的課題における進展は、「急速に増加するデータ量」、区分化された情報、そして一般的に満たされていないエビデンス 統合の課題によって、「既存の科学的エビデンスの統合と統合の欠如によって妨げられている」。 [71]Khalilによれば、研究者は多すぎる論文という問題に直面しており、例えば2014年3月には8,000以上の論文がarXivに投稿されて いる。彼は、総説は通常(のみ)「すでに多くの論文が書かれたトピックのためのものであり、すぐに古くなってしまう」と指摘し、あるトピックに関する新し い研究で継続的に更新され、多くの研究結果を要約し、将来の研究を示唆する「ウィキ総説」を提案している[72]。ある研究は、科学的な出版物がウィキペ ディアの記事で引用されている場合、これはこの出版物のある種の影響力の指標として考えられる可能性があることを示唆している[68]。 科学ジャーナリズム 科学ジャーナリストは、科学エコシステムと一般への科学コミュニケーションにおいて重要な役割を担っており、「研究成果を信頼するかどうか、またそれを報 道するかどうか、どのように報道するかを決定する際に、関連する情報をどのように利用するかを知っている」必要があり、一般に発信される研究成果を吟味し ている[73]。 科学教育 科学教育について調査している研究もある。例えば、選択された科学論争[74]や、主要な科学的結論の歴史的発見過程[75]、一般的な科学的誤解 [76]についての教育などである。教育はまた、科学的成果の質を向上させ、科学的作業までに必要な時間を短縮する方法や、様々な科学的労働力を拡大・維 持する方法など、より一般的なテーマとなることもある。 科学の誤解と反科学的態度 さらなる情報 科学§反科学的態度、メディア・リテラシー、誤報§対策 多くの学生が、科学とは何か、科学がどのように機能するかについて誤解している[77]。 反科学的態度や信念もまた研究の対象である[78][79]。 科学の進化 科学的実践  6つのジャーナルに掲載された研究論文の著者数の経年変化[37]。  引用された研究の多様性、自己引用の平均数、引用された研究の平均年齢の傾向は、論文が「既存の知識のより狭い部分」を利用していることを示している可能性がある[81]。 メタサイエンスは、科学的プロセスが時間とともにどのように進化していくかを調査することができる。ある研究によると、チームの規模は拡大しており、「10年ごとに平均17%増加している」[59](以下の労働優位性を参照)。  ArXivの30年間の年間投稿率の伸び[82]。 オープンアクセスでない出版形態や、多くの従来型ジャーナルに課される価格は、公的資金が投入された論文であっても、科学的進歩にとって不当であり、不必 要であり、あるいは最適とは言えず、有害な障壁であることが判明した[61][83][84][85]。オープンアクセスは、他の方法で使用できるはずの 財源を大幅に節約し、発展途上国の研究者の競争条件を平準化することができる[86]。購読料、特定の研究へのアクセス権獲得、論文処理料には多額の費用 がかかる。ペイウォール The Business of Scholarship』は、そのような問題についてのドキュメンタリーである[87]。 もう一つのトピックは、確立された科学的コミュニ ケーションのスタイル(長文形式の研究やレビューなど) と科学的出版慣行であり、従来の出版が「氷河期的なペース」 であることが懸念されている[88]。研究草稿を早期に公表するた めのプレプリントサーバーの利用が増加し、オープン査読、[89] 研究をスクリーニングするための新しいツール、[90] 投稿原稿と査読者とのマッチングの改善[91] などが、出版を加速するための提案の一つである。 科学全体と分野内の発展  OpenAlexにおける分野別の科学的成果の可視化[92]。 一つの研究が複数の分野に属することもあり[要出典]、論文数の減少は分野にとって必ずしも不利ではない[49]。  OpenAlexによる分野別論文数の推移[92]。  1949年から2020年までの「コロナウイルス」のPubMed検索結果の年別件数 研究には様々な種類のメタデータがあり、有用な方法で利用、補完、アクセスできるようにすることができる。OpenAlexは、2億件以上の科学文献の無 料オンラインインデックスで、出典、引用、著者情報、科学分野、研究トピックなどのメタデータを統合して提供している。そのAPIとオープンソースのウェ ブサイトは、メタサイエンス、サイエントロメトリックス、そしてこの論文のセマンティックウェブを照会する新しいツールに利用することができる[93] [94][95]。開発中の別のプロジェクトScholiaは、ウィキデータの 「main subject 」プロパティを利用して、SARS-CoV-2ウイルスの特定の特徴に関する文献を要約したシンプルなユーザーインターフェースを提供するなど、様々な可 視化と集約機能のために科学論文のメタデータを利用している[96]。 主題レベルの解決 科学賞の影響力を調査するある研究では、論文のテキスト(キーワードだけではない)をウィキペディアの科学トピックページの言語コンテンツ(「ページはク ラウドソーシングを通じて科学者とユーザーによって作成・更新される」)と関連付けるためにこのような処理を使用し、さらなる分析やナビゲーションのため に高忠実度の科学トピックの意味のあるもっともらしい分類を作成した[97]。 科学全体の成長と停滞 さらなる情報 科学的方法§歴史、科学哲学  Scholiaによるバイオマーカーに関する学術論文の大まかな傾向。バイオマーカーに関連する学術論文は、実行可能なバイオマーカーの数と密接に連動していない可能性がある[98]。  Nature、PNAS、Scienceに掲載された論文のCD指数とノーベル賞受賞論文[81]。  CD指数は「破壊的な科学技術の衰退」を示している可能性がある[81]。 メタサイエンス研究は、例えば書誌データベースにおける論文数のデータを用いて、科学全体の成長を調査している。ある研究では、異なる成長率を示す区分 が、「経済的(例えば工業化)」-貨幣は科学システムにとって必要なインプットであると考えられている-および/または「政治的発展(例えば第二次世界大 戦)」の段階に関連しているようであることを発見した。また、科学文献の量が最近指数関数的に増加していることを確認し、平均倍増期間を17.3年と計算 した[99]。 しかしながら、科学の進歩を有意義な方法で測定することは困難であり、その理由の一つは、任意の科学的発見がどれほど重要であるかを正確に評価することが 難しいためであると指摘する者もいる。科学全体の軌跡(インパクト、大発見の数など)については、科学が(費やされたドルや時間あたりで)難しくなってい ること、科学が「今日減速しているとすれば、それは科学が確立された分野に集中しすぎているためである」こと、論文や特許が「CD指数」[81]によって 測定されるような、過去を打ち破るという意味で「破壊的」である可能性がますます低くなっていること、大きな停滞(おそらくより大きな傾向の一部として [100])があることなど、様々な視点が書籍や論文で述べられている。 例えば、コンピュータとインターネットを除いた場合、「1970年代以降、状況はほとんど変化していない」のである。 例えば、科学的生産性の測定における引用の重視、情報過多、[100] 3つの「過去の知識の利用」指標[81]に基づく、より狭い範囲の既存の知識(狭い専門化と関連する現代の実践を含むかもしれない)への依存、リスクを回 避する資金調達構造[102]は、「漸進的な科学に向かい、失敗する可能性の高い探索的プロジェクトから遠ざかっている」かもしれない。 [103]「CD指数」を導入した研究は、論文数全体が増加している一方で、指数によって測定される「破壊性の高い」論文の合計は増加していないことを示 唆している(特に、宇宙の加速膨張に関する1998年の発見は、CD指数が0である)。彼らの結果はまた、科学者や発明家が「知識の拡大ペースに追いつく のに苦労している可能性」を示唆している[104][81]。 研究の「新規性」を測定する様々な方法、新規性測定基準[103]が、潜在的な反新規性バイアスのバランスをとるために提案されている。例えば、テキスト 分析[103]や、難易度を考慮した上で、参照されたジャーナルの組み合わせが初めてかどうかを測定する方法[105]などがある。 その他のアプローチとしては、リスクの高いプロジェクトに積極的に資金を提供する方法がある[59](上記参照)。 トピックマッピング サイエンスマップは、ある科学領域内の相互に関連する主要なトピック、それらの経時的変化、およびそれらの主要なアクター(研究者、機関、ジャーナル)を 示すことができる。科学的変化の理論は、「視覚化された知的構造および動的パターンの探求と解釈」の指針となりうる[107]。 視覚的マップにとどまらず、専門家調査に基づく研究や類似のアプローチによって、社会的に重要な領域が十分に研究されていない、あるいは無視されているこ と、トピックレベルの問題(スティグマやドグマなど)、あるいは潜在的な誤った優先順位付けを特定することができる[108]。 [このような例としては、公衆衛生に関 連する政策に関する研究[109]や、気候変動緩和の社会 科学[110]がある。気候変動に関する自然科学は 既に十分に確立されているのに対して、気候変 動を緩和する方法を解明することが、現在の時点 で最も緊急の課題であるにもかかわらず、気候関 連の研究に対する全資金の0.12%しか、このような研 究に費やされていないと推定されている[110]。 また、科学的分野や、政策や実践における研究エビデンスの活用に関する研究のような、あるトピックをマッピングする研究も、一部調査を用いて行われている[111]。 論争、現在の議論、意見の相違  各分野における全出典のうち、意見の相違のシグナルを含むものの割合[112]。 科学的な論争や論争を調査している研究もあり、現在進行中の主要な論争(未解決の問題など)や、科学者や研究者間の意見の相違を明らかにすることもある [要追加引用]。ある研究によると、意見の相違のレベルは社会科学と人文科学で最も高く(0. 61%)、次いで生物医学・健康科学(0.41%)、生命科学・地球科学(0.29%)、物理科学・工学(0.15%)、数学・コンピュータ科学 (0.06%)の順であった[112]。このような研究では、意見の相違がどこにあるか、特にクラスター図のような視覚的なものも含め、クラスター化され ている場合は、それを示すこともできる。 プール結果の解釈の課題 以下も参照のこと: 臨床試験 § 試験デザイン さらに詳しい情報 メタアナリシス§課題 特定の研究課題または研究テーマに関する研究は、様々な研究の結果が統合、比較、批判的に分析、解釈された、より高度な概要の形でレビューされることが多 い。そのような研究の例として、科学的レビューやメタアナリシスがある。これらと関連する実践は様々な課題に直面しており、メタサイエンスの対象である。 例えば、使用された方法の異質性など、含まれる研究または利用可能な研究に関する様々な問題は、メタアナリシスの誤った結論につながる可能性がある[113]。 知識の統合と生きた文書 様々な問題において、科学に基づく新しい知識と既存の知識を迅速に統合する必要がある。特に、緩やかに関連するプロジェクトやイニシアティブが多数存在する環境では、共通基盤や「コモンズ(共有地)」の恩恵を受けることができる[96]。 エビデンスの統合は、重要で、特に、比較的緊急で、かつ特定のグローバルな課題に適用することができる: 「気候変動、エネルギー転換、生物多様性の損失、抗菌剤耐性、貧困撲滅などである。より良いシステムとしては、生きたシステマティック・レビューを通じ て、研究エビデンスの要約を常に最新の状態に保つことが提案された。科学論文やデータ(あるいは情報やオンライン上の知識)の数が大幅に増加する一方で [要追加引用]、学術的に発表されたシステマティック・レビューの数は、「2011年の約6,000件から2021年には45,000件以上」に増加して いる[114]。例えば、メタアナリシスは、既知のことを定量化し、まだ知られていないことを特定することができ[70]、「真に革新的で高度に学際的な アイデア」を確立された知識の文脈に位置づけることで、その影響力を高めることができる[59](上記参照)。 成功と進歩の要因 科学が成功する要因をより深く理解することで、「科学全体がより効果的に社会的問題に取り組むことができるようになる」という仮説が立てられている[59]。 斬新なアイデアと破壊的な学術 2人のメタサイエンティストは、成長する科学分野では、引用の流れが既に十分に引用されている論文に偏って集約され、正統的な進歩を遅らせたり阻害したり する可能性があるため、「破壊的な学問を育成し、斬新なアイデアに注目させる構造」が重要であり得ると報告している[115][116]。ある研究では、 真に革新的で高度に学際的な斬新なアイデアのインパクトを高めるためには、それらを確立された知識の文脈に位置づけるべきだと結論付けている[59]。 メンターシップ、パートナーシップ、社会的要因 他の研究者は、「受賞の可能性、国民科学アカデミー(NAS)への入会、スーパース ターダムの可能性」という点で、最も成功した研究者は、研究者の指導を 受けた後に賞を授与されるような研究を発表した指導者の下で研究した研究者 であったと報告している。このようなメンターの研究テーマではなく、独創的なテーマを研 究することも成功と正の相関があった[117][118]。生産性の高い連携も研究テーマであり、例えば、スキルを補 完できる2人の個人が頻繁に共著する「スーパー連携」は、相互信頼、確信、 コミットメント、楽しさといった他の要因の結果である可能性が高い[119][59]。 成功した科学者とプロセス、一般的なスキルと活動の研究 成功した科学者によるアイデアの出現や起源もまた研究のテーマであり、例えばメンデルがどのように発見を行ったかに関する既存のアイデアの再検討 [120]、あるいはより一般的には科学者による発見のプロセスなどが挙げられる。また、科学者の習慣、一般的な思考様式、読書習慣、情報源の利用、デジ タルリテラシーのスキル、ワークフローを調査した研究はほとんどない[121][122][123][124][125]。 労働の優位性 ある研究では、多くの学問分野において、エリート大学による科学的生産性の高さや成功は、利用可能な資金提供労働者のプールの大きさによって説明できると 理論化している[126][127]。この研究では、大学の威信は、グループメンバーを擁する教員の生産性の高さとのみ関連しており、教員単独での出版や グループメンバー自身の生産性の高さとは関連していないことを発見している。これは、エリート研究者の突出した生産性は、一流大学がより厳格に人材を選別 しているためではなく、研究資金へのアクセスの拡大や、大学院生やポスドク研究者への名声の魅力を通じて得られる労働上の優位性によるものであることを示 す証拠として提示されている。 究極の影響 科学における成功は(終身在職権の審査プロセスで示されるように)しばしば引用のような測定基準で測定され、賞(上記参照)が時として行うような、生活や 社会に対する最終的または潜在的な影響[128]では測定されない。このような評価基準の問題点については、本稿の別の箇 所で概説しているが、レビューが一次研究の引用に取って代わ ることも含まれる[70]。また、研究過程における社会的インパクトの認 識を高めるような学術的インセンティブ制度の変更に関する提案 もある[129]。 進歩研究 提案されている「進歩研究」という分野は、科学者(あるいは科学者の資金提供者や評価者)がどのように行動すべきかを調査し、「介入策を考え」、進歩その ものを研究することができる[130]。この分野は2019年のエッセイで明確に提案され、行動を規定する応用科学として説明されている[131]。 進歩の加速のために ある研究は、科学のあり方を改善することで、科学的発見とその応用の速度を加速させることができ、それは人類の問題に対する緊急の解決策を見出したり、人 類の状況を改善したり、自然に対する理解を深めたりするのに役立つ可能性があることを示唆している。もし科学が経済成長と社会進歩の基本的な原動力である と認められるならば、「科学を加速させ、社会の最も重要な問題を解決するために科学を導くために、社会として何ができるのかという問題」が提起されること になる。 「例えば、資金調達においては、DARPAモデル、好奇心主導の手法、「たとえ同僚が同意しなくても、一人の審査員がプロジェクトを支持する」ことを認め る手法、その他様々なアプローチには全て使い道がある。とはいえ、それらを評価することで、何が効果的か、あるいは何が最も効果的かについての知識を構築 することができる[102]。 |

| Reforms Meta-research identifying flaws in scientific practice has inspired reforms in science. These reforms seek to address and fix problems in scientific practice which lead to low-quality or inefficient research. A 2015 study lists "fragmented" efforts in meta-research.[1] Pre-registration Further information: Pre-registration (science) and Clinical trial registration The practice of registering a scientific study before it is conducted is called pre-registration. It arose as a means to address the replication crisis. Pregistration requires the submission of a registered report, which is then accepted for publication or rejected by a journal based on theoretical justification, experimental design, and the proposed statistical analysis. Pre-registration of studies serves to prevent publication bias (e.g. not publishing negative results), reduce data dredging, and increase replicability.[133][134] Reporting standards Further information: CONSORT and EQUATOR Network Studies showing poor consistency and quality of reporting have demonstrated the need for reporting standards and guidelines in science, which has led to the rise of organisations that produce such standards, such as CONSORT (Consolidated Standards of Reporting Trials) and the EQUATOR Network. The EQUATOR (Enhancing the QUAlity and Transparency Of health Research)[135] Network is an international initiative aimed at promoting transparent and accurate reporting of health research studies to enhance the value and reliability of medical research literature.[136] The EQUATOR Network was established with the goals of raising awareness of the importance of good reporting of research, assisting in the development, dissemination and implementation of reporting guidelines for different types of study designs, monitoring the status of the quality of reporting of research studies in the health sciences literature, and conducting research relating to issues that impact the quality of reporting of health research studies.[137] The Network acts as an "umbrella" organisation, bringing together developers of reporting guidelines, medical journal editors and peer reviewers, research funding bodies, and other key stakeholders with a mutual interest in improving the quality of research publications and research itself. |

改革 科学的実践の欠陥を明らかにするメタ研究は、科学における改革を促してきた。これらの改革は、質の低い研究や非効率的な研究につながる科学的実践の問題に対処し、修正しようとするものである。 2015年の研究では、メタ研究における「断片的な」取り組みが挙げられている[1]。 予備登録 さらなる情報 事前登録(科学)および臨床試験登録 科学研究を実施する前に登録することを予備登録という。これは、再現性の危機に対処する手段として生まれた。予備登録は、登録された報告書の提出を要求 し、その報告書は、理論的正当性、実験デザイン、提案された統計解析に基づいて、ジャーナルによって掲載の可否が決定される。研究の予備登録は、出版バイ アス(否定的な結果を公表しないなど)を防ぎ、データの浚渫を減らし、再現性を高める役割を果たしている[133][134]。 報告基準 さらなる情報 CONSORTおよびEQUATORネットワーク 報告の一貫性と質の低さを示す研究から、科学における報告基準やガイドラインの必要性が示され、CONSORT(Consolidated Standards of Reporting Trials)やEQUATOR Networkなど、そのような基準を作成する組織の台頭につながっている。 EQUATOR(Enhancing the QUAlity and Transparency Of health Research)ネットワーク[135]は、医学研究文献の価値と信頼性を高めるために、健康研究の透明で正確な報告を促進することを目的とした国際的 な取り組みである[136]。EQUATORネットワークは、優れた研究報告の重要性に対する認識を高め、さまざまなタイプの研究デザインに対する報告ガ イドラインの開発、普及、実施を支援し、健康科学文献における研究報告の質の状況を監視し、健康研究報告の質に影響を与える問題に関連する研究を実施する ことを目的として設立された。 [ネットワークは、報告ガイドラインの作成者、医学雑誌の編集者や査読者、研究助成機関、その他研究発表や研究そのものの質を向上させることに相互に関心 を持つ主要な利害関係者を集め、「傘」の役割を果たす。 |

| Applications Information and communications technologies See also: Group decision-making, List of academic databases and search engines, and Scientific communication Metascience is used in the creation and improvement of technical systems (ICTs) and standards of science evaluation, incentivation, communication, commissioning, funding, regulation, production, management, use and publication. Such can be called "applied metascience"[138][better source needed] and may seek to explore ways to increase quantity, quality and positive impact of research. One example for such is the development of alternative metrics.[59] Study screening and feedback Various websites or tools also identify inappropriate studies and/or enable feedback such as PubPeer, Cochrane's Risk of Bias Tool[139] and RetractionWatch. Medical and academic disputes are as ancient as antiquity and a study calls for research into "constructive and obsessive criticism" and into policies to "help strengthen social media into a vibrant forum for discussion, and not merely an arena for gladiator matches".[140] Feedback to studies can be found via altmetrics which is often integrated at the website of the study – most often as an embedded Altmetrics badge – but may often be incomplete, such as only showing social media discussions that link to the study directly but not those that link to news reports about the study. (see above) Tools used, modified, extended or investigated Tools may get developed with metaresearch or can be used or investigated by such. Notable examples may include: The tool scite.ai aims to track and link citations of papers as 'Supporting', 'Mentioning' or 'Contrasting' the study.[141][142][143] The Scite Reference Check bot is an extension of scite.ai that scans new article PDFs "for references to retracted papers, and posts both the citing and retracted papers on Twitter" and also "flags when new studies cite older ones that have issued corrections, errata, withdrawals, or expressions of concern".[143] Studies have suggested as few as 4% of citations to retracted papers clearly recognize the retraction.[143] Search engines like Google Scholar are used to find studies and the notification service Google Alerts enables notifications for new studies matching specified search terms. Scholarly communication infrastructure includes search databases.[144] Shadow library Sci-hub is a topic of metascience[145] Personal knowledge management systems for research-, knowledge- and task management, such as saving information in organized ways[146] with multi-document text editors for future use[147][148] Such systems could be described as part of, along with e.g. Web browser (tabs-addons[149] etc) and search software,[additional citation(s) needed] "mind-machine partnerships" that could be investigated by metascience for how they could improve science.[59] Scholia – efforts to open scholarly publication metadata and use it via Wikidata.[150] (see above) Various software enables common metascientific practices such as bibliometric analysis.[151] Development According to a study "a simple way to check how often studies have been repeated, and whether or not the original findings are confirmed" is needed due to reproducibility issues in science.[152][153] A study suggests a tool for screening studies for early warning signs for research fraud.[154] Medicine See also: Profit motive § Criticisms Clinical research in medicine is often of low quality, and many studies cannot be replicated.[155][156] An estimated 85% of research funding is wasted.[157] Additionally, the presence of bias affects research quality.[158] The pharmaceutical industry exerts substantial influence on the design and execution of medical research. Conflicts of interest are common among authors of medical literature[159] and among editors of medical journals. While almost all medical journals require their authors to disclose conflicts of interest, editors are not required to do so.[160] Financial conflicts of interest have been linked to higher rates of positive study results. In antidepressant trials, pharmaceutical sponsorship is the best predictor of trial outcome.[161] Blinding is another focus of meta-research, as error caused by poor blinding is a source of experimental bias. Blinding is not well reported in medical literature, and widespread misunderstanding of the subject has resulted in poor implementation of blinding in clinical trials.[162] Furthermore, failure of blinding is rarely measured or reported.[163] Research showing the failure of blinding in antidepressant trials has led some scientists to argue that antidepressants are no better than placebo.[164][165] In light of meta-research showing failures of blinding, CONSORT standards recommend that all clinical trials assess and report the quality of blinding.[166] Studies have shown that systematic reviews of existing research evidence are sub-optimally used in planning a new research or summarizing the results.[167] Cumulative meta-analyses of studies evaluating the effectiveness of medical interventions have shown that many clinical trials could have been avoided if a systematic review of existing evidence was done prior to conducting a new trial.[168][169][170] For example, Lau et al.[168] analyzed 33 clinical trials (involving 36974 patients) evaluating the effectiveness of intravenous streptokinase for acute myocardial infarction. Their cumulative meta-analysis demonstrated that 25 of 33 trials could have been avoided if a systematic review was conducted prior to conducting a new trial. In other words, randomizing 34542 patients was potentially unnecessary. One study[171] analyzed 1523 clinical trials included in 227 meta-analyses and concluded that "less than one quarter of relevant prior studies" were cited. They also confirmed earlier findings that most clinical trial reports do not present systematic review to justify the research or summarize the results.[171] Many treatments used in modern medicine have been proven to be ineffective, or even harmful. A 2007 study by John Ioannidis found that it took an average of ten years for the medical community to stop referencing popular practices after their efficacy was unequivocally disproven.[172][173] Psychology Further information: Replication crisis Metascience has revealed significant problems in psychological research. The field suffers from high bias, low reproducibility, and widespread misuse of statistics.[174][175][176] The replication crisis affects psychology more strongly than any other field; as many as two-thirds of highly publicized findings may be impossible to replicate.[177] Meta-research finds that 80-95% of psychological studies support their initial hypotheses, which strongly implies the existence of publication bias.[178] The replication crisis has led to renewed efforts to re-test important findings.[179][180] In response to concerns about publication bias and p-hacking, more than 140 psychology journals have adopted result-blind peer review, in which studies are pre-registered and published without regard for their outcome.[181] An analysis of these reforms estimated that 61 percent of result-blind studies produce null results, in contrast with 5 to 20 percent in earlier research. This analysis shows that result-blind peer review substantially reduces publication bias.[178] Psychologists routinely confuse statistical significance with practical importance, enthusiastically reporting great certainty in unimportant facts.[182] Some psychologists have responded with an increased use of effect size statistics, rather than sole reliance on the p values.[citation needed] Physics Richard Feynman noted that estimates of physical constants were closer to published values than would be expected by chance. This was believed to be the result of confirmation bias: results that agreed with existing literature were more likely to be believed, and therefore published. Physicists now implement blinding to prevent this kind of bias.[183] Computer Science Web measurement studies are essential for understanding the workings of the modern Web, particularly in the fields of security and privacy. However, these studies often require custom-built or modified crawling setups, leading to a plethora of analysis tools for similar tasks. In a paper by Nurullah Demir et al., the authors surveyed 117 recent research papers to derive best practices for Web-based measurement studies and establish criteria for reproducibility and replicability. They found that experimental setups and other critical information for reproducing and replicating results are often missing. In a large-scale Web measurement study on 4.5 million pages with 24 different measurement setups, the authors demonstrated the impact of slight differences in experimental setups on the overall results, emphasizing the need for accurate and comprehensive documentation.[184] |

アプリケーション 情報通信技術 こちらも参照のこと: 集団意思決定、学術データベースと検索エンジンのリスト、科学コミュニケーション メタサイエンスは、技術システム(ICT)および科学評価、インセンティブ付与、コミュニケーション、委託、資金提供、規制、生産、管理、利用、出版の基 準の作成と改善に利用される。このようなものは「応用メタサイエンス」[138][要出典]と呼ぶことができ、研究の量、質、好影響を増大させる方法を模 索することができる。そのような例として、代替的な測定基準の開発がある[59]。 研究のスクリーニングとフィードバック PubPeer、Cochrane's Risk of Bias Tool[139]、RetractionWatchなど、様々なウェブサイトやツールも不適切な研究を特定し、フィードバックを可能にしている。ある研 究では、「建設的で執拗な批判」に関する研究や、「ソーシャルメディアを単なる剣闘士の試合の場ではなく、活気ある議論の場として強化する」ための政策に 関する研究が求められている[140]。研究へのフィードバックは、多くの場合、研究のウェブサイトに組み込まれたAltmetricsバッジを介して見 つけることができるが、研究に直接リンクしているソーシャルメディア上の議論のみを表示し、研究に関する報道へのリンクを表示していないなど、不完全な場 合が多い。(上記参照) 使用、修正、拡張、調査されたツール ツールは、メタリサーチとともに開発されたり、メタリサーチによって使用されたり調査されたりすることがある。代表的な例としては以下のようなものがある: scite.aiは、その研究を「支持」、「言及」、「対比」している論文の引用を追跡し、リンクすることを目的としたツールである[141][142][143]。 Scite Reference Checkボットは、scite.aiの拡張機能で、新しい論文のPDFをスキャンし、「撤回された論文への参照を探し、引用論文と撤回された論文の両方 をツイッターに投稿」し、また「新しい研究が、訂正、正誤表、撤回、懸念の表明を発表した古い論文を引用したときにフラグを立てる」[143]。 Google Scholarのような検索エンジンは、研究を見つけるために使用され、通知サービスGoogle Alertsは、指定された検索用語に一致する新しい研究の通知を可能にする。学術コミュニケーション基盤には検索データベースが含まれる[144]。 シャドウ・ライブラリSci-hubはメタサイエンスのトピックである[145]。 このようなシステムは、例えばウェブ・ブラウザ(タブ・アド オン[149]など)や検索ソフトウェアとともに、[要追加引用]「マインド・マシ ン・パートナーシップ」の一部として説明することができる。 Scholia-学術出版物のメタデータをオープン化し、ウィキデータを通じて利用する取り組み[150](上記参照)。 様々なソフトウェアが、書誌分析のような一般的なメタ科学的実践を可能にしている[151]。 開発 ある研究によると、科学における再現性の問題から、「どれだけの頻度で研究が繰り返され、元の知見が確認されているかどうかをチェックする簡単な方法」が 必要とされている[152][153]。ある研究では、研究不正の早期警告の兆候のために研究をスクリーニングするツールを提案している[154]。 医学 以下も参照のこと: 利益動機 § 批判 医学の臨床研究は質が低いことが多く、多くの研究は再現できない[155][156] 。研究資金の85%が浪費されていると推定される[157] 。利益相反は医学文献の著者[159]や医学雑誌の編集者の間でよく見られる。ほとんどすべての医学雑誌が著者に利益相反の開示を義務づけているが、編集 者にはその義務はない[160]。金銭的利益相反は、肯定的な研究結果の割合の高さと関連している。抗うつ薬の試験では、製薬会社のスポンサーシップが試 験結果の最良の予測因子である [161] 。 盲検化はメタ研究のもう1つの焦点であり、盲検化が不十分なために起こる誤差が実験バイアスの原因となるからである。盲検化は医学文献ではあまり報告され ておらず、この主題に対する広範な誤解が臨床試験における盲検化の不十分な実施につながっている[162]。さらに、盲検化の失敗が測定されたり報告され たりすることはほとんどない[163]。抗うつ薬試験における盲検化の失敗を示す研究から、一部の科学者は抗うつ薬はプラセボよりも優れていないと主張す るようになった[164][165]。盲検化の失敗を示すメタ研究を考慮して、CONSORT基準はすべての臨床試験で盲検化の質を評価し報告するよう推 奨している[166]。 医学的介入の有効性を評価する研究の累積メタアナリシスにより、新しい試験を実施する前に既存のエビデンスの系統的レビューを行っていれば、多くの臨床試 験を回避できたことが示されている[168][169][170] 。彼らの累積メタアナリシスにより、新しい試験を実施する前にシステマティックレビューを実施すれば、33試験中25試験を回避できたことが示された。言 い換えれば、34542人の患者を無作為化することは不必要であった可能性がある。ある研究[171]は、227のメタアナリシスに含まれる1523の臨 床試験を分析し、「関連する先行研究の4分の1以下しか引用されていない」と結論づけた。また、ほとんどの臨床試験報告では、研究を正当化したり結果を要 約したりするためのシステマティック・レビューが示されていないという以前の知見も確認された[171]。 現代医学で用いられている多くの治療法は、効果がないこと、あるいは有害であることさえ証明されている。ジョン・イオアニディスによる2007年の研究に よると、医学界が一般的に行われている治療法の有効性が明確に否定された後、その治療法を参照しなくなるまでに平均10年かかることがわかった[172] [173]。 心理学 さらなる情報 再現の危機 メタサイエンスは心理学研究における重大な問題を明らかにした。この分野は、高いバイアス、低い再現性、広範な統計の誤用に悩まされている[174] [175][176]。再現性の危機は、他のどの分野よりも心理学に強く影響を及ぼしており、大々的に公表された研究結果の3分の2は再現不可能である可 能性がある[177]。 出版バイアスとp-ハッキングに関する懸念に対応して、140誌以上の心理学ジャーナルが結果盲検査読を採用しており、この査読では研究は事前に登録さ れ、結果を無視して出版される[181]。この分析は、結果盲検査読が出版バイアスを大幅に減少させることを示している[178]。 心理学者は日常的に統計的有意性と実際的重要性を混同しており、重要でない事実の確実性を熱心に報告している[182]。一部の心理学者は、p値のみに依存するのではなく、効果量統計の使用を増やすことで対応している[要出典]。 物理学 リチャード・ファインマンは、物理定数の推定値が偶然に予想される値よりも公表値に近いことを指摘した。これは確証バイアスの結果であり、既存の文献と一 致する結果は信じられやすく、したがって発表されやすいと考えられた。物理学者は現在、この種のバイアスを防ぐために盲検化を実施している[183]。 コンピュータサイエンス ウェブ計測の研究は、特にセキュリティとプライバシーの分野において、現代のウェブの仕組みを理解するために不可欠である。しかし、このような研究には、 特注のクロール・セットアップや修正されたクロール・セットアップが必要になることが多く、その結果、同じような作業のための分析ツールが氾濫することに なる。Nurullah Demirらの論文では、著者らは最近の研究論文117本を調査し、ウェブベースの計測研究のベストプラクティスを導き出し、再現性と複製可能性の基準を 確立した。その結果、結果を再現・複製するための実験セットアップやその他の重要な情報がしばしば欠落していることがわかった。24の異なる測定セット アップで450万ページを対象とした大規模なウェブ測定研究において、著者らは、実験セットアップのわずかな違いが全体的な結果に与える影響を実証し、正 確で包括的な文書化の必要性を強調した[184]。 |

| Organizations and institutes Further information: List of metascience research centers There are several organizations and universities across the globe which work on meta-research – these include the Meta-Research Innovation Center at Berlin,[185] the Meta-Research Innovation Center at Stanford,[186][187] the Meta-Research Center at Tilburg University, the Meta-research & Evidence Synthesis Unit, The George Institute for Global Health at India and Center for Open Science. Organizations that develop tools for metascience include OurResearch, Center for Scientific Integrity and altmetrics companies. There is an annual Metascience Conference hosted by the Association for Interdisciplinary Meta-Research and Open Science (AIMOS) and biannual conference hosted by the Centre for Open Science.[188][189] |

組織と研究機関 さらに詳しい情報 メタサイエンス研究センターのリスト ベルリンにあるMeta-Research Innovation Center、[185]スタンフォード大学のMeta-Research Innovation Center、[186][187]ティルブルク大学のMeta-Research Center、Meta-research & Evidence Synthesis Unit、インドのThe George Institute for Global Health、Center for Open Scienceなどである。メタサイエンスのためのツールを開発している組織には、OurResearch、Center for Scientific Integrity、altmetrics企業などがある。Association for Interdisciplinary Meta-Research and Open Science(AIMOS)が主催する年1回のメタサイエンス会議と、Centre for Open Scienceが主催する年2回の会議がある[188][189]。 |

| Accelerating change Basic research Citation analysis Epistemology Evidence-based practices Evidence-based medicine Evidence-based policy Further research is needed HARKing Logology (science) Metadata § Science Metatheory Open science Philosophy of science Science of science policy Sociology of scientific knowledge Self-Organized Funding Allocation |

変化を加速する 基礎研究 引用分析 認識論 エビデンスに基づく実践 エビデンスに基づく医療 エビデンスに基づく政策 さらなる研究が必要である ハーキング 論理学(科学) メタデータ§科学 メタ理論 オープンサイエンス 科学哲学 科学政策の科学 科学的知識の社会学 自己組織的な資金配分 |

| https://en.wikipedia.org/wiki/Metascience |

|

リ ンク

文 献

そ の他の情報

Copyleft, CC, Mitzub'ixi Quq Chi'j, 1996-2099

☆

☆

☆