クロスモーダル

Crossmodal

☆ クロスモーダル知覚(cross-modal perception)とは、2つ以上の異なる感覚モダリティ間の相互作用を伴う知覚のことである。その例として、共感覚、感覚代替、視覚と聴覚が相互作用して音声を知覚するマクガーク効果などが挙げられる。また、マルチモーダル、多感覚統合(マルチモーダルな統合とも呼ばれる)と は、異なる感覚モダリティ(視覚、聴覚、触覚、嗅覚、自己運動、味覚など)からの情報が、神経系によって どのように統合されるかを研究する学問である。実際、多感覚統合は、動物が首尾一貫した知覚実体の世界を認識することを可能にするため、適応行動の中心的 役割を担っている。多感覚統合はまた、異なる感覚モダリティがどのように相互作用し、互いの処理を変化させるかを扱う。

★クロスモーダル注意とは、異なる感覚に注意を向けることである。注意とは、感覚刺激を選択的に強調したり無視 したりする認知過程である。クロスモーダル注意の観点によると、注意は多くの場合、複数の感覚モダリティを通じて同時に起こる。これらのモダリティは、視 覚、聴覚、空間、触覚などの異なる感覚野からの情報を処理する。 [これらのモダリティはそれぞれ特定の種類の感覚情報を 処理するように設計されているが、モダリティ間にはかなりの重複があ るため、研究者は注意がモダリティに特有なのか、それとも共有され た「クロスモーダル」資源の結果なのかを疑問視している。クロスモーダル注意の最も一般的な例は、カクテルパーティー効果である。この現象により、1つの 刺激に対してより深いレベルの処理が行われ、他の刺激は無視される。| Crossmodal perception or cross-modal perception is perception that

involves interactions between two or more different sensory

modalities.[1] Examples include synesthesia, sensory substitution and

the McGurk effect, in which vision and hearing interact in speech

perception. Crossmodal perception, crossmodal integration and cross modal plasticity of the human brain are increasingly studied in neuroscience to gain a better understanding of the large-scale and long-term properties of the brain.[2] A related research theme is the study of multisensory perception and multisensory integration. As a cultural movement Described as synthesizing art, science and entrepreneurship. Crossmodialism as a movement started in London in 2013.[3][4] The movement focuses on bringing together the talents of traditionally distinct disciplines to make cohesive works. Crossmodalism has been compared to the Dadaist art movement of the 20th century, as well as other avant garde styles like futurism and surrealism.[5] Crossmodal attention Ideasthesia Molyneux's problem Sensory substitution |

クロスモーダル知覚(cross-modal perception)とは、2つ以上の異なる感覚モダリティ間の相互作用を伴う知覚のことである[1]。その例として、共感覚、感覚代替、視覚と聴覚が相互作用して音声を知覚するマクガーク効果などが挙げられる。 ヒトの脳のクロスモーダル知覚、クロスモーダル統合、クロスモーダル可塑性は、脳の大規模かつ長期的な特性をより深く理解するために、神経科学においてますます研究されるようになっている[2]。 文化運動として アート、科学、起業家精神を統合したものと表現される。ムーブメントとしてのクロスモダリズムは、2013年にロンドンで始まった[3][4]。このムー ブメントは、伝統的に異なる分野の才能を結集し、まとまりのある作品を作ることに焦点を当てている。クロスモダリズムは、20世紀のダダイスト芸術運動 や、未来派やシュルレアリスムのような前衛的なスタイルと比較されている[5]。 クロスモダルの注意感覚 イデアステシア モリニューの問題 感覚代替 |

| Crossmodal

attention refers to the distribution of attention to different senses.

Attention is the cognitive process of selectively emphasizing and

ignoring sensory stimuli. According to the crossmodal attention

perspective, attention often occurs simultaneously through multiple

sensory modalities.[1] These modalities process information from the

different sensory fields, such as: visual, auditory, spatial, and

tactile.[2] While each of these is designed to process a specific type

of sensory information, there is considerable overlap between them

which has led researchers to question whether attention is

modality-specific or the result of shared "cross-modal" resources.[1]

Cross-modal attention is considered to be the overlap between

modalities that can both enhance and limit attentional processing. The

most common example given of crossmodal attention is the Cocktail Party

Effect, which is when a person is able to focus and attend to one

important stimulus instead of other less important stimuli. This

phenomenon allows deeper levels of processing to occur for one stimulus

while others are then ignored. A primary concern for cognitive psychologists researching attention is to determine whether directing attention to one specific sensory modality occurs at the expense of others.[3] Previous research has often examined how directing attention to different modalities can affect the efficiency of performance in various tasks.[3][4][5][6] Studies have found that the interplay between attentional modalities exists at the neurological level[7][8] providing evidence for the influences of cross-modal attention. However a greater number of studies have emphasized the deficits in attention caused by the shifting between modalities.[1][3][4][5] |

ク

ロスモーダル注意とは、異なる感覚に注意を向けることである。注意とは、感覚刺激を選択的に強調したり無視

したりする認知過程である。クロスモーダル注意の観点によると、注意は多くの場合、複数の感覚モダリティを通じて同時に起こる。これらのモダリティは、視

覚、聴覚、空間、触覚などの異なる感覚野からの情報を処理する。 [これらのモダリティはそれぞれ特定の種類の感覚情報を

処理するように設計されているが、モダリティ間にはかなりの重複があ るため、研究者は注意がモダリティに特有なのか、それとも共有され

た「クロスモーダル」資源の結果なのかを疑問視している。クロスモーダル注意の最も一般的な例は、カクテルパーティー効果である。この現象により、1つの

刺激に対してより深いレベルの処理が行われ、他の刺激は無視される。 注意について研究している認知心理学者にとっての主要な関心事は、ある特定の感覚モダリティに注意を向けることが、他の感覚モダリティを犠牲にして起こる かどうかを明らかにすることである[3]。これまでの研究では、異なるモダリティに注意を向けることが、様々な課題におけるパフォーマンスの効率にどのよ うな影響を与えるかについてしばしば検討されてきた[3][4][5][6]。しかし、より多くの研究が、モダリティ間のシフトによって引き起こされる注 意の欠損を強調している[1][3][4][5]。 |

| Deficits caused by crossmodal attention As cross-modal attention requires attending to two or more types of sensory information simultaneously, attentional resources are typically divided unequally. It has been suggested by most research that this divided attention can result in more attentional deficits than benefits. This has raised the question as to the effectiveness of multitasking and the potential dangers associated with it. Significant amounts of delay in reaction times are present when various distractions across modalities occur.[9] In real-life situations these slower reaction times can result in dangerous situations. Recent concerns in the media on this topic revolve around the topic of cellphone usage while driving. Studies have found that processing, and therefore attending to, auditory information can impair the simultaneous processing of visual information.[10] This suggests that attending to the auditory information from cellphone usage while driving will impair a driver's visual attention and ability to drive. This would result in the endangering of the driver, passengers of the driver, pedestrians, and other drivers and their passengers. Similar studies have examined how visual attention is affected by auditory stimuli as it relates to hemispatial neglect,[4] responses to cuing,[5] and general spatial processing.[2] The majority of this research suggests that multitasking and dividing attention, while possible, degrade the quality of the directed attention. This also suggests that attention is a limited resource that cannot be infinitely divided between modalities and tasks. Benefits While research on cross-modal attention has found that deficits in attending often occur, this research has led to a better understanding of attentional processing. Some studies have used positron emission tomography (PET) to examine the neurological basis for how we selectively attend to information using different sensory modalities.[2] Event related potentials (ERPs). have also been used to help researchers measure how humans encode and process attended information in the brain.[10] By increasing our understanding of modality-specific and cross-modal attention, we are better able to understand how we think and direct our attention. In addition to greater general understanding of attention, other benefits of crossmodal attention have been found. Studies show that reinforcing information through more than one modality can increase learning.[11] This would support the traditional theory that pairing auditory and visual stimuli that communicate the same information improves processing and memory. |

クロスモーダル注意による欠陥 クロスモーダル注意は、2種類以上の感覚情報に同時に注意を向ける必要があるため、注意資源は通常、不均等に分割される。多くの研究で、このような注意の 分割は、利点よりも注意の欠損をもたらすことが示唆されている。このため、マルチタスクの有効性とそれに伴う潜在的な危険性について疑問が投げかけられて いる。モダリティを超えた様々な注意散漫が生じると、反応時間にかなりの遅れが生じる[9]。現実の状況では、このような反応時間の遅れが危険な状況をも たらす可能性がある。この話題に関する最近のメディアでの懸念は、運転中の携帯電話の使用に関する話題を中心に展開されている。聴覚情報を処理すること、 つまり聴覚情報に注意を向けることで、視覚情報の同時処理が損なわれることが研究で明らかになっている[10]。このことは、運転中に携帯電話の使用によ る聴覚情報に注意を向けることで、ドライバーの視覚的注意と運転能力が損なわれることを示唆している。その結果、運転者、運転者の同乗者、歩行者、他の運 転者とその同乗者を危険にさらすことになる。同様の研究では、視覚的注意が聴覚刺激によってどのような影響を受けるかについて、半側空間無視[4]、手が かりに対する反応[5]、一般的な空間処理[2]との関連で検討されている。この研究の大半は、マルチタスクや注意の分割は可能ではあるが、指示された注 意の質を低下させることを示唆している。このことはまた、注意は限られた資源であり、モダリティやタスク間で無限に分割することはできないことを示唆して いる。 利点 クロスモーダル注意に関する研究は、注意の欠損がしばしば起こることを発見したが、この研究は注意の処理に関する理解を深めることにつながった。また、事 象関連電位(ERP)も、ヒトが脳内でどのように注意された情報を符号化し、処理するかを測定するのに役立てられている[10]。モダリティ特異的注意と クロスモダリティ注意の理解を深めることで、ヒトがどのように考え、注意を向けるかをより理解できるようになる。 注意に関する一般的な理解が深まるだけでなく、クロスモーダル注意の他の利点も発見されている。このことは、同じ情報を伝達する聴覚刺激と視覚刺激を対にすることで、処理と記憶が向上するという従来の理論を支持するものである。 |

|

Example of associations between graphemes and colors that are described more accurately as ideasthesia than as synesthesia 共感覚というよりも、観念感覚としてより正確に表現される、書記素と色彩の関連性の例 |

| Ideasthesia

(alternative spelling ideaesthesia) is a neuropsychological phenomenon

in which activations of concepts (inducers) evoke perception-like

sensory experiences (concurrents). The name comes from the Ancient

Greek ἰδέα (idéa) and αἴσθησις (aísthēsis), meaning 'sensing concepts'

or 'sensing ideas'. The notion was introduced by neuroscientist Danko

Nikolić as an alternative explanation for a set of phenomena

traditionally covered by synesthesia.[1] While synesthesia meaning 'union of senses' implies the association of two sensory elements with little connection to the cognitive level, empirical evidence indicated that most phenomena linked to synesthesia are in fact induced by semantic representations. That is, the linguistic meaning of the stimulus is what is important rather than its sensory properties. In other words, while synesthesia presumes that both the trigger (inducer) and the resulting experience (concurrent) are of sensory nature, ideasthesia presumes that only the resulting experience is of sensory nature while the trigger is semantic.[2][3][4][5][6][7] Research has later extended the concept to topics other than synesthesia, and since it turned out to be applicable to everyday perception, the concept has developed into a theory of how we perceive. For example ideasthesia has been applied to the theory of art and could bear important implications in explaining human conscious experience, which, according to ideasthesia, is grounded in how we activate concepts.[8] |

イディア

ステシア(ideasthesia(ideaesthesiaの別綴)=共感覚統合)とは、概念の活性化(誘発)が知覚に似た感覚体験(同時体験)を誘発

する神経心理学的現象である。この名称は、古代ギリシア語のἰδέα (idéa)とαἴσθησις

(aísthēsis)に由来し、「概念の感知」や「観念の感知」を意味する。この概念は、神経科学者のダンコ・ニコリッチによって、従来は共感覚

(synesthesia)によってカバーされていた一連の現象の代替説明として導入された[1]。 「感覚の結合」を意味する共感覚は、認知レベルとの関連性がほとんどない2つの感覚要素の連合を意味するが、経験的証拠から、共感覚に関連するほとんどの現象は、実際には意味表現によって誘発されることが示された。 つまり、刺激の言語的意味こそが、その感覚的特性よりも重要なのである。言い換えれば、共感覚が引き金(誘因)と結果としての経験(同時性)の両方が感覚 的性質であると仮定するのに対し、イデア感覚は引き金が意味的であるのに対し、結果としての経験のみが感覚的性質であると仮定する[2][3][4] [5][6][7]。 その後、研究はこの概念を共感覚以外のトピックにも拡張し、日常的な知覚にも適用できることが判明したため、この概念は知覚方法の理論へと発展した。例え ば、イデアステシアは芸術理論に応用されており、イデアステシアによれば、人間の意識的経験を説明する上で重要な意味を持つ可能性がある。 |

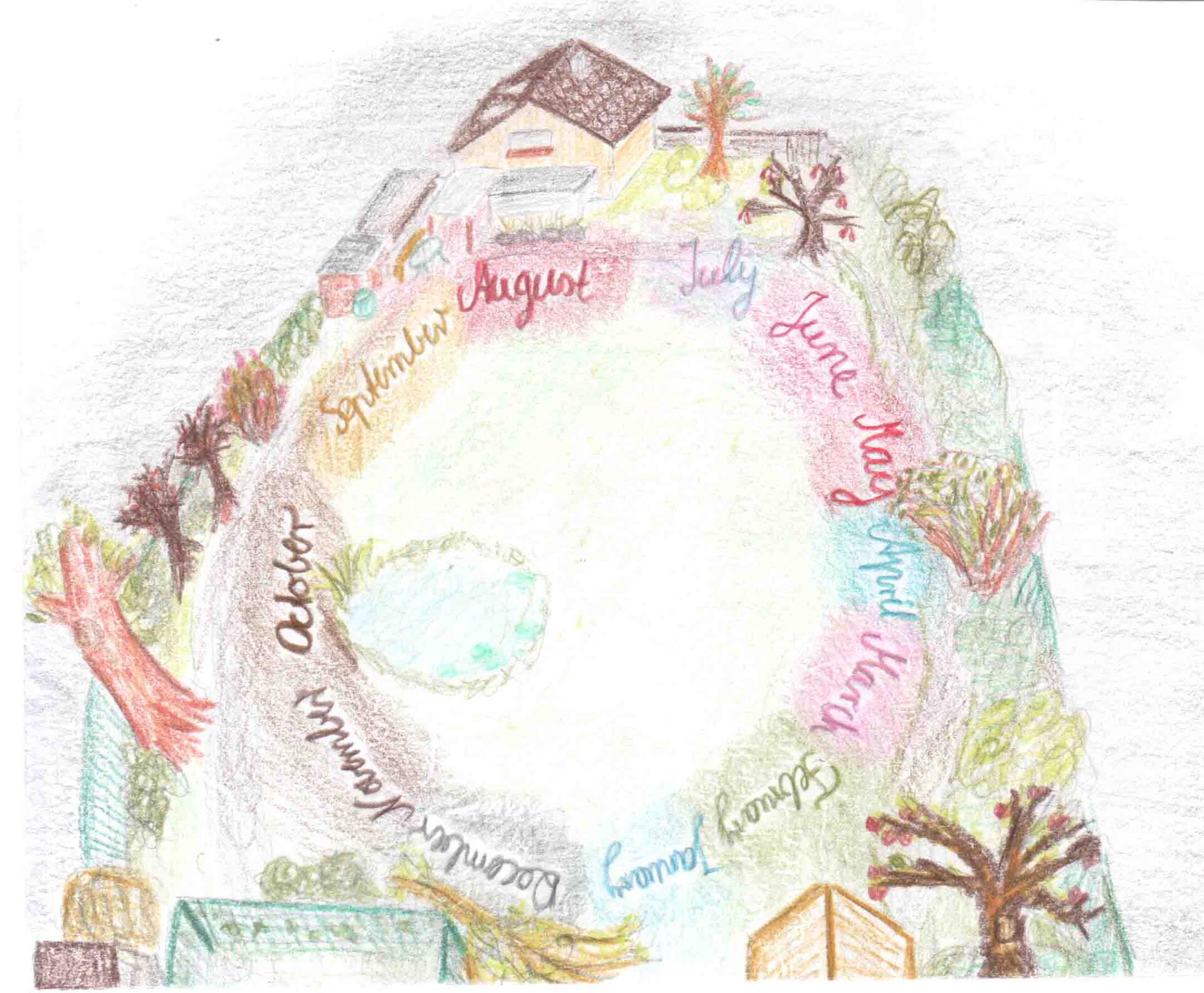

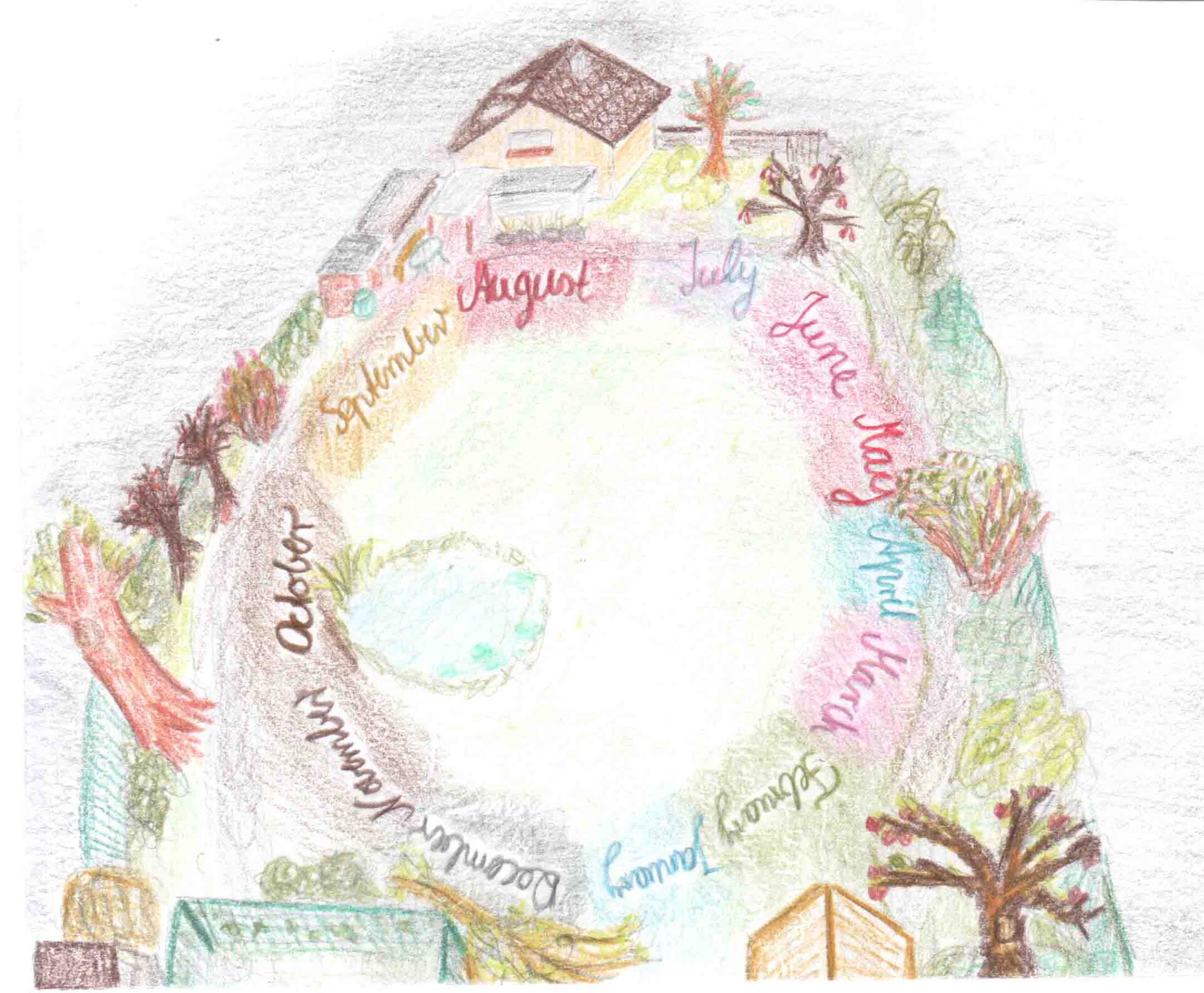

Examples and evidence A drawing by a synesthete which illustrates time unit-space synesthesia/ideasthesia. The months in a year are organized into a circle surrounding the synesthete's body, each month having a fixed location in space and a unique color. A common example of synesthesia is the association between graphemes and colors, usually referred to as grapheme–color synesthesia. Here, letters of the alphabet are associated with vivid experiences of color. Studies have indicated that the perceived color is context-dependent and is determined by the extracted meaning of a stimulus. For example, an ambiguous stimulus '5' that can be interpreted either as 'S' or '5' will have the color associated with 'S' or with '5', depending on the context in which it is presented. If presented among numbers, it will be interpreted as '5' and will associate the respective color. If presented among letters, it will be interpreted as 'S' and will associate the respective synesthetic color.[2] Evidence for grapheme-color synesthesia comes also from the finding that colors can be flexibly associated to graphemes, as new meanings become assigned to those graphemes. In one study synesthetes were presented with Glagolitic letters that they have never seen before, and the meaning was acquired through a short writing exercise. The Glagolitic graphemes inherited the colors of the corresponding Latin graphemes as soon as the Glagolitic graphemes acquired the new meaning.[3] In another study, synesthetes were prompted to form novel synesthetic associations to graphemes never seen before. Synesthetes created those associations within minutes or seconds – which was time too short to account for creation of new physical connections between color representation and grapheme representation areas in the brain,[9] pointing again towards ideasthesia. Although the time course is consistent with postsynaptic AMPA receptor upregulation or NMDA receptor coactivation, or both, which would imply that the realtime experience is invoked at the synaptic level of analysis prior to establishment of novel wiring per se, a very intuitively appealing model. For lexical–gustatory synesthesia evidence also points towards ideasthesia: in lexical-gustatory synesthesia, verbalisation of the stimulus is not necessary for the experience of concurrents. Instead, it is sufficient to activate the concept.[4] Another case of synesthesia is swimming-style synesthesia in which each swimming style is associated with a vivid experience of a color.[5][10] These synesthetes do not need to perform the actual movements of a corresponding swimming style. To activate the concurrent experiences, it is sufficient to activate the concept of a swimming style (e.g., by presenting a photograph of a swimmer or simply talking about swimming).[11] It has been argued that grapheme-color synesthesia for geminate consonants also provides evidence for ideasthesia.[12] In pitch-color synesthesia, the same tone will be associated with different colors depending on how it has been named; do-sharp (i.e. di) will have colors similar to do (e.g., a reddish color) and re-flat (i.e. ra) will have color similar to that of re (e.g., yellowish), although the two classes refer to the same tone.[13] Similar semantic associations have been found between the acoustic characteristics of vowels and the notion of size.[14] There are synesthetic experiences that can occur just once in a lifetime, and are thus dubbed one-shot synesthesia. Investigation of such cases has indicated that such unique experiences typically occur when a synesthete is involved in an intensive mental and emotional activity such as making important plans for one's future or reflecting on one's life. It has been thus concluded that this is also a form of ideasthesia.[15] |

例と証拠 ある共感覚者が描いた、時間単位-空間の共感覚/感覚を示す絵。1年の月が共感覚者の身体を囲む円の中に構成され、各月は空間における一定の位置と固有の色を持っている。 共感覚の一般的な例として、通常、書記素-色彩共感覚と呼ばれる、書記素と色彩の関連がある。ここでは、アルファベットの文字が鮮やかな色彩体験と関連し ている。知覚される色は文脈に依存し、刺激の抽出された意味によって決定されることが研究で示されている。例えば、'S'とも'5'とも解釈できる曖昧な 刺激'5'は、それが提示される文脈によって、'S'に関連する色、または'5'に関連する色となる。数字の中に提示された場合、'5'と解釈され、それ ぞれの色が連想される。文字の中に提示された場合は、'S'と解釈され、それぞれの共感覚的な色が連想される[2]。 書記素と色の共感覚の証拠は、新しい意味がその書記素に割り当てられると、色が柔軟に書記素と関連づけられるという発見からも得られる。ある研究では、共 感覚者に見たこともないグラゴル文字が提示され、その意味は短い書き取り練習によって獲得された。グラゴリティック文字が新しい意味を獲得すると同時に、 グラゴリティック文字は対応するラテン文字の色を受け継いだ[3]。 別の研究では、共感覚者に、これまでに見たことのないような新しい共感覚的連想を形成するよう促した。共感覚者は数分から数秒以内にそのような連想を創り 出したが、これは脳内の色彩表現領域と書記素表現領域の間に新たな物理的結合を創り出すには短すぎる時間であり[9]、再びイデアステーシアを指してい る。この時間経過は、シナプス後のAMPA受容体のアップレギュレーション、あるいはNMDA受容体の共活性化、あるいはその両方と一致するが、このこと は、新しい配線それ自体が確立される前に、シナプスレベルの分析で実時間体験が呼び起こされることを示唆しており、非常に直感的に魅力的なモデルである。 語彙性-味覚性共感覚では、刺激の言語化は同時感覚の経験には必要ない。その代わりに、概念を活性化させるのに十分である[4]。 このような共感覚者は、対応する水泳スタイルの実際の動作を行う必要はない。同時体験を活性化するには、水泳スタイルの概念を活性化すれば十分である(例えば、水泳選手の写真を提示したり、単に水泳について話したりする)[11]。 促音子音に対する書記素-色彩の共感覚もまた、イデア感覚を示す証拠であると主張されている[12]。 音高-色彩共感覚では、同じ音調でも、それがどのように命名されたかによって、異なる色彩が連想される。ド-シャープ(すなわちジ)はドに似た色彩(例え ば赤みがかった色彩)を持ち、レ-フラット(すなわちラ)はレに似た色彩(例えば黄色がかった色彩)を持つが、この2つのクラスは同じ音調を指す [13]。 一生に一度しか起こらない共感覚体験があり、これはワンショット共感覚と呼ばれている。このような事例を調査したところ、このようなユニークな体験は、共 感覚者が将来の重要な計画を立てたり、自分の人生を振り返ったりするなど、集中的な精神的・感情的活動に関与しているときに典型的に起こることが示され た。そのため、これも一種のイデア感覚であると結論付けられている[15]。 |

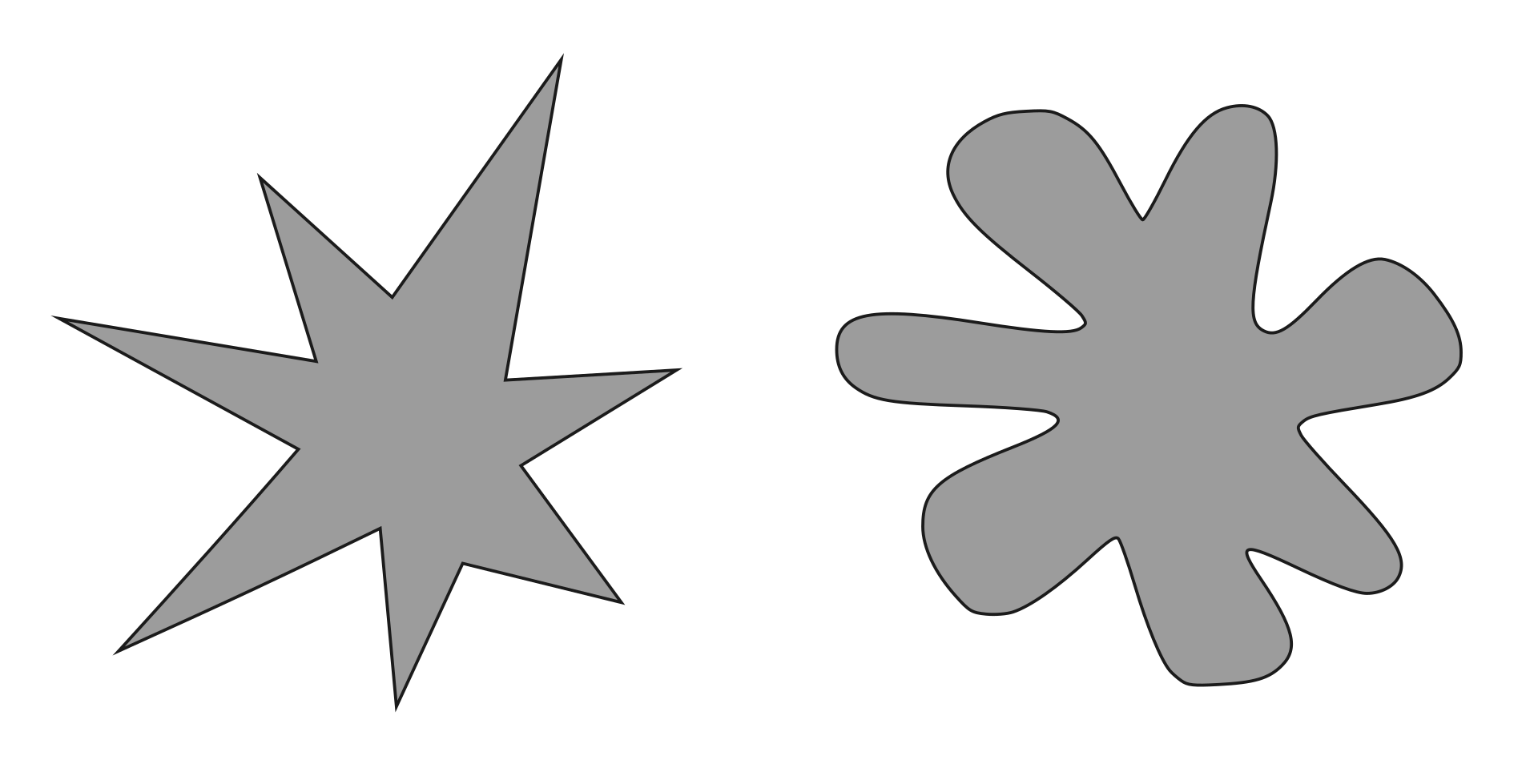

In normal perception Which one would be called Bouba and which Kiki? Responses are highly consistent among people. This is an example of ideasthesia as the conceptualization of the stimulus plays an important role. Since 2013, it has been suggested that the Bouba/Kiki phenomenon is a case of ideasthesia.[16][17][18] Most people will agree that the star-shaped object on the left is named Kiki and the round one on the right Bouba.[19][20] It has been assumed that these associations come from direct connections between visual and auditory cortices.[20] For example, according to that hypothesis, representations of sharp inflections in the star-shaped object would be physically connected to the representations of sharp inflection in the sound of Kiki. However, Gomez et al.[16][21] have shown that Kiki/Bouba associations are much richer as either word and either image is associated semantically to a number of concepts such as white or black color, feminine vs. masculine, cold vs. hot, and others. These sound–shape associations seem to be related through a large overlap between semantic networks of Kiki and star-shape on the one hand, and Bouba and round-shape on the other hand. For example, both Kiki and star-shape are clever, small, thin and nervous. This indicates that behind Kiki-Bouba effect lies a rich semantic network. In other words, our sensory experience is largely determined by the meaning that we assign to stimuli. Food description and wine tasting is another domain in which ideasthetic association between flavor and other modalities such as shape may play an important role.[22] These semantic-like relations play a role in successful marketing; the name of a product should match its other characteristics.[23] |

通常の認識では どちらを「ボウバ」と呼び、どちらを「キキ」と呼ぶだろうか?反応は人によって非常に一貫している。これは、刺激の概念化が重要な役割を果たすので、イデアステーシアの一例である。 2013年以降、Bouba/Kiki現象はideasthesiaの一例であることが示唆されている[16][17][18]。ほとんどの人は、左側の 星形の物体はKikiと名付けられ、右側の丸い物体はBoubaと名付けられることに同意するだろう[19][20]。このような連想は、視覚野と聴覚野 の間の直接的な結合から生じると仮定されてきた[20]。しかし、ゴメスら[16][21]は、キキ/ブーバの連想は、いずれかの単語といずれかのイメー ジが、白か黒か、女性的か男性的か、冷たいか熱いかなど、多くの概念と意味的に関連しているため、より豊かであることを示している。これらの音と形の連想 は、一方ではキキと星形、他方ではボバと丸形の意味ネットワークの間に大きな重なりを通して関連しているようだ。例えば、キキと星形はともに、利口で、小 さく、細く、神経質である。このことは、キキ・ボーバ効果の背後に豊かな意味ネットワークがあることを示している。つまり、私たちの感覚体験は、刺激に割 り当てる意味によって大きく左右されるのである。食品の説明やワインの試飲は、風味と形状など他のモダリティとの間の意味論的関連が重要な役割を果たすか もしれないもう一つの領域である[22]。これらの意味論的な関係は、成功するマーケティングにおいて役割を果たす。 |

| Implications for development of synesthesia The concept of ideasthesia bears implications for understanding how synesthesia develops in children. Synesthetic children may associate concrete sensory-like experiences primarily to the abstract concepts that they have otherwise difficulties dealing with.[8] Synesthesia may thus be used as a cognitive tool to cope with the abstractness of the learning materials imposed by the educational system – referred to also as a "semantic vacuum hypothesis". This hypothesis explains why the most common inducers in synesthesia are graphemes and time units – both relating to the first truly abstract ideas that a child needs to master.[24] Implications for art theory The concept of ideasthesia has been often discussed in relation to art,[25][26][27][28][29][30][31][32] and also used to formulate a psychological theory of art.[33] According to the theory, we consider something to be a piece of art when experiences induced by the piece are accurately balanced with semantics induced by the same piece. Thus, a piece of art makes us both strongly think and strongly experience. Moreover, the two must be perfectly balanced such that the most salient stimulus or event is both the one that evokes strongest experiences (fear, joy, ... ) and strongest cognition (recall, memory, ...) – in other words, idea is well balanced with aesthesia. Ideasthesia theory of art may be used for psychological studies of aesthetics. It may also help explain classificatory disputes about art as its main tenet is that experience of art can only be individual, depending on person's unique knowledge, experiences and history.[33] There could exist no general classification of art satisfactorily applicable to each and all individuals. Neurophysiology of ideasthesia Ideasthesia is congruent with the theory of brain functioning known as practopoiesis.[34] According to that theory, concepts are not an emergent property of highly developed, specialized neuronal networks in the brain, as is usually assumed; rather, concepts are proposed to be fundamental to the very adaptive principles by which living systems and the brain operate.[35] A study using magnetoencephalography has shown that color information is available in the brain signal ~200 milliseconds later when accessed via synesthesia in comparison to direct color perception, which is consistent with conceptual mediation.[36] The study supports the idea that synesthesia is a semantic phenomenon – i.e., ideasthesia. |

共感覚の発達への示唆 観念感覚の概念は、共感覚がどのように発達していくかを理解する上で重要な意味を持つ。共感覚を持つ子どもは、具体的な感覚に似た体験を、そうでなければ 扱うのが難しい抽象的な概念に結びつけることがある[8]。このように共感覚は、教育システムが課す学習教材の抽象性に対処するための認知ツールとして使 われることがある。この仮説は、共感覚において最も一般的な誘発因子が、子供が習得する必要がある最初の真に抽象的な概念に関連する、書記素と時間単位で ある理由を説明する[24]。 芸術理論への影響 この理論によると、作品によって誘発される経験と、同じ作品によって誘発される意味論とが正確に釣り合っているとき、私たちは何かを芸術作品であるとみな す[33]。したがって、芸術作品は私たちに強く考えさせると同時に、強く経験させる。さらに、最も顕著な刺激や出来事が、最も強い経験(恐怖、喜 び、...)を喚起するものであると同時に、最も強い認知(想起、記憶、...)を喚起するものであるように、この2つが完璧に釣り合っていなければなら ない。 芸術のイデアステシア理論は、美学の心理学的研究に利用できるかもしれない。また、芸術の経験はその人固有の知識、経験、歴史に依存する個人的なものでしかありえないというのがその主な信条であるため、芸術に関する分類上の論争を説明するのにも役立つだろう。 観念感覚の神経生理学 この理論によれば、概念は、通常想定されているような、高度に発達し、特殊化された脳内のニューロン・ネットワークの創発的な特性ではなく、むしろ、概念は、生命システムと脳が活動する際の適応原理そのものが基本であると提唱されている[35]。 脳磁図を用いた研究では、共感覚によって色情報にアクセスする場合、直接的な色知覚と比較して200ミリ秒程度遅れて脳信号が利用可能になることが示されており、これは概念の媒介と一致している[36]。 |

| Aesthetics – Branch of philosophy dealing with the nature of art, beauty, and taste Charles Bonnet syndrome – visual disturbances and the experience of complex visual hallucinations in a blind person Classificatory disputes about art – Disputes about what should and should not be classified as art Consciousness – Awareness of existence Explanatory gap – Inability to describe conscious experiences in solely physical or structural terms Mind–body problem – Open question in philosophy of how abstract minds interact with physical bodies New mysterianism – Philosophical position on the mind-body problem Perception – Interpretation of sensory information Phantom eye syndrome – condition of pain in a lost eye Phantom limb – Sensation that an amputated or missing limb is attached Philosophical zombie – Thought experiment in philosophy Pictogram – Ideogram that conveys its meaning through its pictorial resemblance to a physical object Practopoiesis – System that can adapt to the environment Qualia – Instances of subjective experience Sentience – Ability to be aware of feelings and sensations Sound symbolism – Study in linguistics Synesthesia – Neurological condition involving the crossing of senses |

美学 - 芸術、美、味覚の本質を扱う哲学の一分野である。 シャルル・ボネ症候群 - 視覚障害と視覚障害者の複雑な幻覚体験 芸術の分類論争 - 何が芸術として分類されるべきか、されるべきでないかについての論争 意識 - 存在の認識 説明のギャップ - 意識的な経験を、物理的あるいは構造的な用語だけで説明することができない。 心身問題 - 抽象的な心がどのように肉体と相互作用するかという、哲学における未解決の問題 新・神秘主義 - 心身問題に対する哲学的立場 知覚 - 感覚情報の解釈 幻視症候群 - 失われた目に痛みを感じる症状 幻肢 - 切断または欠損した手足がついている感覚 Synesthesia.html - 哲学における思考実験 ピクトグラム - 物理的な物体に絵的に似ていることで意味を伝える表意文字 プラクティポイエーシス - 環境に適応できるシステム クオリア - 主観的な経験のインスタンス 感覚 - 感情や感覚を認識する能力 音象徴 - 言語学における研究 共感覚 - 感覚の交差を伴う神経学的状態 |

| https://en.wikipedia.org/wiki/Ideasthesia |

| The

McGurk effect is a perceptual phenomenon that demonstrates an

interaction between hearing and vision in speech perception. The

illusion occurs when the auditory component of one sound is paired with

the visual component of another sound, leading to the perception of a

third sound.[1] The visual information a person gets from seeing a

person speak changes the way they hear the sound.[2][3] If a person is

getting poor-quality auditory information but good-quality visual

information, they may be more likely to experience the McGurk effect.[4] Integration abilities for audio and visual information may also influence whether a person will experience the effect. People who are better at sensory integration have been shown to be more susceptible to the effect.[2] Many people are affected differently by the McGurk effect based on many factors, including brain damage and other disorders. Background It was first described in 1976 in a paper by Harry McGurk and John MacDonald, titled "Hearing Lips and Seeing Voices" in Nature (23 December 1976).[5] This effect was discovered by accident when McGurk and his research assistant, MacDonald, asked a technician to dub a video with a different phoneme from the one spoken while conducting a study on how infants perceive language at different developmental stages. When the video was played back, both researchers heard a third phoneme rather than the one spoken or mouthed in the video.[6] This effect may be experienced when a video of one phoneme's production is dubbed with a sound-recording of a different phoneme being spoken. Often, the perceived phoneme is a third, intermediate phoneme. As an example, the syllables /ba-ba/ are spoken over the lip movements of /ga-ga/, and the perception is of /da-da/. McGurk and MacDonald originally believed that this resulted from the common phonetic and visual properties of /b/ and /g/.[7] Two types of illusion in response to incongruent audiovisual stimuli have been observed: fusions ('ba' auditory and 'ga' visual produce 'da') and combinations ('ga' auditory and 'ba' visual produce 'bga').[8] This is the brain's effort to provide the consciousness with its best guess about the incoming information.[9] The information coming from the eyes and ears is contradictory, and in this instance, the eyes (visual information) have had a greater effect on the brain, and thus the fusion and combination responses have been created.[9] Vision is the primary sense for humans,[2] but speech perception is multimodal, which means that it involves information from more than one sensory modality, in particular, audition and vision. The McGurk effect arises during phonetic processing because the integration of audio and visual information happens early in speech perception.[7] The McGurk effect is very robust; that is, knowledge about it seems to have little effect on one's perception of it. This is different from certain optical illusions, which break down once one "sees through" them. Some people, including those that have been researching the phenomenon for more than twenty years, experience the effect even when they are aware that it is taking place.[8][10] With the exception of people who can identify most of what is being said from lip reading alone, most people are quite limited in their ability to identify speech from visual-only signals.[2] A more extensive phenomenon is the ability of visual speech to increase the intelligibility of heard speech in a noisy environment.[2] Visible speech can also alter the perception of perfectly audible speech sounds when the visual speech stimuli are mismatched with the auditory speech.[2] Normally, speech perception is thought to be an auditory process;[2] however, our use of information is immediate, automatic, and, to a large degree, unconscious[10] and therefore, despite what is widely accepted as true, speech is not only something we hear.[10] Speech is perceived by all of the senses working together (seeing, touching, and listening to a face move).[10] The brain is often unaware of the separate sensory contributions of what it perceives.[10] Therefore, when it comes to recognizing speech the brain cannot differentiate whether it is seeing or hearing the incoming information.[10] It has also been examined in relation to witness testimony. Wareham and Wright's 2005 study showed that inconsistent visual information can change the perception of spoken utterances, suggesting that the McGurk effect may have many influences in everyday perception. Not limited to syllables, the effect can occur in whole words[7][11] and have an effect on daily interactions that people are unaware of. Research into this area can provide information on not only theoretical questions, but also it can provide therapeutic and diagnostic relevance for those with disorders relating to audio and visual integration of speech cues.[12] Factors Internal Brain damage Both hemispheres of the brain make a contribution to the McGurk effect.[13] They work together to integrate speech information that is received through the auditory and visual senses. A McGurk response is more likely to occur in right-handed individuals for whom the face has privileged access to the right hemisphere and words to the left hemisphere.[13] In people that have had callosotomies done, the McGurk effect is still present but significantly slower.[13] In people with lesions to the left hemisphere of the brain, visual features often play a critical role in speech and language therapy.[12] People with lesions in the left hemisphere of the brain show a greater McGurk effect than normal controls.[12] Visual information strongly influences speech perception in these people.[12] There is a lack of susceptibility to the McGurk illusion if left hemisphere damage resulted in a deficit to visual segmental speech perception.[14] In people with right hemisphere damage, impairment on both visual-only and audio-visual integration tasks is exhibited, although they are still able to integrate the information to produce a McGurk effect.[14] Integration only appears if visual stimuli is used to improve performance when the auditory signal is impoverished but audible.[14] Therefore, there is a McGurk effect exhibited in people with damage to the right hemisphere of the brain but the effect is not as strong as a normal group. Dyslexia Dyslexic individuals exhibit a smaller McGurk effect than normal readers of the same chronological age, but they showed the same effect as reading-level age-matched readers.[15] Dyslexics particularly differed for combination responses, not fusion responses.[15] The smaller McGurk effect may be due to the difficulties dyslexics have in perceiving and producing consonant clusters.[15] Specific language impairment Children with specific language impairment show a significantly lower McGurk effect than the average child.[16] They use less visual information in speech perception, or have a reduced attention to articulatory gestures, but have no trouble perceiving auditory-only cues.[16] Autism spectrum disorders Children with autism spectrum disorders (ASD) showed a significantly reduced McGurk effect than children without.[17] However, if the stimulus was nonhuman (for example bouncing a tennis ball to the sound of a bouncing beach ball) then they scored similarly to children without ASD.[17] Younger children with ASD show a very reduced McGurk effect; however, this diminishes with age. As the individuals grow up, the effect they show becomes closer to those who did not have ASD.[18] It has been suggested that the weakened McGurk effect seen in people with ASD is due to deficits in identifying both the auditory and visual components of speech rather than in the integration of said components (although distinguishing speech components as speech components may be isomorphic to integrating them).[19] Language-learning disabilities Adults with language-learning disabilities exhibit a much smaller McGurk effect than other adults.[20] These people are not as influenced by visual input as most people.[20] Therefore, people with poor language skills will produce a smaller McGurk effect. A reason for the smaller effect in this population is that there may be uncoupled activity between anterior and posterior regions of the brain, or left and right hemispheres.[20] Cerebellar or basal ganglia etiology is also possible. Alzheimer’s disease In patients with Alzheimer's disease (AD), there is a smaller McGurk effect exhibited than in those without.[21] Often a reduced size of the corpus callosum produces a hemisphere disconnection process.[21] Less influence on visual stimulus is seen in patients with AD, which is a reason for the lowered McGurk effect.[21] Schizophrenia The McGurk effect is not as pronounced in schizophrenic individuals as in non-schizophrenic individuals. However, it is not significantly different in adults.[22] Schizophrenia slows down the development of audiovisual integration and does not allow it to reach its developmental peak. However, no degradation is observed.[22] Schizophrenics are more likely to rely on auditory cues than visual cues in speech perception.[22] Aphasia People with aphasia show impaired perception of speech in all conditions (visual-only, auditory-only, and audio-visual), and therefore exhibited a small McGurk effect.[23] The greatest difficulty for aphasics is in the visual-only condition showing that they use more auditory stimuli in speech perception.[23] Bipolar disorder A small study (N=22 per group) showed no apparent difference between individuals with bipolar disorder and those without, with respect to the McGurk effect. However, people with bipolar disorder showed significantly lower scores on a lipreading task. This may suggest that the neural pathways formed and activated in the integration of auditory and visual speech information in individuals with bipolar disorder are different compared to those in people without any mental disorder.[24] External Cross-dubbing Discrepancy in vowel category significantly reduced the magnitude of the McGurk effect for fusion responses.[25] Auditory /a/ tokens dubbed onto visual /i/ articulations were more compatible than the reverse.[25] This could be because /a/ has a wide range of articulatory configurations whereas /i/ is more limited,[25] which makes it much easier for subjects to detect discrepancies in the stimuli.[25] /i/ vowel contexts produce the strongest effect, while /a/ produces a moderate effect, and /u/ has almost no effect.[26] Mouth visibility The McGurk effect is stronger when the right side of the speaker's mouth (on the viewer's left) is visible.[27] People tend to get more visual information from the right side of a speaker's mouth than the left or even the whole mouth.[27] This relates to the hemispheric attention factors discussed in the brain hemispheres section above. Visual distractors The McGurk effect is weaker when there is a visual distractor present that the listener is attending to.[28] Visual attention modulates audiovisual speech perception.[28] Another form of distraction is movement of the speaker. A stronger McGurk effect is elicited if the speaker's face/head is motionless, rather than moving.[29] Syllable structure A strong McGurk effect can be seen for click-vowel syllables compared to weak effects for isolated clicks.[30] This shows that the McGurk effect can happen in a non-speech environment.[30] Phonological significance is not a necessary condition for a McGurk effect to occur; however, it does increase the strength of the effect.[30] Gender Females show a stronger McGurk effect than males. Women show significantly greater visual influence on auditory speech than men did for brief visual stimuli, but no difference is apparent for full stimuli.[29] Another aspect regarding gender is the issue of male faces and voices as stimuli in comparison to female faces and voices as stimuli. Although, there is no difference in the strength of the McGurk effect for either situation.[31] If a male face is dubbed with a female voice, or vice versa, there is still no difference in strength of the McGurk effect.[31] Knowing that the voice you hear is different from the face you see – even if different genders – doesn't eliminate the McGurk effect.[10] Familiarity Subjects who are familiar with the faces of the speakers are less susceptible to the McGurk effect than those who are unfamiliar with the faces of the speakers.[2][26] On the other hand, there was no difference regarding voice familiarity.[26] Expectation Semantic congruency had a significant impact on the McGurk illusion.[32] The effect is experienced more often and rated as clearer in the semantically congruent condition relative to the incongruent condition.[32] When a person was expecting a certain visual or auditory appearance based on the semantic information leading up to it, the McGurk effect was greatly increased.[32] Self-influence The McGurk effect can be observed when the listener is also the speaker or articulator.[33] While looking at oneself in the mirror and articulating visual stimuli while listening to another auditory stimulus, a strong McGurk effect can be observed.[33] In the other condition, where the listener speaks auditory stimuli softly while watching another person articulate the conflicting visual gestures, a McGurk effect can still be seen, although it is weaker.[33] Temporal synchrony Temporal synchrony is not necessary for the McGurk effect to be present.[34] Subjects are still strongly influenced by auditory stimuli even when it lagged the visual stimuli by 180 milliseconds (point at which McGurk effect begins to weaken).[34] There was less tolerance for the lack of synchrony if the auditory stimuli preceded the visual stimuli.[34] In order to produce a significant weakening of the McGurk effect, the auditory stimuli had to precede the visual stimuli by 60 milliseconds, or lag by 240 milliseconds.[2] Physical task diversion The McGurk effect was greatly reduced when attention was diverted to a tactile task (touching something).[35] Touch is a sensory perception like vision and audition, therefore increasing attention to touch, decreases the attention to auditory and visual senses. Gaze The eyes do not need to fixate in order to integrate audio and visual information in speech perception.[36] There was no difference in the McGurk effect when the listener was focusing anywhere on the speaker's face.[36] The effect does not appear if the listener focuses beyond the speaker's face.[2] In order for the McGurk effect to become insignificant, the listener's gaze must deviate from the speaker's mouth by at least 60 degrees.[36] |

マ

クガーク効果は、音声知覚における聴覚と視覚の相互作用を示す知覚現象である。この錯視は、ある音の聴覚的な成分と別の音の視覚的な成分とが対になり、第

3の音が知覚されることで起こる[1]。

人が話すのを見て得られる視覚的な情報によって、音の聞こえ方が変わる[2][3]。聴覚的な情報の質が低くても、視覚的な情報の質が高ければ、マクガー

ク効果を経験しやすい可能性がある[4]。 音声情報と視覚情報の統合能力も、その人が効果を経験するかどうかに影響する可能性がある。感覚統合が得意な人ほど、マクガーク効果の影響を受けやすいことが示されている[2]。脳の損傷やその他の障害など、多くの要因によってマクガーク効果の影響を受ける人は異なる。 背景 この効果は、1976年にハリー・マクガークとジョン・マクドナルドが『ネイチャー』誌(1976年12月23日号)に発表した論文「Hearing Lips and Seeing Voices」で初めて報告された[5]。マクガークと助手のマクドナルドが、乳幼児が異なる発達段階において言語をどのように知覚するかについての研究 を行っているときに、発話された音素とは異なる音素でビデオをダビングするよう技術者に依頼したところ、偶然発見された。ビデオを再生すると、研究者二人 はビデオで話されたり口にされたりした音素ではなく、第三の音素を聞いた[6]。 この効果は、ある音素の発声のビデオに、別の音素の発声を録音した音声をダビングした場合に経験することがある。多くの場合、知覚される音素は第3の中間 音素である。例えば、/ba-ba/という音節は、/ga-ga/という唇の動きの上で話されており、知覚は/da-da/である。McGurkと MacDonaldは当初、これは/b/と/g/の共通の音韻特性と視覚特性に起因すると考えていた[7]。不一致な視聴覚刺激に反応する2種類の錯覚が 観察されている:融合('ba'聴覚と'ga'視覚が'da'を生じる)と組み合わせ('ga'聴覚と'ba'視覚が'bga'を生じる)である。 [目と耳から入ってくる情報は矛盾しており、この例では目(視覚情報)の方が脳に大きな影響を与えたため、融合と組み合わせの反応が生まれた[9]。 視覚は人間にとって主要な感覚であるが[2]、音声知覚はマルチモーダルであり、複数の感覚モダリティ、特に聴覚と視覚からの情報が関与している。マク ガーク効果は音声処理中に生じるが、これは音声と視覚の統合が音声知覚の初期に起こるためである[7]。これは、ある種の錯視とは異なり、錯視はいったん 「見通す」と壊れてしまう。この現象を20年以上研究している人を含む何人かの人は、この現象が起きていること に気づいていても、その効果を体験している[8][10]。読唇術だけで話されていることの ほとんどを識別できる人を除けば、ほとんどの人は視覚のみの信号から音声を識別 する能力はかなり限られている。 [また、視覚的な音声刺激が聴覚的な音声刺激と不一致の場合、視覚的な音声は完全に聞き取れる音声の知覚を変化させることもある[2]。 [通常、音声知覚は聴覚的なプロセスであると考えられているが[2]、私たちが情報を利用するのは即時的、自動的であり、かなりの程度、無意識的である [10]。 [そのため、音声を認識するとき、脳は入ってくる情報を見ているのか聞いているのかを区別することができない[10]。 また、目撃証言との関連も検討されている。WarehamとWrightの2005年の研究では、一貫性のない視覚情報が話し言葉の知覚を変化させること が示され、マクガーク効果は日常的な知覚に多くの影響を及ぼす可能性が示唆された。この効果は音節に限らず、単語全体[7][11]で起こる可能性があ り、日常的な相互作用に影響を及ぼす可能性がある。この分野の研究は、理論的な疑問に関する情報を提供するだけでなく、音声と視覚の統合に関連する障害を 持つ人々に対して、治療や診断に関連する情報を提供することができる[12]。 要因 内部 脳の損傷 脳の両半球がマクガーク効果に寄与している[13]。 両半球は協力して、聴覚と視覚を通して受け取った音声情報を統合する。マックガーク反応は、顔が右半球に、言葉が左半球に優先的にアクセスできる右利きの 人に起こりやすい[13]。 [脳の左半球に病変のある人では、視覚的特徴が言語療法において重要な役割を果たすことが多い[12]。 脳の左半球に病変のある人は、正常な対照者よりも大きなマクガーク効果を示す[12]。 [12]左半球の損傷によって視覚的な分節音声知覚に障害が生じた場合、マクガーク錯視の感受性はない[14]。 右半球の損傷者では、視覚のみの課題でも視聴覚統合の課題でも障害を示すが、情報を統合してマクガーク効果を生じさせることはできる。 [14]統合が現れるのは、聴覚信号が貧弱だが可聴である場合に、視覚刺激を用いてパフォーマンスを向上させた場合のみである[14]。したがって、脳の 右半球に障害のある人にはマクガーク効果が認められるが、その効果は健常者ほど強くない。 失読症 ディスレクシアの人は、同じ年代年齢の健常読者よりもマクガーク効果が小さいが、読書レベルの年齢をマッチさせた読者と同じ効果を示した[15]。ディス レクシアの人は、融合反応ではなく、組み合わせ反応に特に差があった[15]。マクガーク効果が小さいのは、ディスレクシアの人が子音クラスターを知覚 し、生成することが困難であるためと考えられる[15]。 特異的言語障害 特異的言語障害のある子どもは、平均的な子どもよりも有意に低いマクガーク効果を示す[16]。 彼らは、音声知覚における視覚情報の利用が少ないか、調音ジェスチャーに対する注意力が低下しているが、聴覚のみの手がかりを知覚することには問題がない[16]。 自閉症スペクトラム 自閉スペクトラム症(ASD)の子どもは、そうでない子どもよりもマクガーク効果が有意に低下していた[17]。しかし、刺激が非人間的なもの(例えば、 ビーチボールの弾む音に合わせてテニスボールを弾むなど)であれば、ASDでない子どもと同様のスコアを示した[17]。ASDの人に見られるマクガーク 効果の弱まりは、音声の聴覚的・視覚的な構成要素を統合することよりも、その両方を識別することに障害があるためであると示唆されている[18](ただ し、音声構成要素を音声構成要素として区別することは、それらを統合することと同型であるかもしれない)[19]。 言語学習障害 言語学習障害のある成人は、他の成人に比べてはるかに小さなマクガーク効果を示す[20]。 このような人は、ほとんどの人ほど視覚的入力の影響を受けない[20]。したがって、言語能力が低い人は、より小さなマクガーク効果を生じる。このような 集団で効果が小さい理由としては、脳の前部と後部、または左半球と右半球の間の活動が結合していないことが考えられる[20]。 アルツハイマー病 アルツハイマー病(AD)患者では、そうでない患者よりもマクガーク効果の発現が小さい[21]。しばしば脳梁の縮小によって半球の断絶過程が生じる[21]。AD患者では視覚刺激に対する影響が少なく、これがマクガーク効果の低下の理由である[21]。 統合失調症 統合失調症患者では、マクガーク効果は非統合失調症患者ほど顕著ではない。しかし、成人では有意差はない[22]。統合失調症では視聴覚統合の発達が遅く なり、発達のピークに達しない。しかし、劣化は認められない[22]。統合失調症患者は、音声知覚において視覚的手がかりよりも聴覚的手がかりに依存する 傾向が強い[22]。 失語症 失語症者は、すべての条件(視覚のみ、聴覚のみ、視聴覚)において音声知覚の障害を示し、そのため小さなマクガーク効果を示した[23]。失語症者にとって最も困難なのは視覚のみの条件であり、音声知覚において聴覚刺激をより多く用いることを示している[23]。 双極性障害 小規模の研究(各群N=22)では、マクガーク効果に関して双極性障害のある人とない人の間に明らかな差は認められなかった。しかし、双極性障害の人は読 唇課題で有意に低い得点を示した。このことは、双極性障害の人が聴覚と視覚の音声情報を統合する際に形成され、活性化される神経経路が、精神障害のない人 と比べて異なっていることを示唆しているのかもしれない[24]。 外部 クロスダビング 母音カテゴリーの不一致は、融合反応のMcGurk効果の大きさを有意に減少させた[25]。聴覚的/a/トークンを視覚的/i/調音にダビングすると、 その逆よりも適合性が高くなった。 [25]これは、/a/が幅広い調音構成を持っているのに対して、/i/はより限定的であるため[25]、被験者が刺激の不一致を検出しやすくなるためと 考えられる[25]。 口の視認性 マクガーク効果は、話し手の口の右側(見る人の左側)が見えると強くなる[27]。人は話し手の口の右側から、左側や口全体よりも多くの視覚情報を得る傾向がある。 視覚的注意散漫 視覚的注意は視聴覚的音声知覚を調節する[28] 。話者の顔や頭が動いているよりも、むしろ動いていない方が、より強いマクガーク効果が誘発される[29]。 音節構造 このことは、マクガーク効果が非音声環境でも起こりうることを示している[30]。音韻的有意性はマクガーク効果が起こるための必要条件ではないが、効果の強さを増加させる[30]。 性別 女性は男性よりも強いマクガーク効果を示す。女性は、短時間の視覚刺激では男性よりも聴覚的発話に対する視覚的影響が有意に大きいが、完全な刺激では差は 見られない。しかし、どちらの状況でもマクガーク効果の強さに差はない[31]。男性の顔に女性の声をダビングしても、あるいはその逆でも、やはりマク ガーク効果の強さに差はない[31]。たとえ性別が異なっても、聞こえてくる声と見えている顔が異なることを知っても、マクガーク効果がなくなるわけでは ない。 慣れ 話し手の顔に慣れている被験者は、話し手の顔に慣れていない被験者よりもマクガーク効果の影響を受けにくい[2][26]。一方、声に慣れているかどうかについては差がなかった[26]。 期待 意味的一致はマクガーク錯視に大きな影響を与える[32]。 意味的一致の条件では、不一致の条件に比べて、より頻繁に効果を経験し、より明瞭であると評価される[32]。 自己影響 マクガーク効果は、聞き手が話し手または調音者でもある場合に観察されることがある[33]。鏡の中の自分を見て、別の聴覚刺激を聞きながら視覚刺激を調 音しているときに、強いマクガーク効果が観察されることがある[33]。もう1つの条件では、相反する視覚的身振りを調音する別の人を見ながら、聞き手が 聴覚刺激をソフトに話す場合、マクガーク効果は弱くなるが、依然として観察されることがある[33]。 時間的同期 時間的同期性はマクガーク効果の発現に必要なものではない。[34] 聴覚刺激が視覚刺激より180ミリ秒遅れても(マクガーク効果が弱まり始める時点)、被験者は依然として聴覚刺激に強く影響される。 [34]聴覚刺激が視覚刺激に先行する場合は、同調性の欠如に対する許容度が低かった[34]。マクガーク効果の有意な弱まりを生じさせるためには、聴覚 刺激が視覚刺激に60ミリ秒先行するか、240ミリ秒遅れる必要があった[2]。 物理的課題転換 触覚は視覚や聴覚と同じ感覚知覚であるため、触覚への注意 を高めると聴覚や視覚への注意が低下する。 視線 音声知覚において音声と視覚の情報を統合するために、目は固視する必要はない[36]。聞き手が話し手の顔のどこかに焦点を合わせている場合、マクガーク 効果に差はなかった[36]。 聞き手が話し手の顔の向こう側に焦点を合わせている場合、効果は現れない[2]。マクガーク効果が重要でなくなるためには、聞き手の視線が話し手の口元か ら少なくとも60度ずれる必要がある[36]。 |

リ ンク

文 献

そ の他の情報

Copyleft, CC, Mitzub'ixi Quq Chi'j, 1996-2099

☆

☆

☆