マルチモーダルな統合

multimodal integration, or multisensory integration

Philippe Mercier, The Sense of Taste, c.1744-47

☆ 多感覚統合(マルチモーダルな統合とも呼ばれる)は、異なる感覚モダリティ(視覚、聴覚、触覚、嗅覚、自己運動、味覚など)からの情報が、神経系によって どのように統合されるかを研究する学問である。実際、多感覚統合は、動物が首尾一貫した知覚実体の世界を認識することを可能にするため、適応行動の中心的 役割を担っている。多感覚統合はまた、異なる感覚モダリティがどのように相互作用し、互いの処理を変化させるかを扱う。

★クロスモーダル知覚(cross-modal perception)とは、2つ以上の異なる感覚モダリティ間の相互作用を伴う知覚のことである。その例として、共感覚、感覚代替、視覚と聴覚が相互作用して音声を知覚するマクガーク効果などが挙げられる。

| Multisensory integration, also known as multimodal integration,

is the study of how information from the different sensory modalities

(such as sight, sound, touch, smell, self-motion, and taste) may be

integrated by the nervous system.[1] A coherent representation of

objects combining modalities enables animals to have meaningful

perceptual experiences. Indeed, multisensory integration is central to

adaptive behavior because it allows animals to perceive a world of

coherent perceptual entities.[2] Multisensory integration also deals

with how different sensory modalities interact with one another and

alter each other's processing. |

多

感覚統合(マルチモーダルな統合とも呼ばれる)は、異なる感覚モダリティ(視覚、聴覚、触覚、嗅覚、自己運動、味覚など)からの情報が、神経系によってど

のように統合されるかを研究する学問である。実際、多感覚統合は、動物が首尾一貫した知覚実体の世界を認識することを可能にするため、適応行動の中心的役

割を担っている。多感覚統合はまた、異なる感覚モダリティがどのように相互作用し、互いの処理を変化させるかを扱う。 |

| General introduction Multimodal perception is how animals form coherent, valid, and robust perception by processing sensory stimuli from various modalities. Surrounded by multiple objects and receiving multiple sensory stimulations, the brain is faced with the decision of how to categorize the stimuli resulting from different objects or events in the physical world. The nervous system is thus responsible for whether to integrate or segregate certain groups of signals. Multimodal perception has been widely studied in cognitive science, behavioral science, and neuroscience. Stimuli and sensory modalities There are four attributes of stimulus: modality, intensity, location, and duration. The neocortex in the mammalian brain has parcellations that primarily process sensory input from one modality. For example, primary visual area, V1, or primary somatosensory area, S1. These areas mostly deal with low-level stimulus features such as brightness, orientation, intensity, etc. These areas have extensive connections to each other as well as to higher association areas that further process the stimuli and are believed to integrate sensory input from various modalities. However, multisensory effects have been shown to occur in primary sensory areas as well.[3] Binding problem Main article: Binding problem The relationship between the binding problem and multisensory perception can be thought of as a question – the binding problem – and its potential solution – multisensory perception. The binding problem stemmed from unanswered questions about how mammals (particularly higher primates) generate a unified, coherent perception of their surroundings from the cacophony of electromagnetic waves, chemical interactions, and pressure fluctuations that forms the physical basis of the world around us. It was investigated initially in the visual domain (colour, motion, depth, and form), then in the auditory domain, and recently in the multisensory areas. It can be said therefore, that the binding problem is central to multisensory perception.[4] However, considerations of how unified conscious representations are formed are not the full focus of multisensory Integration research. It is obviously important for the senses to interact in order to maximize how efficiently people interact with the environment. For perceptual experience and behavior to benefit from the simultaneous stimulation of multiple sensory modalities, integration of the information from these modalities is necessary. Some of the mechanisms mediating this phenomenon and its subsequent effects on cognitive and behavioural processes will be examined hereafter. Perception is often defined as one's conscious experience, and thereby combines inputs from all relevant senses and prior knowledge. Perception is also defined and studied in terms of feature extraction, which is several hundred milliseconds away from conscious experience. Notwithstanding the existence of Gestalt psychology schools that advocate a holistic approach to the operation of the brain,[5][6] the physiological processes underlying the formation of percepts and conscious experience have been vastly understudied. Nevertheless, burgeoning neuroscience research continues to enrich our understanding of the many details of the brain, including neural structures implicated in multisensory integration such as the superior colliculus (SC)[7] and various cortical structures such as the superior temporal gyrus (GT) and visual and auditory association areas. Although the structure and function of the SC are well known, the cortex and the relationship between its constituent parts are presently the subject of much investigation. Concurrently, the recent impetus on integration has enabled investigation into perceptual phenomena such as the ventriloquism effect,[8] rapid localization of stimuli and the McGurk effect;[9] culminating in a more thorough understanding of the human brain and its functions. History Studies of sensory processing in humans and other animals has traditionally been performed one sense at a time,[10] and to the present day, numerous academic societies and journals are largely restricted to considering sensory modalities separately ('Vision Research', 'Hearing Research' etc.). However, there is also a long and parallel history of multisensory research. An example is the Stratton's (1896) experiments on the somatosensory effects of wearing vision-distorting prism glasses.[11][12] Multisensory interactions or crossmodal effects in which the perception of a stimulus is influenced by the presence of another type of stimulus are referred since very early in the past. They were reviewed by Hartmann[13] in a fundamental book where, among several references to different types of multisensory interactions, reference is made to the work of Urbantschitsch in 1888[14] who reported on the improvement of visual acuity by auditive stimuli in subjects with damaged brains. This effect was also found later in individuals with undamaged brains by Krakov[15] and Hartmann,[16] as well as the fact that the visual acuity could be improved by other type of stimuli.[16] It is also noteworthy the amount of work in the early 1930s on intersensory relations in the Soviet Union, reviewed by London.[17] A remarkable multisensory research is the extensive and pioneering work of Gonzalo [18] in the mid-20th century on the characterization of a multisensory syndrome in patients with parieto-occipital cortical lesions. In this syndrome, all the sensory functions are affected, and with symmetric bilaterality, in spite of being a unilateral lesion where the primary areas were not involved. A feature of this syndrome is the great permeability to crossmodal effects between visual, tactile, auditive stimuli as well as muscular effort to improve the perception, also decreasing the reaction times. The improvement by crossmodal effect was found to be greater as the primary stimulus to be perceived was weaker, and as the cortical lesion was greater (Vol 1 and 2 of reference[18]). This author interpreted these phenomena under a dynamic physiological concept, and from a model based on functional gradients through the cortex and scaling laws of dynamical systems, thus highlighting the functional unity of the cortex. According to the functional cortical gradients, the specificity of the cortex would be distributed in gradation, and the overlap of different specific gradients would be related to multisensory interactions.[19] Multisensory research has recently gained enormous interest and popularity. Example of spatial and structural congruence When we hear a car honk, we would determine which car triggers the honk by which car we see is the spatially closest to the honk. It's a spatially congruent example by combining visual and auditory stimuli. On the other hand, the sound and the pictures of a TV program would be integrated as structurally congruent by combining visual and auditory stimuli. However, if the sound and the pictures did not meaningfully fit, we would segregate the two stimuli. Therefore, spatial or structural congruence comes from not only combining the stimuli but is also determined by our understanding. |

はじめに マルチモーダル知覚とは、動物が様々なモダリティからの感覚刺激を処理することで、首尾一貫した、有効で頑健な知覚を形成する方法のことである。複数の物 体に囲まれ、複数の感覚刺激を受けている脳は、物理世界における様々な物体や事象から生じる刺激をどのように分類するかという決定に直面する。神経系はこ のように、特定の信号群を統合するか分離するかを決定する。マルチモーダル知覚は、認知科学、行動科学、神経科学において広く研究されている。 刺激と感覚モダリティ 刺激には、モダリティ、強度、位置、持続時間の4つの属性がある。哺乳類の脳の新皮質には、主に1つのモダリティからの感覚入力を処理する小区域がある。 例えば、一次視覚野V1や一次体性感覚野S1である。これらの領域は主に、明るさ、方向、強さなどの低レベルの刺激特徴を扱う。これらの領域は、刺激をさ らに処理する高次連合野だけでなく、互いに広範に結合しており、さまざまなモダリティからの感覚入力を統合していると考えられている。しかし、多感覚効果 は一次感覚野でも起こることが示されている[3]。 結合の問題 主な記事 結合問題 束縛問題と多感覚知覚の関係は、束縛問題という疑問と、多感覚知覚という潜在的な解決策として考えることができる。結合問題は、哺乳類(特に高等霊長類) が、私たちを取り巻く世界の物理的基盤を形成している電磁波、化学的相互作用、圧力変動の不協和音から、どのようにして統一された首尾一貫した周囲の知覚 を生み出すのか、という未解決の疑問に端を発している。最初は視覚領域(色、動き、奥行き、形)で研究され、次に聴覚領域、そして最近では多感覚領域で研 究されている。したがって、結合問題は多感覚知覚の中心的な問題であると言える[4]。 しかし、統一された意識表象がどのように形成されるかという考察は、多感覚統合研究の焦点のすべてではない。人が環境といかに効率的に相互作用するかを最 大化するためには、感覚が相互作用することが明らかに重要である。複数の感覚モダリティの同時刺激から知覚経験や行動が恩恵を受けるためには、これらのモ ダリティからの情報の統合が必要である。以下では、この現象を媒介するメカニズムの一部と、認知・行動プロセスへのその後の影響について検討する。知覚は しばしば、自分の意識的な経験として定義され、それによってすべての関連する感覚と予備知識からの入力が組み合わされる。知覚はまた、意識的な体験から数 百ミリ秒離れた特徴抽出の観点からも定義され、研究されている。脳の働きに対する全体論的アプローチを提唱するゲシュタルト心理学の学派が存在するにもか かわらず[5][6]、知覚と意識的経験の形成の根底にある生理学的プロセスは、これまでほとんど研究されてこなかった。とはいえ、急成長する神経科学研 究は、上丘(SC)[7]などの多感覚統合に関与する神経構造や、上側頭回(GT)、視覚・聴覚連合野などの様々な皮質構造を含め、脳の多くの詳細につい ての理解を深め続けている。SCの構造と機能はよく知られているが、大脳皮質とその構成部分間の関係については、現在多くの研究が行われている。同時に、 最近の統合化の推進により、腹話術効果[8]、刺激の迅速な局在化、マクガーク効果[9]などの知覚現象の研究が可能になり、ヒトの脳とその機能のより詳 細な理解が得られるに至っている。 歴史 ヒトや他の動物における感覚処理の研究は、伝統的に1つの感覚ずつ行われており[10]、現在に至るまで、多くの学会や学術誌が感覚モダリティを別々に考 えることに大きく制限されている(「視覚研究」、「聴覚研究」など)。しかし、多感覚研究の長い歴史も並行して存在する。一例として、視覚を歪めるプリズ ム眼鏡をかけたときの体性感覚効果に関するStrattonの実験(1896年)が挙げられる[11][12]。ある刺激の知覚が別の種類の刺激の存在に よって影響を受けるという多感覚相互作用またはクロスモーダル効果は、非常に早い時期から言及されている。Hartmann[13]は基本的な本の中で多 感覚的相互作用について概説しており、様々な種類の多感覚的相互作用に関するいくつかの文献の中で、1888年にUrbantschitsch[14]が 脳に損傷を受けた被験者において聴覚刺激によって視力が改善したことを報告している。この効果は、後にクラコフ[15]やハルトマン[16]によって、損 傷を受けていない脳でも発見された。 [17] 顕著な多感覚研究は、20世紀半ばのGonzalo [18] による、頭頂-後頭葉皮質病変患者における多感覚症候群の特徴に関する広範かつ先駆的な研究である。この症候群では、すべての感覚機能が影響を受け、一側 性の病変であるにもかかわらず、対称的な両側性を示す。本症候群の特徴は、視覚、触覚、聴覚刺激間のクロスモーダル効果に非常に寛容であること、また知覚 を改善するための筋力努力も反応時間を短縮させる。クロスモーダル効果による改善は、知覚すべき一次刺激が弱いほど、また大脳皮質の病変が大きいほど大き いことがわかった(文献[18]のVol.1およびVol.2)。筆者は、これらの現象を動的生理学的概念のもとで、大脳皮質の機能勾配と力学系のスケー リング則に基づくモデルから解釈し、大脳皮質の機能的統一性を強調した。大脳皮質の機能的勾配によれば、大脳皮質の特異性は勾配状に分布し、異なる特異的 勾配の重なりは多感覚相互作用に関係していることになる[19]。 空間的・構造的一致の例 私たちは車のクラクションを聞いたとき、どの車がクラクションの引き金 になったかを、どの車がクラクションに空間的に最も近いかで判断する。視覚刺激と聴覚刺激の組み合わせによる空間的一致の例である。一方、テレビ番組の音 と絵は、視覚刺激と聴覚刺激の組み合わせによって、構造的に一致したものとして統合される。しかし、もし音と絵が意味のある一致でなければ、私たちは2つ の刺激を分離するだろう。したがって、空間的あるいは構造的な一致は、刺激の組み合わせからだけでなく、私たちの理解によっても決まるのである。 |

| Theories and approaches Visual dominance Literature on spatial crossmodal biases suggests that visual modality often influences information from other senses.[20] Some research indicates that vision dominates what we hear, when varying the degree of spatial congruency. This is known as the ventriloquist effect.[21] In cases of visual and haptic integration, children younger than 8 years of age show visual dominance when required to identify object orientation. However, haptic dominance occurs when the factor to identify is object size.[22][23] Modality appropriateness According to Welch and Warren (1980), the Modality Appropriateness Hypothesis states that the influence of perception in each modality in multisensory integration depends on that modality's appropriateness for the given task. Thus, vision has a greater influence on integrated localization than hearing, and hearing and touch have a greater bearing on timing estimates than vision.[24][25] More recent studies refine this early qualitative account of multisensory integration. Alais and Burr (2004), found that following progressive degradation in the quality of a visual stimulus, participants' perception of spatial location was determined progressively more by a simultaneous auditory cue.[26] However, they also progressively changed the temporal uncertainty of the auditory cue; eventually concluding that it is the uncertainty of individual modalities that determine to what extent information from each modality is considered when forming a percept.[26] This conclusion is similar in some respects to the 'inverse effectiveness rule'. The extent to which multisensory integration occurs may vary according to the ambiguity of the relevant stimuli. In support of this notion, a recent study shows that weak senses such as olfaction can even modulate the perception of visual information as long as the reliability of visual signals is adequately compromised.[27] Bayesian integration The theory of Bayesian integration is based on the fact that the brain must deal with a number of inputs, which vary in reliability.[28] In dealing with these inputs, it must construct a coherent representation of the world that corresponds to reality. The Bayesian integration view is that the brain uses a form of Bayesian inference.[29] This view has been backed up by computational modeling of such a Bayesian inference from signals to coherent representation, which shows similar characteristics to integration in the brain.[29] Cue combination vs. causal inference models With the assumption of independence between various sources, the traditional cue combination model is successful in modality integration. However, depending on the discrepancies between modalities, there might be different forms of stimuli fusion: integration, partial integration, and segregation. To fully understand the other two types, we have to use causal inference model without the assumption as cue combination model. This freedom gives us general combination of any numbers of signals and modalities by using Bayes' rule to make causal inference of sensory signals.[30] The hierarchical vs. non-hierarchical models The difference between two models is that hierarchical model can explicitly make causal inference to predict certain stimulus while non-hierarchical model can only predict joint probability of stimuli. However, hierarchical model is actually a special case of non-hierarchical model by setting joint prior as a weighted average of the prior to common and independent causes, each weighted by their prior probability. Based on the correspondence of these two models, we can also say that hierarchical is a mixture modal of non-hierarchical model. Independence of likelihoods and priors For Bayesian model, the prior and likelihood generally represent the statistics of the environment and the sensory representations. The independence of priors and likelihoods is not assured since the prior may vary with likelihood only by the representations. However, the independence has been proved by Shams with series of parameter control in multi sensory perception experiment.[31] Shared intentionality The shared intentionality approach proposes the holistic explanation of the neurophysiological processes underlying the formation of percepts and conscious experience. The psychological construct of shared intentionality was introduced at the end of 20th century.[32][33][34] Michael Tomasello developed it to explain cognition beginning in the earlier developmental stage through unaware collaboration in mother-child dyads.[35][36] Over the past twenty years, knowledge of this notion has evolved through observing shared intentionality from different perspectives, e.g., psychophysiology,[37][38] and neurobiology.[39] According to Igor Val Danilov, shared intentionality enables the mother-child pair to share the essential sensory stimulus of the actual cognitive problem.[40] The hypothesis of neurophysiological processes occurring during shared intentionality explains its integrative complexity from neuronal to interpersonal dynamics levels.[41] This collaborative interaction provides environmental learning of the immature organism, starting at the reflexes stage of development, for processing the organization, identification, and interpretation of sensory information in developing perception.[42] From this perspective, Shared intentionality contributes to the formation of percepts and conscious experiences, solving the binding problem, or at least complements one of the mechanisms noted above.[43] |

理論とアプローチ 視覚優位 空間的クロスモーダルバイアスに関する文献は、視覚モダリ ティがしばしば他の感覚からの情報に影響を与えることを示唆し ている[20]。いくつかの研究は、空間的一致の程度を変化させると、 視覚が聴覚を支配することを示している。これは腹話術効果として知られ ている[21]。視覚と触覚の統合の場合、8歳未満の子どもは物体の方 向を識別する際に視覚優位を示す。しかし、識別すべき要因が物体の大きさである場合には、触覚優位が生じる[22][23]。 モダリティの適切性 WelchとWarren (1980)によると、モダリティの適切性仮説は、多感覚統合における各モダリティの知覚の影響は、そのモダリティが与えられた課題に適切であるかどうか に依存すると述べている。したがって、視覚は聴覚よりも統合された定位に大きな影響を及ぼし、聴覚と触覚は視覚よりもタイミングの推定に大きな影響を及ぼ す[24][25]。 より最近の研究では、多感覚統合に関するこの初期の定性的な説明が改良されている。AlaisとBurr(2004)は、視覚刺激の質が漸進的に低下する と、参加者の空間的位置の知覚は、同時に提示される聴覚的手がかりによって漸進的に決定されることを発見した[26]。しかし、聴覚的手がかりの時間的不 確実性も漸進的に変化し、最終的には、知覚を形成する際に各モダリティからの情報がどの程度考慮されるかを決定するのは、個々のモダリティの不確実性であ ると結論づけた[26]。この結論は、「逆有効性の法則」と類似している点がある。多感覚統合の程度は、関連する刺激の曖昧さによって変化する可能性があ る。この考え方を裏付けるように、最近の研究では、視覚信号の信頼性が十分に損なわれている限り、嗅覚のような弱い感覚が視覚情報の知覚を変調させること さえあることが示されている[27]。 ベイズ積分 ベイズ積分の理論は、脳が信頼性の異なる多くの入力を扱わなけれ ばならないという事実に基づいている[28]。この見解は、信号から首尾一貫した表象へのベ イジアン推論の計算モデル化によって裏付けられており、 脳における統合と同様の特徴を示している[29]。 手がかりの組み合わせ対因果推論モデル 様々な情報源間の独立性を仮定すると、伝統的な手がかり結合モデルはモダリティ統合に成功する。しかし、モダリティ間の不一致に応じて、統合、部分統合、 分離という異なる形態の刺激融合が存在する可能性がある。他の2つのタイプを完全に理解するためには、手がかり結合モデルのような仮定を持たない因果推論 モデルを使用する必要がある。この自由度は、感覚信号の因果推論を行うためにベイズのルールを使用することによって、任意の数の信号とモダリティの一般的 な組み合わせを与える[30]。 階層モデルと非階層モデル この2つのモデルの違いは、階層モデルはある刺激を予測する因果推論を明示的に行うことができるのに対し、非階層モデルは刺激の結合確率を予測することし かできないという点である。しかし、階層モデルは実際には非階層モデルの特殊なケースであり、共同事前分布を共通および独立の原因に対する事前分布の加重 平均として設定し、それぞれの事前確率で加重する。この2つのモデルの対応から、階層モデルは非階層モデルの混合モーダルであるとも言える。 尤度と事前確率の独立性 ベイズモデルでは、一般に事前分布と尤度は環境と感覚表現の統計量を表す。事前分布と尤度の独立性は保証されていない。しかし、多感覚知覚実験における一連のパラメータ制御により、シャムスによって独立性が証明されている[31]。 共有意図性 共有意図性アプローチは、知覚と意識経験の形成の基礎となる神経生理学的プロセスの全体的な説明を提案する。共有意図性という心理学的構成概念は20世紀 末に導入された[32][33][34]。マイケル・トマセロは、母子二人組における無自覚な協働を通じて、発達初期段階から始まる認知を説明するために この概念を開発した[35][36]、 イゴール・ヴァル・ダニロフ[39]によると、共有された意図性は母子ペアが実際の認知問題の本質的な感覚刺激を共有することを可能にする[40]。共有 された意図性の間に起こる神経生理学的プロセスの仮説は、神経細胞レベルから対人ダイナミクスのレベルまでの統合的な複雑性を説明する。 [この協調的相互作用は、発達の反射段階から始まる未熟な生物の環境学習を提供し、知覚を発達させる際の感覚情報の組織化、識別、解釈を処理する [42]。この観点から、共有意図性は知覚と意識的経験の形成に寄与し、束縛問題を解決するか、少なくとも上述のメカニズムの一つを補完する[43]。 |

| Principles The contributions of Barry Stein, Alex Meredith, and their colleagues (e.g."The merging of the senses" 1993,[44]) are widely considered to be the groundbreaking work in the modern field of multisensory integration. Through detailed long-term study of the neurophysiology of the superior colliculus, they distilled three general principles by which multisensory integration may best be described. The spatial rule[45][46] states that multisensory integration is more likely or stronger when the constituent unisensory stimuli arise from approximately the same location. The temporal rule[46][47] states that multisensory integration is more likely or stronger when the constituent unisensory stimuli arise at approximately the same time. The principle of inverse effectiveness[48][49] states that multisensory integration is more likely or stronger when the constituent unisensory stimuli evoke relatively weak responses when presented in isolation. Perceptual and behavioral consequences A unimodal approach dominated scientific literature until the beginning of this century. Although this enabled rapid progression of neural mapping, and an improved understanding of neural structures, the investigation of perception remained relatively stagnant, with a few exceptions. The recent revitalized enthusiasm into perceptual research is indicative of a substantial shift away from reductionism and toward gestalt methodologies. Gestalt theory, dominant in the late 19th and early 20th centuries espoused two general principles: the 'principle of totality' in which conscious experience must be considered globally, and the 'principle of psychophysical isomorphism' which states that perceptual phenomena are correlated with cerebral activity. Just these ideas were already applied by Justo Gonzalo in his work of brain dynamics, where a sensory-cerebral correspondence is considered in the formulation of the "development of the sensory field due to a psychophysical isomorphism" (pag. 23 of the English translation of ref.[19]). Both ideas 'principle of totality' and 'psychophysical isomorphism' are particularly relevant in the current climate and have driven researchers to investigate the behavioural benefits of multisensory integration. Decreasing sensory uncertainty It has been widely acknowledged that uncertainty in sensory domains results in an increased dependence of multisensory integration.[26] Hence, it follows that cues from multiple modalities that are both temporally and spatially synchronous are viewed neurally and perceptually as emanating from the same source. The degree of synchrony that is required for this 'binding' to occur is currently being investigated in a variety of approaches.[50] The integrative function only occurs to a point beyond which the subject can differentiate them as two opposing stimuli. Concurrently, a significant intermediate conclusion can be drawn from the research thus far. Multisensory stimuli that are bound into a single percept, are also bound on the same receptive fields of multisensory neurons in the SC and cortex.[26] Decreasing reaction time Responses to multiple simultaneous sensory stimuli can be faster than responses to the same stimuli presented in isolation. Hershenson (1962) presented a light and tone simultaneously and separately, and asked human participants to respond as rapidly as possible to them. As the asynchrony between the onsets of both stimuli was varied, it was observed that for certain degrees of asynchrony, reaction times were decreased.[51] These levels of asynchrony were quite small, perhaps reflecting the temporal window that exists in multisensory neurons of the SC. Further studies have analysed the reaction times of saccadic eye movements;[52] and more recently correlated these findings to neural phenomena.[53] In patients studied by Gonzalo,[18] with lesions in the parieto-occipital cortex, the decrease in the reaction time to a given stimulus by means of intersensory facilitation was shown to be very remarkable. Redundant target effects The redundant target effect is the observation that people typically respond faster to double targets (two targets presented simultaneously) than to either of the targets presented alone. This difference in latency is termed the redundancy gain (RG).[54] In a study done by Forster, Cavina-Pratesi, Aglioti, and Berlucchi (2001), normal observers responded faster to simultaneous visual and tactile stimuli than to single visual or tactile stimuli. RT to simultaneous visual and tactile stimuli was also faster than RT to simultaneous dual visual or tactile stimuli. The advantage for RT to combined visual-tactile stimuli over RT to the other types of stimulation could be accounted for by intersensory neural facilitation rather than by probability summation. These effects can be ascribed to the convergence of tactile and visual inputs onto neural centers which contain flexible multisensory representations of body parts.[55] Multisensory illusions McGurk effect It has been found that two converging bimodal stimuli can produce a perception that is not only different in magnitude than the sum of its parts, but also quite different in quality. In a classic study labeled the McGurk effect,[56] a person's phoneme production was dubbed with a video of that person speaking a different phoneme.[57] The result was the perception of a third, different phoneme. McGurk and MacDonald (1976) explained that phonemes such as ba, da, ka, ta, ga and pa can be divided into four groups, those that can be visually confused, i.e. (da, ga, ka, ta) and (ba and pa), and those that can be audibly confused. Hence, when ba – voice and ga lips are processed together, the visual modality sees ga or da, and the auditory modality hears ba or da, combining to form the percept da.[56] Ventriloquism Ventriloquism has been used as the evidence for the modality appropriateness hypothesis. The ventriloquism effect is the situation in which auditory location perception is shifted toward a visual cue. The original study describing this phenomenon was conducted by Howard and Templeton, (1966) after which several studies have replicated and built upon the conclusions they reached.[58] In conditions in which the visual cue is unambiguous, visual capture reliably occurs. Thus to test the influence of sound on perceived location, the visual stimulus must be progressively degraded.[26] Furthermore, given that auditory stimuli are more attuned to temporal changes, recent studies have tested the ability of temporal characteristics to influence the spatial location of visual stimuli. Some types of EVP – electronic voice phenomenon, mainly the ones using sound bubbles are considered a kind of modern ventriloquism technique and is played by the use of sophisticated software, computers and sound equipment. Double-flash illusion The double flash illusion was reported as the first illusion to show that visual stimuli can be qualitatively altered by audio stimuli.[59] In the standard paradigm participants are presented combinations of one to four flashes accompanied by zero to 4 beeps. They were then asked to say how many flashes they perceived. Participants perceived illusory flashes when there were more beeps than flashes. fMRI studies have shown that there is crossmodal activation in early, low level visual areas, which was qualitatively similar to the perception of a real flash. This suggests that the illusion reflects subjective perception of the extra flash.[60] Further, studies suggest that timing of multisensory activation in unisensory cortexes is too fast to be mediated by a higher order integration suggesting feed forward or lateral connections.[61] One study has revealed the same effect but from vision to audition, as well as fission rather than fusion effects, although the level of the auditory stimulus was reduced to make it less salient for those illusions affecting audition.[62] Rubber hand illusion See also: Body transfer illusion § Rubber hand illusion In the rubber hand illusion (RHI),[63] human participants view a dummy hand being stroked with a paintbrush, while they feel a series of identical brushstrokes applied to their own hand, which is hidden from view. If this visual and tactile information is applied synchronously, and if the visual appearance and position of the dummy hand is similar to one's own hand, then people may feel that the touches on their own hand are coming from the dummy hand, and even that the dummy hand is, in some way, their own hand.[63] This is an early form of body transfer illusion. The RHI is an illusion of vision, touch, and posture (proprioception), but a similar illusion can also be induced with touch and proprioception.[64] It has also been found that the illusion may not require tactile stimulation at all, but can be completely induced using mere vision of the rubber hand being in a congruent posture with the hidden real hand.[65] The first report of this kind of illusion may have been as early as 1937 (Tastevin, 1937).[66][67][68] Body transfer illusion Body transfer illusion typically involves the use of virtual reality devices to induce the illusion in the subject that the body of another person or being is the subject's own body. |

原理 バリー・スタイン、アレックス・メレディス、そして彼らの同僚たち(1993年の「感覚の統合」[44]など)の貢献は、現代の多感覚統合分野における画 期的な研究であると広く考えられている。上丘の神経生理学の長期にわたる詳細な研究を通じて、彼らは多感覚統合を最もよく説明できる3つの一般原則を抽出 した。 空間的法則[45][46]は、構成する単感覚刺激がほぼ同じ位置から生じる場合、多感覚統合がより起こりやすい、またはより強くなると述べている。 時間的法則[46][47]は、構成する単感覚刺激がほぼ同じ時間に生じるとき、多感覚統合がより起こりやすい、あるいはより強くなるとするものである。 逆有効性の原理[48][49]は、構成する単感覚刺激が単独で提示されたときに比較的弱い反応を喚起する場合に、多感覚統合がより起こりやすいか強くなるとする。 知覚と行動の結果 今世紀の初めまでは、単峰性のアプローチが科学文献を支配していた。そのため、神経マッピングは急速に進歩し、神経構造の理解は深まったが、知覚の研究は 一部の例外を除いて比較的停滞したままであった。最近になって知覚研究への熱が再燃しているのは、還元主義からゲシュタルト的方法論への実質的なシフトを 示している。19世紀末から20世紀初頭にかけて支配的だったゲシュタルト理論は、2つの一般原則を信奉していた。すなわち、意識経験を大局的に考えなけ ればならないという「全体性の原則」と、知覚現象は大脳活動と相関しているという「心理物理学的同型性の原則」である。ちょうどこれらの考え方は、ジュス ト・ゴンザロによって脳のダイナミクスの研究ですでに応用されており、「心理物理学的同型性による感覚野の発達」(参考文献[19]の英訳の23ページ) という定式化の中で、感覚と大脳の対応関係が考察されている。全体性の原理」と「心理物理学的同型性」の両方の考え方は、現在の情勢において特に適切であ り、研究者を多感覚統合の行動上の利点の調査に駆り立てている。 感覚の不確実性を減少させる 感覚領域の不確実性が多感覚統合の依存性を高めることは広く認められている[26]。したがって、時間的・空間的に同期している複数のモダリティからの手 がかりは、神経的にも知覚的にも同じソースから発せられたものとみなされる。この「結合」が起こるために必要な同期の程度は、現在さまざまなアプローチで 研究されている[50]。統合機能は、被験者がそれらを2つの対立する刺激として区別できる点を超えて初めて起こる。同時に、これまでの研究から重要な中 間的結論が導き出される。単一の知覚に結合された多感覚刺激は、SCと大脳皮質の多感覚ニューロンの同じ受容野にも結合される[26]。 反応時間の短縮 複数の同時感覚刺激に対する反応は、単独で提示された同じ刺激に対する反応よりも速くなることがある。Hershenson (1962)は、光と音を同時かつ別々に提示し、ヒトの被験者にそれらにできるだけ速く反応するよう求めた。両刺激のオンセット間の非同期性を変化させた ところ、ある 程度の非同期性では反応時間が減少することが観察された。ゴンザロ[18]によって研究された頭頂-後頭葉皮 質に病変のある患者において、感覚間促進による所与の 刺激に対する反応時間の短縮は非常に顕著であることが示され た。 冗長標的効果 冗長標的効果とは、二重標的(同時に提示された2つの標的)に対する反応が、どちらか一方の標的を単独で提示した場合よりも速いという観察である。この待ち時間の差は冗長性利得(RG)と呼ばれる[54]。 Forster, Cavina-Pratesi, Aglioti, and Berlucchi (2001)による研究では、正常な観察者は、単一の視覚刺激や触覚刺激よりも、視覚刺激と触覚刺激の同時提示に速く反応した。視覚と触覚の同時刺激に対 するRTは、視覚と触覚の同時刺激に対するRTよりも速かった。視覚刺激と触覚刺激の組み合わせに対するRTが、他の種類の刺激に対するRTよりも優れて いるのは、確率和よりもむしろ感覚間神経促進によって説明できる。これらの効果は、身体部位の柔軟な多感覚的表象を含む神経中枢に触覚入力と視覚入力が収 束することに起因する[55]。 多感覚的錯覚 マクガーク効果 収束する2つの二峰性刺激が、その部分の和とは大きさが異なるだけでなく、質もまったく異なる知覚を生じさせることがあることが発見されている。 McGurk効果と呼ばれる古典的な研究[56]では、ある人物の音素生成に、その人物が別の音素を話しているビデオをダビングした[57]。その結果、 第3の別の音素が知覚された。McGurkとMacDonald (1976)は、ba、da、ka、ta、ga、paのような音素は、視覚的に混同できるもの、すなわち(da、ga、ka、ta)と(baとpa)、そ して聴覚的に混同できるものの4つのグループに分けることができると説明している。したがって、「バ」の声と「ガ」の唇が一緒に処理されると、視覚野には 「ガ」または「ダ」が見え、聴覚野には「バ」または「ダ」が聞こえ、それらが組み合わさって「ダ」という知覚が形成される[56]。 腹話術 腹話術は、モダリティ適切性仮説の証拠として用いられてきた。腹話術効果とは、聴覚的な位置認知が視覚的な手がかりの方にシフトする状況をいう。この現象 を説明した最初の研究はHowardとTempleton(1966)によって行われ、その後、いくつかの研究が彼らの到達した結論を再現し、発展させて きた[58]。視覚的手がかりが曖昧でない条件では、視覚的捕捉は確実に起こる。したがって、知覚位置に対する音の影響を検証するためには、視覚刺激を徐 々に低下させる必要がある[26]。さらに、聴覚刺激は時間的変化に敏感であることから、最近の研究では、視覚刺激の空間的位置に影響を与える時間的特性 の能力が検証されている。EVP(電子音声現象)のなかには、主にサウンドバブルを使ったものがあるが、これは現代の腹話術の一種と考えられており、高度 なソフトウェア、コンピュータ、音響機器を使って演じられる。 ダブルフラッシュ錯視 ダブルフラッシュ錯視は、視覚刺激が音声刺激によって質的に変化することを示した最初の錯視として報告された[59]。標準的なパラダイムでは、0から4 回のビープ音を伴った1回から4回のフラッシュの組合せが被験者に提示される。そして、知覚した閃光の数を言うよう求められた。fMRIの研究によると、 初期の低レベルの視覚野にクロスモーダルな活性化が見られ、これは本物の閃光の知覚と質的に類似していた。このことは、この錯視が余分な閃光の主観的知覚 を反映していることを示唆している[60]。さらに、単感覚皮質における多感覚活性化のタイミングは、フィードフォワードや側方結合を示唆する高次の統合 によって媒介されるには速すぎることが研究によって示唆されている[61]。ある研究では、聴覚に影響を及ぼす錯視では、聴覚刺激のレベルを低下させて顕 著性を低下させたが、視覚から聴覚へも同じ効果があり、融合効果ではなく分裂効果があることが明らかにされている[62]。 ゴム手錯視 参照 身体移動錯視§ ゴム手錯視 ラバーハンド錯視(rubber hand illusion: RHI)[63]では、被験者は絵筆で撫でられるダミーの手を見ながら、隠れている自分の手に同じ筆跡が描かれているのを感じる。この視覚情報と触覚情報 が同期して適用され、ダミーの手の視覚的外観と位置が自分の手に似ていれば、人は自分の手に触れているのがダミーの手から来ていると感じ、ダミーの手があ る意味で自分の手であるとさえ感じるかもしれない。 RHIは視覚、触覚、姿勢(プロプリオセプション)の錯視であるが、触覚とプロプリオセプションでも同様の錯視を誘発することができる[64]。また、触 覚刺激を全く必要とせず、ゴムの手が隠れた本物の手と一致した姿勢をしているという視覚だけで完全に錯視を誘発できる場合もあることがわかっている [65]。 この種の錯視の最初の報告は1937年(Tastevin, 1937)であったかもしれない[66][67][68]。 身体移動錯視 身体移乗錯視は、典型的には、仮想現実装置を用いて、他人の身体が自分の身体であると被験者に錯覚させるものである。 |

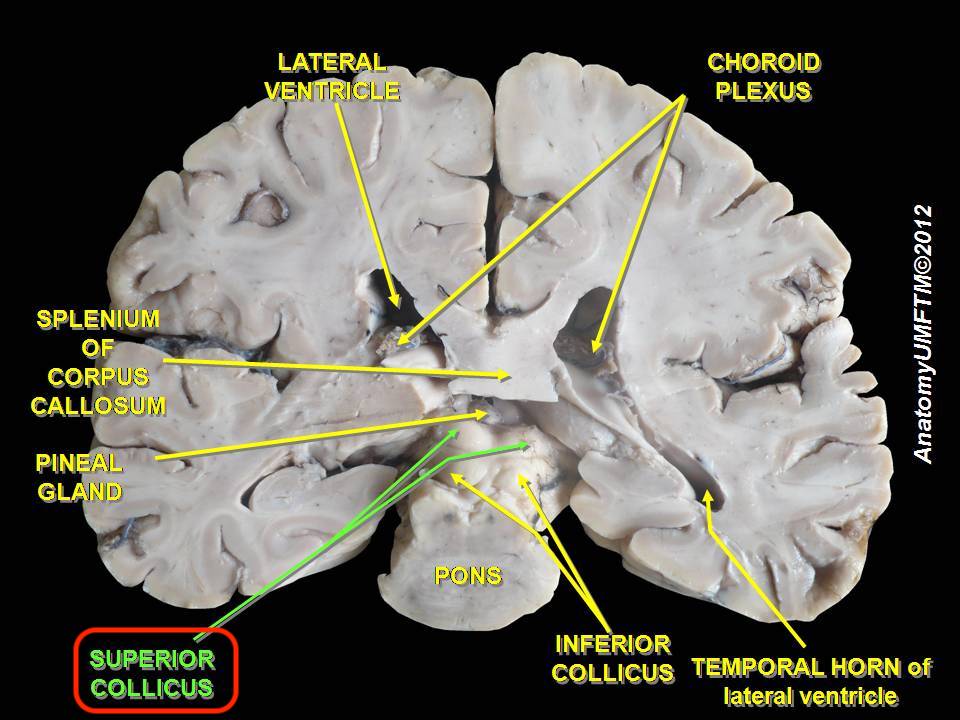

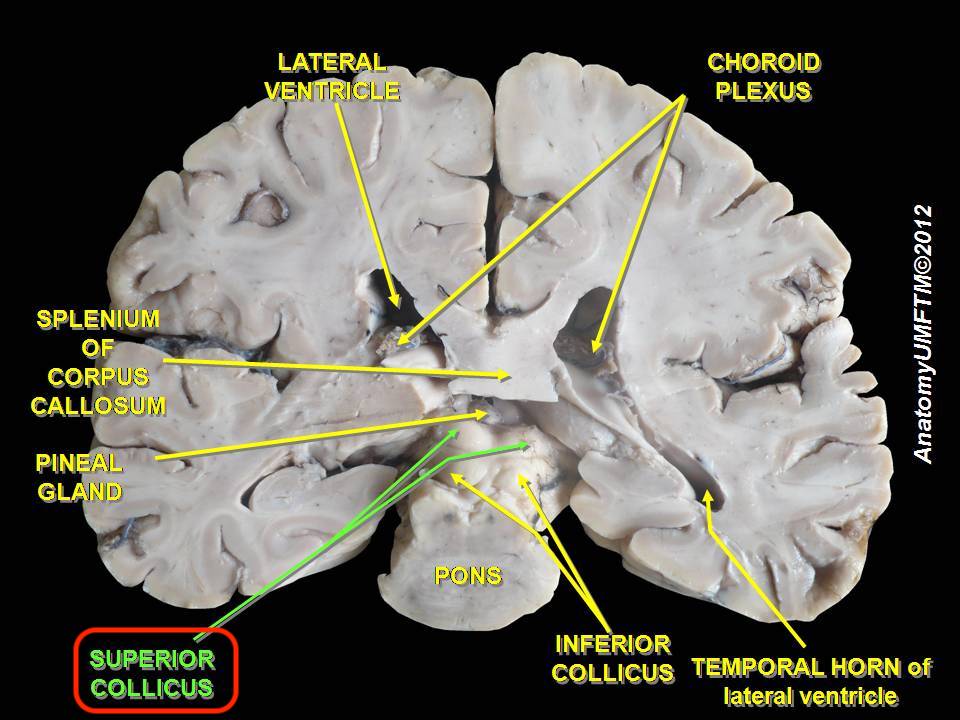

| Neural mechanisms Subcortical areas Superior colliculus  Superior colliculus The superior colliculus (SC) or optic tectum (OT) is part of the tectum, located in the midbrain, superior to the brainstem and inferior to the thalamus. It contains seven layers of alternating white and grey matter, of which the superficial contain topographic maps of the visual field; and deeper layers contain overlapping spatial maps of the visual, auditory and somatosensory modalities.[69] The structure receives afferents directly from the retina, as well as from various regions of the cortex (primarily the occipital lobe), the spinal cord and the inferior colliculus. It sends efferents to the spinal cord, cerebellum, thalamus and occipital lobe via the lateral geniculate nucleus (LGN). The structure contains a high proportion of multisensory neurons and plays a role in the motor control of orientation behaviours of the eyes, ears and head.[53] Receptive fields from somatosensory, visual and auditory modalities converge in the deeper layers to form a two-dimensional multisensory map of the external world. Here, objects straight ahead are represented caudally and objects on the periphery are represented rosterally. Similarly, locations in superior sensory space are represented medially, and inferior locations are represented laterally.[44] However, in contrast to simple convergence, the SC integrates information to create an output that differs from the sum of its inputs. Following a phenomenon labelled the 'spatial rule', neurons are excited if stimuli from multiple modalities fall on the same or adjacent receptive fields, but are inhibited if the stimuli fall on disparate fields.[70] Excited neurons may then proceed to innervate various muscles and neural structures to orient an individual's behaviour and attention toward the stimulus. Neurons in the SC also adhere to the 'temporal rule', in which stimulation must occur within close temporal proximity to excite neurons. However, due to the varying processing time between modalities and the relatively slower speed of sound to light, it has been found the neurons may be optimally excited when stimulated some time apart.[71] Putamen Single neurons in the macaque putamen have been shown to have visual and somatosensory responses closely related to those in the polysensory zone of the premotor cortex and area 7b in the parietal lobe.[72][73] Cortical areas Multisensory neurons exist in a large number of locations, often integrated with unimodal neurons. They have recently been discovered in areas previously thought to be modality specific, such as the somatosensory cortex; as well as in clusters at the borders between the major cerebral lobes, such as the occipito-parietal space and the occipito-temporal space.[74][53][75] However, in order to undergo such physiological changes, there must exist continuous connectivity between these multisensory structures. It is generally agreed that information flow within the cortex follows a hierarchical configuration.[76] Hubel and Wiesel showed that receptive fields and thus the function of cortical structures, as one proceeds out from V1 along the visual pathways, become increasingly complex and specialized.[76] From this it was postulated that information flowed outwards in a feed-forward fashion; the complex end products eventually binding to form a percept. However, via fMRI and intracranial recording technologies, it has been observed that the activation time of successive levels of the hierarchy does not correlate with a feed-forward structure. That is, late activation has been observed in the striate cortex, markedly after activation of the prefrontal cortex in response to the same stimulus.[77] Complementing this, afferent nerve fibres have been found that project to early visual areas such as the lingual gyrus from late in the dorsal (action) and ventral (perception) visual streams, as well as from the auditory association cortex.[78] Feedback projections have also been observed in the opossum directly from the auditory association cortex to V1.[76] This last observation currently highlights a point of controversy within the neuroscientific community. Sadato et al. (2004) concluded, in line with Bernstein et al. (2002), that the primary auditory cortex (A1) was functionally distinct from the auditory association cortex, in that it was void of any interaction with the visual modality. They hence concluded that A1 would not at all be effected by cross modal plasticity.[79][80] This concurs with Jones and Powell's (1970) contention that primary sensory areas are connected only to other areas of the same modality.[81] In contrast, the dorsal auditory pathway, projecting from the temporal lobe is largely concerned with processing spatial information, and contains receptive fields that are topographically organized. Fibers from this region project directly to neurons governing corresponding receptive fields in V1.[76] The perceptual consequences of this have not yet been empirically acknowledged. However, it can be hypothesized that these projections may be the precursors of increased acuity and emphasis of visual stimuli in relevant areas of perceptual space. Consequently, this finding rejects Jones and Powell's (1970) hypothesis[81] and thus is in conflict with Sadato et al.'s (2004) findings.[79] A resolution to this discrepancy includes the possibility that primary sensory areas can not be classified as a single group, and thus may be far more different from what was previously thought. The multisensory syndrome with symmetric bilaterality, characterized by Gonzalo and called by this author 'central syndrome of the cortex',[18][19] was originated from a unilateral parieto-occipital cortical lesion equidistant from the visual, tactile, and auditory projection areas (the middle of area 19, the anterior part of area 18 and the most posterior of area 39, in Brodmann terminology) that was called 'central zone'. The gradation observed between syndromes led this author to propose a functional gradient scheme in which the specificity of the cortex is distributed with a continuous variation,[19] the overlap of the specific gradients would be high or maximum in that 'central zone'. Frontal lobe This section provides insufficient context for those unfamiliar with the subject. Please help improve the article by providing more context for the reader. (July 2013) (Learn how and when to remove this message) Area F4 in macaques Area F5 in macaques[82][83] Polysensory zone of premotor cortex (PZ) in macaques[84] Occipital lobe This section provides insufficient context for those unfamiliar with the subject. Please help improve the article by providing more context for the reader. (July 2013) (Learn how and when to remove this message) Primary visual cortex (V1)[85] Lingual gyrus in humans Lateral occipital complex (LOC), including lateral occipital tactile visual area (LOtv)[86] Parietal lobe This section provides insufficient context for those unfamiliar with the subject. Please help improve the article by providing more context for the reader. (July 2013) (Learn how and when to remove this message) Ventral intraparietal sulcus (VIP) in macaques[82] Lateral intraparietal sulcus (LIP) in macaques[82] Area 7b in macaques[87] Second somatosensory cortex (SII)[88] Temporal lobe This section provides insufficient context for those unfamiliar with the subject. Please help improve the article by providing more context for the reader. (July 2013) (Learn how and when to remove this message) Primary auditory cortex (A1) Superior temporal cortex (STG/STS/PT) Audio visual cross modal interactions are known to occur in the auditory association cortex which lies directly inferior to the Sylvian fissure in the temporal lobe.[79] Plasticity was observed in the superior temporal gyrus (STG) by Petitto et al. (2000).[89] Here, it was found that the STG was more active during stimulation in native deaf signers compared to hearing non signers. Concurrently, further research has revealed differences in the activation of the Planum temporale (PT) in response to non linguistic lip movements between the hearing and deaf; as well as progressively increasing activation of the auditory association cortex as previously deaf participants gain hearing experience via a cochlear implant.[79] Anterior ectosylvian sulus (AES) in cats[90][91][92] Rostral lateral suprasylvian sulcus (rLS) in cats[91] Cortical-subcortical interactions The most significant interaction between these two systems (corticotectal interactions) is the connection between the anterior ectosylvian sulcus (AES), which lies at the junction of the parietal, temporal and frontal lobes, and the SC. The AES is divided into three unimodal regions with multisensory neurons at the junctions between these sections.[93] (Jiang & Stein, 2003). Neurons from the unimodal regions project to the deep layers of the SC and influence the multiplicative integration effect. That is, although they can receive inputs from all modalities as normal, the SC can not enhance or depress the effect of multisensory stimulation without input from the AES.[93] Concurrently, the multisensory neurons of the AES, although also integrally connected to unimodal AES neurons, are not directly connected to the SC. This pattern of division is reflected in other areas of the cortex, resulting in the observation that cortical and tectal multisensory systems are somewhat dissociated.[94] Stein, London, Wilkinson and Price (1996) analysed the perceived luminance of an LED in the context of spatially disparate auditory distracters of various types. A significant finding was that a sound increased the perceived brightness of the light, regardless of their relative spatial locations, provided the light's image was projected onto the fovea.[95] Here, the apparent lack of the spatial rule, further differentiates cortical and tectal multisensory neurons. Little empirical evidence exists to justify this dichotomy. Nevertheless, cortical neurons governing perception, and a separate sub cortical system governing action (orientation behavior) is synonymous with the perception action hypothesis of the visual stream.[96] Further investigation into this field is necessary before any substantial claims can be made. Dual "what" and "where" multisensory routes Research suggests the existence of two multisensory routes for "what" and "where". The "what" route identifying the identity of things involving area Brodmann area 9 in the right inferior frontal gyrus and right middle frontal gyrus, Brodmann area 13 and Brodmann area 45 in the right insula-inferior frontal gyrus area, and Brodmann area 13 bilaterally in the insula. The "where" route detecting their spatial attributes involving the Brodmann area 40 in the right and left inferior parietal lobule and the Brodmann area 7 in the right precuneus-superior parietal lobule and Brodmann area 7 in the left superior parietal lobule.[97] |

神経メカニズム 皮質下領域 上丘  上丘 上丘(SC)または視蓋(OT)は視蓋の一部で、中脳の脳幹より上、視床より下に位置する。白質と灰白質が交互に7層になっており、表層には視覚野の地形 図があり、深層には視覚、聴覚、体性感覚モダリティの重複した空間地図がある[69]。この構造は、網膜から直接求心性神経を受け取るとともに、大脳皮質 (主に後頭葉)、脊髄、下丘の様々な領域から求心性神経を受け取る。外側被蓋核(LGN)を介して脊髄、小脳、視床、後頭葉に求心性神経を送る。この構造 には、多感覚ニューロンの割合が高く、目、耳、頭の方向行動の運動制御に役割を果たしている[53]。 体性感覚、視覚、聴覚モダリティからの受容野が深層で収束し、外界の2次元多感覚マップを形成する。ここで、直進する物体は尾側に、周縁にある物体はロスター側に表象される。同様に、上方の感覚空間の位置は内側に、下方の位置は外側に表現される[44]。 しかし、単純な収束とは対照的に、SCは情報を統合して、入力の和とは異なる出力を生成する。空間的ルール」と呼ばれる現象に従うと、ニュー ロンは複数のモダリティからの刺激が同一または隣接する受容野に 入ると興奮するが、刺激が異なる受容野に入ると抑制さ れる。SCの神経細胞もまた「時間的規則」に従っており、神経細胞を興奮させるためには、刺激が時間的に近接して起こらなければならない。しかし、モダリ ティ間の処理時間が様々であることと、音と光の速度が比較的遅いことから、ニューロンは少し時間を隔てて刺激されると最適に興奮することがわかっている [71]。 プタメン マカクルの被蓋野の単一ニューロンは、運動前野の多感覚領域および頭頂葉の7b野のものと密接に関連する視覚および体性感覚応答を有することが示されている[72][73]。 皮質領域 多感覚ニューロンは多くの場所に存在し、しばしば単峰性ニューロンと統合されている。最近では、体性感覚皮質のような、以前はモダリティに特有であると考 えられていた領域や、後頭-頭頂間隙や後頭-側頭間隙のような大脳葉の境界にあるクラスターで発見されている[74][53][75]。 しかし、このような生理学的変化を起こすためには、これらの多感覚構造の間に連続的な結合が存在しなければならない。HubelとWieselは、視覚経 路に沿ってV1から外側に進むにつれて、受容野、ひいては皮質構造の機能が複雑化し、専門化することを示した。しかし、fMRIや頭蓋内記録技術により、 階層構造の連続するレベルの活性化時間はフィードフォワード構造と相関しないことが観察されている。つまり、同じ刺激に反応して前頭前野が活性化した後 に、線状皮質が著しく活性化することが観察されている[77]。 これを補完するように、背側視覚野(行動)および腹側視覚野(知覚)の後期視覚野、ならびに聴覚連合皮質から、舌回などの初期視覚野に投射する求心性神経 線維が発見されている[78]。オポッサムでは、聴覚連合皮質からV1への直接のフィードバック投射も観察されている[76]。Sadatoら (2004)は、Bernsteinら(2002)と同様に、一次聴覚皮質(A1)は視覚モダリティとの相互作用がないという点で、聴覚連合皮質とは機能 的に異なると結論づけた。このことは、一次感覚野は同じモダリティの他の領域と のみ接続しているというジョーンズとパウエル(Jones and Powell, 1970)の主張と一致する[81]。 対照的に、側頭葉から投射される背側聴覚経路は、主に空間情報の処理に関係し、位相幾何学的に組織化された受容野を含む。この領域からの線維は、V1の対 応する受容野を支配するニュー ロンに直接投射される。しかし、これらの投射は、知覚空間の関連領域における視覚刺激の鋭敏性と強調性の増大の前駆体であるかもしれないという仮説は立て られる。その結果、この所見はJonesとPowellの仮説[81]を否定することになり、Sadatoら(2004)の所見と矛盾することになる [79]。この矛盾を解決するには、一次感覚野は単一のグループとして分類することはできず、したがって以前考えられていたものとははるかに異なる可能性 がある。 Gonzaloによって特徴づけられ、筆者によって「大脳皮質の中心症候群」と呼ばれる対称的な両側性をもつ多感覚症候群[18][19]は、視覚、触 覚、聴覚の投射野(Brodmannの用語では、第19野の中央部、第18野の前方部、第39野の最も後方部)から等距離にある片側の頭頂-後頭葉皮質病 変に由来しており、「中心域」と呼ばれていた。症候群間で観察される勾配から、著者は、皮質の特異性が連続的な変化を伴って分布する機能勾配スキームを提 案した[19]。 前頭葉 このセクションは、このテーマに馴染みのない人には十分な文脈を提供していない。読者により多くの文脈を提供することで、記事の改善にご協力いただきたい。(2013年7月)(このメッセージを削除する方法とタイミングを学ぶ) マカクのF4領域 マカクのF5領域[82][83]。 マカクでは運動前野の多感覚野(PZ)[84]。 後頭葉 このセクションは、このテーマに馴染みのない人々には十分な文脈を提供していない。読者により多くの文脈を提供することで、記事の改善にご協力いただきたい。(2013年7月)(このメッセージを削除する方法とタイミングを学ぶ) 一次視覚野(V1)[85]。 ヒトでは舌回 外側後頭複合体(LOC)、外側後頭触覚視覚野(LOtv)を含む[86]。 頭頂葉 このセクションは、このテーマに馴染みのない人々には十分な文脈を提供していない。読者により多くの文脈を提供することで、記事の改善にご協力いただきたい。(2013年7月) (このメッセージを削除する方法とタイミングを学ぶ) マカクの腹側頭頂間溝(VIP)[82] マカクの側頭頂溝(LIP)[82] マカクの7b領域[87]。 第二体性感覚皮質(SII)[88]。 側頭葉 このセクションは、このテーマに馴染みのない人々には十分な文脈を提供していない。読者により多くの文脈を提供することで、記事の改善にご協力いただきたい。(2013年7月) (このメッセージを削除する方法とタイミングを学ぶ) 一次聴覚野(A1) 上側頭回(STG/STS/PT) 音声視覚のクロスモーダル相互作用は、側頭葉のシルビウス裂の直下にある聴覚連合皮質で起こることが知られている[79]。可塑性はPetittoら (2000)[89]によって上側頭回(STG)で観察された。同時に、さらなる研究により、言語的でない唇の動きに対する側頭葉(PT)の活性化が、聴 覚障害者と聴覚障害者で異なること、また、聴覚障害者であった参加者が人工内耳によって聴覚経験を積むにつれて、聴覚連合皮質の活性化が徐々に増加するこ とが明らかになった[79]。 猫の前部外シルビウス(AES)[90][91][92]。 猫の吻側外側上シルビウス溝(rLS)[91]。 皮質-皮質下相互作用 これら2つのシステム間の最も重要な相互作用(皮質-皮質間相互作用)は、頭頂葉、側頭葉、前頭葉の接合部にある前部外シルビウス溝(AES)とSCの接 続である。AESは3つの単峰性領域に分けられ、これらの領域の接合部には多感覚ニューロンがある[93](Jiang & Stein, 2003)。単峰性領域からのニューロンはSCの深層に投射され、多峰性統合効 果に影響を与える。つまり、SCは通常通りすべてのモダリティからの入力を受け取ることができるが、AESからの入力なしに多感覚刺激の効果を増強したり 抑制したりすることはできない[93]。 同時に、AESの多感覚ニューロンは、単一モダリティのAESニューロンにも統合的に接続されているが、SCには直接接続されていない。この分割パターン は大脳皮質の他の領域にも反映され、その結果、 皮質と視蓋の多感覚系はいくらか解離しているという観察が得ら れる。重要な発見は、光の像が窩に投影されていれば、相対的な 空間的位置に関係なく、音が光の知覚輝度を増加させるというこ とであった[95]。ここでは、空間的ルールの明らかな欠如が、皮質と視 線の多感覚ニューロンをさらに区別している。この二分法を正当化する経験的証拠はほとんど存在しない。とはいえ、知覚を司る皮質ニューロンと、行動(方位 行動)を司る別個の皮 質下システムは、視覚的ストリームの知覚行動仮説と同義である[96]。 何を」と「どこで」の二重の多感覚経路 研究は、「何」と「どこ」に対する2つの多感覚的経路の存在を示唆している。何が」ルートは、右下前頭回と右中前頭回にあるブロードマン第9野、右島-下 前頭回にあるブロードマン第13野とブロードマン第45野、島皮質にある両側のブロードマン第13野が関与し、物事の同一性を識別する。右と左の下頭頂小 葉にあるブロドマン野40と、右の楔前部-上頭頂小葉にあるブロドマン野7と左の上頭頂小葉にあるブロドマン野7が関与する、それらの空間的属性を検出す る 「where 」ルートである[97]。 |

| Development of multisensory operations Theories of development All species equipped with multiple sensory systems, utilize them in an integrative manner to achieve action and perception.[44] However, in most species, especially higher mammals and humans, the ability to integrate develops in parallel with physical and cognitive maturity. Children until certain ages do not show mature integration patterns.[98][99] Classically, two opposing views that are principally modern manifestations of the nativist/empiricist dichotomy have been put forth. The integration (empiricist) view states that at birth, sensory modalities are not at all connected. Hence, it is only through active exploration that plastic changes can occur in the nervous system to initiate holistic perceptions and actions. Conversely, the differentiation (nativist) perspective asserts that the young nervous system is highly interconnected; and that during development, modalities are gradually differentiated as relevant connections are rehearsed and the irrelevant are discarded.[100] Using the SC as a model, the nature of this dichotomy can be analysed. In the newborn cat, deep layers of the SC contain only neurons responding to the somatosensory modality. Within a week, auditory neurons begin to occur, but it is not until two weeks after birth that the first multisensory neurons appear. Further changes continue, with the arrival of visual neurons after three weeks, until the SC has achieved its fully mature structure after three to four months. Concurrently in species of monkey, newborns are endowed with a significant complement of multisensory cells; however, along with cats there is no integration effect apparent until much later.[53] This delay is thought to be the result of the relatively slower development of cortical structures including the AES; which as stated above, is essential for the existence of the integration effect.[93] Furthermore, it was found by Wallace (2004) that cats raised in a light deprived environment had severely underdeveloped visual receptive fields in deep layers of the SC.[53] Although, receptive field size has been shown to decrease with maturity, the above finding suggests that integration in the SC is a function of experience. Nevertheless, the existence of visual multisensory neurons, despite a complete lack of visual experience, highlights the apparent relevance of nativist viewpoints. Multisensory development in the cortex has been studied to a lesser extent, however a similar study to that presented above was performed on cats whose optic nerves had been severed. These cats displayed a marked improvement in their ability to localize stimuli through audition; and consequently also showed increased neural connectivity between V1 and the auditory cortex.[76] Such plasticity in early childhood allows for greater adaptability, and thus more normal development in other areas for those with a sensory deficit. In contrast, following the initial formative period, the SC does not appear to display any neural plasticity. Despite this, habituation and sensititisation over the long term is known to exist in orientation behaviors. This apparent plasticity in function has been attributed to the adaptability of the AES. That is, although neurons in the SC have a fixed magnitude of output per unit input, and essentially operate an all or nothing response, the level of neural firing can be more finely tuned by variations in input by the AES. Although there is evidence for either perspective of the integration/differentiation dichotomy, a significant body of evidence also exists for a combination of factors from either view. Thus, analogous to the broader nativist/empiricist argument, it is apparent that rather than a dichotomy, there exists a continuum, such that the integration and differentiation hypotheses are extremes at either end. Psychophysical development of integration Not much is known about the development of the ability to integrate multiple estimates such as vision and touch.[98] Some multisensory abilities are present from early infancy, but it is not until children are eight years or older before they use multiple modalities to reduce sensory uncertainty.[98] One study demonstrated that cross-modal visual and auditory integration is present from within 1 year of life.[101] This study measured response time for orientating towards a source. Infants who were 8–10 months old showed significantly decreased response times when the source was presented through both visual and auditory information compared to a single modality. Younger infants, however, showed no such change in response times to these different conditions. Indeed, the results of the study indicates that children potentially have the capacity to integrate sensory sources at any age. However, in certain cases, for example visual cues, intermodal integration is avoided.[98] Another study found that cross-modal integration of touch and vision for distinguishing size and orientation is available from at least 8 years of age.[99] For pre-integration age groups, one sense dominates depending on the characteristic discerned (see visual dominance).[99] A study investigating sensory integration within a single modality (vision) found that it cannot be established until age 12 and above.[98] This particular study assessed the integration of disparity and texture cues to resolve surface slant. Though younger age groups showed a somewhat better performance when combining disparity and texture cues compared to using only disparity or texture cues, this difference was not statistically significant.[98] In adults, the sensory integration can be mandatory, meaning that they no longer have access to the individual sensory sources.[102] Acknowledging these variations, many hypotheses have been established to reflect why these observations are task-dependent. Given that different senses develop at different rates, it has been proposed that cross-modal integration does not appear until both modalities have reached maturity.[99][103] The human body undergoes significant physical transformation throughout childhood. Not only is there growth in size and stature (affecting viewing height), but there is also change in inter-ocular distance and eyeball length. Therefore, sensory signals need to be constantly re-evaluated to appreciate these various physiological changes.[99] Some support comes from animal studies that explore the neurobiology behind integration. Adult monkeys have deep inter-neuronal connections within the superior colliculus providing strong, accelerated visuo-auditory integration.[104] Young animals conversely, do not have this enhancement until unimodal properties are fully developed.[105][106] Additionally, to rationalize sensory dominance, Gori et al. (2008) advocates that the brain utilises the most direct source of information during sensory immaturity.[99] In this case, orientation is primarily a visual characteristic. It can be derived directly from the object image that forms on the retina, irrespective of other visual factors. In fact, data shows that a functional property of neurons within primate visual cortices' are their discernment to orientation.[107] In contrast, haptic orientation judgements are recovered through collaborated patterned stimulations, evidently an indirect source susceptible to interference. Likewise, when size is concerned haptic information coming from positions of the fingers is more immediate. Visual-size perceptions, alternatively, have to be computed using parameters such as slant and distance. Considering this, sensory dominance is a useful instinct to assist with calibration. During sensory immaturity, the more simple and robust information source could be used to tweak the accuracy of the alternate source.[99] Follow-up work by Gori et al. (2012) showed that, at all ages, vision-size perceptions are near perfect when viewing objects within the haptic workspace (i.e. at arm's reach).[108] However, systematic errors in perception appeared when the object was positioned beyond this zone.[109] Children younger than 14 years tend to underestimate object size, whereas adults overestimated. However, if the object was returned to the haptic workspace, those visual biases disappeared.[108] These results support the hypothesis that haptic information may educate visual perceptions. If sources are used for cross-calibration they cannot, therefore, be combined (integrated). Maintaining access to individual estimates is a trade-off for extra plasticity over accuracy, which could be beneficial in retrospect to the developing body.[99][103] Alternatively, Ernst (2008) advocates that efficient integration initially relies upon establishing correspondence – which sensory signals belong together.[103] Indeed, studies have shown that visuo-haptic integration fails in adults when there is a perceived spatial separation, suggesting sensory information is coming from different targets.[110] Furthermore, if the separation can be explained, for example viewing an object through a mirror, integration is re-established and can even be optimal.[111][112] Ernst (2008) suggests that adults can obtain this knowledge from previous experiences to quickly determine which sensory sources depict the same target, but young children could be deficient in this area.[103] Once there is a sufficient bank of experiences, confidence to correctly integrate sensory signals can then be introduced in their behaviour. Lastly, Nardini et al. (2010) recently hypothesised that young children have optimized their sensory appreciation for speed over accuracy.[98] When information is presented in two forms, children may derive an estimate from the fastest available source, subsequently ignoring the alternate, even if it contains redundant information. Nardini et al. (2010) provides evidence that children's (aged 6 years) response latencies are significantly lower when stimuli are presented in multi-cue over single-cue conditions.[98] Conversely, adults showed no change between these conditions. Indeed, adults display mandatory fusion of signals, therefore they can only ever aim for maximum accuracy.[98][102] However, the overall mean latencies for children were not faster than adults, which suggests that speed optimization merely enable them to keep up with the mature pace. Considering the haste of real-world events, this strategy may prove necessary to counteract the general slower processing of children and maintain effective vision-action coupling.[113][114][115] Ultimately the developing sensory system may preferentially adapt for different goals – speed and detecting sensory conflicts – those typical of objective learning. The late development of efficient integration has also been investigated from computational point of view.[116] Daee et al. (2014) showed that having one dominant sensory source at early age, rather than integrating all sources, facilitates the overall development of cross-modal integrations. Applications Prosthesis Prosthetics designers should carefully consider the nature of dimensionality alteration of sensorimotor signaling from and to the CNS when designing prosthetic devices. As reported in literatures, neural signaling from the CNS to the motors is organized in a way that the dimensionalities of the signals are gradually increased as you approach the muscles, also called muscle synergies. In the same principal, but in opposite ordering, on the other hand, signals dimensionalities from the sensory receptors are gradually integrated, also called sensory synergies, as they approaches the CNS. This bow tie like signaling formation enables the CNS to process abstract yet valuable information only. Such as process will decrease complexity of the data, handle the noises and guarantee to the CNS the optimum energy consumption. Although the current commercially available prosthetic devices mainly focusing in implementing the motor side by simply uses EMG sensors to switch between different activation states of the prosthesis. Very limited works have proposed a system to involve by integrating the sensory side. The integration of tactile sense and proprioception is regarded as essential for implementing the ability to perceive environmental input.[117] Visual rehabilitation Multisensory integration has also been shown to ameliorate visual hemianopia. Through the repeated presentation of multisensory stimuli in the blind hemifield, the ability to respond to purely visual stimuli gradually returns to that hemifield in a central to peripheral manner. These benefits persist even after the explicit multisensory training ceases.[118] |

多感覚操作の発達 発達の理論 しかし、ほとんどの種、特に高等哺乳類とヒトでは、統合する能力は身体的・認知的成熟と並行して発達する。ある年齢までの子どもは成熟した統合パターンを 示さない[98][99]。古典的には、主に生得主義者と経験主義者の二分法の現代的な現れである2つの対立する見解が提唱されてきた。統合主義(経験主 義)の見解は、生まれつきの感覚モダリティはまったくつながっ ていないとする。したがって、積極的な探索によってのみ、神経系に可塑的な変化が起こり、全体的な知覚と行動が開始される。逆に、分化(生得主義)の観点 は、幼少期の神経系は高度に相互接続されており、発達の過程で、関連する接続が再確認され、無関係な接続が破棄されるにつれて、モダリティは徐々に分化し ていくと主張する[100]。 SCをモデルとして使用することで、この二分法の性質を分析する ことができる。新生ネコでは、SCの深層には体性感覚モダリティに反応するニュー ロンのみが存在する。週間以内に聴覚ニューロンが出現し始めるが、最初の多感覚ニューロンが出現するのは生後2週間後である。さらに変化は続き、3週間後 には視覚ニューロンが登場し、3~4ヵ月後にはSCが完全に成熟した構造を獲得する。同時にサルの種では、新生児はかなりの数の多感覚細胞を備えている。 しかし、ネコと同様に、統合効果が明らかになるのはずっと後になってからである[53]。この遅れは、上述のように統合効果の存在に不可欠なAESを含む 皮質構造の発達が比較的遅い結果であると考えられている[93]。 さらに、Wallace (2004)によって、光を遮断された環境で育ったネコは、SCの深層にある視覚受容野が著しく未発達であることが明らかにされた[53]。受容野の大き さは成熟とともに減少することが示されているが、上記の所見はSCにおける統合が経験の関数であることを示唆している。とはいえ、視覚経験がまったくない にもかかわらず視覚的多感覚ニューロンが存在することは、ネイティビズムの視点が明らかに妥当であることを浮き彫りにしている。大脳皮質における多感覚の 発達はあまり研究されていないが、視神経を切断したネコを対象に、上記と同様の研究が行われた。その結果、V1と聴覚皮質間の神経結合が増加した [76]。幼少期にこのような可塑性を示すことで、感覚に障害を持つ動物がより適応しやすくなり、他の領域もより正常に発達することが可能になる。 対照的に、初期の形成期を過ぎると、SCは神経可塑性を示さないようである。にもかかわらず、指向行動には長期にわたる慣れと感作が存在することが知られ ている。この明らかな機能の可塑性は、AESの適応性に起因している。つまり、SCのニューロンは単位入力あたりの出力の大きさが一定で、基本的にオー ル・オア・ナッシングの反応をするが、AESによる入力の変動によって、神経発火のレベルをより細かく調整することができる。 統合/分化の二項対立のどちらの観点からも証拠があるが、どちらの観点からの要因の組み合わせについても、かなりの証拠が存在する。したがって、より広範 なネイティビスト/エンピリシストの議論と類似しているが、二項対立ではなく、連続体が存在し、統合仮説と分化仮説は両極端であることが明らかである。 統合の心理物理学的発達 視覚や触覚などの複数の推定を統合する能力の発達につい ては、あまり知られていない[98]。いくつかの多感覚能力は乳幼児期 の早期から存在するが、感覚の不確実性を減らすために複数のモダリティ を使用するようになるのは8歳以上になってからである[98]。 ある研究では、クロスモーダルな視覚と聴覚の統合が生後1年以内から存在することが実証されている[101]。生後8ヵ月から10ヵ月の乳児は、視覚と聴 覚の両方から情報源が提示された場合、単一モダリティの場合と比較して、有意に反応時間が短縮された。しかし、生後8ヶ月から10ヶ月の乳児は、視覚情報 と聴覚情報の両方が提示された場合、単一モダリティで提示された場合と比較して、反応時間が有意に減少した。実際、この研究結果は、子どもは年齢に関係な く、感覚ソースを統合する能力を潜在的に持っていることを示している。しかし、例えば視覚的手がかりのような特定のケースでは、相互峰性統合は回避される [98]。 別の研究では、大きさと方向を識別するための触覚と視覚のクロスモーダルな統合は少なくとも8歳から可能であることがわかった[99]。 単一モダリティ(視覚)における感覚統合を調査した研究によると、12歳以上でないと統合が確立されないことが判明している[98]。より若い年齢層で は、視差とテクスチャの手がかりを 組み合わせることで、視差またはテクスチャの手がかりだ けを使用する場合よりもいくらか良好な結果が得られたが、 この差は統計的に有意ではなかった[98]。成人の場合、感覚統合は必須である可能性があ り、これは個々の感覚情報源にもはやアクセスできないことを意 味する[102]。 このような差異を認識した上で、なぜこれらの観察が課題依存的なのか を反映するために多くの仮説が立てられてきた。異なる感覚は異なる速度で発達することから、クロスモーダル統合は両方のモダリティが成熟するまで現れない と提唱されている[99][103]。体格や身長の成長(見る高さに影響する)だけでなく、眼間距離や眼球の長さも変化する。そのため、このような様々な 生理学的変化を理解するために、感覚信号は常に再評価される必要がある[99]。統合の背後にある神経生物学を探求する動物研究から、いくつかの裏付けが 得られている。成熟したサルは上丘内の深い神経細胞間結合を持ち、視覚と聴覚の統合を強力に加速している[104]が、若い動物では逆に、ユニモーダルな 特性が完全に発達するまで、このような強化は見られない[105][106]。 さらに、感覚優位を合理的に説明するために、Goriら(2008) は、感覚が未熟な間は脳が最も直接的な情報源を利用す ることを提唱している[99]。他の視覚的要因とは無関係に、網膜上に形成される物体像から直接導き出すことができる。実際、霊長類の視覚野にあるニュー ロンの機能的特性は、方位に対する識別力であることがデータによって示されている[107]。対照的に、触覚の方位判断は、明らかに干渉の影響を受けやす い間接的なソースである共同パターン刺激によって回復される。同様に、大きさに関する場合、指の位置から来る触覚情報はより即時的である。代わりに、視覚 による大きさの知覚は、傾きや距離などのパラメータを使って計算しなければならない。このことを考慮すると、感覚の優位性は、キャリブレーションを支援す る有用な本能である。感覚が未熟な間は、より単純で頑健な情報源は、代替情報源の精度を 調整するために使用される可能性がある[99]。Goriら(2012年)のフォローアップ研究によると、 どの年齢においても、視覚-サイズ知覚は、触覚ワークスペース 内(すなわち、腕の届く範囲)で対象物を見る場合にはほぼ完 全である[108]。これらの結果は、触覚情報が視覚的知覚を教育する可能性が あるという仮説を支持している[108]。相互較正のためにソースが使用される場合、それらは結合(統合)することができない。個々の推定値へのアクセス を維持することは、正確さよりも余分な可塑性とのトレードオフであり、これは発達中の身体にとって振り返ると有益である可能性がある[99][103]。 あるいは、Ernst (2008)は、効率的な統合は、どの感覚信号が一緒 にあるべきかという対応関係の確立に最初に依存すると提唱してい る[103]。実際、視覚と触覚の統合は、知覚された空間的な 分離がある場合、成人では失敗することが研究で示されてい る。 [エルンスト(Ernst)(2008)は、大人は過去の経験か らこの知識を得て、どの感覚源が同じ対象を描写してい るかを素早く判断できるが、幼児はこの領域が不十分であ る可能性を示唆している[103]。 最後に、Nardiniら(2010)は最近、幼児は正確さよりも速さに対 して感覚を最適化しているという仮説を立てた[98]。Nardiniら(2010)は、刺激がシングルキュー条件よりもマルチキュー条 件で提示された場合の方が、子ども(6歳)の反応待ち時間が有意に短 いという証拠を示している[98]。確かに、成人は信号の融合を必須とするため、最大限の精度を目指すことしかできない[98][102]。しかし、子ど もの全体的な平均待ち時間は大人よりも速くなかったことから、速度の最適化によって成熟したペースについていけるようになったに過ぎないことが示唆され る。実世界の出来事の急ぎ足を考慮すると、この戦略は、小児の一般的 に遅い処理を打ち消し、効果的な視覚と行動の結合を維持するた めに必要であることが証明されるかもしれない[113][114][115] 。最終的に、発達中の感覚系は、客観的学 習に典型的な目標とは異なる目標(速度と感覚の競合の検出) に優先的に適応する可能性がある。 効率的な統合の後期発達は計算論的な観点からも研究されている[116] Daeeら(2014)は、すべての感覚源を統合するのではなく、幼少期に1つの支配的な感覚源を持つことが、クロスモーダル統合の全体的な発達を促進することを示した。 応用 義肢 義肢装具の設計者は、義肢装具を設計する際に、中枢神経系からの、あるいは中枢神経系への感覚運動シグナリングの次元変化の性質を注意深く考慮すべきであ る。文献で報告されているように、中枢神経系から運動器への神経シグナリングは、筋シナジーとも呼ばれるように、筋に近づくにつれて信号の次元性が徐々に 高まるように組織化されている。同じ原理だが、順序は逆で、一方、感覚受容器からの信号の次元性は、CNSに近づくにつれて徐々に統合され、感覚シナジー とも呼ばれる。この蝶ネクタイのようなシグナル伝達の形成により、中枢神経系は抽象的だが価値のある情報のみを処理できるようになる。このような処理は、 データの複雑さを減らし、ノイズを処理し、CNSに最適なエネルギー消費を保証する。現在市販されている義肢装具は、義肢装具の異なる作動状態を切り替え るためにEMGセンサーを単純に使用することで、主に運動面を実装することに重点を置いている。感覚面を統合するシステムを提案した研究は非常に限られて いる。触覚と固有感覚を統合することは、環境入力を知覚する能力を実現するために不可欠であると考えられている。 視覚リハビリテーション 多感覚統合は、視覚半盲を改善することも示されている。盲半盲野に多感覚刺激を繰り返し提示することにより、純粋な視覚刺激に反応する能力が、その半盲野に中心から周辺へと徐々に戻ってくる。このような効果は、明示的な多感覚訓練を中止した後でも持続する[118]。 |

| Body transfer illusion Sensory processing disorder Synesthesia |

身体移動錯視 感覚処理障害 共感覚 |

| https://en.wikipedia.org/wiki/Multisensory_integration |

|

リ ンク

文 献

そ の他の情報

Copyleft, CC, Mitzub'ixi Quq Chi'j, 1996-2099

Philippe Mercier, The Sense of Taste, c.1744-47(部分)

☆

☆

☆