デジタル・テクノロジー

Digital technology

☆デ ジタルテクノロジーには2つの意味が考えられる。ひとつは、デジタル・エレクトロニクス(digital electronics)の応用のことである。そして、もうひとつは、情報技術(information technology)からくる知識のある意味をもった要素のことである。つまり、デジタルテクノジーについて知るには、デジタル・エレクトロニ クス(digital electronics)ならびに、情報技術(information technology)についての大まかな知識が不可欠である。

☆ つまり、デジタルテクノロジー(デジタル技術)とは、情報技術(インフォメーション テクノロジー)のある部分の成果の利用にもとづく「デジタル・エレクトロニクス」の応用のことである。

★デ ジタル・エレクトロニクス(digital electronics)

| Digital

electronics is a field of electronics involving the study of

digital signals and the engineering of devices that use or produce

them. It deals with the relationship between binary inputs and outputs

by passing electrical signals through logical gates, resistors,

capacitors, amplifiers, and other electrical components. The field of

digital electronics is in contrast to analog electronics which work

primarily with analog signals (signals with varying degrees of

intensity as opposed to on/off two state binary signals). Despite the

name, digital electronics designs include important analog design

considerations. Large assemblies of logic gates, used to represent more complex ideas, are often packaged into integrated circuits. Complex devices may have simple electronic representations of Boolean logic functions.[1] |

デジタル電子工学は、デジタル信号の研究およびそれらを使用または生成

するデバイスの工学を扱う電子工学の一分野です。この分野は、電気信号を論理ゲート、抵抗器、コンデンサ、アンプ、その他の電気部品を通過させることで、

二進入力と出力の関係を扱います。デジタル電子工学は、主にアナログ信号(強度が変化する信号で、オン/オフの二値信号とは対照的)を扱うアナログ電子工

学と対照的です。名称とは異なり、デジタル電子工学の設計には重要なアナログ設計の考慮事項が含まれる。 より複雑なアイデアを表現するために使用される大規模な論理ゲートアセンブリは、多くの場合、集積回路にパッケージ化される。複雑なデバイスは、ブール論 理関数の単純な電子的表現を持つことがある。[1] |

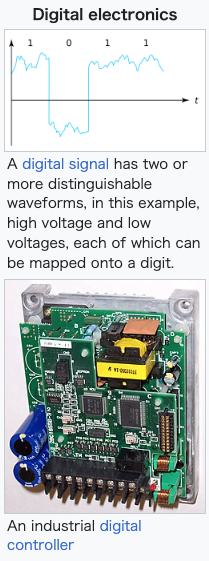

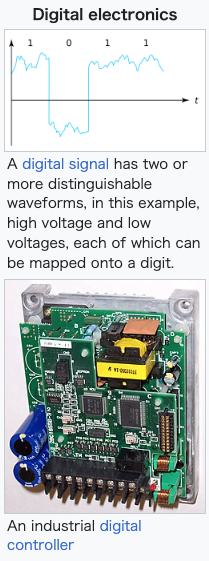

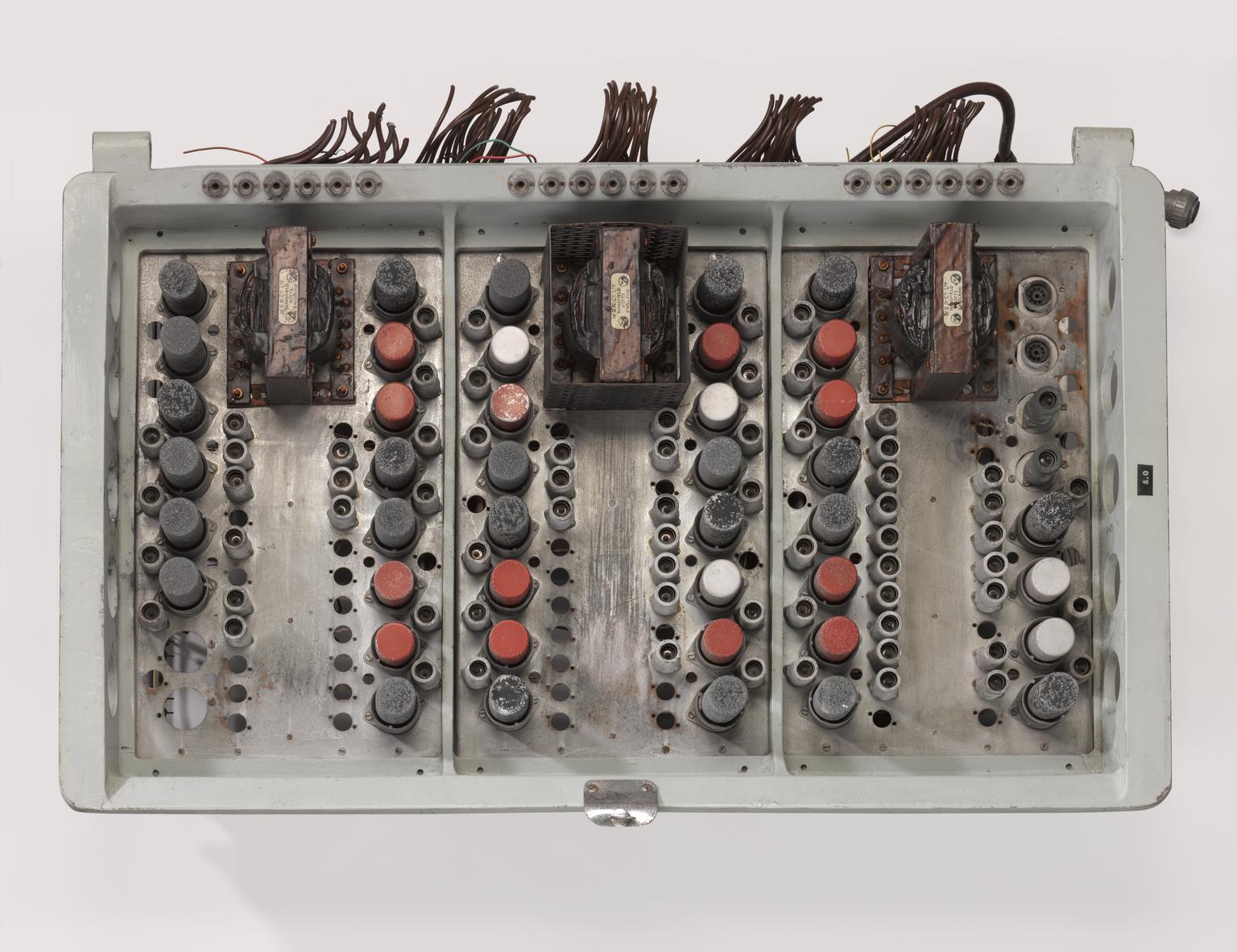

A digital signal has two or

more distinguishable waveforms, in this example, high voltage and low

voltages, each of which can be mapped onto a digit. A digital signal has two or

more distinguishable waveforms, in this example, high voltage and low

voltages, each of which can be mapped onto a digit.An industrial digital controller |

(上)デジタル信号には、2つ以上の区別可能な波形(この例

では高電圧と低電圧)があり、それぞれを1つの数字にマッピングすることができます。 (上)デジタル信号には、2つ以上の区別可能な波形(この例

では高電圧と低電圧)があり、それぞれを1つの数字にマッピングすることができます。(下)産業用デジタルコントローラ |

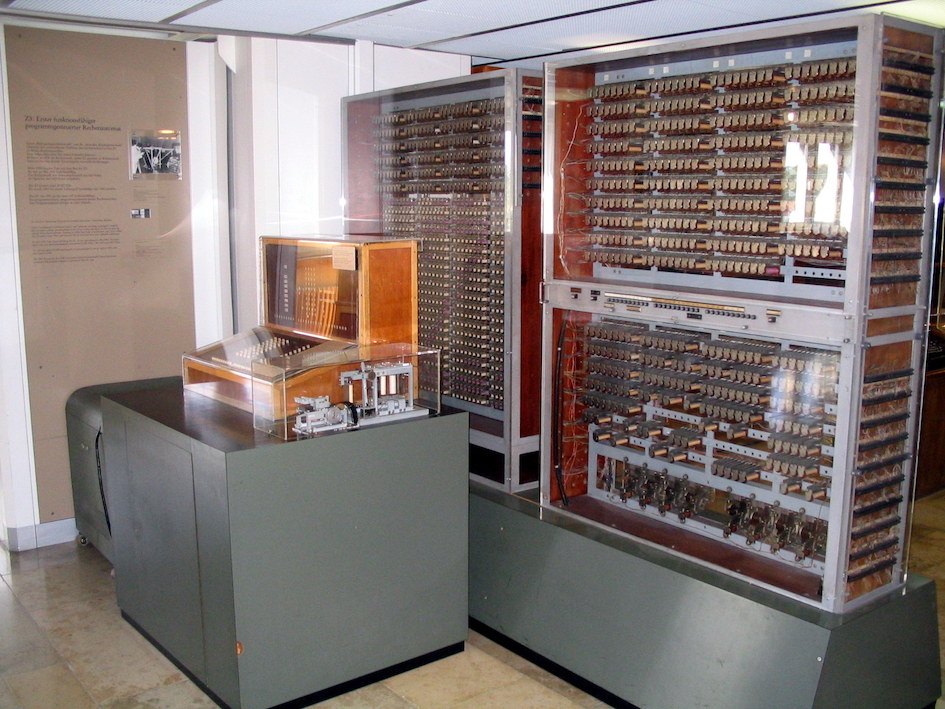

| History The binary number system was refined by Gottfried Wilhelm Leibniz (published in 1705) and he also established that by using the binary system, the principles of arithmetic and logic could be joined. Digital logic as we know it was the invention of George Boole in the mid-19th century. In an 1886 letter, Charles Sanders Peirce described how logical operations could be carried out by electrical switching circuits.[2] Eventually, vacuum tubes replaced relays for logic operations. Lee De Forest's modification of the Fleming valve in 1907 could be used as an AND gate. Ludwig Wittgenstein introduced a version of the 16-row truth table as proposition 5.101 of Tractatus Logico-Philosophicus (1921). Walther Bothe, inventor of the coincidence circuit, shared the 1954 Nobel Prize in physics, for creating the first modern electronic AND gate in 1924. Mechanical analog computers started appearing in the first century and were later used in the medieval era for astronomical calculations. In World War II, mechanical analog computers were used for specialized military applications such as calculating torpedo aiming. During this time the first electronic digital computers were developed, with the term digital being proposed by George Stibitz in 1942. Originally they were the size of a large room, consuming as much power as several hundred modern PCs.[3] Claude Shannon, demonstrating that electrical applications of Boolean algebra could construct any logical numerical relationship, ultimately laid the foundations of digital computing and digital circuits in his master's thesis of 1937, which is considered to be arguably the most important master's thesis ever written, winning the 1939 Alfred Noble Prize.[4][5] The Z3 was an electromechanical computer designed by Konrad Zuse. Finished in 1941, it was the world's first working programmable, fully automatic digital computer.[6] Its operation was facilitated by the invention of the vacuum tube in 1904 by John Ambrose Fleming. At the same time that digital calculation replaced analog, purely electronic circuit elements soon replaced their mechanical and electromechanical equivalents. John Bardeen and Walter Brattain invented the point-contact transistor at Bell Labs in 1947, followed by William Shockley inventing the bipolar junction transistor at Bell Labs in 1948.[7][8] At the University of Manchester, a team under the leadership of Tom Kilburn designed and built a machine using the newly developed transistors instead of vacuum tubes.[9] Their "transistorised computer", and the first in the world, was operational by 1953, and a second version was completed there in April 1955. From 1955 and onwards, transistors replaced vacuum tubes in computer designs, giving rise to the "second generation" of computers. Compared to vacuum tubes, transistors were smaller, more reliable, had indefinite lifespans, and required less power than vacuum tubes - thereby giving off less heat, and allowing much denser concentrations of circuits, up to tens of thousands in a relatively compact space.[citation needed] In 1955, Carl Frosch and Lincoln Derick discovered silicon dioxide surface passivation effects.[10] In 1957 Frosch and Derick, using masking and predeposition, were able to manufacture silicon dioxide field effect transistors; the first planar transistors, in which drain and source were adjacent at the same surface.[11] At Bell Labs, the importance of Frosch and Derick technique and transistors was immediately realized. Results of their work circulated around Bell Labs in the form of BTL memos before being published in 1957. At Shockley Semiconductor, Shockley had circulated the preprint of their article in December 1956 to all his senior staff, including Jean Hoerni,[12][13][14][15] who would later invent the planar process in 1959 while at Fairchild Semiconductor.[16][17] At Bell Labs, J.R. Ligenza and W.G. Spitzer studied the mechanism of thermally grown oxides, fabricated a high quality Si/SiO2 stack and published their results in 1960.[18][19][20] Following this research at Bell Labs, Mohamed Atalla and Dawon Kahng proposed a silicon MOS transistor in 1959[21] and successfully demonstrated a working MOS device with their Bell Labs team in 1960.[22][23] The team included E. E. LaBate and E. I. Povilonis who fabricated the device; M. O. Thurston, L. A. D’Asaro, and J. R. Ligenza who developed the diffusion processes, and H. K. Gummel and R. Lindner who characterized the device.[24][25] While working at Texas Instruments in July 1958, Jack Kilby recorded his initial ideas concerning the integrated circuit (IC), then successfully demonstrated the first working integrated circuit on 12 September 1958.[26] Kilby's chip was made of germanium. The following year, Robert Noyce at Fairchild Semiconductor invented the silicon integrated circuit. The basis for Noyce's silicon IC was Hoerni's planar process.[citation needed] The MOSFET's advantages include high scalability,[27] affordability,[28] low power consumption, and high transistor density.[29] Its rapid on–off electronic switching speed also makes it ideal for generating pulse trains,[30] the basis for electronic digital signals,[31][32] in contrast to BJTs which, more slowly, generate analog signals resembling sine waves.[30] Along with MOS large-scale integration (LSI), these factors make the MOSFET an important switching device for digital circuits.[33] The MOSFET revolutionized the electronics industry,[34][35] and is the most common semiconductor device.[36][37] In the early days of integrated circuits, each chip was limited to only a few transistors, and the low degree of integration meant the design process was relatively simple. Manufacturing yields were also quite low by today's standards. The wide adoption of the MOSFET transistor by the early 1970s led to the first large-scale integration (LSI) chips with more than 10,000 transistors on a single chip.[38] Following the wide adoption of CMOS, a type of MOSFET logic, by the 1980s, millions and then billions of MOSFETs could be placed on one chip as the technology progressed,[39] and good designs required thorough planning, giving rise to new design methods. The transistor count of devices and total production rose to unprecedented heights. The total amount of transistors produced until 2018 has been estimated to be 1.3×1022 (13 sextillion).[40] The wireless revolution (the introduction and proliferation of wireless networks) began in the 1990s and was enabled by the wide adoption of MOSFET-based RF power amplifiers (power MOSFET and LDMOS) and RF circuits (RF CMOS).[41][42][43] Wireless networks allowed for public digital transmission without the need for cables, leading to digital television, satellite and digital radio, GPS, wireless Internet and mobile phones through the 1990s–2000s.[citation needed] |

歴史 2進数は、ゴットフリート・ヴィルヘルム・ライプニッツによって改良され(1705年に発表)、彼はまた、2進数を使用することで、算術と論理の原理を統 合できることを確立した。私たちが知っているデジタル論理は、19 世紀半ばにジョージ・ブールによって発明された。1886 年の手紙の中で、チャールズ・サンダース・パースは、電気スイッチング回路によって論理演算を実行する方法を説明した。[2] 結局、論理演算にはリレーの代わりに真空管が採用されるようになった。1907 年にリー・デ・フォレストがフレミングの真空管を改良したものは、AND ゲートとして使用できた。ルートヴィヒ・ウィトゲンシュタインは、『論理哲学論考』(1921年)の命題 5.101 で、16 行の真理値表のバージョンを紹介した。偶然回路の発明者であるヴァルター・ボテは、1924 年に最初の近代的な電子 AND ゲートを開発し、1954 年にノーベル物理学賞を受賞した。 機械式アナログコンピュータは1世紀に初めて登場し、中世には天文学的な計算に用いられた。第二次世界大戦中、機械式アナログコンピュータは魚雷の照準計 算などの専門的な軍事用途に用いられた。この時代、最初の電子式デジタルコンピュータが開発され、1942年にジョージ・スティビッツによって「デジタ ル」という用語が提案された。当初は大型の部屋ほどの大きさで、現代のPC数百台分の電力を消費していた。[3] クロード・シャノンは、ブール代数の電気的応用によってあらゆる論理的数値関係を構築できることを実証し、1937年の修士論文でデジタルコンピューティ ングとデジタル回路の基礎を築いた。この論文は、史上最も重要な修士論文のひとつとされており、1939年にアルフレッド・ノーベル賞を受賞している。 [4][5] Z3 は、コンラート・ズースによって設計された電気機械式コンピュータ。1941年に完成し、世界初の動作可能な、完全に自動化されたプログラム可能なデジタ ルコンピュータだった。[6] その動作は、1904年にジョン・アンブローズ・フレミングによって発明された真空管によって容易になった。 デジタル計算がアナログ計算に置き換わるのと同時に、純粋な電子回路要素が機械式や電気機械式の同等品を次々と置き換えていった。ジョン・バーディーンと ウォルター・ブラッテンは1947年にベル研究所でポイントコンタクトトランジスタを発明し、その後1948年にウィリアム・ショックリーがベル研究所で バイポーラ接合トランジスタを発明した。[7][8] マンチェスター大学では、トム・キルバーンの指導の下、チームが真空管の代わりに新しく開発されたトランジスタを使用した機械を設計、製作した。[9] 彼らの「トランジスタ式コンピュータ」は、世界初のコンピュータであり、1953年に稼働を開始し、1955年4月に第2世代が完成した。1955年以 降、トランジスタはコンピュータ設計において真空管に置き換えられ、コンピュータの「第2世代」が誕生した。真空管と比べて、トランジスタは小型で信頼性 が高く、寿命が無限で、消費電力が少なかったため、発熱が少なく、比較的コンパクトな空間に数万個の回路を密集させることが可能になった。[出典が必要] 1955年、カール・フロッシュとリンカーン・デリックはシリコン二酸化物表面パッシベーション効果を発見した。[10] 1957年、フロッシュとデリックはマスクと事前堆積技術を用いて、シリコン二酸化物フィールド効果トランジスタを製造した。これは、ドレインとソースが 同一表面に隣接する最初の平面トランジスタだった。[11] ベル研究所では、フロッシュとデリックの技術とトランジスタの重要性がすぐに認識された。彼らの研究結果は、1957年に発表される前に、ベル研究所内で BTLメモの形で広まった。ショックレー・セミコンダクターでは、ショックレーが1956年12月に、ジャン・ホーニを含むすべての幹部職員に彼らの論文 の事前印刷物を配布した。[12][13][14][15]。ホエルニは、1959 年にフェアチャイルドセミコンダクター社で平面プロセスを発明することになる[16][17]。ベル研究所では、J.R. リジェンツァと W.G. スピッツァーが、熱成長酸化物のメカニズムを研究し、高品質の Si/SiO2 スタックを製造、1960 年にその結果を発表した。[18][19][20] ベル研究所でのこの研究を受けて、モハメッド・アタラとダウォン・カンは 1959 年にシリコン MOS トランジスタを提案し[21]、1960 年にベル研究所のチームで MOS デバイスの動作を実証することに成功した[22]。[23] このチームには、デバイスを製造した E. E. LaBate と E. I. Povilonis、拡散プロセスを開発した M. O. Thurston、L. A. D’Asaro、J. R. Ligenza、およびデバイスの特性を評価した H. K. Gummel と R. Lindner が参加していました。[24][25] 1958年7月、テキサス・インスツルメンツ社に勤務していたジャック・キルビーは、集積回路(IC)に関する最初のアイデアを記録し、1958年9月 12日に最初の動作する集積回路のデモンストレーションに成功した。[26] キルビーのチップはゲルマニウムでできていた。翌年、フェアチャイルドセミコンダクター社のロバート・ノイスがシリコン集積回路を発明した。ノイスのシリ コン IC の基礎となったのは、ホーエルニの平面プロセスだった。[要出典] MOSFET の利点としては、高いスケーラビリティ[27]、手頃な価格[28]、低消費電力、高いトランジスタ密度などが挙げられる[29]。また、オン/オフの電 子スイッチング速度が速いため、電子デジタル信号の基礎となるパルス列の生成にも最適だ[30]。[31][32] これとは対照的に、BJT は、よりゆっくりと、正弦波に似たアナログ信号を生成する[30]。MOS 大規模集積化 (LSI) と相まって、これらの要因により、MOSFET はデジタル回路にとって重要なスイッチングデバイスとなっている[33]。MOSFET はエレクトロニクス業界に革命をもたらし[34][35]、最も一般的な半導体デバイスとなっている[36][37]。 集積回路の初期段階では、各チップには数個のトランジスタしか搭載できず、集積度が低かったため、設計プロセスは比較的単純だった。製造収率も現在の基準 では非常に低かった。1970年代初頭までにMOSFETトランジスタが広く採用されたことで、1チップに10,000個を超えるトランジスタを搭載した 最初の大型集積回路(LSI)チップが誕生した。[38] 1980年代までにMOSFETの一種であるCMOSが広く採用されると、技術が進歩するにつれ、1つのチップに数百万、そして数十億のMOSFETを配 置できるようになり[39]、優れた設計には徹底した計画が必要となり、新たな設計手法が生まれました。デバイスのトランジスタ数と総生産量は前例のない 水準に達しました。2018年までに生産されたトランジスタの総数は、1.3×10²²(13セクティリオン)と推定されている。[40] ワイヤレス革命(ワイヤレスネットワークの導入と普及)は1990年代に始まり、MOSFETベースのRFパワーアンプ(パワーMOSFETおよび LDMOS)およびRF回路(RF CMOS)の広範な採用によって可能になった。[41][42][43] 無線ネットワークはケーブルを必要としない公共のデジタル伝送を可能にし、1990年代から2000年代にかけてデジタルテレビ、衛星放送、デジタルラジ オ、GPS、無線インターネット、携帯電話の普及をもたらした。[出典が必要] |

| Properties An advantage of digital circuits when compared to analog circuits is that signals represented digitally can be transmitted without degradation caused by noise.[44] For example, a continuous audio signal transmitted as a sequence of 1s and 0s, can be reconstructed without error, provided the noise picked up in transmission is not enough to prevent identification of the 1s and 0s. In a digital system, a more precise representation of a signal can be obtained by using more binary digits to represent it. While this requires more digital circuits to process the signals, each digit is handled by the same kind of hardware, resulting in an easily scalable system. In an analog system, additional resolution requires fundamental improvements in the linearity and noise characteristics of each step of the signal chain. With computer-controlled digital systems, new functions can be added through software revision and no hardware changes are needed. Often this can be done outside of the factory by updating the product's software. This way, the product's design errors can be corrected even after the product is in a customer's hands. Information storage can be easier in digital systems than in analog ones. The noise immunity of digital systems permits data to be stored and retrieved without degradation. In an analog system, noise from aging and wear degrade the information stored. In a digital system, as long as the total noise is below a certain level, the information can be recovered perfectly. Even when more significant noise is present, the use of redundancy permits the recovery of the original data provided too many errors do not occur. In some cases, digital circuits use more energy than analog circuits to accomplish the same tasks, thus producing more heat which increases the complexity of the circuits such as the inclusion of heat sinks. In portable or battery-powered systems this can limit the use of digital systems. For example, battery-powered cellular phones often use a low-power analog front-end to amplify and tune the radio signals from the base station. However, a base station has grid power and can use power-hungry, but very flexible software radios. Such base stations can easily be reprogrammed to process the signals used in new cellular standards. Many useful digital systems must translate from continuous analog signals to discrete digital signals. This causes quantization errors. Quantization error can be reduced if the system stores enough digital data to represent the signal to the desired degree of fidelity. The Nyquist–Shannon sampling theorem provides an important guideline as to how much digital data is needed to accurately portray a given analog signal. If a single piece of digital data is lost or misinterpreted, in some systems only a small error may result, while in other systems the meaning of large blocks of related data can completely change. For example, a single-bit error in audio data stored directly as linear pulse-code modulation causes, at worst, a single audible click. But when using audio compression to save storage space and transmission time, a single bit error may cause a much larger disruption. Because of the cliff effect, it can be difficult for users to tell if a particular system is right on the edge of failure, or if it can tolerate much more noise before failing. Digital fragility can be reduced by designing a digital system for robustness. For example, a parity bit or other error management method can be inserted into the signal path. These schemes help the system detect errors, and then either correct the errors, or request retransmission of the data. Further information: Digital signal conditioning and Signal conditioning |

特性 アナログ回路と比較したデジタル回路の利点は、デジタルで表された信号はノイズによる劣化を受けずに伝送できる点です。[44] 例えば、連続した音声信号を1と0の列として伝送した場合、伝送中に拾ったノイズが1と0の識別を妨げるほど大きくない限り、誤りなく再構成できます。 デジタルシステムでは、信号をより多くの二進数で表すことで、より正確な信号表現を得ることができます。これには信号処理に多くのデジタル回路が必要にな りますが、各桁は同じ種類のハードウェアで処理されるため、スケーラブルなシステムを実現できます。アナログシステムでは、追加の解像度を得るためには、 信号チェーンの各段階の線形特性とノイズ特性の根本的な改善が必要です。 コンピュータ制御のデジタルシステムでは、ソフトウェアの改訂により新しい機能を追加でき、ハードウェアの変更は不要です。多くの場合、これは製品のソフ トウェアを更新することで工場外で行うことができます。これにより、製品が顧客の手元に渡った後でも、製品の設計ミスを修正することが可能です。 デジタルシステムでは、アナログシステムよりも情報保存が容易です。デジタルシステムのノイズ耐性により、データは劣化せずに保存・取得可能です。アナロ グシステムでは、経年劣化や摩耗によるノイズが保存された情報を劣化させます。デジタルシステムでは、総ノイズが一定レベル未満であれば、情報は完全に復 元可能です。より大きなノイズが存在する場合でも、冗長性を利用することで、エラーが一定数を超えない限り、元のデータを復元可能です。 一部のケースでは、デジタル回路は同じタスクを実行するためにアナログ回路よりも多くのエネルギーを消費し、これにより発熱が増加し、ヒートシンクの追加 など回路の複雑化を招く。携帯型や電池駆動のシステムでは、これがデジタルシステムの使用を制限する要因となる。例えば、電池駆動の携帯電話は、基地局か らの無線信号を増幅および調整するために、低電力のアナログフロントエンドを使用することが多い。しかし、基地局はグリッド電源を使用しており、電力消費 は大きいものの、非常に柔軟性の高いソフトウェア無線を使用することができる。このような基地局は、新しい携帯電話規格で使用される信号を処理するように 簡単に再プログラムすることができる。 多くの有用なデジタルシステムは、連続的なアナログ信号を離散的なデジタル信号に変換する必要がある。これにより、量子化誤差が生じる。量子化誤差は、信 号を望ましい忠実度で表現するのに十分なデジタルデータをシステムが保存していれば、低減できる。ナイキスト・シャノンサンプリング定理は、特定のアナロ グ信号を正確に表現するために必要なデジタルデータの量に関する重要な指針を提供している。 単一のデジタルデータが失われたり誤って解釈されたりした場合、一部のシステムではわずかな誤差で済むが、他のシステムでは関連する大量のデータの意味が 完全に変化してしまうことがある。たとえば、線形パルス符号変調として直接保存されたオーディオデータに 1 ビットのエラーが発生した場合、最悪の場合、1 回だけクリック音が鳴るだけだ。しかし、ストレージ容量や伝送時間を節約するためにオーディオ圧縮を使用している場合、1 ビットのエラーによってはるかに大きな障害が発生する可能性がある。 クリフ効果のため、特定のシステムが故障の危機に瀕しているかどうか、あるいは故障する前にさらに多くのノイズを許容できるかどうかをユーザーが判断する のは難しい場合がある。デジタルの脆弱性は、堅牢性を考慮したデジタルシステム設計により軽減できる。例えば、パリティビットやその他のエラー管理手法を 信号経路に組み込むことができる。これらの手法は、システムがエラーを検出し、エラーを修正するか、データの再送信を要求するのを支援する。 詳細情報:デジタル信号調整および信号調整 |

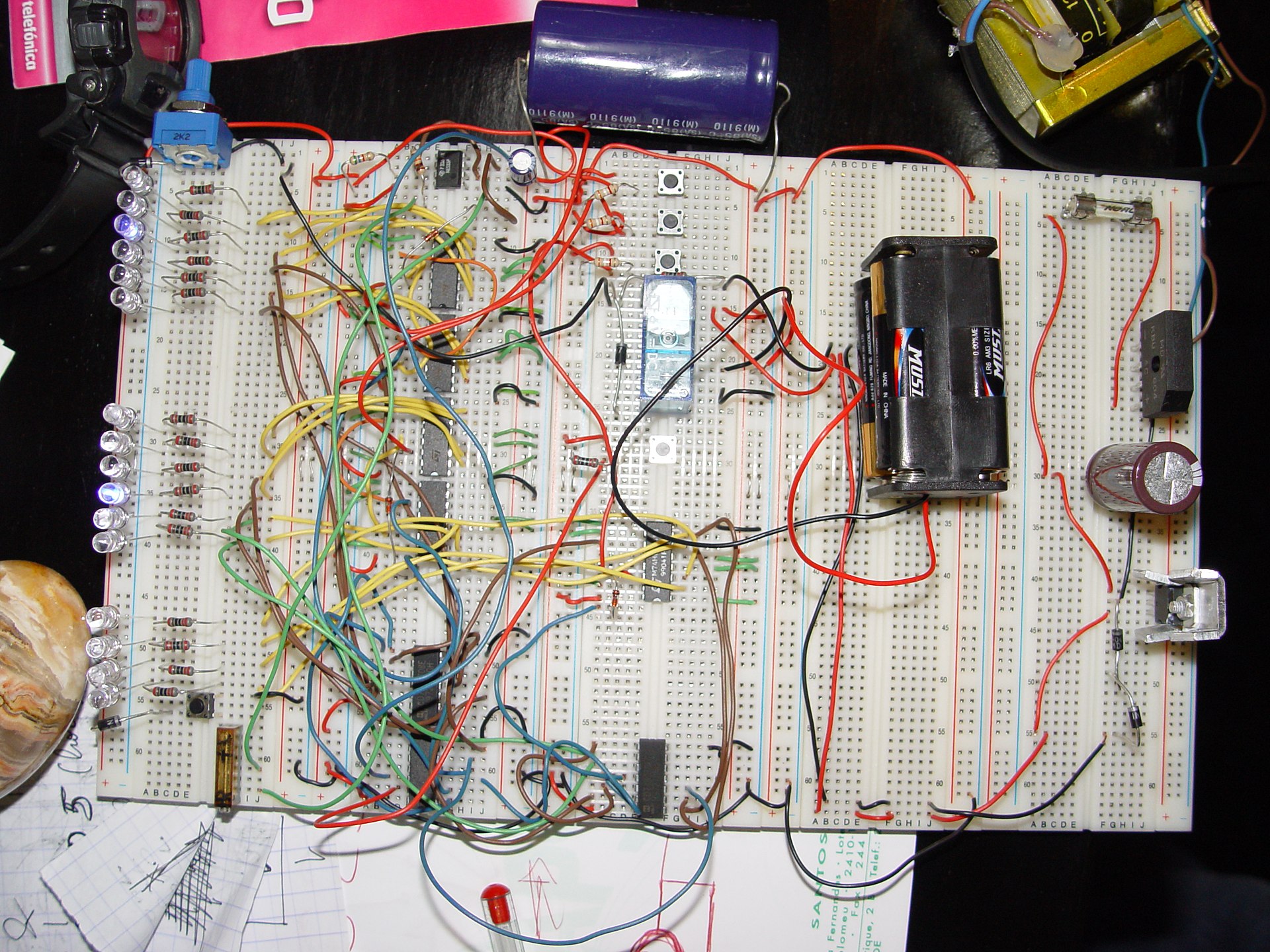

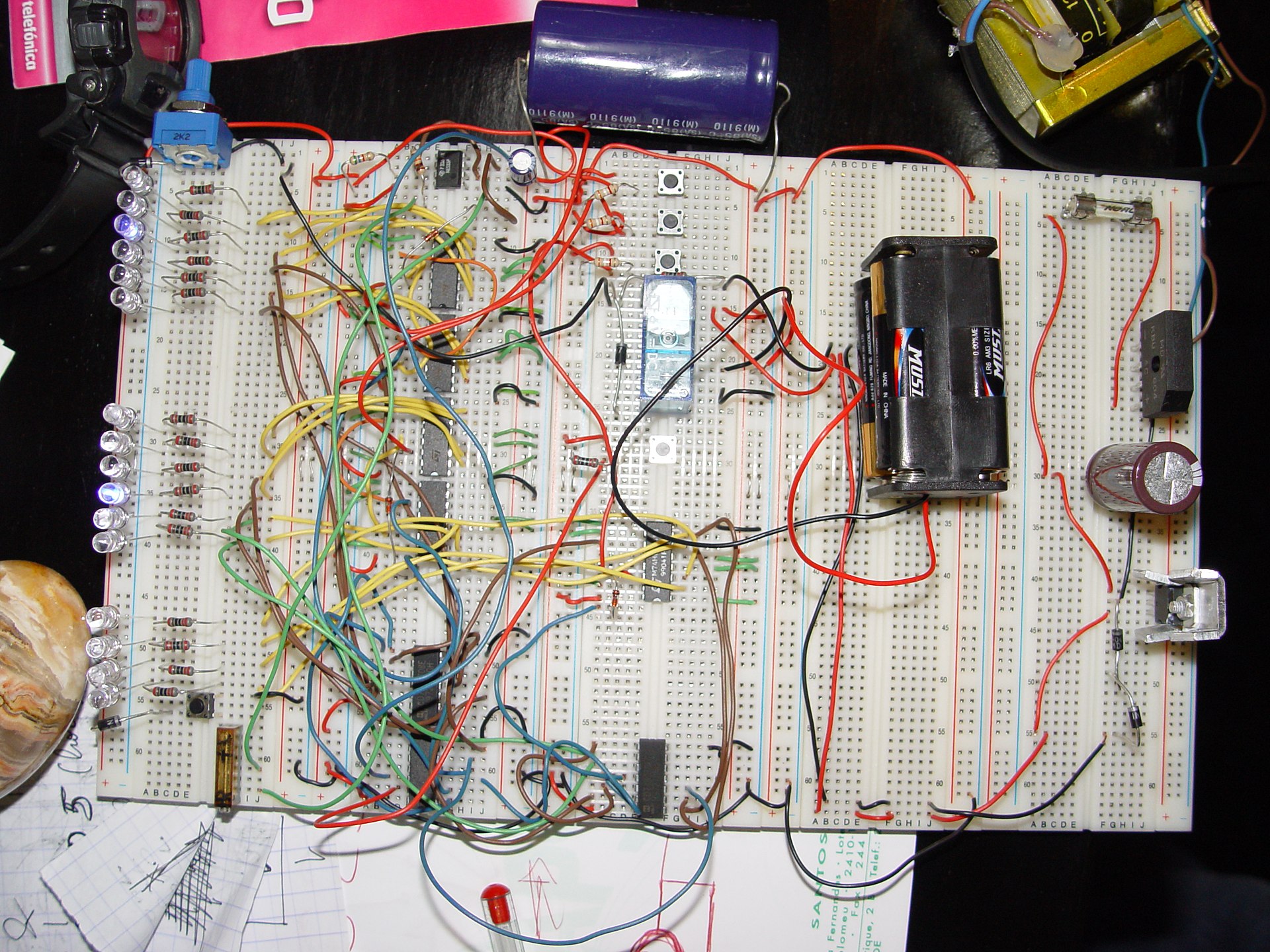

Construction A binary clock, hand-wired on breadboards A digital circuit is typically constructed from small electronic circuits called logic gates that can be used to create combinational logic and sequential logic. Each logic gate is designed to perform a function of Boolean logic when acting on logic signals. A logic gate is generally created from one or more electrically controlled switches, usually transistors but thermionic valves have seen historic use. The output of a logic gate can, in turn, control or feed into more logic gates. Another form of digital circuit is constructed from lookup tables, (many sold as "programmable logic devices", though other kinds of PLDs exist). Lookup tables can perform the same functions as machines based on logic gates, but can be easily reprogrammed without changing the wiring. This means that a designer can often repair design errors without changing the arrangement of wires. Therefore, in small-volume products, programmable logic devices are often the preferred solution. They are usually designed by engineers using electronic design automation software. Integrated circuits consist of multiple transistors on one silicon chip and are the least expensive way to make a large number of interconnected logic gates. Integrated circuits are usually interconnected on a printed circuit board which is a board that holds electrical components, and connects them together with copper traces. |

構造 ブレッドボードに手配線された 2 進時計 デジタル回路は通常、組み合わせ論理や順序論理を構築するために使用される、論理ゲートと呼ばれる小さな電子回路で構成されています。各論理ゲートは、論 理信号に作用する際にブール論理の機能を実行するように設計されています。論理ゲートは通常、1 つ以上の電気的に制御されるスイッチ(通常はトランジスタですが、熱電子バルブも歴史的に使用されています)から構成されています。論理ゲートの出力は、 さらに他の論理ゲートを制御したり、入力したりすることができる。 デジタル回路のもう一つの形態は、ルックアップテーブルから構成されている(多くは「プログラマブル・ロジック・デバイス」として販売されているが、他の 種類の PLD も存在する)。ルックアップテーブルは、論理ゲートに基づく機械と同じ機能を実行できるが、配線を変更することなく簡単に再プログラムすることができる。 つまり、設計者は、配線の配置を変更することなく、設計上の誤りを修正することができる場合が多い。そのため、少量生産の製品では、プログラマブルロジッ クデバイスが好まれることが多い。これらは通常、電子設計自動化ソフトウェアを使用してエンジニアによって設計される。 集積回路は、1つのシリコンチップ上に複数のトランジスタを組み込んだもので、多数の相互接続された論理ゲートを製造する最も安価な方法だ。集積回路は通 常、電気部品を保持し、それらを銅の配線で接続するプリント基板上に相互接続される。 |

| Design Engineers use many methods to minimize logic redundancy in order to reduce the circuit complexity. Reduced complexity reduces component count and potential errors and therefore typically reduces cost. Logic redundancy can be removed by several well-known techniques, such as binary decision diagrams, Boolean algebra, Karnaugh maps, the Quine–McCluskey algorithm, and the heuristic computer method. These operations are typically performed within a computer-aided design system. Embedded systems with microcontrollers and programmable logic controllers are often used to implement digital logic for complex systems that do not require optimal performance. These systems are usually programmed by software engineers or by electricians, using ladder logic. |

設計 エンジニアは、回路の複雑さを軽減するために、論理の冗長性を最小限に抑えるさまざまな手法を使用している。複雑さが軽減されると、部品点数と潜在的なエ ラーが減り、その結果、通常、コストも削減される。論理の冗長性は、バイナリ決定図、ブール代数、カルノー図、クワイン・マックラスキーアルゴリズム、 ヒューリスティックコンピュータ手法など、いくつかのよく知られた手法によって除去することができる。これらの操作は、通常、コンピュータ支援設計システ ム内で実行される。 マイクロコントローラやプログラマブルロジックコントローラを搭載した組み込みシステムは、最適な性能を必要としない複雑なシステムのデジタルロジックの 実装によく使用される。これらのシステムは、通常、ソフトウェアエンジニアや電気技術者がラダーロジックを使用してプログラムする。 |

| Representation A digital circuit's input-output relationship can be represented as a truth table. An equivalent high-level circuit uses logic gates, each represented by a different shape (standardized by IEEE/ANSI 91–1984).[45] A low-level representation uses an equivalent circuit of electronic switches (usually transistors). Most digital systems divide into combinational and sequential systems. The output of a combinational system depends only on the present inputs. However, a sequential system has some of its outputs fed back as inputs, so its output may depend on past inputs in addition to present inputs, to produce a sequence of operations. Simplified representations of their behavior called state machines facilitate design and test. Sequential systems divide into two further subcategories. "Synchronous" sequential systems change state all at once when a clock signal changes state. "Asynchronous" sequential systems propagate changes whenever inputs change. Synchronous sequential systems are made using flip flops that store inputted voltages as a bit only when the clock changes. |

表現 デジタル回路の入出力関係は、真理値表として表現することができる。同等の高レベル回路は、それぞれ異なる形状(IEEE/ANSI 91–1984 で標準化)で表される論理ゲートを使用している。[45] 低レベル表現では、電子スイッチ(通常はトランジスタ)の等価回路を使用する。 ほとんどのデジタルシステムは、組み合わせ回路とシーケンシャル回路に分類される。組み合わせ回路の出力は、現在の入力のみに依存する。一方、シーケン シャル回路は、一部の出力を入力としてフィードバックするため、現在の入力だけでなく過去の入力にも依存して出力が決定され、一連の操作を生成する。その 動作を簡略化した表現である状態マシンは、設計とテストを容易にする。 シーケンシャルシステムはさらに2つのサブカテゴリに分けられる。「同期」シーケンシャルシステムは、クロック信号の状態が変化すると、状態を一度にすべ て変更する。「非同期」シーケンシャルシステムは、入力が変化するたびに状態を伝播する。同期シーケンシャルシステムは、クロックが変化した際にのみ入力 電圧をビットとして保存するフリップフロップを使用して構成される。 |

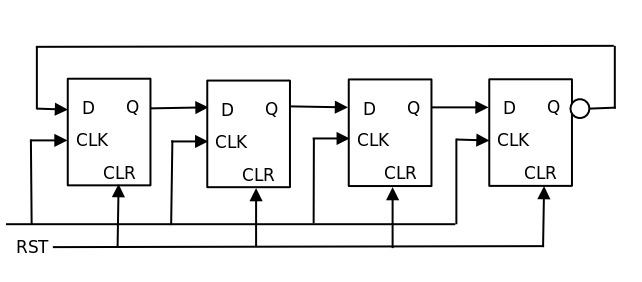

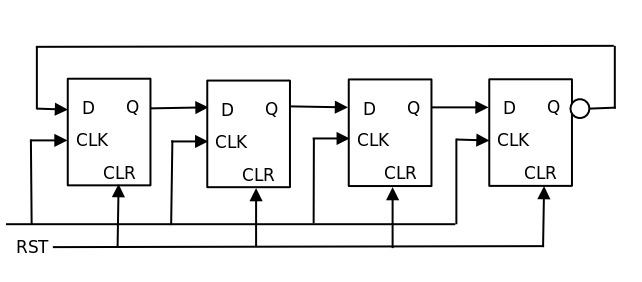

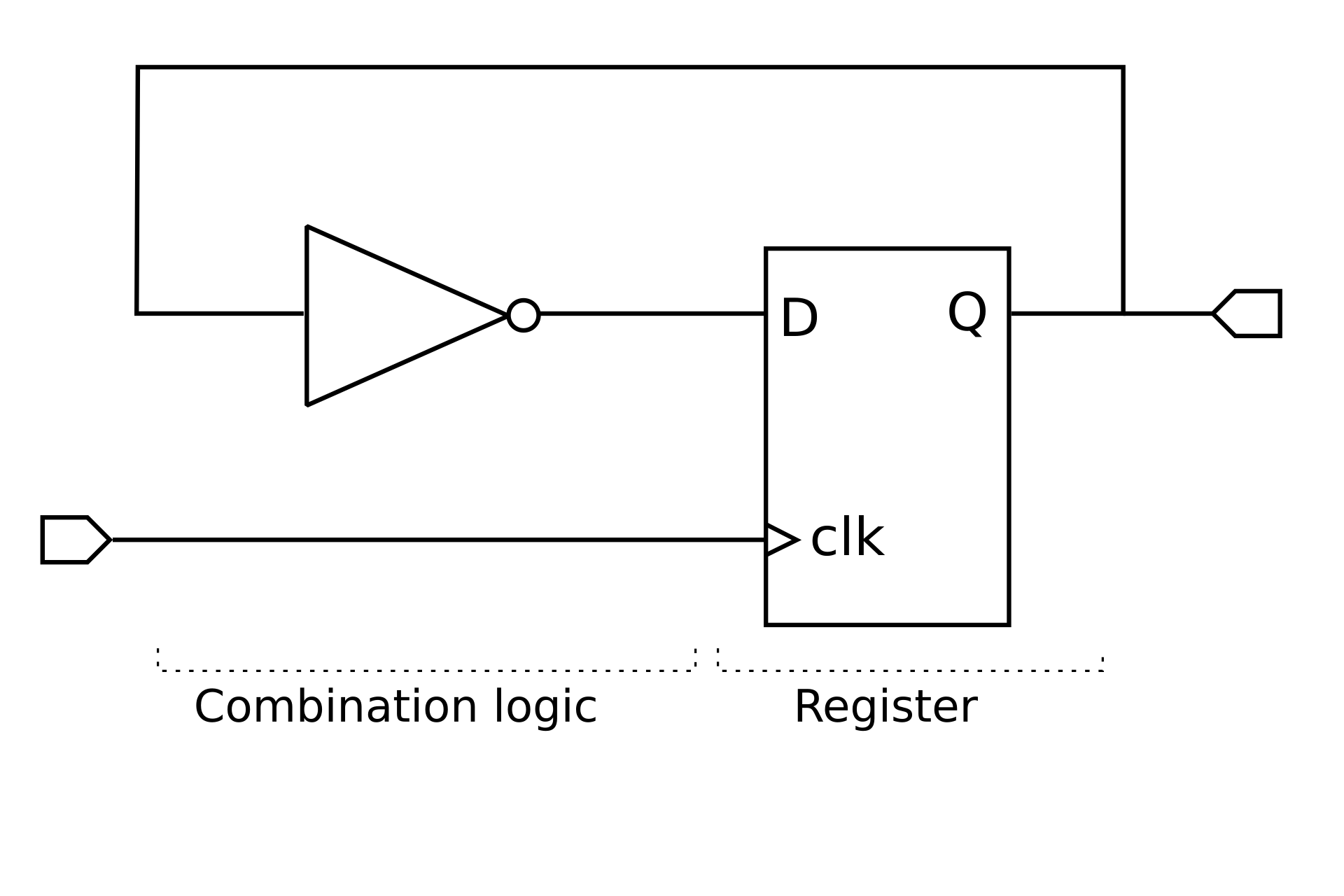

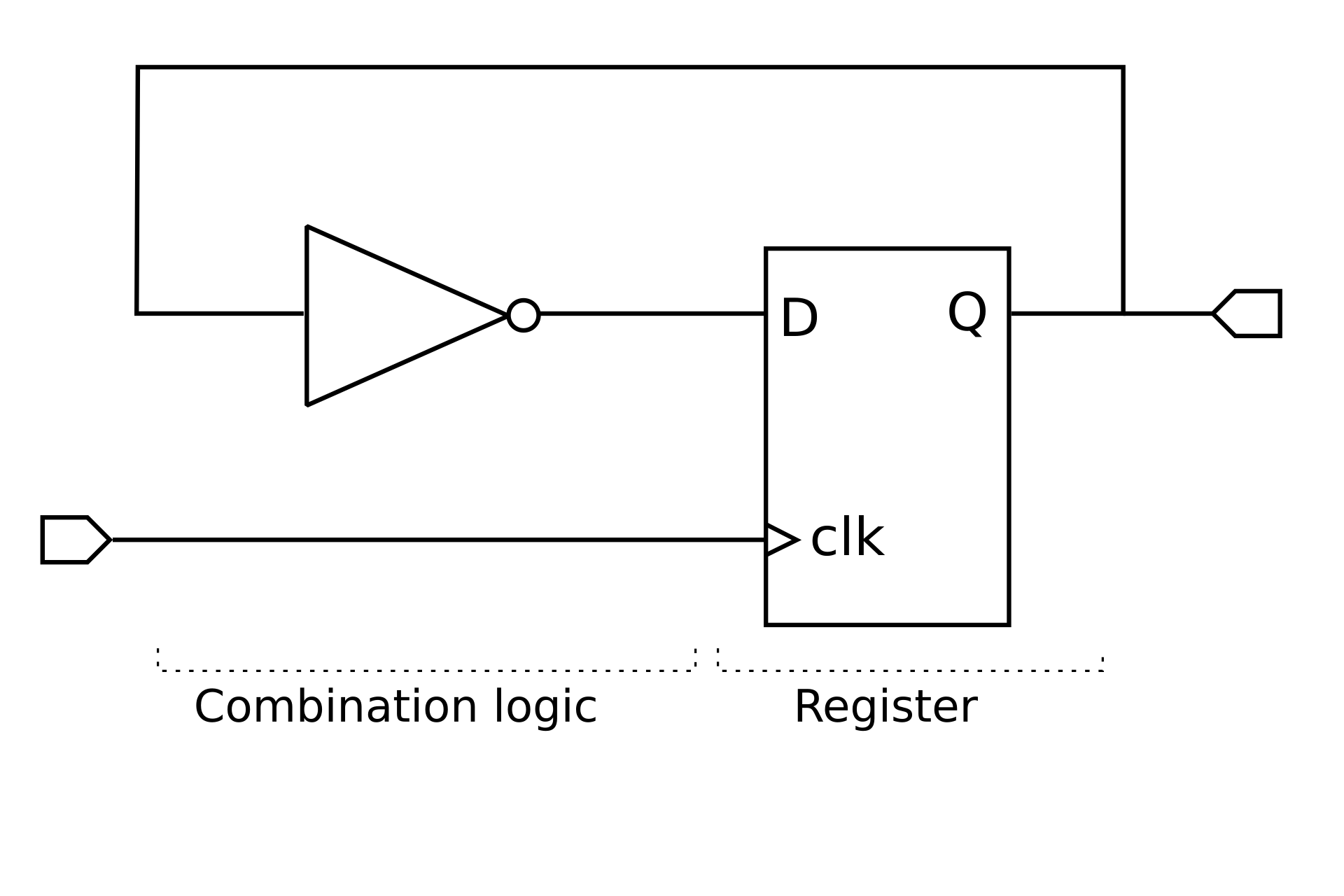

Synchronous systems A 4-bit ring counter using D-type flip flops is an example of synchronous logic. Each device is connected to the clock signal, and update together. Main article: synchronous logic The usual way to implement a synchronous sequential state machine is to divide it into a piece of combinational logic and a set of flip flops called a state register. The state register represents the state as a binary number. The combinational logic produces the binary representation for the next state. On each clock cycle, the state register captures the feedback generated from the previous state of the combinational logic and feeds it back as an unchanging input to the combinational part of the state machine. The clock rate is limited by the most time-consuming logic calculation in the combinational logic. |

同期システム D型フリップフロップを使用した4ビットのリングカウンタは、同期論理の例です。各デバイスはクロック信号に接続されており、同時に更新されます。 主な記事:同期論理 同期シーケンシャルステートマシンを実装する一般的な方法は、それを組み合わせ論理と、ステートレジスタと呼ばれるフリップフロップのセットに分割するこ とです。状態レジスタは状態を二進数で表す。組み合わせ論理は次の状態の二進数表現を生成する。各クロックサイクルで、状態レジスタは組み合わせ論理の前 の状態から生成されたフィードバックをキャプチャし、状態マシンの組み合わせ部分への不変の入力としてフィードバックする。クロックレートは、組み合わせ 論理内の最も時間のかかる論理計算によって制限される。 |

| Asynchronous systems Most digital logic is synchronous because it is easier to create and verify a synchronous design. However, asynchronous logic has the advantage of its speed not being constrained by an arbitrary clock; instead, it runs at the maximum speed of its logic gates.[a] Nevertheless, most systems need to accept external unsynchronized signals into their synchronous logic circuits. This interface is inherently asynchronous and must be analyzed as such. Examples of widely used asynchronous circuits include synchronizer flip-flops, switch debouncers and arbiters. Asynchronous logic components can be hard to design because all possible states, in all possible timings must be considered. The usual method is to construct a table of the minimum and maximum time that each such state can exist and then adjust the circuit to minimize the number of such states. The designer must force the circuit to periodically wait for all of its parts to enter a compatible state (this is called "self-resynchronization"). Without careful design, it is easy to accidentally produce asynchronous logic that is unstable—that is—real electronics will have unpredictable results because of the cumulative delays caused by small variations in the values of the electronic components. |

非同期システム デジタルロジックの大部分は、同期設計の方が作成および検証が容易であるため、同期式です。しかし、非同期ロジックには、任意のクロックによって速度が制 限されないという利点があります。代わりに、ロジックゲートの最大速度で動作します。[a] それにもかかわらず、ほとんどのシステムは、同期ロジック回路に外部からの非同期信号を受け入れる必要があります。このインターフェースは本質的に非同期 であり、そのように分析する必要があります。広く使用されている非同期回路の例としては、シンクロナイザフリップフロップ、スイッチデバウンス、アービ ターなどがある。 非同期論理部品は、考えられるすべてのタイミングにおけるすべての可能な状態を考慮しなければならないため、設計が難しい場合がある。一般的な方法は、各 状態が存在する可能性のある最小時間と最大時間の表を作成し、そのような状態の数を最小限に抑えるように回路を調整することだ。設計者は、回路がすべての 部品が互いに互換性のある状態になるまで定期的に待機するように強制する必要があります(これを「自己再同期化」と呼びます)。慎重な設計が行われない場 合、小さな電子部品の値の変動による累積遅延により、実際の電子機器で予測不能な結果を生じる不安定な非同期論理を誤って生成する可能性があります。 |

Register transfer systems Example of a simple circuit with a toggling output. The inverter forms the combinational logic in this circuit, and the register holds the state. Many digital systems are data flow machines. These are usually designed using synchronous register transfer logic and written with hardware description languages such as VHDL or Verilog. In register transfer logic, binary numbers are stored in groups of flip flops called registers. A sequential state machine controls when each register accepts new data from its input. The outputs of each register are a bundle of wires called a bus that carries that number to other calculations. A calculation is simply a piece of combinational logic. Each calculation also has an output bus, and these may be connected to the inputs of several registers. Sometimes a register will have a multiplexer on its input so that it can store a number from any one of several buses.[b] Asynchronous register-transfer systems (such as computers) have a general solution. In the 1980s, some researchers discovered that almost all synchronous register-transfer machines could be converted to asynchronous designs by using first-in-first-out synchronization logic. In this scheme, the digital machine is characterized as a set of data flows. In each step of the flow, a synchronization circuit determines when the outputs of that step are valid and instructs the next stage when to use these outputs.[citation needed] |

レジスタ転送システム トグル出力を持つ簡単な回路の例。この回路では、インバータが組み合わせ論理を形成し、レジスタが状態を保持している 多くのデジタルシステムはデータフローマシンです。これらは通常、同期レジスタ転送論理を使用して設計され、VHDL や Verilog などのハードウェア記述言語で記述されます。 レジスタ転送論理では、2 進数はレジスタと呼ばれるフリップフロップのグループに格納されます。シーケンシャルステートマシンが、各レジスタが入力から新しいデータを受け入れるタ イミングを制御します。各レジスタの出力は、その数値を他の演算に伝達するバスと呼ばれるワイヤの束です。計算は、単に組み合わせ論理の一部分だ。各計算 にも出力バスがあり、これらは複数のレジスタの入力に接続されている場合がある。レジスタの入力にマルチプレクサが搭載されている場合もあり、その場合は 複数のバスからいずれかの数値を格納することができる。[b] 非同期レジスタ転送システム(コンピュータなど)には、一般的な解決策がある。1980年代、一部の研究者は、ほぼすべての同期レジスタ転送マシンを、先 入れ先出し同期論理を使用することで非同期設計に変換できることを発見した。この方式では、デジタルマシンはデータフローの集合として特徴付けられる。フ ローの各ステップで、同期回路がそのステップの出力の有効性を判断し、次のステージにこれらの出力を使用するタイミングを指示する。[出典必要] |

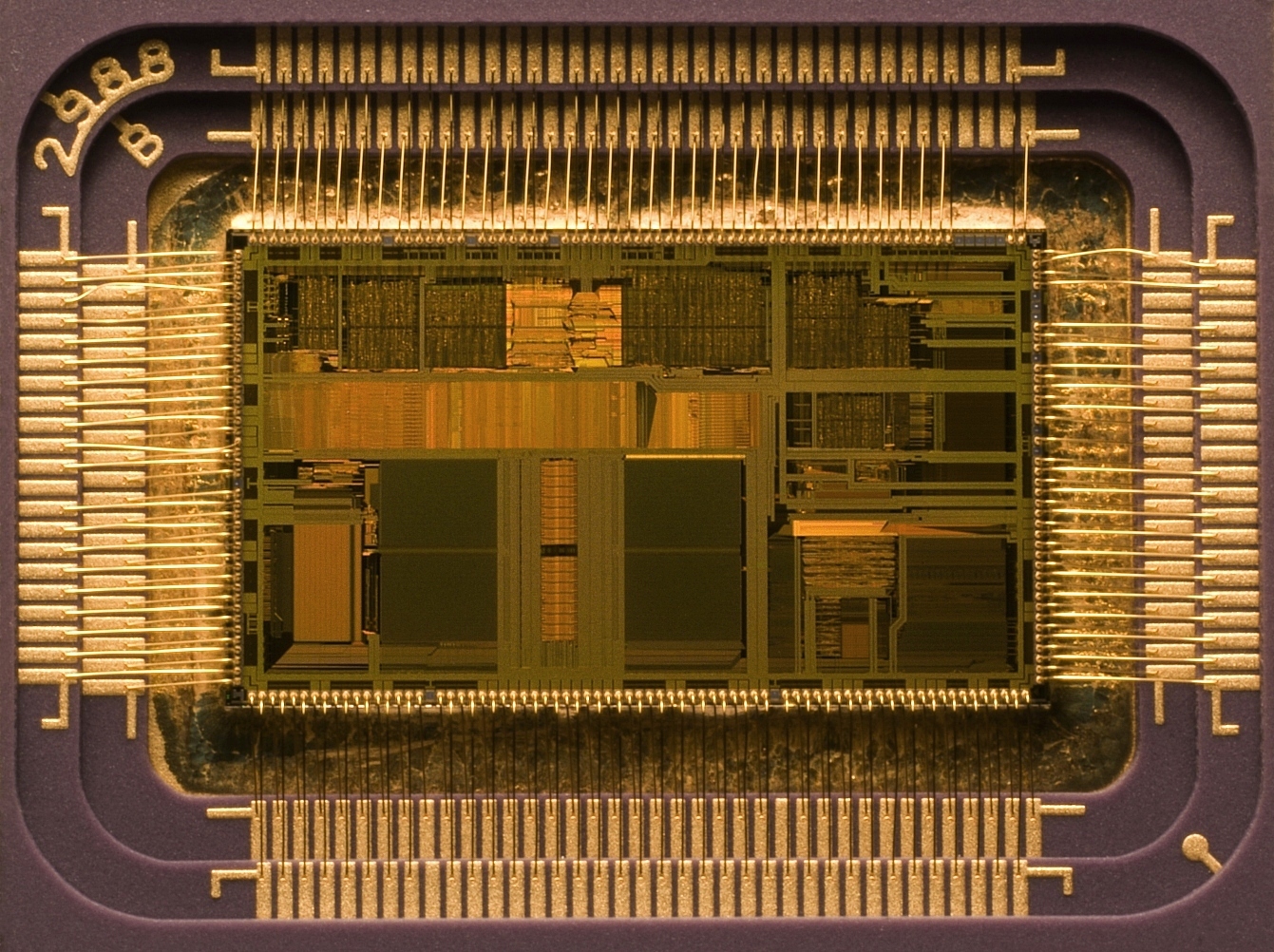

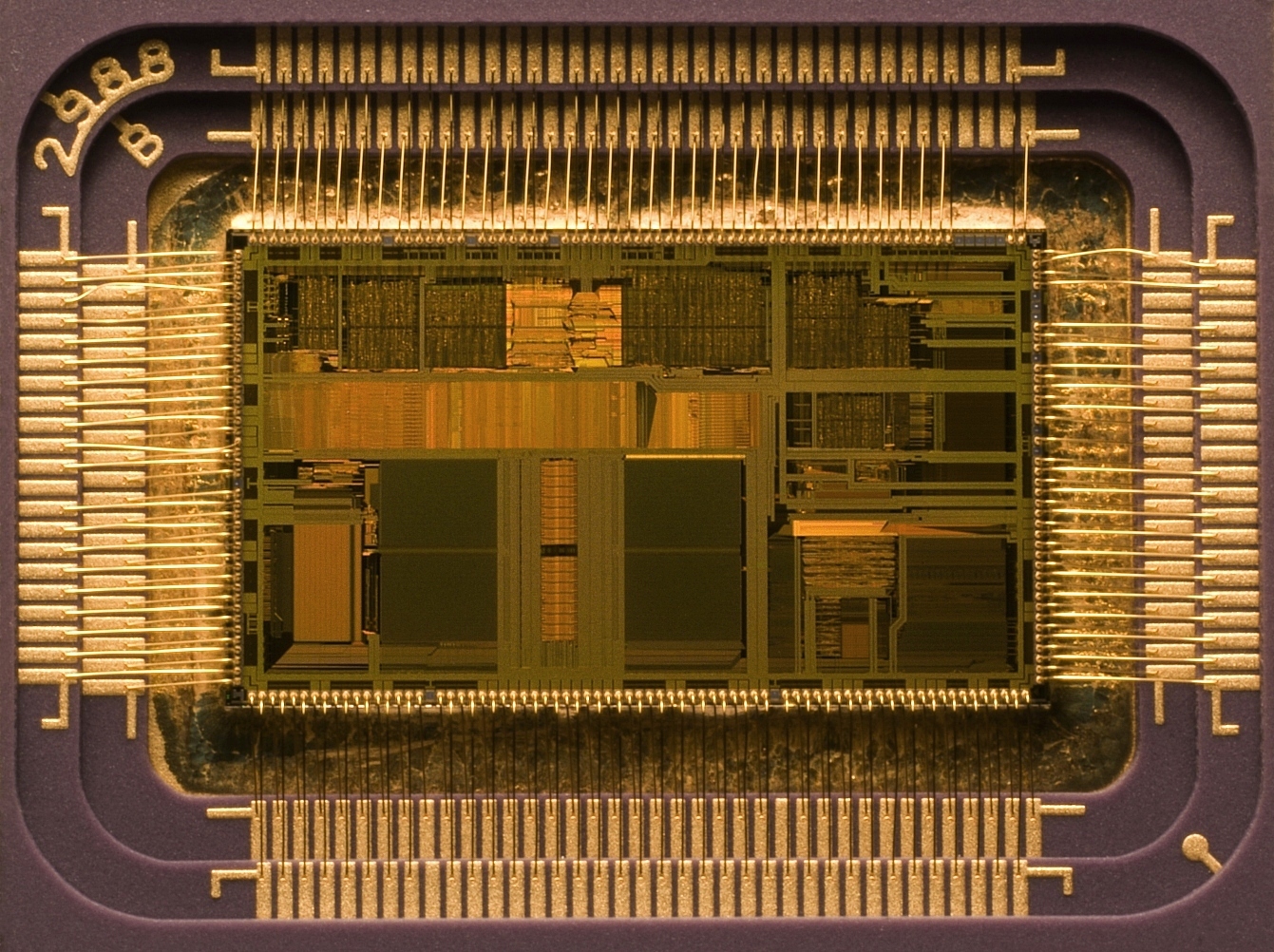

Computer design Intel 80486DX2 microprocessor The most general-purpose register-transfer logic machine is a computer. This is basically an automatic binary abacus. The control unit of a computer is usually designed as a microprogram run by a microsequencer. A microprogram is much like a player-piano roll. Each table entry of the microprogram commands the state of every bit that controls the computer. The sequencer then counts, and the count addresses the memory or combinational logic machine that contains the microprogram. The bits from the microprogram control the arithmetic logic unit, memory and other parts of the computer, including the microsequencer itself. In this way, the complex task of designing the controls of a computer is reduced to the simpler task of programming a collection of much simpler logic machines. Almost all computers are synchronous. However, asynchronous computers have also been built. One example is the ASPIDA DLX core.[47] Another was offered by ARM Holdings.[48] They do not, however, have any speed advantages because modern computer designs already run at the speed of their slowest component, usually memory. They do use somewhat less power because a clock distribution network is not needed. An unexpected advantage is that asynchronous computers do not produce spectrally-pure radio noise. They are used in some radio-sensitive mobile-phone base-station controllers. They may be more secure in cryptographic applications because their electrical and radio emissions can be more difficult to decode.[48] |

コンピュータの設計 Intel 80486DX2 マイクロプロセッサ 最も汎用的なレジスタ転送論理マシンはコンピュータだ。これは基本的に自動二進算盤だ。コンピュータの制御ユニットは、通常、マイクロシーケンサによって 実行されるマイクロプログラムとして設計されている。マイクロプログラムは、ピアノロールに非常に似ている。マイクロプログラムの各テーブルエントリは、 コンピュータを制御するすべてのビットの状態を指示する。シーケンサーはカウントし、そのカウントがマイクロプログラムを含むメモリまたは組み合わせ論理 マシンをアドレス指定する。マイクロプログラムのビットは、算術論理ユニット、メモリ、およびコンピュータの他の部分(マイクロシーケンサー自体を含む) を制御する。この way、コンピュータの制御設計の複雑なタスクは、より単純な論理マシンの集合をプログラミングする単純なタスクに簡素化される。 ほぼすべてのコンピュータは同期式だ。しかし、非同期式コンピュータも構築されている。一例がASPIDA DLXコア[47]だ。もう一つはARM Holdingsが提案した[48]。ただし、現代のコンピュータ設計は既に最も遅いコンポーネント(通常はメモリ)の速度で動作しているため、速度上の 利点はない。ただし、クロック配分ネットワークが不要なため、消費電力は若干少ない。意外な利点として、非同期コンピュータはスペクトル純粋な無線ノイズ を発生しない。これらは、無線に敏感な携帯電話基地局コントローラーに用いられている。暗号化アプリケーションでは、電気的および無線的な放射を解読する のが困難なため、より安全である可能性がある。[48] |

| Computer architecture Computer architecture is a specialized engineering activity that tries to arrange the registers, calculation logic, buses and other parts of the computer in the best way possible for a specific purpose. Computer architects have put a lot of work into reducing the cost and increasing the speed of computers in addition to boosting their immunity to programming errors. An increasingly common goal of computer architects is to reduce the power used in battery-powered computer systems, such as smartphones. Design issues in digital circuits This section does not cite any sources. Please help improve this section by adding citations to reliable sources. Unsourced material may be challenged and removed. (September 2015) (Learn how and when to remove this message) Digital circuits are made from analog components. The design must assure that the analog nature of the components does not dominate the desired digital behavior. Digital systems must manage noise and timing margins, parasitic inductances and capacitances. Bad designs have intermittent problems such as glitches, vanishingly fast pulses that may trigger some logic but not others, runt pulses that do not reach valid threshold voltages. Additionally, where clocked digital systems interface to analog systems or systems that are driven from a different clock, the digital system can be subject to metastability where a change to the input violates the setup time for a digital input latch. Since digital circuits are made from analog components, digital circuits calculate more slowly than low-precision analog circuits that use a similar amount of space and power. However, the digital circuit will calculate more repeatably, because of its high noise immunity. |

コンピュータアーキテクチャ コンピュータアーキテクチャは、特定の目的のために、レジスタ、演算論理、バス、その他のコンピュータの部品を最適な方法で配置しようとする専門的な工学 活動です。コンピュータアーキテクトは、プログラミングエラーに対する耐性を高めるだけでなく、コンピュータのコスト削減と高速化にも多大な努力を注いで きました。コンピュータアーキテクトの目標として、スマートフォンなどのバッテリー駆動のコンピュータシステムで使用する電力を削減することがますます一 般的になっています。 デジタル回路の設計上の問題 このセクションには出典が記載されていない。信頼できる出典を追加して、このセクションを改善してください。出典が記載されていない内容は、削除される可 能性がある。 (2015年9月) (このメッセージの削除方法についてはこちらをご覧ください) デジタル回路はアナログ部品で構成されています。設計では、部品のアナログ特性が、望ましいデジタル動作に悪影響を及ぼさないよう注意する必要がありま す。デジタルシステムは、ノイズやタイミングの境界、寄生インダクタンス、寄生容量を管理する必要があります。 設計が不良な場合、グリッチ、一部のロジックは動作するが他のロジックは動作しないような、非常に高速で消失するパルス、有効しきい値電圧に達しないラン トパルスなどの断続的な問題が発生します。 さらに、クロック駆動のデジタルシステムがアナログシステムや異なるクロックで駆動されるシステムとインターフェースする場合、入力の変化によってデジタ ル入力ラッチのセットアップ時間が違反し、デジタルシステムがメタ安定状態になることがある。 デジタル回路はアナログ部品で構成されているため、同等のスペースと電力を使用する低精度のアナログ回路よりも計算速度が遅くなる。しかし、デジタル回路 はノイズ耐性が高いため、計算の再現性が高くなる。 |

| Automated design tools This section does not cite any sources. Please help improve this section by adding citations to reliable sources. Unsourced material may be challenged and removed. (June 2021) (Learn how and when to remove this message) Much of the effort of designing large logic machines has been automated through the application of electronic design automation (EDA). Simple truth table-style descriptions of logic are often optimized with EDA that automatically produce reduced systems of logic gates or smaller lookup tables that still produce the desired outputs. The most common example of this kind of software is the Espresso heuristic logic minimizer. Optimizing large logic systems may be done using the Quine–McCluskey algorithm or binary decision diagrams. There are promising experiments with genetic algorithms and annealing optimizations. To automate costly engineering processes, some EDA can take state tables that describe state machines and automatically produce a truth table or a function table for the combinational logic of a state machine. The state table is a piece of text that lists each state, together with the conditions controlling the transitions between them and their associated output signals. Often, real logic systems are designed as a series of sub-projects, which are combined using a tool flow. The tool flow is usually controlled with the help of a scripting language, a simplified computer language that can invoke the software design tools in the right order. Tool flows for large logic systems such as microprocessors can be thousands of commands long, and combine the work of hundreds of engineers. Writing and debugging tool flows is an established engineering specialty in companies that produce digital designs. The tool flow usually terminates in a detailed computer file or set of files that describe how to physically construct the logic. Often it consists of instructions on how to draw the transistors and wires on an integrated circuit or a printed circuit board. Parts of tool flows are debugged by verifying the outputs of simulated logic against expected inputs. The test tools take computer files with sets of inputs and outputs and highlight discrepancies between the simulated behavior and the expected behavior. Once the input data is believed to be correct, the design itself must still be verified for correctness. Some tool flows verify designs by first producing a design, then scanning the design to produce compatible input data for the tool flow. If the scanned data matches the input data, then the tool flow has probably not introduced errors. The functional verification data are usually called test vectors. The functional test vectors may be preserved and used in the factory to test whether newly constructed logic works correctly. However, functional test patterns do not discover all fabrication faults. Production tests are often designed by automatic test pattern generation software tools. These generate test vectors by examining the structure of the logic and systematically generating tests targeting particular potential faults. This way the fault coverage can closely approach 100%, provided the design is properly made testable (see next section). Once a design exists, and is verified and testable, it often needs to be processed to be manufacturable as well. Modern integrated circuits have features smaller than the wavelength of the light used to expose the photoresist. Software that are designed for manufacturability add interference patterns to the exposure masks to eliminate open-circuits and enhance the masks' contrast. |

自動設計ツール このセクションには出典が記載されていません。信頼できる出典を追加して、このセクションの改善にご協力ください。出典が記載されていない情報は、検証さ れ、削除される可能性があります。(2021年6月) (このメッセージの削除方法についてはこちらをご覧ください) 大規模な論理マシンの設計作業の多くは、電子設計自動化 (EDA) の適用によって自動化されています。 論理の単純な真理値表形式の記述は、EDA によって自動的に論理ゲートシステムを簡素化したり、同じ出力を生成するより小さなルックアップテーブルを生成したりして最適化される。この種のソフト ウェアの最も一般的な例は、Espresso ヘウリスティック論理最小化ツールである。大規模な論理システムの最適化には、Quine–McCluskey アルゴリズムや二進決定図が使用される。遺伝的アルゴリズムやアンネリング最適化を用いた実験も有望な結果を示している。 コストのかかるエンジニアリングプロセスを自動化するために、一部の EDA は、ステートマシンを記述するステートテーブルを受け取り、ステートマシンの組み合わせ論理の真理値表または関数表を自動的に生成する。ステートテーブル は、各ステート、ステート間の遷移を制御する条件、および関連する出力信号を一覧にしたテキストだ。 多くの場合、実際の論理システムは、一連のサブプロジェクトとして設計され、ツールフローを使用して統合される。ツールフローは通常、スクリプト言語と呼 ばれる簡略化されたコンピュータ言語を使用して制御されます。この言語は、ソフトウェア設計ツールを適切な順序で呼び出すことができます。マイクロプロ セッサのような大規模な論理システム向けのツールフローは、数千のコマンドに及ぶことがあり、数百人のエンジニアの作業を統合します。ツールフローの記述 とデバッグは、デジタル設計を生産する企業において確立されたエンジニアリングの専門分野です。ツールフローは通常、論理を物理的に構築する方法を記述し た詳細なコンピュータファイルまたは一連のファイルで終了する。多くの場合、集積回路またはプリント基板上にトランジスタや配線を引く方法に関する指示で 構成される。 ツールフローの一部は、シミュレーションされた論理の出力を期待される入力に対して検証することでデバッグされる。テストツールは、一連の入力と出力を含 むコンピュータファイルを取り込み、シミュレーションされた動作と期待される動作との相違を強調表示する。 入力データが正しいと確認されたら、設計自体の正確性も検証する必要があります。一部のツールフローでは、まず設計を作成し、その設計をスキャンしてツー ルフローに適した入力データを作成することで、設計の正確性を検証します。スキャンしたデータが入力データと一致すれば、ツールフローにエラーは発生して いないと考えられます。 機能検証データは、通常、テストベクトルと呼ばれます。機能テストベクトルは保存しておき、工場で新しく構築したロジックが正しく動作するかどうかをテストするために使用することができる。ただし、機能テスト パターンでは、すべての製造上の欠陥を発見できるわけではない。生産テストは、多くの場合、自動テストパターン生成ソフトウェアツールによって設計され る。これらのツールは、ロジックの構造を調べ、特定の潜在的な欠陥をターゲットとしたテストを体系的に生成して、テストベクトルを生成する。この方法で は、設計が適切にテスト可能になっている場合、欠陥の検出率は 100% に近づけることができる(次のセクションを参照)。 設計が完成し、検証され、テスト可能になった後は、多くの場合、製造可能にするための処理も必要になる。現代の集積回路は、フォトレジストを露光するため に使用される光の波長よりも小さな特徴を持っている。製造可能性のために設計されたソフトウェアは、露光マスクに干渉パターンを追加して、開回路を排除 し、マスクのコントラストを向上させる。 |

| Design for testability There are several reasons for testing a logic circuit. When the circuit is first developed, it is necessary to verify that the design circuit meets the required functional, and timing specifications. When multiple copies of a correctly designed circuit are being manufactured, it is essential to test each copy to ensure that the manufacturing process has not introduced any flaws.[49] A large logic machine (say, with more than a hundred logical variables) can have an astronomical number of possible states. Obviously, factory testing every state of such a machine is unfeasible, for even if testing each state only took a microsecond, there are more possible states than there are microseconds since the universe began! Large logic machines are almost always designed as assemblies of smaller logic machines. To save time, the smaller sub-machines are isolated by permanently installed design for test circuitry and are tested independently. One common testing scheme provides a test mode that forces some part of the logic machine to enter a test cycle. The test cycle usually exercises large independent parts of the machine. Boundary scan is a common test scheme that uses serial communication with external test equipment through one or more shift registers known as scan chains. Serial scans have only one or two wires to carry the data, and minimize the physical size and expense of the infrequently used test logic. After all the test data bits are in place, the design is reconfigured to be in normal mode and one or more clock pulses are applied, to test for faults (e.g. stuck-at low or stuck-at high) and capture the test result into flip-flops or latches in the scan shift register(s). Finally, the result of the test is shifted out to the block boundary and compared against the predicted good machine result. In a board-test environment, serial-to-parallel testing has been formalized as the JTAG standard. |

テスト容易性の設計 論理回路をテストする理由はいくつかあります。回路が最初に開発されたとき、設計回路が要求される機能およびタイミングの仕様を満たしていることを確認す る必要があります。正しく設計された回路を複数製造する場合、製造工程で欠陥が生じていないことを確認するために、各回路をテストすることが不可欠です。 [49] 大規模な論理マシン(たとえば、100 以上の論理変数を持つマシン)は、膨大な数の可能な状態を持つ可能性があります。このようなマシンのすべての状態を工場でテストすることは、明らかに不可 能です。なぜなら、各状態のテストに 1 マイクロ秒しかかからないとしても、宇宙が誕生してから現在までのマイクロ秒の数よりも、可能な状態の数の方がはるかに多いからです。 大規模な論理マシンは、ほぼ常に小さな論理マシンの集合体として設計される。時間を節約するため、小さなサブマシンは、テスト用に永久的に設置された回路 で隔離され、独立してテストされる。一般的なテスト方式の一つは、論理マシンの一部をテストサイクルに強制的に移行させるテストモードを提供する。テスト サイクルは通常、マシンの大規模な独立した部分をテストする。 境界スキャンは、1つまたは複数のシフトレジスタ(スキャンチェーンと呼ばれる)を介して外部テスト機器とシリアル通信を行う一般的なテスト方式だ。シリ アルスキャンはデータ伝送に1本または2本のワイヤしか使用せず、使用頻度の低いテスト論理の物理的なサイズとコストを最小限に抑える。すべてのテスト データビットが配置された後、設計は通常モードに再構成され、1つ以上のクロックパルスが適用され、故障(例:低レベル固定や高レベル固定)を検出し、テ スト結果をスキャンシフトレジスタ内のフリップフロップまたはラッチに保存する。最後に、テスト結果はブロック境界にシフトアウトされ、予測された正常な マシン結果と比較される。 ボードテスト環境では、シリアルからパラレルへのテストはJTAG標準として形式化されている。 |

| Trade-offs Cost Since a digital system may use many logic gates, the overall cost of building a computer correlates strongly with the cost of a logic gate. In the 1930s, the earliest digital logic systems were constructed from telephone relays because these were inexpensive and relatively reliable. The earliest integrated circuits were constructed to save weight and permit the Apollo Guidance Computer to control an inertial guidance system for a spacecraft. The first integrated circuit logic gates cost nearly US$50, which in 2024 would be equivalent to $531. Mass-produced gates on integrated circuits became the least-expensive method to construct digital logic. With the rise of integrated circuits, reducing the absolute number of chips used represented another way to save costs. The goal of a designer is not just to make the simplest circuit, but to keep the component count down. Sometimes this results in more complicated designs with respect to the underlying digital logic but nevertheless reduces the number of components, board size, and even power consumption. Reliability Another major motive for reducing component count on printed circuit boards is to reduce the manufacturing defect rate due to failed soldered connections and increase reliability. Defect and failure rates tend to increase along with the total number of component pins. The failure of a single logic gate may cause a digital machine to fail. Where additional reliability is required, redundant logic can be provided. Redundancy adds cost and power consumption over a non-redundant system. The reliability of a logic gate can be described by its mean time between failure (MTBF). Digital machines first became useful when the MTBF for a switch increased above a few hundred hours. Even so, many of these machines had complex, well-rehearsed repair procedures, and would be nonfunctional for hours because a tube burned-out, or a moth got stuck in a relay. Modern transistorized integrated circuit logic gates have MTBFs greater than 82 billion hours (8.2×1010 h).[50] This level of reliability is required because integrated circuits have so many logic gates. Fan-out Fan-out describes how many logic inputs can be controlled by a single logic output without exceeding the electrical current ratings of the gate outputs.[51] The minimum practical fan-out is about five.[citation needed] Modern electronic logic gates using CMOS transistors for switches have higher fan-outs. Speed The switching speed describes how long it takes a logic output to change from true to false or vice versa. Faster logic can accomplish more operations in less time. Modern electronic digital logic routinely switches at 5 GHz, and some laboratory systems switch at more than 1 THz.[citation needed]. |

トレードオフ コスト デジタルシステムは多くの論理ゲートを使用するため、コンピュータの構築コストは論理ゲートのコストと強く相関する。1930年代、最初のデジタル論理シ ステムは、安価で比較的信頼性が高かった電話リレーを使用して構築された。 最初の集積回路は、重量を軽減し、アポロ宇宙船の慣性誘導システムを制御するアポロ誘導コンピュータを実現するために構築された。最初の集積回路論理ゲー トはほぼUS$50かかり、2024年の価値に換算すると$531に相当する。集積回路上の量産ゲートは、デジタル論理を構築する最も低コストな方法と なった。 集積回路の普及に伴い、使用されるチップの絶対数を減らすこともコスト削減のもう一つの方法となりました。設計者の目標は、単に最もシンプルな回路を作成 することではなく、部品点数を抑えることです。これによって、基盤となるデジタル論理がより複雑になる場合もありますが、それでも部品点数、基板サイズ、 さらには電力消費を削減できます。 信頼性 プリント基板上の部品数を削減するもう一つの主要な動機は、はんだ接合の故障による製造不良率を低減し、信頼性を向上させることだ。不良率と故障率は、部 品のピン数が増加するにつれて増加する傾向がある。 単一の論理ゲートが故障すると、デジタル機器が故障する可能性がある。追加の信頼性が要求される場合、冗長論理を提供することができる。冗長性は、非冗長 システムに比べてコストと電力消費を増加させる。 論理ゲートの信頼性は、平均故障間隔(MTBF)で表すことができる。デジタル機械が実用化されるようになったのは、スイッチのMTBFが数百時間を超え た頃だ。それでも、これらの機械の多くは複雑で熟練した修理手順を必要とし、管が焼けるやリレーに虫が詰まるなどの理由で数時間機能しなくなることがあっ た。現代のトランジスタ化された集積回路の論理ゲートは、MTBF が 820 億時間(8.2×1010 時間)を超えている。[50] 集積回路には非常に多くの論理ゲートが搭載されているため、このレベルの信頼性が必要なんだ。 ファンアウト ファンアウトは、ゲート出力の定格電流を超えずに、1 つの論理出力で制御できる論理入力の数を表す。[51] 実用的な最小ファンアウトは約 5 である。[要出典] CMOS トランジスタをスイッチとして使用する現代の電子論理ゲートは、より高いファンアウトを実現している。 速度 スイッチング速度とは、論理出力が真から偽、またはその逆に変化するのにかかる時間を指す。論理が高速であれば、より短い時間でより多くの操作を実行でき る。現代の電子デジタル論理は、通常 5 GHz でスイッチングを行い、一部の研究室システムでは 1 THz 以上でスイッチングを行っている。[要出典] |

| Logic families Main article: Logic family Digital design started with relay logic which is slow. Occasionally a mechanical failure would occur. Fan-outs were typically about 10, limited by the resistance of the coils and arcing on the contacts from high voltages. Later, vacuum tubes were used. These were very fast, but generated heat, and were unreliable because the filaments would burn out. Fan-outs were typically 5 to 7, limited by the heating from the tubes' current. In the 1950s, special computer tubes were developed with filaments that omitted volatile elements like silicon. These ran for hundreds of thousands of hours. The first semiconductor logic family was resistor–transistor logic. This was a thousand times more reliable than tubes, ran cooler, and used less power, but had a very low fan-out of 3. Diode–transistor logic improved the fan-out up to about 7, and reduced the power. Some DTL designs used two power supplies with alternating layers of NPN and PNP transistors to increase the fan-out. Transistor–transistor logic (TTL) was a great improvement over these. In early devices, fan-out improved to 10, and later variations reliably achieved 20. TTL was also fast, with some variations achieving switching times as low as 20 ns. TTL is still used in some designs. Emitter coupled logic is very fast but uses a lot of power. It was extensively used for high-performance computers, such as the Illiac IV, made up of many medium-scale components. By far, the most common digital integrated circuits built today use CMOS logic, which is fast, offers high circuit density and low power per gate. This is used even in large, fast computers, such as the IBM System z. |

論理ファミリー メイン記事:論理ファミリー デジタル設計は、速度の遅いリレー論理から始まった。機械的な故障が時折発生した。ファンアウトは通常約 10 で、コイルの抵抗と高電圧による接点のアーキングによって制限されていた。 その後、真空管が使用された。これらは非常に高速だったが、発熱しやすく、フィラメントが焼損するため信頼性が低かった。ファンアウトは通常5~7で、真 空管の電流による発熱に制限されていた。1950年代には、シリコンなどの揮発性元素を排除したフィラメントを採用した特殊なコンピュータ用真空管が開発 された。これらは数十万時間動作した。 最初の半導体論理ファミリーは抵抗トランジスタ論理(RTL)だった。これは管の1,000倍の信頼性があり、発熱が少なく、消費電力も少なかったが、 ファンアウトは3と非常に低かった。ダイオードトランジスタ論理(DTL)はファンアウトを約7まで向上させ、消費電力を削減した。一部のDTL設計で は、NPNとPNPトランジスタを交互に配置した2つの電源を使用し、ファンアウトを増加させた。 トランジスタ・トランジスタ論理(TTL)はこれらを大幅に改善した。初期のデバイスではファンアウトが10に改善され、後のバリエーションでは20を安 定して達成した。TTLは高速でもあり、一部のバリエーションではスイッチング時間が20nsまで短縮された。TTLは現在も一部の設計で用いられてい る。 エミッタ結合ロジックは、非常に高速ですが、消費電力が大きいです。これは、多くの中規模部品で構成される Illiac IV などの高性能コンピュータに広く使用されていました。 現在、最も一般的に使用されているデジタル集積回路は、高速で、高い回路密度と低消費電力を実現する CMOS ロジックです。これは、IBM System z などの大型の高速コンピュータにも使用されています。 |

| Recent developments In 2009, researchers discovered that memristors can implement a Boolean state storage and provides a complete logic family with very small amounts of space and power, using familiar CMOS semiconductor processes.[52] The discovery of superconductivity has enabled the development of rapid single flux quantum (RSFQ) circuit technology, which uses Josephson junctions instead of transistors. Most recently, attempts are being made to construct purely optical computing systems capable of processing digital information using nonlinear optical elements. |

最近の進展 2009年、研究者たちは、メムリストがブール状態の記憶を実現し、よく知られたCMOS半導体プロセスを用いて、非常に小さなスペースと電力で完全な論 理ファミリーを提供できることを発見した。[52] 超伝導の発見により、トランジスタの代わりにジョセフソン接合を用いた高速単一磁束量子(RSFQ)回路技術の開発が可能になった。最近では、非線形光学 素子を用いてデジタル情報を処理できる純粋な光計算システムの構築が試みられている。 |

| De Morgan's laws Electronic kit List of open-source hardware projects for electronics Logical effort Logic optimization Microelectronics Oscilloscope Unconventional computing |

デ・モルガンの法則 電子キット 電子機器用のオープンソースハードウェアプロジェクトの一覧 論理的努力 論理最適化 マイクロエレクトロニクス オシロスコープ 非従来型コンピューティング |

| Douglas Lewin, Logical Design of

Switching Circuits, Nelson,1974. R. H. Katz, Contemporary Logic Design, The Benjamin/Cummings Publishing Company, 1994. P. K. Lala, Practical Digital Logic Design and Testing, Prentice Hall, 1996. Y. K. Chan and S. Y. Lim, Progress In Electromagnetics Research B, Vol. 1, 269–290, 2008, "Synthetic Aperture Radar (SAR) Signal Generation, Faculty of Engineering & Technology, Multimedia University, Jalan Ayer Keroh Lama, Bukit Beruang, Melaka 75450, Malaysia. |

Douglas

Lewin、スイッチング回路の論理設計、Nelson、1974年。 R. H. Katz、現代論理設計、The Benjamin/Cummings Publishing Company、1994年。 P. K. Lala、実用デジタル論理設計とテスト、Prentice Hall、1996年。 Y. K. Chan と S. Y. Lim, 進歩する電磁気学研究 B, 第1巻, 269–290, 2008, 「合成開口レーダー(SAR)信号の生成, 工学技術学部, マルチメディア大学, Jalan Ayer Keroh Lama, Bukit Beruang, Melaka 75450, マレーシア. |

| https://en.wikipedia.org/wiki/Digital_electronics |

★情 報技術(information technology)

A

computer lab contains a wide range of information technology elements,

including hardware, software and storage systems./

コンピュータラボには、ハードウェア、ソフトウェア、ストレージシステムなど、さまざまな情報技術要素が含まれています。

| Information

technology (IT) is the study or use of computers, telecommunication

systems and other devices to create, process, store, retrieve and

transmit information.[1] While the term is commonly used to refer to

computers and computer networks, it also encompasses other information

distribution technologies such as television and telephones.

Information technology is an application of computer science and

computer engineering. An information technology system (IT system) is generally an information system, a communications system, or, more specifically speaking, a computer system — including all hardware, software, and peripheral equipment — operated by a limited group of IT users, and an IT project usually refers to the commissioning and implementation of an IT system.[2] IT systems play a vital role in facilitating efficient data management, enhancing communication networks, and supporting organizational processes across various industries. Successful IT projects require meticulous planning and ongoing maintenance to ensure optimal functionality and alignment with organizational objectives.[3] Although humans have been storing, retrieving, manipulating, analysing and communicating information since the earliest writing systems were developed,[4] the term information technology in its modern sense first appeared in a 1958 article published in the Harvard Business Review; authors Harold J. Leavitt and Thomas L. Whisler commented that "the new technology does not yet have a single established name. We shall call it information technology (IT)."[5] Their definition consists of three categories: techniques for processing, the application of statistical and mathematical methods to decision-making, and the simulation of higher-order thinking through computer programs.[5] |

情報技術(IT)とは、コンピュータ、通信システム、その他のデバイス

を使用して、情報の作成、処理、保存、検索、伝送を行うための研究またはその応用を指します。[1]

この用語は一般的にコンピュータやコンピュータネットワークを指すのに使用されますが、テレビや電話などの他の情報配信技術も含まれます。情報技術は、コ

ンピュータ科学とコンピュータ工学の応用分野です。 情報技術システム(ITシステム)は、一般的には情報システム、通信システム、またはより具体的に言えば、コンピュータシステム(ハードウェア、ソフト ウェア、周辺機器を含む)であり、限定されたITユーザーによって運用される。ITプロジェクトは通常、ITシステムの導入と実施を指す。[2] ITシステムは、効率的なデータ管理の促進、通信ネットワークの強化、および多様な業界における組織プロセスの支援において重要な役割を果たしている。成 功したITプロジェクトには、最適な機能と組織の目標との整合性を確保するため、綿密な計画と継続的なメンテナンスが必要だ。[3] 人類は、最も初期の文字体系が開発されて以来、情報の保存、検索、操作、分析、伝達を行ってきましたが[4]、現代的な意味での「情報技術」という用語 は、1958年にハーバード・ビジネス・レビューに掲載された記事で初めて登場しました。著者のハロルド・J・リービットとトーマス・L・ウィスラーは、 「この新しい技術には、まだ確立された単一の名称はない。私たちはこれを情報技術(IT)と呼ぶことにする」と述べた。[5] 彼らの定義は、処理技術、統計的・数学的方法の意思決定への応用、およびコンピュータプログラムによる高次思考のシミュレーションの3つのカテゴリーから 成る。[5] |

| History Main article: History of computing hardware  Antikythera mechanism, considered the first mechanical analog computer, dating back to the first century BC. Based on the storage and processing technologies employed, it is possible to distinguish four distinct phases of IT development: pre-mechanical (3000 BC – 1450 AD), mechanical (1450 – 1840), electromechanical (1840 – 1940), and electronic (1940 to present).[4] Ideas of computer science were first mentioned before the 1950s under the Massachusetts Institute of Technology (MIT) and Harvard University, where they had discussed and began thinking of computer circuits and numerical calculations. As time went on, the field of information technology and computer science became more complex and was able to handle the processing of more data. Scholarly articles began to be published from different organizations.[6] During the early computing, Alan Turing, J. Presper Eckert, and John Mauchly were considered some of the major pioneers of computer technology in the mid-1900s. Giving them such credit for their developments, most of their efforts were focused on designing the first digital computer. Along with that, topics such as artificial intelligence began to be brought up as Turing was beginning to question such technology of the time period.[7] Devices have been used to aid computation for thousands of years, probably initially in the form of a tally stick.[8] The Antikythera mechanism, dating from about the beginning of the first century BC, is generally considered the earliest known mechanical analog computer, and the earliest known geared mechanism.[9] Comparable geared devices did not emerge in Europe until the 16th century, and it was not until 1645 that the first mechanical calculator capable of performing the four basic arithmetical operations was developed.[10]  Zuse Z3 replica on display at Deutsches Museum in Munich. The Zuse Z3 is the first programmable computer. Electronic computers, using either relays or thermionic valves, began to appear in the early 1940s. The electromechanical Zuse Z3, completed in 1941, was the world's first programmable computer, and by modern standards one of the first machines that could be considered a complete computing machine. During the Second World War, Colossus developed the first electronic digital computer to decrypt German messages. Although it was programmable, it was not general-purpose, being designed to perform only a single task. It also lacked the ability to store its program in memory; programming was carried out using plugs and switches to alter the internal wiring.[11] The first recognizably modern electronic digital stored-program computer was the Manchester Baby, which ran its first program on 21 June 1948.[12] The development of transistors in the late 1940s at Bell Laboratories allowed a new generation of computers to be designed with greatly reduced power consumption. The first commercially available stored-program computer, the Ferranti Mark I, contained 4050 valves and had a power consumption of 25 kilowatts. By comparison, the first transistorized computer developed at the University of Manchester and operational by November 1953, consumed only 150 watts in its final version.[13] Several other breakthroughs in semiconductor technology include the integrated circuit (IC) invented by Jack Kilby at Texas Instruments and Robert Noyce at Fairchild Semiconductor in 1959, silicon dioxide surface passivation by Carl Frosch and Lincoln Derick in 1955,[14] the first planar silicon dioxide transistors by Frosch and Derick in 1957,[15] the MOSFET demonstration by a Bell Labs team,[16][17][18][19] the planar process by Jean Hoerni in 1959,[20][21][22] and the microprocessor invented by Ted Hoff, Federico Faggin, Masatoshi Shima, and Stanley Mazor at Intel in 1971. These important inventions led to the development of the personal computer (PC) in the 1970s, and the emergence of information and communications technology (ICT).[23] By 1984, according to the National Westminster Bank Quarterly Review, the term information technology had been redefined as "the convergence of telecommunications and computing technology (...generally known in Britain as information technology)." We then begin to see the appearance of the term in 1990 contained within documents for the International Organization for Standardization (ISO).[24] Innovations in technology have already revolutionized the world by the twenty-first century as people have gained access to different online services. This has changed the workforce drastically as thirty percent of U.S. workers were already in careers in this profession. 136.9 million people were personally connected to the Internet, which was equivalent to 51 million households.[25] Along with the Internet, new types of technology were also being introduced across the globe, which has improved efficiency and made things easier across the globe. As technology revolutionized society, millions of processes could be completed in seconds. Innovations in communication were crucial as people increasingly relied on computers to communicate via telephone lines and cable networks. The introduction of the email was considered revolutionary as "companies in one part of the world could communicate by e-mail with suppliers and buyers in another part of the world...".[26] Not only personally, computers and technology have also revolutionized the marketing industry, resulting in more buyers of their products. In 2002, Americans exceeded $28 billion in goods just over the Internet alone while e-commerce a decade later resulted in $289 billion in sales.[26] And as computers are rapidly becoming more sophisticated by the day, they are becoming more used as people are becoming more reliant on them during the twenty-first century. |

歴史 主な記事:コンピュータハードウェアの歴史  紀元前1世紀にさかのぼる、最初の機械式アナログコンピュータとされるアンティキティラ装置 採用された記憶と処理の技術に基づいて、ITの発展は4つの異なる段階に区分することができる:前機械式(紀元前3000年~1450年)、機械式 (1450年~1840年)、電気機械式(1840年~1940年)、電子式(1940年~現在)。[4] コンピュータサイエンスの概念は、1950年代以前にマサチューセッツ工科大学(MIT)およびハーバード大学で、コンピュータの回路や数値計算について 議論され、考えられ始めた。時が経つにつれて、情報技術およびコンピュータサイエンスの分野はより複雑になり、より多くのデータの処理が可能になった。さ まざまな組織から学術論文が発表されるようになった。[6] コンピュータの初期には、アラン・チューリング、J・プレスパー・エッカート、ジョン・モークリーが、1900年代半ばのコンピュータ技術の主要な先駆者 たちとして知られていた。彼らの開発に対するこのような評価は、その努力の大部分が最初のデジタルコンピュータの設計に集中していたことからも理解でき る。それに伴い、チューリングが当時の技術に疑問を抱き始めたことで、人工知能などのトピックも取り上げられるようになった。[7] 計算を支援する装置は、おそらくは数千年前から、おそらくは数え棒のような形で使用されてきた。紀元前1世紀初頭頃に作られたアンティキティラ機構は、一 般的に、最古の機械式アナログコンピュータ、および最古の歯車機構とみなされている。[9] 同様の歯車装置は、16 世紀になってようやくヨーロッパに登場し、4 つの基本的な算術演算が可能な最初の機械式計算機が開発されたのは 1645 年のことだった。[10]  ミュンヘンのドイツ博物館に展示されている Zuse Z3 のレプリカ。Zuse Z3 は、最初のプログラム可能なコンピュータ リレーまたは熱電子管を使用した電子コンピュータは、1940年代初頭に登場し始めた。1941年に完成した電気機械式のZuse Z3は、世界初のプログラム可能なコンピュータであり、現代の基準では、完全な計算機として考えられる最初の機械の一つである。第二次世界大戦中、 Colossusはドイツのメッセージを解読するための最初の電子デジタルコンピュータを開発した。これはプログラム可能でしたが、単一のタスクのみを実 行するように設計されていたため、汎用機ではありませんでした。また、プログラムをメモリに保存する機能も備わっておらず、内部配線を変更するプラグとス イッチを使用してプログラミングが行われていました[11]。現代的な電子デジタル記憶プログラム式コンピュータとして初めて認識されたのは、1948年 6月21日に最初のプログラムを実行したマンチェスター・ベイビーでした。[12] 1940年代後半、ベル研究所でトランジスタが開発されたことで、消費電力が大幅に削減された新世代のコンピュータの設計が可能になった。最初に市販され た記憶プログラム式コンピュータであるフェランティ・マーク I は、4050 個の真空管を搭載し、消費電力は 25 キロワットだった。これに対し、マンチェスター大学で開発され、1953 年 11 月に稼働した最初のトランジスタ式コンピュータは、最終バージョンでは消費電力はわずか 150 ワットだった。[13] 半導体技術におけるその他の画期的な進歩としては、1959 年にテキサス・インスツルメンツのジャック・キルビーとフェアチャイルド・セミコンダクターのロバート・ノイスによって発明された集積回路 (IC)、1955 年にカール・フロッシュとリンカーン・デリックによって発明された二酸化ケイ素表面パッシベーション[14]、1957 年にフロッシュとデリックによって発明された最初の平面型二酸化ケイ素トランジスタ、[15] ベル研究所チームによる MOSFET の実証[16][17][18][19]、1959 年にジャン・ホーニによって開発された平面プロセス[20][21][22]、1971 年にインテル社のテッド・ホフ、フェデリコ・ファギン、島正敏、スタンリー・マゾールによって発明されたマイクロプロセッサなどがある。これらの重要な発 明により、1970年代にはパーソナルコンピュータ(PC)が開発され、情報通信技術(ICT)が登場した。[23] 1984年までに、ナショナル・ウェストミンスター銀行の四半期報告書によると、情報技術という用語は「電気通信とコンピュータ技術の融合(...英国で は一般に情報技術として知られている)」と再定義された。その後、1990年に国際標準化機構(ISO)の文書にこの用語が登場し始めた。[24] 21世紀に入り、人々はさまざまなオンラインサービスを利用できるようになり、技術の革新はすでに世界に変革をもたらしている。これにより、労働力も大き く変化し、米国の労働者の 30% はすでにこの職業に就いていた。1 億 3,690 万人、つまり 5,100 万世帯がインターネットに接続していた[25]。インターネットとともに、新しいタイプのテクノロジーも世界中に導入され、効率が向上し、世界中で物事が 容易になった。 テクノロジーが社会に革命をもたらし、何百万ものプロセスが数秒で完了するようになりました。人々が電話回線やケーブルネットワークを介してコミュニケー ションを行うためにコンピュータへの依存度が高まったため、コミュニケーションの革新は極めて重要でした。電子メールの導入は、「世界のある地域の企業 が、世界の別の地域のサプライヤーやバイヤーと電子メールでコミュニケーションできるようになった」という点で、革命的な出来事とみなされました。 [26] コンピュータとテクノロジーは、個人だけでなく、マーケティング業界にも革命をもたらし、製品の購入者を増やした。2002 年、アメリカ人はインターネットだけで 280 億ドルの商品を販売し、10 年後の電子商取引の売上高は 2,890 億ドルに達した。[26] また、コンピュータは日々急速に進歩し、21 世紀には人々がコンピュータへの依存度が高まっているため、その利用もますます拡大している。 |

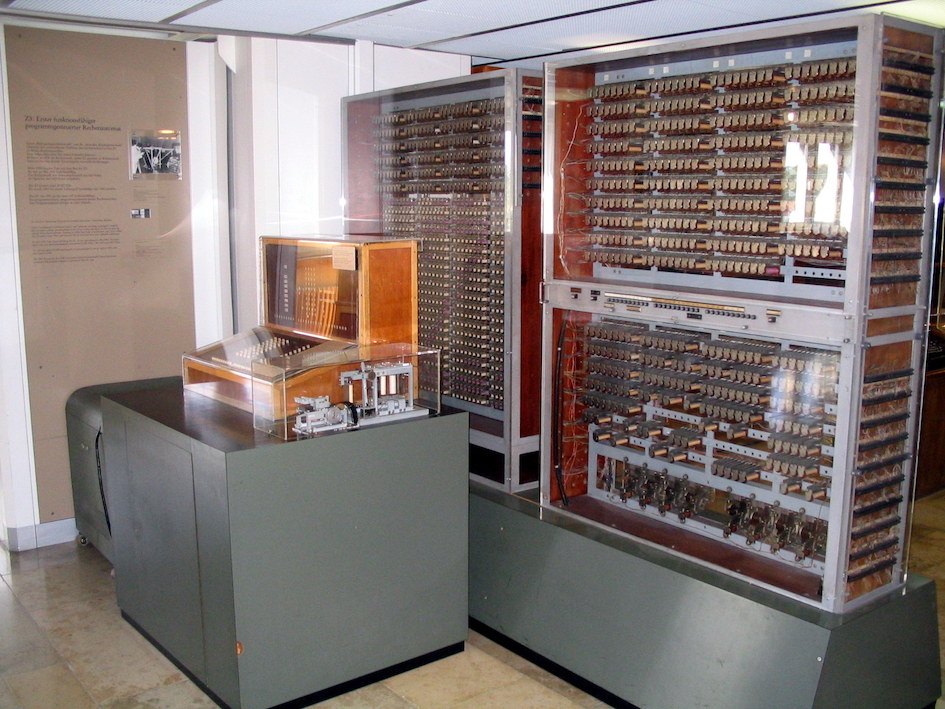

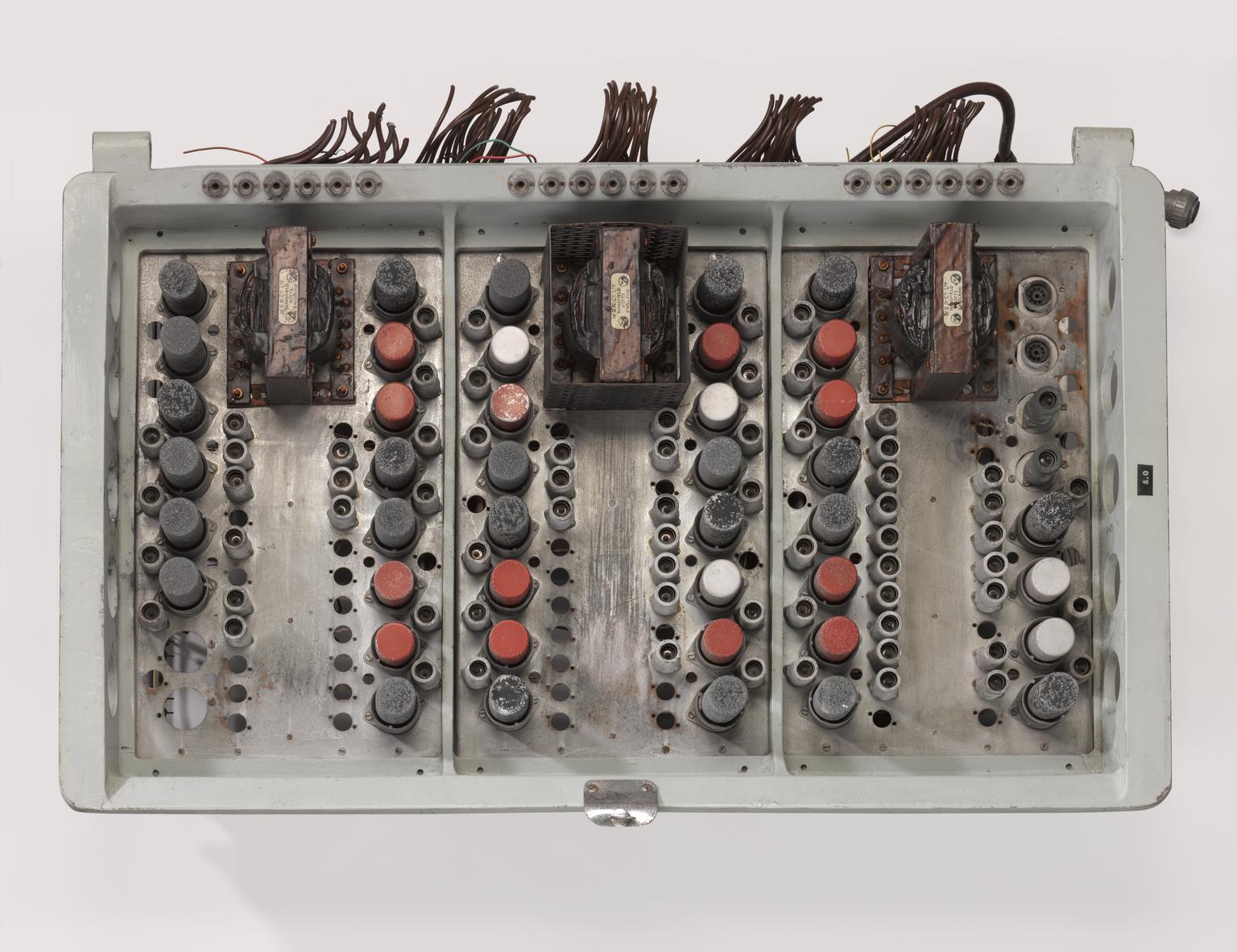

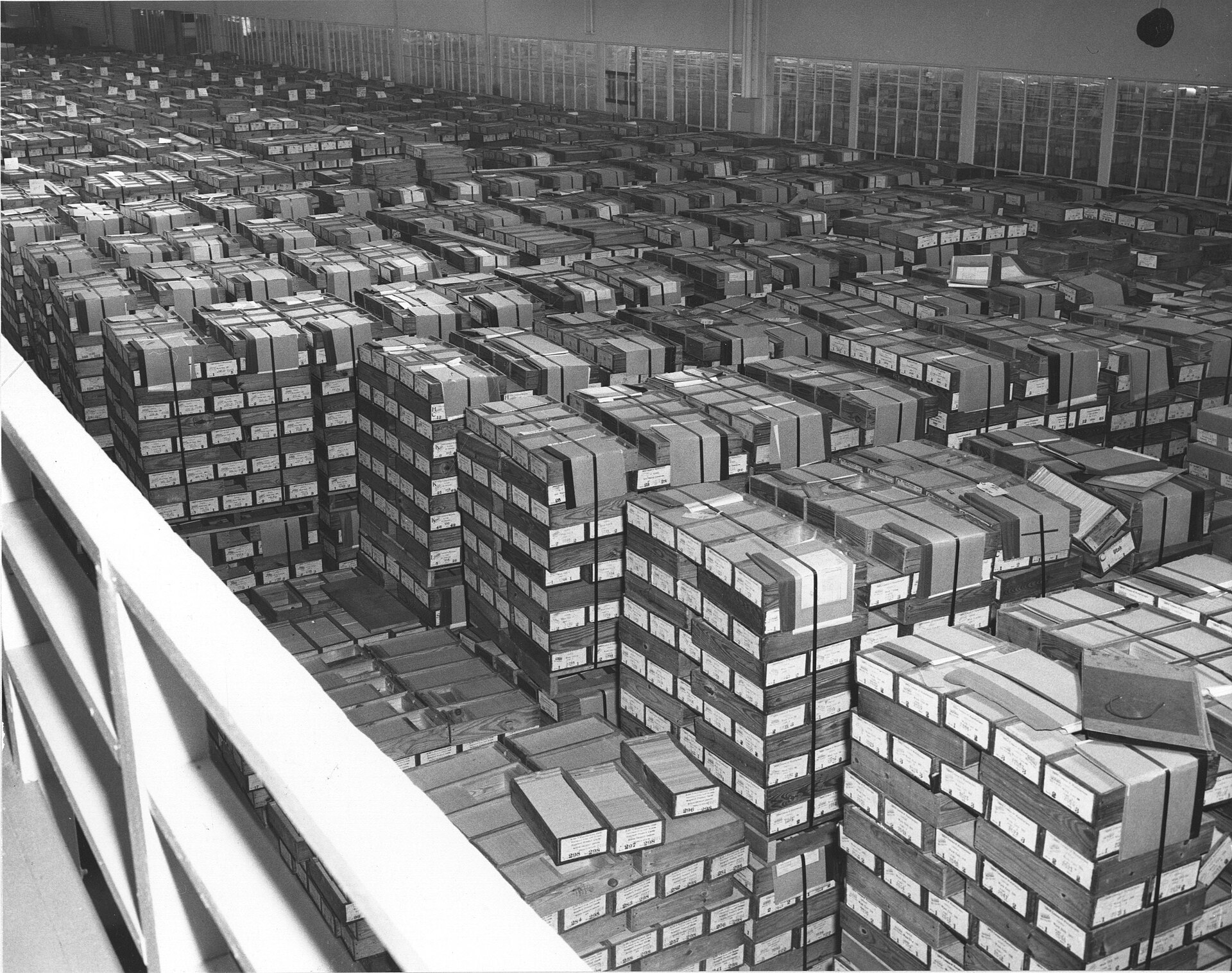

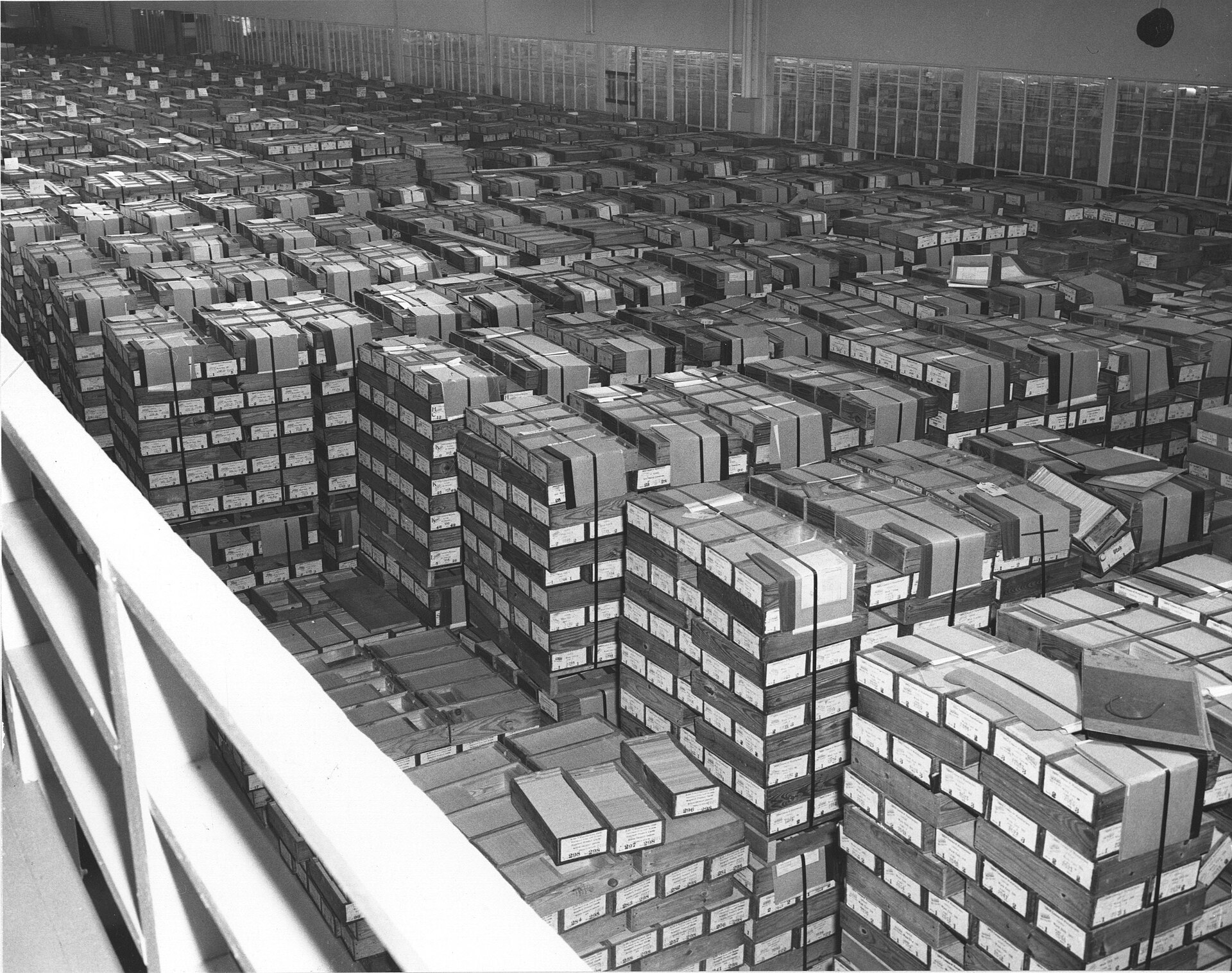

| Data processing Main article: Electronic data processing  Ferranti Mark I computer logic board Electronic data processing or business information processing can refer to the use of automated methods to process commercial data. Typically, this uses relatively simple, repetitive activities to process large volumes of similar information. For example: stock updates applied to an inventory, banking transactions applied to account and customer master files, booking and ticketing transactions to an airline's reservation system, billing for utility services. The modifier "electronic" or "automatic" was used with "data processing" (DP), especially c. 1960, to distinguish human clerical data processing from that done by computer.[27][28] Storage  Punched tapes were used in early computers to store and represent data. Main article: Data storage Early electronic computers such as Colossus made use of punched tape, a long strip of paper on which data was represented by a series of holes, a technology now obsolete.[29] Electronic data storage, which is used in modern computers, dates from World War II, when a form of delay-line memory was developed to remove the clutter from radar signals, the first practical application of which was the mercury delay line.[30] The first random-access digital storage device was the Williams tube, which was based on a standard cathode ray tube.[31] However, the information stored in it and delay-line memory was volatile in the fact that it had to be continuously refreshed, and thus was lost once power was removed. The earliest form of non-volatile computer storage was the magnetic drum, invented in 1932[32] and used in the Ferranti Mark 1, the world's first commercially available general-purpose electronic computer.[33]  IBM card storage warehouse located in Alexandria, Virginia in 1959. This is where the United States government kept storage of punched cards. IBM introduced the first hard disk drive in 1956, as a component of their 305 RAMAC computer system.[34]: 6 Most digital data today is still stored magnetically on hard disks, or optically on media such as CD-ROMs.[35]: 4–5 Until 2002 most information was stored on analog devices, but that year digital storage capacity exceeded analog for the first time. As of 2007, almost 94% of the data stored worldwide was held digitally:[36] 52% on hard disks, 28% on optical devices, and 11% on digital magnetic tape. It has been estimated that the worldwide capacity to store information on electronic devices grew from less than 3 exabytes in 1986 to 295 exabytes in 2007,[37] doubling roughly every 3 years.[38] Databases Main article: Database Database Management Systems (DMS) emerged in the 1960s to address the problem of storing and retrieving large amounts of data accurately and quickly. An early such system was IBM's Information Management System (IMS),[39] which is still widely deployed more than 50 years later.[40] IMS stores data hierarchically,[39] but in the 1970s Ted Codd proposed an alternative relational storage model based on set theory and predicate logic and the familiar concepts of tables, rows, and columns. In 1981, the first commercially available relational database management system (RDBMS) was released by Oracle.[41] All DMS consist of components; they allow the data they store to be accessed simultaneously by many users while maintaining its integrity.[42] All databases are common in one point that the structure of the data they contain is defined and stored separately from the data itself, in a database schema.[39] In the late 2000s (decade), the extensible markup language (XML) has become a popular format for data representation. Although XML data can be stored in normal file systems, it is commonly held in relational databases to take advantage of their "robust implementation verified by years of both theoretical and practical effort."[43] As an evolution of the Standard Generalized Markup Language (SGML), XML's text-based structure offers the advantage of being both machine- and human-readable.[44] |

データ処理 主な記事:電子データ処理  フェランティ・マーク I コンピュータのロジックボード 電子データ処理またはビジネス情報処理とは、商業データを処理するための自動化された手法の使用を指す。通常、これは比較的単純で反復的な作業を用いて、 大量の類似した情報を処理する。例としては、在庫に適用される在庫更新、口座および顧客マスターファイルに適用される銀行取引、航空会社の予約システムに 適用される予約および発券取引、公共料金の請求などが挙げられる。修飾語「電子」または「自動」は、特に 1960 年頃、「データ処理」(DP)と組み合わせて、人間による事務的なデータ処理とコンピュータによるデータ処理を区別するために使用された。[27] [28] ストレージ  パンチテープは、初期のコンピュータでデータを保存および表現するために使用されていた メイン記事:データストレージ Colossusのような初期の電子コンピュータでは、データが穴の列で表された長い紙の帯であるパンチテープが使用されていたが、この技術は現在では廃 れている。[29] 現代のコンピュータで使用されている電子データストレージは、レーダー信号の雑音を排除するために開発された遅延線メモリの一種が第二次世界大戦中に開発 されたことに遡る。その最初の実用的な応用例は水銀遅延線だった。[30] 最初のランダムアクセスデジタルストレージデバイスは、標準的な陰極線管を基にしたウィリアムズ管だった。[31] しかし、これと遅延線メモリに保存された情報は、電源を切ると失われるという揮発性があった。不揮発性コンピュータ記憶装置の最も初期の形態は、1932 年に発明された磁気ドラムで[32]、世界初の市販汎用電子コンピュータであるフェランティ・マーク1に使用された[33]。  1959年にバージニア州アレクサンドリアにあったIBMのカード記憶倉庫。ここは、米国政府がパンチカードを保管していた場所だ IBMは1956年に、305 RAMACコンピュータシステムのコンポーネントとして最初のハードディスクドライブを発売した[34]: 6。現在、デジタルデータのほとんどは、ハー ドディスクに磁気的に、またはCD-ROMなどの光メディアに光学的に保存されている。[35]: 4–5 2002年まで、ほとんどの情報はアナログデバイスに保存されていましたが、その年にデジタルストレージ容量がアナログを初めて上回りました。2007年 時点で、世界中で保存されているデータの約94%がデジタル形式で保存されており、[36] 52%がハードディスク、28%が光学デバイス、11%がデジタル磁気テープに保存されています。電子デバイスに保存できる情報容量は、1986年の3エ クサバイト未満から2007年には295エクサバイトに増加したと推定されており[37]、約3年ごとに倍増している。[38] データベース 主な記事:データベース データベース管理システム(DMS)は、大量のデータを正確かつ迅速に保存および検索するという問題に対処するために、1960年代に登場した。初期のシ ステムとしては、IBM の情報管理システム(IMS)[39] が挙げられ、50年以上経った現在も広く採用されている。[40] IMSはデータを階層的に格納するが、1970年代にテッド・コッドは集合論と述語論理、およびテーブル、行、列といった馴染みのある概念に基づく代替の 関数型ストレージモデルを提案した。1981年、オラクルにより最初の商用関係データベース管理システム(RDBMS)がリリースされた。[41] すべての DMS はコンポーネントで構成されており、その整合性を維持しながら、保存されているデータに多くのユーザーが同時にアクセスできるようにする。[42] すべてのデータベースは、その構造がデータ自体とは別にデータベーススキーマとして定義され、保存されているという点で共通している。[39] 2000年代後半(10年間)には、拡張マークアップ言語(XML)がデータ表現の一般的な形式として普及した。XMLデータは通常のファイルシステムに 保存できるが、関係データベースに保存されることが一般的で、その「理論的・実践的な努力によって長年検証された堅牢な実装」の利点を活用している。 [43] 標準汎用マークアップ言語(SGML)の進化形である XML のテキストベースの構造は、機械と人間の両方が読み取れるという利点がある。[44] |

Transmission Radio towers at Pine Hill lookout Data transmission has three aspects: transmission, propagation, and reception.[45] It can be broadly categorized as broadcasting, in which information is transmitted unidirectionally downstream, or telecommunications, with bidirectional upstream and downstream channels.[37] XML has been increasingly employed as a means of data interchange since the early 2000s,[46] particularly for machine-oriented interactions such as those involved in web-oriented protocols such as SOAP,[44] describing "data-in-transit rather than... data-at-rest".[46] Manipulation Hilbert and Lopez identify the exponential pace of technological change (a kind of Moore's law): machines' application-specific capacity to compute information per capita roughly doubled every 14 months between 1986 and 2007; the per capita capacity of the world's general-purpose computers doubled every 18 months during the same two decades; the global telecommunication capacity per capita doubled every 34 months; the world's storage capacity per capita required roughly 40 months to double (every 3 years); and per capita broadcast information has doubled every 12.3 years.[37] Massive amounts of data are stored worldwide every day, but unless it can be analyzed and presented effectively it essentially resides in what have been called data tombs: "data archives that are seldom visited".[47] To address that issue, the field of data mining — "the process of discovering interesting patterns and knowledge from large amounts of data"[48] — emerged in the late 1980s.[49] |

伝送 パインヒル展望台のラジオ塔 データ伝送には、伝送、伝搬、受信の 3 つの側面がある。[45] これは、情報が一方向の下流に伝送される放送と、双方向の上流と下流のチャネルを持つ通信に大別できる。[37] XML は、2000 年代初頭からデータ交換の手段としてますます採用されるようになっており[46]、特に SOAP などのウェブ指向のプロトコルに関連する、機械指向の相互作用に多く使用されている。これは、「保存されているデータではなく、転送中のデータ」を表すも のである[46]。 操作 ヒルベルトとロペスは、技術変化の指数関数的ペース(一種のムーアの法則)を指摘している:1986年から2007年までの間、1人当たりの情報処理能力 は、アプリケーション特化型マシンで概ね14ヶ月ごとに倍増した;同じ20年間で、世界全体の汎用コンピュータの1人当たり処理能力は18ヶ月ごとに倍増 した;世界全体の通信容量は1人当たり34ヶ月ごとに倍増した; 世界の人口当たりストレージ容量は、約40ヶ月(3年ごと)で倍増し、人口当たり放送情報は12.3年ごとに倍増した。[37] 世界中で毎日莫大な量のデータが保存されていますが、効果的に分析され提示されない限り、それらは「データ墓場」と呼ばれる「ほとんど訪問されないデータ アーカイブ」に存在しているに過ぎません。[47] この問題に対処するため、1980年代後半に「大量のデータから興味深いパターンや知識を発見するプロセス」[48] であるデータマイニングの分野が誕生しました。[49] |

Services A woman sending an email at an internet cafe's public computer. The technology and services IT provides for sending and receiving electronic messages (called "letters" or "electronic letters") over a distributed (including global) computer network. In terms of the composition of elements and the principle of operation, electronic mail practically repeats the system of regular (paper) mail, borrowing both terms (mail, letter, envelope, attachment, box, delivery, and others) and characteristic features — ease of use, message transmission delays, sufficient reliability and at the same time no guarantee of delivery. The advantages of e-mail are: easily perceived and remembered by a person addresses of the form user_name@domain_name (for example, somebody@example.com); the ability to transfer both plain text and formatted, as well as arbitrary files; independence of servers (in the general case, they address each other directly); sufficiently high reliability of message delivery; ease of use by humans and programs. The disadvantages of e-mail include: the presence of such a phenomenon as spam (massive advertising and viral mailings); the theoretical impossibility of guaranteed delivery of a particular letter; possible delays in message delivery (up to several days); limits on the size of one message and on the total size of messages in the mailbox (personal for users). Search system A search system is software and hardware complex with a web interface that provides the ability to look for information on the Internet. A search engine usually means a site that hosts the interface (front-end) of the system. The software part of a search engine is a search engine (search engine) — a set of programs that provides the functionality of a search engine and is usually a trade secret of the search engine developer company. Most search engines look for information on World Wide Web sites, but there are also systems that can look for files on FTP servers, items in online stores, and information on Usenet newsgroups. Improving search is one of the priorities of the modern Internet (see the Deep Web article about the main problems in the work of search engines). |

サービス 電子メール  インターネットカフェの公衆用コンピュータで電子メールを送る女性 分散型(グローバルを含む)コンピュータネットワークを介して電子メッセージ(「手紙」または「電子手紙」と呼ばれる)を送受信するための、IT が提供する技術およびサービス。構成要素と動作原理の点では、電子メールは通常の(紙の)郵便システムをほぼ再現しており、用語(メール、手紙、封筒、添 付ファイル、箱、配達など)と特徴的な機能(使いやすさ、メッセージの送信遅延、十分な信頼性、ただし配達保証はない)を借用している。電子メールの利点 は、user_name@domain_name(例:somebody@example.com)という形式のアドレスが、人間にとって認識しやすく覚 えやすいこと、プレーンテキストとフォーマットされたテキスト、および任意のファイルの両方を転送できること、サーバーの独立性(通常、サーバーは相互に 直接通信する)、メッセージの配信の信頼性が十分に高いこと、人間およびプログラムによる使いやすさ、などだ。 電子メールのデメリットとしては、スパム(大量の広告やウイルスメール)などの現象の存在、特定の手紙の配信を保証することが理論的に不可能、メッセージ の配信遅延(数日程度)、1 つのメッセージのサイズおよびメールボックスのメッセージの合計サイズに制限がある(ユーザーごとに個人用)などが挙げられる。 検索システム 検索システムは、ウェブインターフェースを備えたソフトウェアとハードウェアの複合体で、インターネット上の情報を検索する機能を提供する。検索エンジン は通常、システムのインターフェース(フロントエンド)をホストするサイトを指す。検索エンジンのソフトウェア部分は検索エンジン(検索エンジン)であ り、検索エンジンの機能を提供するプログラムの集合体で、通常は検索エンジン開発企業の企業秘密となっている。ほとんどの検索エンジンはワールドワイド ウェブ(WWW)のウェブサイトから情報を検索するが、FTPサーバー上のファイル、オンラインストアの商品、Usenetニュースグループの情報などを 検索できるシステムも存在する。検索の改善は現代のインターネットの優先課題の一つである(検索エンジンの動作における主要な問題については「ディープ ウェブ」の記事を参照)。 |

| Commercial effects Companies in the information technology field are often discussed as a group as the "tech sector" or the "tech industry."[50][51][52] These titles can be misleading at times and should not be mistaken for "tech companies," which are generally large scale, for-profit corporations that sell consumer technology and software. From a business perspective, information technology departments are a "cost center" the majority of the time. A cost center is a department or staff which incurs expenses, or "costs," within a company rather than generating profits or revenue streams. Modern businesses rely heavily on technology for their day-to-day operations, so the expenses delegated to cover technology that facilitates business in a more efficient manner are usually seen as "just the cost of doing business." IT departments are allocated funds by senior leadership and must attempt to achieve the desired deliverables while staying within that budget. Government and the private sector might have different funding mechanisms, but the principles are more or less the same. This is an often overlooked reason for the rapid interest in automation and artificial intelligence, but the constant pressure to do more with less is opening the door for automation to take control of at least some minor operations in large companies. Many companies now have IT departments for managing the computers, networks, and other technical areas of their businesses. Companies have also sought to integrate IT with business outcomes and decision-making through a BizOps or business operations department.[53] In a business context, the Information Technology Association of America has defined information technology as "the study, design, development, application, implementation, support, or management of computer-based information systems".[54][page needed] The responsibilities of those working in the field include network administration, software development and installation, and the planning and management of an organization's technology life cycle, by which hardware and software are maintained, upgraded, and replaced. |

商業的影響 情報技術分野の企業は、しばしば「テクノロジーセクター」や「テクノロジー産業」として一括りに議論される。[50][51][52] これらの呼称は誤解を招く場合があり、「テクノロジー企業」と混同してはならない。テクノロジー企業とは、一般に大規模な営利企業で、消費者向けテクノロ ジーやソフトウェアを販売する企業を指す。ビジネス視点では、情報技術部門はほとんどの場合「コストセンター」に分類される。コストセンターとは、企業内 で費用(コスト)を発生させる部門や従業員を指し、利益や収益を生み出さない部門だ。現代の企業は、日々の業務においてテクノロジーに大きく依存している ため、ビジネスをより効率的に推進するためのテクノロジーに割り当てられる費用は、通常「事業運営上の費用」とみなされる。IT 部門は、経営陣から予算を割り当てられ、その予算の範囲内で望ましい成果を達成しなければならない。政府と民間企業では資金調達メカニズムは異なるかもし れないが、その原則はほぼ同じだ。これは、自動化と人工知能への関心が高まっている理由として見過ごされがちな要因だけど、少ないリソースでより多くの成 果を上げるという絶え間ないプレッシャーが、大企業において少なくとも一部の minor operations を自動化に委ねる道を開いているんだ。 現在、多くの企業は、コンピュータ、ネットワーク、その他の技術分野を管理するための IT 部門を設置している。また、BizOps(ビジネスオペレーション)部門やビジネスオペレーション部門を通じて、IT をビジネス成果や意思決定に統合しようとしている企業も多い。[53] ビジネス文脈において、アメリカ情報技術協会(ITAA)は情報技術を「コンピュータベースの情報システムの研究、設計、開発、応用、実装、サポート、ま たは管理」と定義している。[54][ページ番号必要] この分野で働く人々の責任には、ネットワーク管理、ソフトウェア開発とインストール、および組織のテクノロジーライフサイクルの計画と管理が含まれる。こ れにより、ハードウェアとソフトウェアの維持、アップグレード、および交換が実施される。 |

| Information services Information services is a term somewhat loosely applied to a variety of IT-related services offered by commercial companies,[55][56][57] as well as data brokers. U.S. Employment distribution of computer systems design and related services, 2011[58] U.S. Employment distribution of computer systems design and related services, 2011[58] U.S. Employment in the computer systems and design related services industry, in thousands, 1990–2011[58] U.S. Employment in the computer systems and design related services industry, in thousands, 1990–2011[58] U.S. Occupational growth and wages in computer systems design and related services, 2010–2020[58] U.S. Occupational growth and wages in computer systems design and related services, 2010–2020[58] U.S. projected percent change in employment in selected occupations in computer systems design and related services, 2010–2020[58] U.S. projected percent change in employment in selected occupations in computer systems design and related services, 2010–2020[58] U.S. projected average annual percent change in output and employment in selected industries, 2010–2020[58] U.S. projected average annual percent change in output and employment in selected industries, 2010–2020[58] |

情報サービス 情報サービスとは、商業企業[55][56][57]やデータブローカーが提供するさまざまな IT 関連サービスを総称する用語です。 2011 年の米国におけるコンピュータシステム設計および関連サービスの雇用分布[58] 2011年のコンピュータシステム設計および関連サービスの米国雇用分布[58] 1990年から2011年のコンピュータシステムおよび設計関連サービス業界における米国の雇用(千人単位)[58] コンピュータシステムおよび設計関連サービス業界における米国の雇用、1990年から2011年[58] コンピュータシステム設計および関連サービスにおける米国の職業の成長と賃金、2010年から2020年[58] コンピュータシステム設計および関連サービスにおける米国の職業の成長と賃金、2010年から2020年[58] 2010年から2020年までの、コンピュータシステム設計および関連サービスにおける特定の職業の雇用予測変化率(米国)[58] 2010年から2020年までの、コンピュータシステム設計および関連サービスにおける特定の職業の雇用予測変化率(米国)[58] 米国における 2010 年から 2020 年までの、選定産業の生産高および雇用の平均年間変化率予測[58] 米国における 2010 年から 2020 年までの、選定産業の生産高および雇用の平均年間変化率予測[58] |

| Ethics Main article: Information ethics The field of information ethics was established by mathematician Norbert Wiener in the 1940s.[59]: 9 Some of the ethical issues associated with the use of information technology include:[60]: 20–21 Breaches of copyright by those downloading files stored without the permission of the copyright holders Employers monitoring their employees' emails and other Internet usage Unsolicited emails Hackers accessing online databases Web sites installing cookies or spyware to monitor a user's online activities, which may be used by data brokers |

倫理 主な記事:情報倫理 情報倫理の分野は、1940年代に数学者ノーバート・ウィーナーによって確立された[59]: 9。情報技術の利用に関連する倫理的問題には、次のような ものがある[60]: 20–21 著作権者の許可なく保存されたファイルをダウンロードする行為による著作権侵害 雇用主が従業員のメールやその他のインターネット利用を監視する行為 迷惑メール ハッカーがオンラインデータベースにアクセスする行為 ユーザーのオンライン活動を監視するためにクッキーやスパイウェアをインストールするウェブサイト(これらの情報はデータブローカーによって利用される可 能性がある) |

| IT projects Research suggests that IT projects in business and public administration can easily become significant in scale. Research conducted by McKinsey in collaboration with the University of Oxford suggested that half of all large-scale IT projects (those with initial cost estimates of $15 million or more) often failed to maintain costs within their initial budgets or to complete on time.[61] |

IT プロジェクト 研究によると、ビジネスや行政における IT プロジェクトは、容易に大規模になる可能性があることが示唆されています。マッキンゼーがオックスフォード大学と共同で実施した調査によると、大規模 IT プロジェクト(初期費用見積額が 1,500 万ドル以上のプロジェクト)の半分は、初期予算内のコストを維持できなかったり、予定通りに完了できなかったりすることが多いと報告されています。 [61] |

| Information and communications

technology (ICT) IT infrastructure Outline of information technology Knowledge society |

情報通信技術(ICT) IT インフラ 情報技術の概要 知識社会 |