確証バイアス

Confirmation bias

☆ 確証バイアス(confirmation bias、確認バイアス、myside bias、またはcongeniality bias)とは、自分の以前の信念や価値観を肯定または支持するような方法で情報を探し、解釈し、支持し、思い出す傾向のことである。人々 は、自分の見解を支持する情報を選択し、反対の情報は無視したり、曖昧な証拠を自分の既存の態度を支持するものとして解釈したりするときに、このバイアス を示す。この効果は、望ましい結果、感情的な問題、そして根強く定着した信念に対して最も強く現れる。

| Confirmation bias

(also confirmatory bias, myside bias,[a] or congeniality bias[2]) is

the tendency to search for, interpret, favor, and recall information in

a way that confirms or supports one's prior beliefs or values.[3]

People display this bias when they select information that supports

their views, ignoring contrary information, or when they interpret

ambiguous evidence as supporting their existing attitudes. The effect

is strongest for desired outcomes, for emotionally charged issues, and

for deeply entrenched beliefs. Biased search for information, biased interpretation of this information, and biased memory recall, have been invoked to explain four specific effects: 1. attitude polarization (when a disagreement becomes more extreme even though the different parties are exposed to the same evidence) 2. belief perseverance (when beliefs persist after the evidence for them is shown to be false) 3. the irrational primacy effect (a greater reliance on information encountered early in a series) 4. illusory correlation (when people falsely perceive an association between two events or situations). A series of psychological experiments in the 1960s suggested that people are biased toward confirming their existing beliefs. Later work re-interpreted these results as a tendency to test ideas in a one-sided way, focusing on one possibility and ignoring alternatives. Explanations for the observed biases include wishful thinking and the limited human capacity to process information. Another proposal is that people show confirmation bias because they are pragmatically assessing the costs of being wrong, rather than investigating in a neutral, scientific way. Flawed decisions due to confirmation bias have been found in a wide range of political, organizational, financial and scientific contexts. These biases contribute to overconfidence in personal beliefs and can maintain or strengthen beliefs in the face of contrary evidence. For example, confirmation bias produces systematic errors in scientific research based on inductive reasoning (the gradual accumulation of supportive evidence). Similarly, a police detective may identify a suspect early in an investigation, but then may only seek confirming rather than disconfirming evidence. A medical practitioner may prematurely focus on a particular disorder early in a diagnostic session, and then seek only confirming evidence. In social media, confirmation bias is amplified by the use of filter bubbles, or "algorithmic editing", which display to individuals only information they are likely to agree with, while excluding opposing views. |

確

証バイアス(confirmation bias、確認バイアス、myside bias、[a]またはcongeniality

bias[2])とは、自分の以前の信念や価値観を肯定または支持するような方法で情報を探し、解釈し、支持し、思い出す傾向のことである[3]。人々

は、自分の見解を支持する情報を選択し、反対の情報は無視したり、曖昧な証拠を自分の既存の態度を支持するものとして解釈したりするときに、このバイアス

を示す。この効果は、望ましい結果、感情的な問題、そして根強く定着した信念に対して最も強く現れる。 偏った情報の検索、その情報の偏った解釈、そして偏った記憶の想起は、4つの特定の効果を説明するために用いられてきた。 1. 態度の二極化(異なる当事者が同じ証拠に接しているにもかかわらず、意見の相違がさらに極端になること) 2. 信念の持続(その信念を裏付ける証拠が誤りであることが示された後も、信念が持続すること) 3. 非合理なプライマリー効果(一連の情報の最初に見つけた情報に過度に依存すること) 4. 幻想的な相関関係(2つの出来事や状況の間に誤った関連があると人々が誤って認識すること) 1960年代に行われた一連の心理実験により、人は既存の信念を裏付ける方向に偏る傾向があることが示唆された。その後の研究では、これらの結果を、ある 可能性に焦点を当て、他の可能性を無視するという、偏った方法でアイデアを検証する傾向として再解釈した。観察された偏りの説明には、希望的観測や、情報 を処理するための人間の能力の限界などが含まれる。また、別の説として、人々は中立かつ科学的な調査を行うのではなく、現実的に間違っている場合のコスト を評価しているため、確証バイアスを示すという説もある。 確証バイアスによる誤った意思決定は、政治、組織、金融、科学の幅広い分野で見つかっている。これらのバイアスは、個人の信念に対する過信につながり、相 反する証拠がある場合でも信念を維持したり強化したりしてしまう可能性がある。例えば、帰納的推論(支持する証拠を徐々に積み重ねていく)に基づく科学的 研究では、確証バイアスによって系統的なエラーが生じる。同様に、警察の刑事は捜査の初期段階で容疑者を特定しても、それを否定する証拠ではなく、それを 裏付ける証拠ばかりを求める可能性がある。医療従事者は診断の初期段階で特定の疾患に早期に焦点を当て、それを裏付ける証拠ばかりを求める可能性がある。 ソーシャルメディアでは、フィルターバブルや「アルゴリズム編集」と呼ばれる手法により、確証バイアスがさらに増幅される。フィルターバブルとは、個人の 好みに合った情報のみを表示し、反対意見は排除する仕組みのことである。 |

| Definition and context Confirmation bias, a phrase coined by English psychologist Peter Wason, is the tendency of people to favor information that confirms or strengthens their beliefs or values and is difficult to dislodge once affirmed.[4] Confirmation biases are effects in information processing. They differ from what is sometimes called the behavioral confirmation effect, commonly known as self-fulfilling prophecy, in which a person's expectations influence their own behavior, bringing about the expected result.[5] Some psychologists restrict the term "confirmation bias" to selective collection of evidence that supports what one already believes while ignoring or rejecting evidence that supports a different conclusion. Others apply the term more broadly to the tendency to preserve one's existing beliefs when searching for evidence, interpreting it, or recalling it from memory.[6][b] Confirmation bias is a result of automatic, unintentional strategies rather than deliberate deception.[8][9] |

定義と背景 確認バイアスとは、イギリスの心理学者ピーター・ワソンが作った言葉で、自分の信念や価値観を裏付ける、あるいは強化する情報を好む傾向であり、いったん肯定されると覆すことが難しいものである[4]。 確認バイアスは、情報処理における効果である。これは、自己成就予言として一般的に知られている行動確認効果と呼ばれるものと異なる。 自己成就予言とは、人の期待が自身の行動に影響を与え、期待通りの結果をもたらすものである[5]。一部の心理学者は、「確証バイアス」という用語を、自 分がすでに信じていることを裏付ける証拠を厳選して集め、異なる結論を裏付ける証拠を無視したり拒否したりすることと限定している。また、証拠を探した り、解釈したり、記憶から思い出したりする際に、既存の信念を維持しようとする傾向にもっと広くこの用語を適用する者もいる[6][b]。確認バイアス は、意図的な欺瞞ではなく、自動的で無意識的な戦略の結果である[8][9]。 |

| Types Biased search for information  A drawing of a man sitting on a stool at a writing desk Confirmation bias has been described as an internal "yes man", echoing back a person's beliefs like Charles Dickens's character Uriah Heep.[10] Experiments have found repeatedly that people tend to test hypotheses in a one-sided way, by searching for evidence consistent with their current hypothesis.[3]: 177–178 [11] Rather than searching through all the relevant evidence, they phrase questions to receive an affirmative answer that supports their theory.[12] They look for the consequences that they would expect if their hypothesis was true, rather than what would happen if it was false.[12] For example, someone using yes/no questions to find a number they suspect to be the number 3 might ask, "Is it an odd number?" People prefer this type of question, called a "positive test", even when a negative test such as "Is it an even number?" would yield exactly the same information.[13] However, this does not mean that people seek tests that guarantee a positive answer. In studies where subjects could select either such pseudo-tests or genuinely diagnostic ones, they favored the genuinely diagnostic.[14][15] The preference for positive tests in itself is not a bias, since positive tests can be highly informative.[16] However, in combination with other effects, this strategy can confirm existing beliefs or assumptions, independently of whether they are true.[8] In real-world situations, evidence is often complex and mixed. For example, various contradictory ideas about someone could each be supported by concentrating on one aspect of his or her behavior.[11] Thus any search for evidence in favor of a hypothesis is likely to succeed.[8] One illustration of this is the way the phrasing of a question can significantly change the answer.[11] For example, people who are asked, "Are you happy with your social life?" report greater satisfaction than those asked, "Are you unhappy with your social life?"[17] Even a small change in a question's wording can affect how people search through available information, and hence the conclusions they reach. This was shown using a fictional child custody case.[18] Participants read that Parent A was moderately suitable to be the guardian in multiple ways. Parent B had a mix of salient positive and negative qualities: a close relationship with the child but a job that would take them away for long periods of time. When asked, "Which parent should have custody of the child?" the majority of participants chose Parent B, looking mainly for positive attributes. However, when asked, "Which parent should be denied custody of the child?" they looked for negative attributes and the majority answered that Parent B should be denied custody, implying that Parent A should have custody.[18] Similar studies have demonstrated how people engage in a biased search for information, but also that this phenomenon may be limited by a preference for genuine diagnostic tests. In an initial experiment, participants rated another person on the introversion–extroversion personality dimension on the basis of an interview. They chose the interview questions from a given list. When the interviewee was introduced as an introvert, the participants chose questions that presumed introversion, such as, "What do you find unpleasant about noisy parties?" When the interviewee was described as extroverted, almost all the questions presumed extroversion, such as, "What would you do to liven up a dull party?" These loaded questions gave the interviewees little or no opportunity to falsify the hypothesis about them.[19] A later version of the experiment gave the participants less presumptive questions to choose from, such as, "Do you shy away from social interactions?"[20] Participants preferred to ask these more diagnostic questions, showing only a weak bias towards positive tests. This pattern, of a main preference for diagnostic tests and a weaker preference for positive tests, has been replicated in other studies.[20] Personality traits influence and interact with biased search processes.[21] Individuals vary in their abilities to defend their attitudes from external attacks in relation to selective exposure. Selective exposure occurs when individuals search for information that is consistent, rather than inconsistent, with their personal beliefs.[22] An experiment examined the extent to which individuals could refute arguments that contradicted their personal beliefs.[21] People with high confidence levels more readily seek out contradictory information to their personal position to form an argument. This can take the form of an oppositional news consumption, where individuals seek opposing partisan news in order to counterargue.[23] Individuals with low confidence levels do not seek out contradictory information and prefer information that supports their personal position. People generate and evaluate evidence in arguments that are biased towards their own beliefs and opinions.[24] Heightened confidence levels decrease preference for information that supports individuals' personal beliefs. Another experiment gave participants a complex rule-discovery task that involved moving objects simulated by a computer.[25] Objects on the computer screen followed specific laws, which the participants had to figure out. So, participants could "fire" objects across the screen to test their hypotheses. Despite making many attempts over a ten-hour session, none of the participants figured out the rules of the system. They typically attempted to confirm rather than falsify their hypotheses, and were reluctant to consider alternatives. Even after seeing objective evidence that refuted their working hypotheses, they frequently continued doing the same tests. Some of the participants were taught proper hypothesis-testing, but these instructions had almost no effect.[25] Biased interpretation of information Smart people believe weird things because they are skilled at defending beliefs they arrived at for non-smart reasons. —Michael Shermer[26] Confirmation biases are not limited to the collection of evidence. Even if two individuals have the same information, the way they interpret it can be biased. A team at Stanford University conducted an experiment involving participants who felt strongly about capital punishment, with half in favor and half against it.[27][28] Each participant read descriptions of two studies: a comparison of U.S. states with and without the death penalty, and a comparison of murder rates in a state before and after the introduction of the death penalty. After reading a quick description of each study, the participants were asked whether their opinions had changed. Then, they read a more detailed account of each study's procedure and had to rate whether the research was well-conducted and convincing.[27] In fact, the studies were fictional. Half the participants were told that one kind of study supported the deterrent effect and the other undermined it, while for other participants the conclusions were swapped.[27][28] The participants, whether supporters or opponents, reported shifting their attitudes slightly in the direction of the first study they read. Once they read the more detailed descriptions of the two studies, they almost all returned to their original belief regardless of the evidence provided, pointing to details that supported their viewpoint and disregarding anything contrary. Participants described studies supporting their pre-existing view as superior to those that contradicted it, in detailed and specific ways.[27][29] Writing about a study that seemed to undermine the deterrence effect, a death penalty proponent wrote, "The research didn't cover a long enough period of time," while an opponent's comment on the same study said, "No strong evidence to contradict the researchers has been presented."[27] The results illustrated that people set higher standards of evidence for hypotheses that go against their current expectations. This effect, known as "disconfirmation bias", has been supported by other experiments.[30] Another study of biased interpretation occurred during the 2004 U.S. presidential election and involved participants who reported having strong feelings about the candidates. They were shown apparently contradictory pairs of statements, either from Republican candidate George W. Bush, Democratic candidate John Kerry or a politically neutral public figure. They were also given further statements that made the apparent contradiction seem reasonable. From these three pieces of information, they had to decide whether each individual's statements were inconsistent.[31]: 1948 There were strong differences in these evaluations, with participants much more likely to interpret statements from the candidate they opposed as contradictory.[31]: 1951  A large round machine with a hole in the middle, with a platter for a person to lie on so that their head can fit into the hole An MRI scanner allowed researchers to examine how the human brain deals with dissonant information. In this experiment, the participants made their judgments while in a magnetic resonance imaging (MRI) scanner which monitored their brain activity. As participants evaluated contradictory statements by their favored candidate, emotional centers of their brains were aroused. This did not happen with the statements by the other figures. The experimenters inferred that the different responses to the statements were not due to passive reasoning errors. Instead, the participants were actively reducing the cognitive dissonance induced by reading about their favored candidate's irrational or hypocritical behavior.[31]: 1956 Biases in belief interpretation are persistent, regardless of intelligence level. Participants in an experiment took the SAT test (a college admissions test used in the United States) to assess their intelligence levels. They then read information regarding safety concerns for vehicles, and the experimenters manipulated the national origin of the car. American participants provided their opinion if the car should be banned on a six-point scale, where one indicated "definitely yes" and six indicated "definitely no". Participants firstly evaluated if they would allow a dangerous German car on American streets and a dangerous American car on German streets. Participants believed that the dangerous German car on American streets should be banned more quickly than the dangerous American car on German streets. There was no difference among intelligence levels at the rate participants would ban a car.[24] Biased interpretation is not restricted to emotionally significant topics. In another experiment, participants were told a story about a theft. They had to rate the evidential importance of statements arguing either for or against a particular character being responsible. When they hypothesized that character's guilt, they rated statements supporting that hypothesis as more important than conflicting statements.[32] Biased recall of information People may remember evidence selectively to reinforce their expectations, even if they gather and interpret evidence in a neutral manner. This effect is called "selective recall", "confirmatory memory", or "access-biased memory".[33] Psychological theories differ in their predictions about selective recall. Schema theory predicts that information matching prior expectations will be more easily stored and recalled than information that does not match.[34] Some alternative approaches say that surprising information stands out and so is memorable.[34] Predictions from both these theories have been confirmed in different experimental contexts, with no theory winning outright.[35] In one study, participants read a profile of a woman which described a mix of introverted and extroverted behaviors.[36] They later had to recall examples of her introversion and extroversion. One group was told this was to assess the woman for a job as a librarian, while a second group were told it was for a job in real estate sales. There was a significant difference between what these two groups recalled, with the "librarian" group recalling more examples of introversion and the "sales" groups recalling more extroverted behavior.[36] A selective memory effect has also been shown in experiments that manipulate the desirability of personality types.[34][37] In one of these, a group of participants were shown evidence that extroverted people are more successful than introverts. Another group were told the opposite. In a subsequent, apparently unrelated study, participants were asked to recall events from their lives in which they had been either introverted or extroverted. Each group of participants provided more memories connecting themselves with the more desirable personality type, and recalled those memories more quickly.[38] Changes in emotional states can also influence memory recall.[39][40] Participants rated how they felt when they had first learned that O. J. Simpson had been acquitted of murder charges.[39] They described their emotional reactions and confidence regarding the verdict one week, two months, and one year after the trial. Results indicated that participants' assessments for Simpson's guilt changed over time. The more that participants' opinion of the verdict had changed, the less stable were the participant's memories regarding their initial emotional reactions. When participants recalled their initial emotional reactions two months and a year later, past appraisals closely resembled current appraisals of emotion. People demonstrate sizable myside bias when discussing their opinions on controversial topics.[24] Memory recall and construction of experiences undergo revision in relation to corresponding emotional states. Myside bias has been shown to influence the accuracy of memory recall.[40] In an experiment, widows and widowers rated the intensity of their experienced grief six months and five years after the deaths of their spouses. Participants noted a higher experience of grief at six months rather than at five years. Yet, when the participants were asked after five years how they had felt six months after the death of their significant other, the intensity of grief participants recalled was highly correlated with their current level of grief. Individuals appear to utilize their current emotional states to analyze how they must have felt when experiencing past events.[39] Emotional memories are reconstructed by current emotional states. One study showed how selective memory can maintain belief in extrasensory perception (ESP).[41] Believers and disbelievers were each shown descriptions of ESP experiments. Half of each group were told that the experimental results supported the existence of ESP, while the others were told they did not. In a subsequent test, participants recalled the material accurately, apart from believers who had read the non-supportive evidence. This group remembered significantly less information and some of them incorrectly remembered the results as supporting ESP.[41] |

タイプ 偏った情報の検索  机の前に腰掛けた男が椅子に座っている絵 確認バイアスは、チャールズ・ディケンズの小説に登場するキャラクター、ユーライア・ヒープのように、自分の信念を反映させる「イエスマン」として説明されてきた[10]。 実験では、人々は現在の仮説と一致する証拠を探すことで、一方的に仮説を検証する傾向があることが繰り返し確認されている[3]: 177–17 8 [11] 彼らは、関連するすべての証拠を調べるのではなく、自分たちの理論を裏付ける肯定的な答えが得られるような質問をする[12]。彼らは、仮説が間違ってい る場合に何が起こるのかではなく、仮説が正しい場合に予想される結果を探す[12]。例えば、3という数字を推測するためにイエス/ノーの質問を使う人 は、「奇数ですか?」と尋ねるかもしれない。「偶数ですか?」といった否定的な質問でも全く同じ情報を得られる場合であっても、人々は「肯定的テスト」と 呼ばれるこのタイプの質問を好む[13]。しかし、これは人々が肯定的な答えを保証するテストを求めているという意味ではない。被験者がそのような疑似テ ストと真正の診断テストのどちらかを選択できる研究では、被験者は真正の診断テストを好むことが示されている[14][15]。 真正のテストは有益な情報をもたらす可能性があるため、真正のテストを好むこと自体はバイアスではない[16]。しかし、他の効果と組み合わせると、この 戦略は、それが真実であるかどうかとは関係なく、既存の信念や仮定を裏付ける可能性がある[8]。現実世界では、証拠は複雑で矛盾することが多い。例え ば、ある人について相反するさまざまな考え方が、その人の行動の1つの側面だけに注目することでそれぞれ裏付けられる可能性がある[11]。したがって、 仮説を支持する証拠を探すことは成功する可能性が高い[8]。このことを示す一例として、質問の言い回しによって答えが大きく変わる場合がある[11]。 例えば、「あなたは社交生活に満足していますか?」と尋ねられた人は、「あなたは社交生活に不満がありますか?」と尋ねられた人よりも、より大きな満足感 を報告している[17]。 質問の文言を少し変えるだけでも、人々が利用可能な情報をどのように検索するか、そしてその結果どのような結論に達するかにも影響する。これは架空の親権 争いに関するケースを用いて示された[18]。参加者は、親 A は複数の点で適任であると書かれていた。親 B は、子供と親密な関係にあるが、仕事が理由で長期間家を空けなければならないという、顕著な長所と短所を併せ持っていた。どちらの親に親権を与えるべき か」という質問に対し、参加者の大半は主に長所に着目して親 B を選んだ。しかし、「どちらの親に子供の親権を与えないべきか」と尋ねられると、参加者は否定的な要素に注目し、大半が「B親に親権を与えないべき」と回 答した。 同様の研究では、人々が偏った情報検索を行うことが示されているが、この現象は本物の診断テストへの嗜好によって制限される可能性があることも示されてい る。最初の実験では、参加者は面接に基づいて、他者を内向的か外向的かの性格次元で評価した。彼らは与えられたリストから面接の質問を選んだ。面接者が内 向的であると紹介されると、参加者は「騒々しいパーティーで何が不快に感じますか?」など、内向性を前提とした質問を選んだ。面接対象者が外向的であると 説明された場合、質問のほとんどは外向性を前提としたもので、「退屈なパーティーを盛り上げるために何をしますか?」といった質問があった。このような 偏った質問は、被験者に自分についての仮説を覆す機会をほとんど与えないものであった[19]。この実験の後のバージョンでは、被験者に「あなたは社交的 な交流を避けがちですか?」といった、より推測的ではない質問が提示された[20]。被験者はこのような診断的な質問を好む傾向があり、肯定的なテストに 対する偏りは弱いことが示された。診断テストを主に好み、肯定テストをあまり好まないというこのパターンは、他の研究でも再現されている[20]。 パーソナリティ特性は、偏った探索プロセスに影響を与え、相互作用する[21]。個々人は、選択的暴露に関連して、外部からの攻撃から自分の態度を守る能 力に差がある。選択的暴露とは、個人が自身の信念と矛盾しない情報を探す場合のことである[22]。ある実験では、個人が自身の信念と矛盾する主張をどの 程度反論できるかを調べた[21]。自信レベルが高い人は、自身の立場と相反する情報をより積極的に探し、議論を展開する。これは、反対意見のニュースを 消費するという形をとることもある。これは、反論するために、個人が反対の党派ニュースを求めることである[23]。自信の低い個人は、矛盾する情報を求 めず、自分の立場を支持する情報を好む。人々は、自分の信念や意見に偏った議論の中で証拠を生み出し、評価する[24]。自信が高まるほど、個人の信念を 支持する情報を好む傾向は弱まる。 別の実験では、参加者にコンピュータでシミュレートされた物体の移動を伴う複雑な規則発見課題を与えた[25]。コンピュータ画面上の物体は特定の法則に 従っていたが、参加者はその法則を解明しなければならなかった。そのため、参加者は仮説を検証するために画面上の物体を「発射」することができた。10時 間にわたるセッションで何度も試みたが、参加者の誰一人としてシステムの法則を解明することはできなかった。彼らは通常、仮説を否定するのではなく確認し ようとし、代替案を検討することに消極的だった。仮説を否定する客観的証拠を目にしても、参加者は同じテストを何度も繰り返すことが多かった。一部の参加 者は仮説検証の正しい方法を教わったが、その指示はほとんど効果を示さなかった[25]。 情報の偏った解釈 賢い人々は、非賢い理由で得た信念を擁護することに長けているため、奇妙なことを信じてしまう。 —マイケル・シャーマー[26] 確証バイアスは証拠の収集に限ったことではない。たとえ 2 人の個人が同じ情報を持っていたとしても、その解釈の仕方は偏ってしまう可能性がある。 スタンフォード大学の研究チームは、死刑制度に強く反対する人と賛成する人に分かれて実験を行った[27][28]。各参加者は、死刑制度のある州とない 州を比較した研究と、死刑制度導入前後の殺人発生率を比較した研究、2 つの研究の説明を読んだ。各研究の概要を簡単に読んだ後、参加者は自分の意見が変わったかどうか尋ねられた。その後、各研究の手順の詳細な説明を読み、そ の研究が適切に実施され説得力があるかどうかを評価しなければならなかった[27]。実際には、これらの研究は架空のものであった。参加者の半数は、ある 種の研究が抑止効果を支持し、もう一方の研究はそれを損なうという説明を受け、残りの参加者には結論が入れ替えられた[27][28]。 支持者でも反対者でも、参加者は最初に読んだ研究の方向性に少しだけ考えが傾いたと報告した。2つの研究の詳細な説明を読んだ後、彼らは証拠が提示された かどうかに関わらず、ほぼ全員が元の信念に戻った。自分の見解を支持する詳細を指摘し、反対するものは無視したのだ。参加者は、自分の既存の考え方を裏付 ける研究を、それを否定する研究よりも優れていると、詳細かつ具体的に説明した[27][29]。抑止効果を損なうと思われる研究について、死刑制度支持 者は「この研究は十分な期間を対象としていない」と書き、 十分な期間を対象としていなかった」と述べた。一方、同じ研究に対する反対派のコメントは、「研究結果を否定する有力な証拠は提示されていない」というも のであった[27]。この結果は、人々が現在の期待に反する仮説に対してより高い証拠基準を設定することを示している。この効果は「反証バイアス」として 知られており、他の実験でも裏付けられている[30]。 偏った解釈に関する別の研究は、2004年のアメリカ大統領選挙中に実施され、候補者について強い感情を抱いていると報告した参加者が対象となった。参加 者は、共和党候補のジョージ・W・ブッシュ、民主党候補のジョン・ケリー、または政治的に中立な著名人による、一見矛盾した内容の文を提示された。さら に、一見矛盾しているように見える文を、矛盾していないように見せる文も提示された。被験者は、この 3 つの情報から、各個人の発言が矛盾しているかどうかを判断しなければならなかった[31]: 1948 。これらの評価には大きな違いがあり、被験者は自 分が反対する候補者の発言を矛盾していると解釈する傾向が強かった[31 ]: 1951  中央に穴のあいた大きな円形の機械。人が横たわり、穴に頭が入るよう皿が備えられている MRIスキャナーにより、研究者は人間の脳が矛盾した情報をどのように処理するのかを調べることができるようになった。 この実験では、参加者は磁気共鳴画像装置(MRI)スキャナーの中で脳活動をモニターされながら判断を下した。参加者は、自分が支持する候補者の矛盾した 発言を評価する際に、脳内の感情中枢が活性化していた。これは、他の候補者の発言では起こらなかった。実験者は、発言に対する反応の違いが受動的な推論エ ラーによるものではないと推測した。その代わりに、参加者は、自分が支持する候補者の非合理的な行動や偽善的な行動について読んだことで生じた認知的不協 和を積極的に解消しようとしていた[31]: 1956 信念の解釈における偏見は、知能レベルに関係なく根強いものである。実験の参加者は、SATテスト(米国で大学入学試験として用いられている)を受けて知 能レベルを評価した。その後、自動車の安全性に関する情報を読み、実験者は自動車の国籍を操作した。アメリカ人の参加者は、その車が禁止されるべきかどう かについて、1が「間違いなくイエス」、6が「間違いなくノー」を示す6段階評価で意見を述べた。参加者はまず、危険なドイツ車がアメリカの道路を走り、 危険なアメリカ車がドイツの道路を走ることを許容するかどうかについて評価した。参加者は、危険なドイツ車がアメリカの道路を走ることは、危険なアメリカ 車がドイツの道路を走るよりも早く禁止されるべきだと考えていた。参加者が車を禁止する割合に、知能レベルによる違いはなかった[24]。 偏った解釈は、感情的に重要な話題に限ったことではない。別の実験では、参加者に盗難の話を聞かせた。そして、特定の人物が犯人であるとする主張と、そう でないとする主張の証拠としての重要性を評価させた。参加者は、ある人物の有罪を仮定した場合、その仮説を裏付ける主張を、矛盾する主張よりも重要だと評 価した[32]。 情報の偏った想起 人々は、中立的な方法で証拠を集め、解釈している場合でも、自分の期待を強化するために証拠を選択的に思い出すことがある。この現象は「選択的想起」、 「確認記憶」、「アクセスバイアス記憶」などと呼ばれる[33]。選択的想起に関する心理学的理論は、その予測において異なる。スキーマ理論では、事前の 期待と一致する情報は、一致しない情報よりも記憶されやすく、思い出しやすいと予測している[34]。一方、驚くような情報は際立って記憶に残るとする別 のアプローチもある[34]。これらの理論に基づく予測は、さまざまな実験的 ある研究では、参加者は内向的行動と外向的行動の両方が混在する女性のプロフィールを読んだ[36]。その後、参加者は彼女の内向性と外向性の例を思い出 すように指示された。あるグループには、これは図書館司書の仕事のための評価だと伝えられ、別のグループには、不動産販売の仕事のための評価だと伝えられ た。この 2 つのグループで思い出した内容には大きな違いがあり、「司書」グループは内向的な行動の例を多く思い出し、「営業」グループは外向的な行動の例を多く思い 出した[36]。また、性格タイプの望ましい点を操作する実験でも、選択的記憶効果が示されている[34][37]。そのうちの 1 つでは、参加者に外向的な人は内向的な人よりも成功しやすいという証拠が示された。別のグループにはその逆が伝えられた。その後に行われた、一見無関係な 研究では、参加者に内向的または外向的だった出来事を思い出すよう求めた。各グループの参加者は、より望ましい性格タイプと結びついた記憶をより多く提供 し、それらの記憶をより早く思い出した[38]。 感情状態の変化も記憶の想起に影響を与える可能性がある[39][40]。参加者は、O. J. シンプソンが殺人容疑で無罪になったことを初めて知ったときの感情を評定した[39]。彼らは、裁判から1週間後、2ヶ月後、1年後の判決に対する感情的 な反応と自信を述べた。その結果、シンプソンの有罪に対する参加者の評価は時間とともに変化することが示された。 参加者の評決に対する意見の変化が大きければ大きいほど、最初の感情的反応に関する参加者の記憶は安定性を欠くことがわかった。 2ヶ月後と1年後に最初の感情的反応を思い出すと、過去の評価は現在の感情評価と非常に類似していた。人々は物議を醸す話題について意見を述べる際に、か なりのマイサイドバイアスを示す[24]。記憶の想起と経験の組み立ては、対応する感情状態に応じて修正される。 マイサイドバイアスは、記憶の想起の正確性に影響を与えることが示されている[40]。ある実験では、配偶者を亡くした未亡人と寡夫に、配偶者の死から6 か月後と5年後に経験した悲しみの強さを評価してもらった。参加者は、5年後よりも6か月後のほうが悲しみを強く感じたと回答した。しかし、5年後に参加 者に、大切な人を亡くしてから6か月後にどう感じていたかを尋ねたところ、参加者が思い出した悲しみの強さは、現在の悲しみのレベルと高い相関関係があっ た。 人は現在の感情の状態を利用して、過去の出来事を経験したときにどう感じていたかを分析しているようだ[39]。感情的な記憶は、現在の感情の状態によっ て再構築される。 ある研究では、選択的記憶が超感覚的知覚(ESP)に対する信念を維持する方法が示された[41]。信奉者と懐疑論者の両方に、ESPの実験の説明が示さ れた。各グループの半数は、実験結果がESPの存在を支持していると伝えられ、残りの半数は支持しないと伝えられた。その後のテストで、参加者は、非支持 的な証拠を読んだ信奉者を除き、正確に内容を思い出した。このグループは、記憶した情報の量が著しく少なく、そのうちの何人かは、結果が超能力の存在を裏 付けるものであると誤って記憶していた[41]。 |

| Individual differences Myside bias was once believed to be correlated with intelligence; however, studies have shown that myside bias can be more influenced by ability to rationally think as opposed to level of intelligence.[24] Myside bias can cause an inability to effectively and logically evaluate the opposite side of an argument. Studies have stated that myside bias is an absence of "active open-mindedness", meaning the active search for why an initial idea may be wrong.[42] Typically, myside bias is operationalized in empirical studies as the quantity of evidence used in support of their side in comparison to the opposite side.[43] A study has found individual differences in myside bias. This study investigates individual differences that are acquired through learning in a cultural context and are mutable. The researcher found important individual difference in argumentation. Studies have suggested that individual differences such as deductive reasoning ability, ability to overcome belief bias, epistemological understanding, and thinking disposition are significant predictors of the reasoning and generating arguments, counterarguments, and rebuttals.[44][45][46] A study by Christopher Wolfe and Anne Britt also investigated how participants' views of "what makes a good argument?" can be a source of myside bias that influences the way a person formulates their own arguments.[43] The study investigated individual differences of argumentation schema and asked participants to write essays. The participants were randomly assigned to write essays either for or against their preferred side of an argument and were given research instructions that took either a balanced or an unrestricted approach. The balanced-research instructions directed participants to create a "balanced" argument, i.e., that included both pros and cons; the unrestricted-research instructions included nothing on how to create the argument.[43] Overall, the results revealed that the balanced-research instructions significantly increased the incidence of opposing information in arguments. These data also reveal that personal belief is not a source of myside bias; however, that those participants, who believe that a good argument is one that is based on facts, are more likely to exhibit myside bias than other participants. This evidence is consistent with the claims proposed in Baron's article—that people's opinions about what makes good thinking can influence how arguments are generated.[43] |

個人差 マイサイドバイアスはかつて知性と相関があると考えられていたが、研究により、マイサイドバイアスは知性のレベルよりもむしろ合理的に考える能力により影 響を受けることが示されている[24]。マイサイドバイアスは、議論の反対側を効果的に論理的に評価できない原因となる。研究によると、myside bias は「能動的なオープンマインド」の欠如であり、つまり、最初の考えがなぜ間違っている可能性があるのかについて能動的に探求することを意味するという。通 常、myside bias は、反対側の意見と比較して、自分の意見を支持するために使用される証拠の量として実証研究で操作化される。 ある研究では、myside bias に個人差があることが明らかになっている。この研究では、文化的文脈における学習を通じて獲得され、変化し得る個人差について調査している。研究者は、議 論において重要な個人差を発見した。研究によると、演繹的推論能力、信念バイアスを克服する能力、認識論的理解、思考傾向などの個人差によって、推論や論 証、反論、反論の生成が予測できることが示唆されている[44][45][46]。 クリストファー・ウルフとアン・ブリットによる研究では Wolfe と Anne Britt による研究では、参加者が「何が優れた議論なのか」について抱く見解が、人が自身の議論を組み立てる際に影響を与えるマイサイドバイアス(自分と同じ意見 に偏る傾向)の要因となりうるかどうかについても調査が行われた[43]。この研究では、議論の枠組みに関する個人差を調査し、参加者に小論文を書いても らった。参加者は、議論のどちらかの側について賛成または反対の論文を書くよう無作為に割り当てられ、バランスの取れたアプローチまたは制限のないアプ ローチのいずれかの研究指示が与えられた。バランスの取れた研究指示では、参加者は賛成と反対の両方を含む「バランスの取れた」議論を作成するように指示 された。一方、制限のない研究指示では、議論の作成方法については何も指示されなかった[43]。 全体として、バランスの取れた研究指示により、議論に反対の情報が含まれる割合が大幅に増加したことが明らかになった。これらのデータから、個人的な信念 がバイアスを生み出す要因ではないことが明らかになった。しかし、事実に基づく議論が良い議論であるという信念を持つ参加者は、そうでない参加者よりもバ イアスを生じやすいことがわかった。この結果は、バロン氏の論文で提唱された主張と一致している。すなわち、良い思考とは何かについての人々の意見は、議 論の組み立て方に影響を与える可能性があるということである[43]。 |

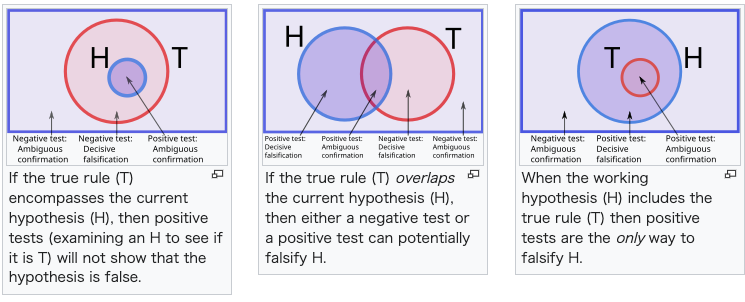

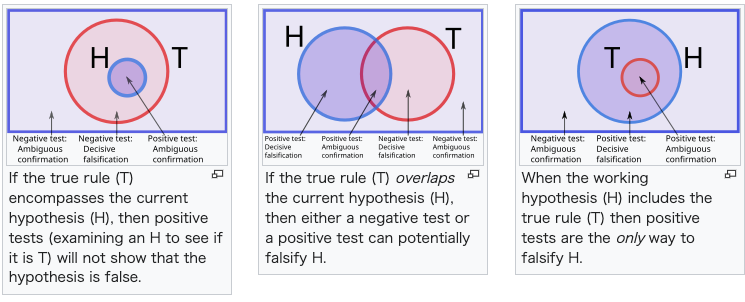

| Discovery Informal observations  Engraved head-and-shoulders portrait of Francis Bacon wearing a hat and ruff. Francis Bacon Before psychological research on confirmation bias, the phenomenon had been observed throughout history. Beginning with the Greek historian Thucydides (c. 460 BC – c. 395 BC), who wrote of misguided reason in The Peloponnesian War; "... for it is a habit of mankind to entrust to careless hope what they long for, and to use sovereign reason to thrust aside what they do not fancy".[47] Italian poet Dante Alighieri (1265–1321) noted it in the Divine Comedy, in which St. Thomas Aquinas cautions Dante upon meeting in Paradise, "opinion—hasty—often can incline to the wrong side, and then affection for one's own opinion binds, confines the mind".[48] Ibn Khaldun noticed the same effect in his Muqaddimah:[49] Untruth naturally afflicts historical information. There are various reasons that make this unavoidable. One of them is partisanship for opinions and schools. ... if the soul is infected with partisanship for a particular opinion or sect, it accepts without a moment's hesitation the information that is agreeable to it. Prejudice and partisanship obscure the critical faculty and preclude critical investigation. The result is that falsehoods are accepted and transmitted. In the Novum Organum, English philosopher and scientist Francis Bacon (1561–1626)[50] noted that biased assessment of evidence drove "all superstitions, whether in astrology, dreams, omens, divine judgments or the like".[51] He wrote:[51] The human understanding when it has once adopted an opinion ... draws all things else to support and agree with it. And though there be a greater number and weight of instances to be found on the other side, yet these it either neglects or despises, or else by some distinction sets aside or rejects[.] In the second volume of his The World as Will and Representation (1844), German philosopher Arthur Schopenhauer observed that "An adopted hypothesis gives us lynx-eyes for everything that confirms it and makes us blind to everything that contradicts it."[52] In his essay (1897) What Is Art?, Russian novelist Leo Tolstoy wrote:[53] I know that most men—not only those considered clever, but even those who are very clever, and capable of understanding most difficult scientific, mathematical, or philosophic problems—can very seldom discern even the simplest and most obvious truth if it be such as to oblige them to admit the falsity of conclusions they have formed, perhaps with much difficulty—conclusions of which they are proud, which they have taught to others, and on which they have built their lives. In his essay (1894) The Kingdom of God Is Within You, Tolstoy had earlier written:[54] The most difficult subjects can be explained to the most slow-witted man if he has not formed any idea of them already; but the simplest thing cannot be made clear to the most intelligent man if he is firmly persuaded that he knows already, without a shadow of doubt, what is laid before him. Hypothesis-testing (falsification) explanation (Wason) Main article: Wason selection task In Peter Wason's initial experiment published in 1960 (which does not mention the term "confirmation bias"), he repeatedly challenged participants to identify a rule applying to triples of numbers. They were told that (2,4,6) fits the rule. They generated triples, and the experimenter told them whether each triple conformed to the rule.[3]: 179 The actual rule was simply "any ascending sequence", but participants had great difficulty in finding it, often announcing rules that were far more specific, such as "the middle number is the average of the first and last".[55] The participants seemed to test only positive examples—triples that obeyed their hypothesized rule. For example, if they thought the rule was, "Each number is two greater than its predecessor," they would offer a triple that fitted (confirmed) this rule, such as (11,13,15) rather than a triple that violated (falsified) it, such as (11,12,19).[56] Wason interpreted his results as showing a preference for confirmation over falsification, hence he coined the term "confirmation bias".[c][58] Wason also used confirmation bias to explain the results of his selection task experiment.[59] Participants repeatedly performed badly on various forms of this test, in most cases ignoring information that could potentially refute (falsify) the specified rule.[60][61] Hypothesis testing (positive test strategy) explanation (Klayman and Ha) Klayman and Ha's 1987 paper argues that the Wason experiments do not actually demonstrate a bias towards confirmation, but instead a tendency to make tests consistent with the working hypothesis.[16][62] They called this the "positive test strategy".[11] This strategy is an example of a heuristic: a reasoning shortcut that is imperfect but easy to compute.[63] Klayman and Ha used Bayesian probability and information theory as their standard of hypothesis-testing, rather than the falsificationism used by Wason. According to these ideas, each answer to a question yields a different amount of information, which depends on the person's prior beliefs. Thus a scientific test of a hypothesis is one that is expected to produce the most information. Since the information content depends on initial probabilities, a positive test can either be highly informative or uninformative. Klayman and Ha argued that when people think about realistic problems, they are looking for a specific answer with a small initial probability. In this case, positive tests are usually more informative than negative tests.[16] However, in Wason's rule discovery task the answer—three numbers in ascending order—is very broad, so positive tests are unlikely to yield informative answers. Klayman and Ha supported their analysis by citing an experiment that used the labels "DAX" and "MED" in place of "fits the rule" and "doesn't fit the rule". This avoided implying that the aim was to find a low-probability rule. Participants had much more success with this version of the experiment.[64][65] Within the universe of all possible triples, those that fit the true rule are shown schematically as a circle. The hypothesized rule is a smaller circle enclosed within it. If the true rule (T) encompasses the current hypothesis (H), then positive tests (examining an H to see if it is T) will not show that the hypothesis is false. Two overlapping circles represent the true rule and the hypothesized rule. Any observation falling in the non-overlapping parts of the circles shows that the two rules are not exactly the same. In other words, those observations falsify the hypothesis. If the true rule (T) overlaps the current hypothesis (H), then either a negative test or a positive test can potentially falsify H. The triples fitting the hypothesis are represented as a circle within the universe of all triples. The true rule is a smaller circle within this.  When the working hypothesis (H) includes the true rule (T) then positive tests are the only way to falsify H. In light of this and other critiques, the focus of research moved away from confirmation versus falsification of an hypothesis, to examining whether people test hypotheses in an informative way, or an uninformative but positive way. The search for "true" confirmation bias led psychologists to look at a wider range of effects in how people process information.[66] Information processing explanations There are currently three main information processing explanations of confirmation bias, plus a recent addition. Cognitive versus motivational  Happy events are more likely to be remembered. According to Robert MacCoun, most biased evidence processing occurs through a combination of "cold" (cognitive) and "hot" (motivated) mechanisms.[67] Cognitive explanations for confirmation bias are based on limitations in people's ability to handle complex tasks, and the shortcuts, called heuristics, that they use.[68] For example, people may judge the reliability of evidence by using the availability heuristic that is, how readily a particular idea comes to mind.[69] It is also possible that people can only focus on one thought at a time, so find it difficult to test alternative hypotheses in parallel.[3]: 198–199 Another heuristic is the positive test strategy identified by Klayman and Ha, in which people test a hypothesis by examining cases where they expect a property or event to occur. This heuristic avoids the difficult or impossible task of working out how diagnostic each possible question will be. However, it is not universally reliable, so people can overlook challenges to their existing beliefs.[16][3]: 200 Motivational explanations involve an effect of desire on belief.[3]: 197 [70] It is known that people prefer positive thoughts over negative ones in a number of ways: this is called the "Pollyanna principle".[71] Applied to arguments or sources of evidence, this could explain why desired conclusions are more likely to be believed true. According to experiments that manipulate the desirability of the conclusion, people demand a high standard of evidence for unpalatable ideas and a low standard for preferred ideas. In other words, they ask, "Can I believe this?" for some suggestions and, "Must I believe this?" for others.[72][73] Although consistency is a desirable feature of attitudes, an excessive drive for consistency is another potential source of bias because it may prevent people from neutrally evaluating new, surprising information. Social psychologist Ziva Kunda combines the cognitive and motivational theories, arguing that motivation creates the bias, but cognitive factors determine the size of the effect.[3]: 198 Cost-benefit Explanations in terms of cost-benefit analysis assume that people do not just test hypotheses in a disinterested way, but assess the costs of different errors.[74] Using ideas from evolutionary psychology, James Friedrich suggests that people do not primarily aim at truth in testing hypotheses, but try to avoid the most costly errors. For example, employers might ask one-sided questions in job interviews because they are focused on weeding out unsuitable candidates.[75] Yaacov Trope and Akiva Liberman's refinement of this theory assumes that people compare the two different kinds of error: accepting a false hypothesis or rejecting a true hypothesis. For instance, someone who underestimates a friend's honesty might treat him or her suspiciously and so undermine the friendship. Overestimating the friend's honesty may also be costly, but less so. In this case, it would be rational to seek, evaluate or remember evidence of their honesty in a biased way.[76] When someone gives an initial impression of being introverted or extroverted, questions that match that impression come across as more empathic.[77] This suggests that when talking to someone who seems to be an introvert, it is a sign of better social skills to ask, "Do you feel awkward in social situations?" rather than, "Do you like noisy parties?" The connection between confirmation bias and social skills was corroborated by a study of how college students get to know other people. Highly self-monitoring students, who are more sensitive to their environment and to social norms, asked more matching questions when interviewing a high-status staff member than when getting to know fellow students.[77] Exploratory versus confirmatory Psychologists Jennifer Lerner and Philip Tetlock distinguish two different kinds of thinking process. Exploratory thought neutrally considers multiple points of view and tries to anticipate all possible objections to a particular position, while confirmatory thought seeks to justify a specific point of view. Lerner and Tetlock say that when people expect to justify their position to others whose views they already know, they will tend to adopt a similar position to those people, and then use confirmatory thought to bolster their own credibility. However, if the external parties are overly aggressive or critical, people will disengage from thought altogether, and simply assert their personal opinions without justification. Lerner and Tetlock say that people only push themselves to think critically and logically when they know in advance they will need to explain themselves to others who are well-informed, genuinely interested in the truth, and whose views they do not already know. Because those conditions rarely exist, they argue, most people are using confirmatory thought most of the time.[78][79][80] Make-believe Developmental psychologist Eve Whitmore has argued that beliefs and biases involved in confirmation bias have their roots in childhood coping through make-believe, which becomes "the basis for more complex forms of self-deception and illusion into adulthood." The friction brought on by questioning as an adolescent with developing critical thinking can lead to the rationalization of false beliefs, and the habit of such rationalization can become unconscious over the years.[81] |

発見 非公式な観察  帽子とラッフルを着用したフランシス・ベーコンの肩から上の肖像画。 フランシス・ベーコン 確証バイアスに関する心理学の研究が行われる以前から、この現象は歴史上観察されていた。『ペロポネソス戦争』で誤った理性を論じた古代ギリシャの歴史家 トゥキュディデス(紀元前460年頃~紀元前395年頃)が、その現象について初めて言及した。 「... 人間の習性として、切望するものを無頓着な希望に委ね、気に入らないものを突き放すのに最高の理性を用いる」[47]。イタリアの詩人ダンテ・アリギエー リ(1265年~ 1321)は『神曲』の中で、聖トマス・アクィナスが楽園でダンテに警告する場面をこう記している。「意見は、性急であればあるほど、しばしば誤った方向 に傾く。そして、自分の意見に対する愛着が、心を縛り、閉じ込める」。[48] イブン・ハルドゥーンは『ムカディマ』の中で、同様の影響に気づいていた:[49] 虚偽は、歴史的情報を当然苦しめる。これを避けることができない理由はさまざまある。その一つは、意見や学派に対する偏りである。... 特定の意見や宗派に対する偏りが心に染みついている場合、その意見や宗派に都合の良い情報はためらうことなく受け入れられる。偏見や党派心は批判的思考を 鈍らせ、批判的な調査を妨げる。その結果、虚偽が受け入れられ、広まっていく。 イギリスの哲学者であり科学者でもあったフランシス・ベーコン(1561年~1626年)[50]は、『ノヴム・オルガヌム』の中で、証拠の偏った評価が 「占星術、夢、前兆、神の判断など、あらゆる迷信」を生み出していると指摘している[51]。彼は次のように書いている[51]。 いったん意見を受け入れた人間の理解力は、それを支持し、それに同意するようにあらゆるものを引き寄せる。そして反対側に多くの事例やより重要な事例があ るにもかかわらず、それらは無視されたり軽蔑されたり、あるいは何らかの区別によって無視されたり拒否されたりしている[。 ドイツの哲学者アルトゥール・ショーペンハウアーは、『意志と表象としての世界』(1844年)の第2巻で、「採用された仮説は、それを裏付けるものには 鋭い目を向け、それと矛盾するものには盲目にする」と指摘している[52]。それを裏付けるものには鋭い洞察力を与え、それに反するものはすべて見えなく してしまう」[52]。 ロシアの小説家レフ・トルストイは、1897年に発表したエッセイ『芸術とは何か』の中で次のように書いている[53]。 私は、ほとんどの男性は――賢いとされる人だけでなく、非常に賢く、 最も難しい科学的、数学的、哲学的問題を理解できる非常に聡明な人物でさえ、おそらく苦労して得た結論の誤りを認めざるを得ないような場合、最も単純で明 白な真実でさえほとんど見抜くことができない。その結論は、彼らが誇りに思い、他人に教え、人生そのものを築いてきたものである。 トルストイは、1894年に発表したエッセイ『神の王国はあなたの中にある』の中で、次のように書いている[54]。 最も難しいテーマでも、そのテーマについて何も考えていない鈍い人でも説明できる。しかし、最も賢い人でも、目の前に提示されたことをすでに疑いなく知っていると固く確信している場合は、最も簡単なことでも理解できない。 仮説検証(反証)的説明(ワソン メイン記事:ワソン選択課題 ピーター・ワソンが1960年に発表した最初の実験(この実験では「確証バイアス」という言葉は使用されていない)では、参加者に数字の3つの組に適用さ れる規則を識別するよう繰り返し挑戦させた。参加者は(2,4,6)がその規則に当てはまると教えられた。参加者は3つの数からなる組を生成し、実験者は それぞれの組がそのルールに当てはまるかどうかを伝えた[3]: 179 実際のルールは単に「昇順の並び」という単純なものであったが、参加者はそれを発見するのに非常に苦労し、しばしば「真ん中の数は最初と最後の数の平均で ある」など、はるかに具体的なルールを提示することが多かった[55]。参加者は、自分の仮説したルールに従う組、つまり肯定的な例だけをテストしている ように見えた。例えば、彼らが「各数字は、その前の数字よりも2だけ大きい」というルールを考えた場合、彼らはこのルールに当てはまる(確認する)トリプ ル、例えば(11、13、15)を提供するが、このルールに違反する(偽造する)トリプル、例えば(11、12、19)は提供しないだろう[56]。 Wasonは、この結果を、偽造よりも確認を好むことを示すものと解釈し、それゆえ「確認バイアス」という用語を考案した [c][58] ワソンは、選択課題の実験結果の説明にも確認バイアスを用いた[59]。参加者は、このテストのさまざまな形式で繰り返し悪い成績を収め、ほとんどの場 合、指定されたルールを反証(偽造)する可能性のある情報を無視した[60][61]。 仮説検定(ポジティブテスト戦略)の説明(クレイマンとハー) クレイマンとハーの1987年の論文は、ワソン 実験は、確認バイアスではなく、仮説と一致するテストを行う傾向を示している。[16][62] 彼らはこれを「ポジティブテスト戦略」と呼んだ。[11] この戦略は、不完全だが計算しやすい推論の近道であるヒューリスティックの一例である。[63] クライマンとハーは、ワソンが用いた反証主義ではなく、ベイズの確率と情報理論を仮説検定の基準として使用した。これらの考え方によると、質問に対する答 えは人によって異なる情報量をもたらす。つまり、仮説を科学的に検証するとは、最も多くの情報をもたらすものを選択することである。情報量は初期確率に依 存するため、肯定的検証は有益な情報をもたらす場合もあれば、有益な情報をもたらさない場合もある。KlaymanとHaは、人々が現実的な問題について 考えるとき、初期確率が低い特定の答えを求めている、と主張した。この場合、肯定的なテストは通常、否定的なテストよりも有益であることが多い[16]。 しかし、ワソンのルール発見課題では、答え(昇順の3つの数字)が非常に広範囲にわたるため、肯定的なテストが有益な答えをもたらす可能性は低い。 KlaymanとHaは、「ルールに当てはまる」と「ルールに当てはまらない」の代わりに「DAX」と「MED」というラベルを使用した実験を引用するこ とで、自分たちの分析を裏付けた。これにより、低確率のルールを見つけることが目的であるとの誤解を避けることができた。参加者はこのバージョンの実験 で、はるかに高い成功を収めた[64][65]。  すべての可能なトリプルの中で、真のルールに当てはまるものは、図式的に円で示される。仮説上のルールは、その中に囲まれた小さな円である。 真のルール(T)が現在の仮説(H)を包含している場合、肯定的なテスト(HがTであるかどうかを調べる)では、仮説が誤りであると示されない。 2つの重なり合う円は、真のルールと仮説上のルールを表す。2つの円の重なり合わない部分に当てはまる観測結果は、2つのルールが完全に一致していないことを示す。言い換えれば、それらの観測結果は仮説を否定することになる。 真のルール(T)が現在の仮説(H)と重なる場合、否定的なテストまたは肯定的なテストのいずれかがHを否定する可能性が出てくる。 仮説に当てはまるトリプルは、すべてのトリプルの集合の中で円として表される。真のルールは、この中のさらに小さな円として表される。 作業仮説(H)が真のルール(T)を含む場合、Hを反証する唯一の方法は肯定的なテストである。 この批判やその他の批判を踏まえ、研究の中心は仮説の検証と反証から、人々が仮説を情報的に検証するのか、それとも非情報的だが肯定的に検証するのかとい う検証方法へと移っていった。「真実」の確認バイアスを求める心理学者たちは、人々が情報を処理する方法における幅広い影響に注目した[66]。 情報処理による説明 現在、確認バイアスを説明する情報処理による説明は主に 3 つあり、さらに最近追加されたものもある。 認知的 vs 動機的  嬉しい出来事はより記憶に残りやすい。 ロバート・マックカウンによると、偏った証拠処理の大半は、「コールド」(認知的)メカニズムと「ホット」(動機づけ)メカニズムの組み合わせによって生じる[67]。 確証バイアスに対する認知的説明は、複雑なタスクを処理する人間の能力の限界と、ヒューリスティックと呼ばれるその人間の使用している近道に基づいている [68]。例えば、人々は証拠の信頼性を、特定の考えがどれだけ容易に頭に浮かぶかという「利用可能性ヒューリスティック」を使って判断する場合がある [69]。特定の考えがどれだけ容易に頭に浮かぶか、ということである[69]。また、人は一度に一つの考えにしか集中できないため、並行して複数の仮説 を検証することが難しい可能性もある[3]: 198–199 。もう一つのヒューリスティックは、KlaymanとHaが特定したポジティブテスト戦略 である。これは、ある特性や事象が起こると思われる事例を検証することで仮説を検証する方法である。この発見的手法は、各質問がどの程度診断的であるかを 考えるという困難または不可能な作業を回避する。しかし、この方法は万能ではなく、人々は既存の信念に対する課題を無視してしまう可能性がある[16] [3]: 200 動機付けの説明は、信念に対する欲求の影響を含む[3]: 197 [70]。。これは「ポリアナの原理」と呼ばれている。[71] 議論や証拠の根拠に適用すると、望ましい結論がより真実であると信じられやすい理由を説明できる可能性がある。結論の妥当性を操作する実験によると、人々 は好ましくないアイデアに対しては高い水準の証拠を要求し、好ましいアイデアに対しては低い水準の証拠で満足する。言い換えれば、ある提案に対しては「こ れを信じていいのだろうか」と問い、別の提案に対しては「これを信じなければならないのだろうか」と問うのである[72][73]。一貫性は態度の望まし い特徴であるが、一貫性を求めすぎることは、新しい驚くべき情報を中立的に評価することを妨げる可能性があるため、偏りのもう一つの潜在的な原因となる。 社会心理学者ジヴァ・クンダは、認知理論と動機付け理論を結びつけ、動機付けが偏りを生み出すが、認知的要因がその影響の大きさを決定すると主張している [3]: 198 費用対効果 費用対効果分析による説明は、人々が 無関心な態度で仮説を検証するのではなく、さまざまなエラーのコストを評価する[74]。進化心理学の考え方を応用し、ジェームズ・フリードリッヒは、人 々は仮説を検証する際に真実を第一の目的としているのではなく、最もコストのかかるエラーを回避しようとしていると示唆している。例えば、雇用主が面接で 一方的な質問をするのは、不適格な候補者をふるい落とすことに重点を置いているためである[75]。ヤコブ・トロペとアキバ・リーバーマンのこの理論の改 良版では、人々は2つの異なる種類のエラーを比較すると仮定している。例えば、友人の正直さを過小評価する人は、その人を疑いの目で見ることになり、友情 を損なう可能性がある。友人の誠実さを過大評価することも、同様にコストがかかる可能性があるが、その程度は低い。この場合、偏った方法で彼らの正直さの 証拠を求めたり、評価したり、思い出したりすることは合理的である[76]。誰かが内向的または外向的であるという第一印象を与える場合、その印象に一致 する質問はより共感的に受け取られる [77] つまり、内向的と思われる人と話すときは、「騒々しいパーティーは好きですか?」ではなく、「社交的な場面で気まずく感じませんか?」と尋ねる方が、社交 スキルが高いことの表れであるといえる。確認バイアスと社会性の関連性は、大学生が他人と知り合いになる方法について行われた研究によって裏付けられた。 自己監視能力が高く、環境や社会的規範に敏感な学生は、学生同士の知り合いになる場合よりも、地位の高いスタッフにインタビューする場合により多くのマッ チング質問をした[77]。 探索的思考と確認的思考 心理学者ジェニファー・ラーナーとフィリップ・テトロックは、思考プロセスを2つの異なる種類に分類している。探索的思考は、特定の立場に対するあらゆる 反論を予測しようと、複数の視点を中立的に考慮する。一方、確認的思考は、特定の視点を正当化しようとする。LernerとTetlockは、自分の意見 をすでに知っている相手に対して正当化する必要がある場合、人はその相手と同じような立場を取り、自分の信頼性を高めるために確認的思考を用いる傾向があ る、と述べる。しかし、外部の人々が攻撃的すぎたり批判的すぎたりする場合は、人は思考から完全に手を引き、正当化することなく個人的な意見を主張する。 ラーナーとテトロックは、人々が批判的かつ論理的に考えるよう自らを駆り立てる場合、それは、知識が豊富で、真実を純粋に知りたいと思っている人々に対し て、自分の意見を説明する必要があるとあらかじめ分かっている場合だけだと述べている。このような状況はめったに存在しないため、ほとんどの人はほとんど の場合、確認的思考を用いていると彼らは主張している[78][79][80]。 ごっこ遊び 発達心理学者イヴ・ウィットモアは、確証バイアスに関わる信念や偏見は、子どもの頃に「ごっこ遊び」を通して対処した経験に根ざしており、それが「大人に なってからのより複雑な自己欺瞞や幻想の基盤」になると主張している。思春期において批判的思考が発達する過程で疑問を持つことによる摩擦は、誤った信念 の合理化につながり、そのような合理化の習慣は長年にわたって無意識のものとなる可能性がある[81]。 |

| Real-world effects Social media In social media, confirmation bias is amplified by the use of filter bubbles, or "algorithmic editing", which displays to individuals only information they are likely to agree with, while excluding opposing views.[82] Some have argued that confirmation bias is the reason why society can never escape from filter bubbles, because individuals are psychologically hardwired to seek information that agrees with their preexisting values and beliefs.[83] Others have further argued that the mixture of the two is degrading democracy—claiming that this "algorithmic editing" removes diverse viewpoints and information—and that unless filter bubble algorithms are removed, voters will be unable to make fully informed political decisions.[84][82] The rise of social media has contributed greatly to the rapid spread of fake news, that is, false and misleading information that is presented as credible news from a seemingly reliable source. Confirmation bias (selecting or reinterpreting evidence to support one's beliefs) is one of three main hurdles cited as to why critical thinking goes astray in these circumstances. The other two are shortcut heuristics (when overwhelmed or short of time, people rely on simple rules such as group consensus or trusting an expert or role model) and social goals (social motivation or peer pressure can interfere with objective analysis of facts at hand).[85] In combating the spread of fake news, social media sites have considered turning toward "digital nudging".[86] This can currently be done in two different forms of nudging. This includes nudging of information and nudging of presentation. Nudging of information entails social media sites providing a disclaimer or label questioning or warning users of the validity of the source while nudging of presentation includes exposing users to new information which they may not have sought out but could introduce them to viewpoints that may combat their own confirmation biases.[87] Science and scientific research See also: Planck's principle, Escalation of commitment, and Replication crisis A distinguishing feature of scientific thinking is the search for confirming or supportive evidence (inductive reasoning) as well as falsifying evidence (deductive reasoning).[88][89] Many times in the history of science, scientists have resisted new discoveries by selectively interpreting or ignoring unfavorable data.[3]: 192–194 Several studies have shown that scientists rate studies that report findings consistent with their prior beliefs more favorably than studies reporting findings inconsistent with their previous beliefs.[9][90][91] However, assuming that the research question is relevant, the experimental design adequate and the data are clearly and comprehensively described, the empirical data obtained should be important to the scientific community and should not be viewed prejudicially, regardless of whether they conform to current theoretical predictions.[91] In practice, researchers may misunderstand, misinterpret, or not read at all studies that contradict their preconceptions, or wrongly cite them anyway as if they actually supported their claims.[92] Further, confirmation biases can sustain scientific theories or research programs in the face of inadequate or even contradictory evidence.[60][93] The discipline of parapsychology is often cited as an example.[94] An experimenter's confirmation bias can potentially affect which data are reported. Data that conflict with the experimenter's expectations may be more readily discarded as unreliable, producing the so-called file drawer effect. To combat this tendency, scientific training teaches ways to prevent bias.[95] For example, experimental design of randomized controlled trials (coupled with their systematic review) aims to minimize sources of bias.[95][96] The social process of peer review aims to mitigate the effect of individual scientists' biases, even though the peer review process itself may be susceptible to such biases[97][98][91][99][100] Confirmation bias may thus be especially harmful to objective evaluations regarding nonconforming results since biased individuals may regard opposing evidence to be weak in principle and give little serious thought to revising their beliefs.[90] Scientific innovators often meet with resistance from the scientific community, and research presenting controversial results frequently receives harsh peer review.[101] Finance See also: Escalation of commitment and Sunk cost Confirmation bias can lead investors to be overconfident, ignoring evidence that their strategies will lose money.[10][102] In studies of political stock markets, investors made more profit when they resisted bias. For example, participants who interpreted a candidate's debate performance in a neutral rather than partisan way were more likely to profit.[103] To combat the effect of confirmation bias, investors can try to adopt a contrary viewpoint "for the sake of argument".[104] In one technique, they imagine that their investments have collapsed and ask themselves why this might happen.[10] Medicine and health Cognitive biases are important variables in clinical decision-making by medical general practitioners (GPs) and medical specialists. Two important ones are confirmation bias and the overlapping availability bias. A GP may make a diagnosis early on during an examination, and then seek confirming evidence rather than falsifying evidence. This cognitive error is partly caused by the availability of evidence about the supposed disorder being diagnosed. For example, the client may have mentioned the disorder, or the GP may have recently read a much-discussed paper about the disorder. The basis of this cognitive shortcut or heuristic (termed anchoring) is that the doctor does not consider multiple possibilities based on evidence, but prematurely latches on (or anchors to) a single cause.[105] In emergency medicine, because of time pressure, there is a high density of decision-making, and shortcuts are frequently applied. The potential failure rate of these cognitive decisions needs to be managed by education about the 30 or more cognitive biases that can occur, so as to set in place proper debiasing strategies.[106] Confirmation bias may also cause doctors to perform unnecessary medical procedures due to pressure from adamant patients.[107] Raymond Nickerson, a psychologist, blames confirmation bias for the ineffective medical procedures that were used for centuries before the arrival of scientific medicine.[3]: 192 If a patient recovered, medical authorities counted the treatment as successful, rather than looking for alternative explanations such as that the disease had run its natural course. Biased assimilation is a factor in the modern appeal of alternative medicine, whose proponents are swayed by positive anecdotal evidence but treat scientific evidence hyper-critically.[108][109][110] Cognitive therapy was developed by Aaron T. Beck in the early 1960s and has become a popular approach.[111] According to Beck, biased information processing is a factor in depression.[112] His approach teaches people to treat evidence impartially, rather than selectively reinforcing negative outlooks.[50] Phobias and hypochondria have also been shown to involve confirmation bias for threatening information.[113] Politics, law and policing  A woman and a man reading a document in a courtroom Mock trials allow researchers to examine confirmation biases in a realistic setting. Nickerson argues that reasoning in judicial and political contexts is sometimes subconsciously biased, favoring conclusions that judges, juries or governments have already committed to.[3]: 191–193 Since the evidence in a jury trial can be complex, and jurors often reach decisions about the verdict early on, it is reasonable to expect an attitude polarization effect. The prediction that jurors will become more extreme in their views as they see more evidence has been borne out in experiments with mock trials.[114][115] Both inquisitorial and adversarial criminal justice systems are affected by confirmation bias.[116] Confirmation bias can be a factor in creating or extending conflicts, from emotionally charged debates to wars: by interpreting the evidence in their favor, each opposing party can become overconfident that it is in the stronger position.[117] On the other hand, confirmation bias can result in people ignoring or misinterpreting the signs of an imminent or incipient conflict. For example, psychologists Stuart Sutherland and Thomas Kida have each argued that U.S. Navy Admiral Husband E. Kimmel showed confirmation bias when playing down the first signs of the Japanese attack on Pearl Harbor.[60][118] A two-decade study of political pundits by Philip E. Tetlock found that, on the whole, their predictions were not much better than chance. Tetlock divided experts into "foxes" who maintained multiple hypotheses, and "hedgehogs" who were more dogmatic. In general, the hedgehogs were much less accurate. Tetlock blamed their failure on confirmation bias, and specifically on their inability to make use of new information that contradicted their existing theories.[119] In police investigations, a detective may identify a suspect early in an investigation, but then sometimes largely seek supporting or confirming evidence, ignoring or downplaying falsifying evidence.[120] Social psychology Social psychologists have identified two tendencies in the way people seek or interpret information about themselves. Self-verification is the drive to reinforce the existing self-image and self-enhancement is the drive to seek positive feedback. Both are served by confirmation biases.[121] In experiments where people are given feedback that conflicts with their self-image, they are less likely to attend to it or remember it than when given self-verifying feedback.[122][123][124] They reduce the impact of such information by interpreting it as unreliable.[122][125][126] Similar experiments have found a preference for positive feedback, and the people who give it, over negative feedback.[121] Mass delusions Confirmation bias can play a key role in the propagation of mass delusions. Witch trials are frequently cited as an example.[127][128] For another example, in the Seattle windshield pitting epidemic, there seemed to be a "pitting epidemic" in which windshields were damaged due to an unknown cause. As news of the apparent wave of damage spread, more and more people checked their windshields, discovered that their windshields too had been damaged, thus confirming belief in the supposed epidemic. In fact, the windshields were previously damaged, but the damage went unnoticed until people checked their windshields as the delusion spread.[129] Paranormal beliefs One factor in the appeal of alleged psychic readings is that listeners apply a confirmation bias which fits the psychic's statements to their own lives.[130] By making a large number of ambiguous statements in each sitting, the psychic gives the client more opportunities to find a match. This is one of the techniques of cold reading, with which a psychic can deliver a subjectively impressive reading without any prior information about the client.[130] Investigator James Randi compared the transcript of a reading to the client's report of what the psychic had said, and found that the client showed a strong selective recall of the "hits".[131] As a striking illustration of confirmation bias in the real world, Nickerson mentions numerological pyramidology: the practice of finding meaning in the proportions of the Egyptian pyramids.[3]: 190 There are many different length measurements that can be made of, for example, the Great Pyramid of Giza and many ways to combine or manipulate them. Hence it is almost inevitable that people who look at these numbers selectively will find superficially impressive correspondences, for example with the dimensions of the Earth.[3]: 190 Recruitment and selection Unconscious cognitive bias (including confirmation bias) in job recruitment affects hiring decisions and can potentially prohibit a diverse and inclusive workplace. There are a variety of unconscious biases that affects recruitment decisions but confirmation bias is one of the major ones, especially during the interview stage.[132] The interviewer will often select a candidate that confirms their own beliefs, even though other candidates are equally or better qualified. |

現実世界への影響 ソーシャルメディア ソーシャルメディアでは、フィルターバブル、つまり「アルゴリズム編集」の使用により、確証バイアスが拡大される。フィルターバブルとは、個々人が賛成し そうな情報のみを表示し、反対意見は排除する仕組みである[82]。確証バイアスが、社会がフィルターバブルから抜け出せない理由だと主張する者もいる。 なぜなら、個々人は心理的に、既存の価値観や信念に一致する情報を求めるようにできているからだ[83]。さらに、この2つの混合が民主主義を衰退させて いる、と主張する者もいる。この「アルゴリズム編集」が多様な視点や情報を排除していると主張し、フィルターバブルアルゴリズムが除去されない限り、有権 者は十分に情報に基づいた政治的決定を下すことができないとしている[84][82]。 ソーシャルメディアの台頭は、フェイクニュースの急速な拡散に大きく貢献している。フェイクニュースとは、一見信頼のおける情報源から発信された信頼でき るニュースのように見せかけた、虚偽または誤解を招く情報のことである。このような状況下で批判的思考が迷走してしまう理由として、確認バイアス(自分の 信念を裏付ける証拠を選択したり、解釈し直したりする)が挙げられている。残りの 2 つは、近道ヒューリスティクス(圧倒されたり時間に余裕がない場合、人々はグループでの合意や専門家やロールモデルを信頼するといった単純なルールに頼 る)と社会的目標(社会的動機付けや同調圧力は、目の前の事実の客観的分析を妨げる可能性がある)である[85]。 フェイクニュースの拡散に対抗するため、ソーシャルメディアサイトは「デジタル・ナッジング」の導入を検討している[86]。これは現在、2つの異なる形 態のナッジングとして実施できる。これには、情報の「ナッジング」と提示の「ナッジング」がある。情報の「ナッジング」とは、ソーシャルメディアサイトが 情報源の正当性についてユーザーに疑問を投げかけたり警告したりする免責事項やラベルを表示することであり、提示の「ナッジング」とは、ユーザーが自ら探 し出さなかった新しい情報を提示することで、自身の確証バイアスと対立する視点を紹介することである[87]。 科学と科学研究 関連項目: プランクの原理、コミットメントのエスカレーション、再現の危機 科学的な思考の特徴は、証拠を偽造する(演繹的推論)だけでなく、証拠を裏付けるか支持する証拠を探すことである(帰納的推論)。[88][89] 科学の歴史において、科学者は都合の悪いデータを選択的に解釈したり無視したりすることで、新しい発見に抵抗してきたことが何度もあった。[3]: 192–194 いくつかの研究では、科学者は、 それまでの信念と一致する結果の報告よりも、それまでの信念と一致しない結果の報告を好意的に評価する傾向があることが、いくつかの研究で明らかになって いる[9][90][91]。 しかし、研究課題が適切であり、実験計画が適切で、データが明確かつ包括的に記述されていると仮定すれば、得られた経験的データは科学界にとって重要であ り、現在の理論的予測と一致しているかどうかに関わらず、偏見を持って見なされるべきではない[91]。実際には、研究者は 、誤って解釈したり、あるいは先入観に反する研究をまったく読まない、あるいは間違って引用して、あたかもそれが自分の主張を裏付けるかのように扱う可能 性がある[92]。 さらに、確証バイアスは、不適切あるいは矛盾する証拠がある場合でも、科学理論や研究プログラムを正当化する可能性がある[60][93]。超心理学はしばしばその例として引用される[94]。 実験者の確証バイアスは、報告されるデータに影響を与える可能性がある。実験者の期待に反するデータは、信頼性に欠けるとしてより容易に破棄され、いわゆ るファイルドロワー効果が生じる可能性がある。この傾向に対抗するため、科学的なトレーニングでは偏りを防ぐ方法を教えている[95]。例えば、ランダム 化比較試験(系統的レビューと組み合わせた)の実験デザインは、偏りの原因を最小限に抑えることを目的としている[95][96]。 ピアレビューという社会的プロセスは、個々の科学者の偏りの影響を軽減することを目的としているが、ピアレビュープロセス自体がそのような偏りに影響を受 けやすい場合もある[97][98 ][91][99][100] 確認バイアスは、偏った個人が反対の証拠を原則として弱いと見なし、自分の信念を修正することを真剣に考えない可能性があるため、特に、適合しない結果に 関する客観的評価に有害である可能性がある[90]。科学的な革新者はしばしば科学界からの抵抗に直面し、物議を醸す結果を発表する研究は厳しいピアレ ビューを受けることが多い[101]。 金融 関連項目: コミットメントのエスカレーションとサンクコスト 確認バイアスは、投資家が自信過剰になり、彼らの戦略が損失を出すという証拠を無視する原因となる可能性がある[10][102]。政治株式市場の調査で は、投資家がバイアスに抵抗すると、より多くの利益を得ることができた。例えば、候補者の討論のパフォーマンスを党派的な見方ではなく中立的な見方で解釈 した参加者は、利益を得やすい傾向があった[103]。確認バイアスの影響を克服するために、投資家は「議論のため」に反対の視点を取り入れるように試み ることができる[104]。あるテクニックでは、投資が破綻したと想像し、なぜそのようなことが起こりうるかを自問する[10]。 医学と健康 認知バイアスは、開業医や専門医による臨床的意思決定において重要な変数である。重要なものとしては、確証バイアスとオーバーラップバイアスがある。開業 医は診察の初期段階で診断を下し、その後、証拠を捏造するのではなく、それを裏付ける証拠を探すことがある。この認知エラーは、診断された障害に関する証 拠が入手可能であることが原因の一部である。例えば、患者がその疾患について言及していたり、医師がその疾患について最近話題になった論文を読んだりして いたりする可能性がある。この認知の近道や発見的思考(アンカリングと呼ばれる)の根底にあるのは、医師が証拠に基づいて複数の可能性を考慮するのではな く、一つの原因に早まって固執(アンカー)してしまうことである[105]。救急医療では時間的制約があるため、意思決定の密度が高く、近道が頻繁に適用 される。このような認知的判断の失敗率を管理するには、起こりうる 30 以上の認知バイアスに関する教育を行い、適切な脱バイアス戦略を策定する必要がある[106]。また、確証バイアスにより、頑固な患者の圧力から、医師が 不要な医療処置を行う可能性もある[107]。 心理学者レイモンド・ニッカーソンは、科学的医療が確立される何世紀も前から用いられていた非効果的な医療処置の原因を確証バイアスに求めている[3]: 192 。患者が回復した場合、医療当局は、病気が自然経過をたどったなど、別の説明を探すのではなく、その治療を成功とみなした。現代における代替医 療の流行には、偏った同化という要因がある。代替医療の支持者は、肯定的な逸話的証拠に左右されるが、科学的証拠には過度に批判的である[108] [109][110]。 認知療法は、アーロン・T・ベックによって1960年代初頭に開発され、広く普及している[111]。ベックによると、偏った情報処理は うつ病の一因である[112]。彼のアプローチは、人々に対して、ネガティブな見通しを選択的に強化するのではなく、証拠を公平に扱うことを教えるもので ある[50]。恐怖症や心気症も、脅威となる情報に対して確証バイアスが関与することが示されている[113]。 政治、法律、警察  法廷で書類を読む女性と男性 模擬裁判は、研究者が現実的な設定で確証バイアスを検証することを可能にする。 Nickersonは、司法や政治の文脈における推論は、時に無意識のうちに偏りが生じ、裁判官や陪審員、政府がすでに固執している結論を後押しすること があると主張している[3]: 191–193。陪審員裁判の証拠は複雑になりがちであり、陪審員は判決について早い段階で決定を下すことが多いことか ら、態度の二極化効果が起こることは当然予想できる。陪審員は証拠を目にするにつれ、より極端な見解を持つようになるという予測は、模擬裁判の実験で実証 されている[114][115]。 確証バイアスは、感情的な議論から戦争に至るまで、対立を生み出す、あるいは拡大する要因となりうる。感情的な議論から戦争に至るまで、対立を生み出す、 あるいは拡大させる要因となりうる。証拠を自分たちに有利に解釈することで、対立する各当事者は、自分たちがより強い立場にあると過信してしまう可能性が ある[117]。一方、確証バイアスは、差し迫った、あるいは発生しつつある対立の兆候を人々が無視したり、誤って解釈したりすることにつながる可能性が ある。例えば、心理学者スチュアート・サザーランドとトーマス・キダは、それぞれ、日本軍による真珠湾攻撃の最初の兆候を軽視したアメリカ海軍提督ハズバ ンド・E・キンメルが確証バイアスに陥っていたと主張している[60][118]。 フィリップ・E・テトロックによる政治評論家に関する20年にわたる研究では、彼らの予測は全体として、偶然による予測と大差ないことがわかった。テト ロックは、複数の仮説を主張する「キツネ」と、より独断的な「ハリネズミ」に専門家を分類した。 一般的に、ハリネズミははるかに正確性が低かった。テトロックは彼らの失敗を確証バイアス、特に既存の理論と矛盾する新しい情報を活用できないことに起因 するとした[119]。 警察の捜査では、刑事は捜査の初期段階で容疑者を特定することがあるが、その後、偽造証拠を無視したり軽視したりしながら、裏付けや確認となる証拠を主に探すことがある[120]。 社会心理学 社会心理学者は、人々が自分自身に関する情報を求める、あるいは解釈する方法について、2つの傾向を特定している。自己検証とは、既存の自己イメージを強 化しようとする衝動であり、自己強化とは、肯定的なフィードバックを求める衝動である。どちらも確証バイアスによって強化される[121]。自己イメージ と相反するフィードバックが与えられた場合、人々はそれをあまり気に留めず、またそれを覚えておくこともあまりない。自己イメージを確認するフィードバッ クが与えられた場合よりもその傾向が強い[122][123][ 124] 人はそのような情報を信頼できないと解釈することで、その影響力を弱めるのである[122][125][126]。同様の実験では、否定的なフィードバッ クよりも肯定的なフィードバック、そしてそれを与える人に対する好みが確認されている[121]。 集団妄想 確証バイアスは、集団妄想の伝播において重要な役割を果たすことがある。 魔女裁判はその例としてよく挙げられる[127][128]。 別の例として、シアトルで発生したフロントガラスのピッティング現象では、原因不明のフロントガラスの損傷が「流行」したかのように見えた。被害が相次い でいるというニュースが広まると、ますます多くの人が自分の車のフロントガラスを確認し、自分のフロントガラスにも傷があることに気づき、その流行病説を 裏付けることになった。実際には、フロントガラスは以前から傷ついていたが、この被害が広まるにつれ人々がフロントガラスを確認するまで、その被害に気づ かなかったのである[129]。 超常現象への信仰 超能力による占いとされるものの魅力の1つは、聞き手が超能力者の発言を自分の人生に当てはめるという確認バイアスを働かせることである[130]。超能 力者は、各セッションで曖昧な発言を数多く行うことで、クライアントが一致点を見つける機会を増やす。これはコールドリーディングの手法の1つであり、サ イキックはクライアントに関する事前情報なしに、主観的に印象的なリーディングを行うことができる[130]。調査員ジェームズ・ランディは、リーディン グの書き起こしとサイキックが言ったことについてのクライアントの報告を比較し、クライアントが「当たり」について強い選択的想起をしていることを発見し た[1 31] 現実世界における確証バイアスの顕著な例として、ニッカーソンは数秘ピラミッド学について言及している。これは、エジプトのピラミッドの比率に意味を見出 すという手法である[3]: 190。ギザの大ピラミッドなどには、さまざまな長さの測定値があり、それらを組み合わせたり操作したりする方法は数多くあ る。したがって、これらの数字を恣意的に解釈する人々は、例えば地球の寸法との表面的な一致を印象的に見いだしてしまうことはほぼ避けられない。 採用と選考 採用における無意識の認知バイアス(確認バイアスを含む)は、採用決定に影響を与え、多様性と包括性のある職場を妨げる可能性がある。採用決定に影響を与 える無意識の偏見にはさまざまなものがあるが、特に面接の段階では、確証バイアスが主要な偏見の 1 つである[132]。面接官は、他の候補者が同程度またはそれ以上の資格を持っているにもかかわらず、自分の信念を裏付ける候補者を採用することが多い。 |

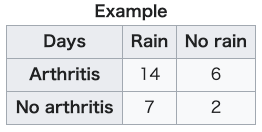

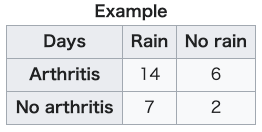

| Associated effects and outcomes Polarization of opinion Main article: Attitude polarization When people with opposing views interpret new information in a biased way, their views can move even further apart. This is called "attitude polarization".[133] The effect was demonstrated by an experiment that involved drawing a series of red and black balls from one of two concealed "bingo baskets". Participants knew that one basket contained 60 percent black and 40 percent red balls; the other, 40 percent black and 60 percent red. The experimenters looked at what happened when balls of alternating color were drawn in turn, a sequence that does not favor either basket. After each ball was drawn, participants in one group were asked to state out loud their judgments of the probability that the balls were being drawn from one or the other basket. These participants tended to grow more confident with each successive draw—whether they initially thought the basket with 60 percent black balls or the one with 60 percent red balls was the more likely source, their estimate of the probability increased. Another group of participants were asked to state probability estimates only at the end of a sequence of drawn balls, rather than after each ball. They did not show the polarization effect, suggesting that it does not necessarily occur when people simply hold opposing positions, but rather when they openly commit to them.[134] A less abstract study was the Stanford biased interpretation experiment, in which participants with strong opinions about the death penalty read about mixed experimental evidence. Twenty-three percent of the participants reported that their views had become more extreme, and this self-reported shift correlated strongly with their initial attitudes.[27] In later experiments, participants also reported their opinions becoming more extreme in response to ambiguous information. However, comparisons of their attitudes before and after the new evidence showed no significant change, suggesting that the self-reported changes might not be real.[30][133][135] Based on these experiments, Deanna Kuhn and Joseph Lao concluded that polarization is a real phenomenon but far from inevitable, only happening in a small minority of cases, and it was prompted not only by considering mixed evidence, but by merely thinking about the topic.[133] Charles Taber and Milton Lodge argued that the Stanford team's result had been hard to replicate because the arguments used in later experiments were too abstract or confusing to evoke an emotional response. The Taber and Lodge study used the emotionally charged topics of gun control and affirmative action.[30] They measured the attitudes of their participants towards these issues before and after reading arguments on each side of the debate. Two groups of participants showed attitude polarization: those with strong prior opinions and those who were politically knowledgeable. In part of this study, participants chose which information sources to read, from a list prepared by the experimenters. For example, they could read the National Rifle Association's and the Brady Anti-Handgun Coalition's arguments on gun control. Even when instructed to be even-handed, participants were more likely to read arguments that supported their existing attitudes than arguments that did not. This biased search for information correlated well with the polarization effect.[30] The backfire effect is a name for the finding that given evidence against their beliefs, people can reject the evidence and believe even more strongly.[136][137] The phrase was coined by Brendan Nyhan and Jason Reifler in 2010.[138] However, subsequent research has since failed to replicate findings supporting the backfire effect.[139] One study conducted out of the Ohio State University and George Washington University studied 10,100 participants with 52 different issues expected to trigger a backfire effect. While the findings did conclude that individuals are reluctant to embrace facts that contradict their already held ideology, no cases of backfire were detected.[140] The backfire effect has since been noted to be a rare phenomenon rather than a common occurrence[141] (compare the boomerang effect). Persistence of discredited beliefs Main article: Belief perseverance See also: Cognitive dissonance and Monty Hall problem Beliefs can survive potent logical or empirical challenges. They can survive and even be bolstered by evidence that most uncommitted observers would agree logically demands some weakening of such beliefs. They can even survive the total destruction of their original evidential bases. —Lee Ross and Craig Anderson[142] Confirmation biases provide one plausible explanation for the persistence of beliefs when the initial evidence for them is removed or when they have been sharply contradicted.[3]: 187 This belief perseverance effect has been first demonstrated experimentally by Festinger, Riecken, and Schachter. These psychologists spent time with a cult whose members were convinced that the world would end on 21 December 1954. After the prediction failed, most believers still clung to their faith. Their book describing this research is aptly named When Prophecy Fails.[143] The term belief perseverance, however, was coined in a series of experiments using what is called the "debriefing paradigm": participants read fake evidence for a hypothesis, their attitude change is measured, then the fakery is exposed in detail. Their attitudes are then measured once more to see if their belief returns to its previous level.[142] A common finding is that at least some of the initial belief remains even after a full debriefing.[144] In one experiment, participants had to distinguish between real and fake suicide notes. The feedback was random: some were told they had done well while others were told they had performed badly. Even after being fully debriefed, participants were still influenced by the feedback. They still thought they were better or worse than average at that kind of task, depending on what they had initially been told.[145] In another study, participants read job performance ratings of two firefighters, along with their responses to a risk aversion test.[142] This fictional data was arranged to show either a negative or positive association: some participants were told that a risk-taking firefighter did better, while others were told they did less well than a risk-averse colleague.[146] Even if these two case studies were true, they would have been scientifically poor evidence for a conclusion about firefighters in general. However, the participants found them subjectively persuasive.[146] When the case studies were shown to be fictional, participants' belief in a link diminished, but around half of the original effect remained.[142] Follow-up interviews established that the participants had understood the debriefing and taken it seriously. Participants seemed to trust the debriefing, but regarded the discredited information as irrelevant to their personal belief.[146] The continued influence effect is the tendency for misinformation to continue to influence memory and reasoning about an event, despite the misinformation having been retracted or corrected. This occurs even when the individual believes the correction.[147] Preference for early information Experiments have shown that information is weighted more strongly when it appears early in a series, even when the order is unimportant. For example, people form a more positive impression of someone described as "intelligent, industrious, impulsive, critical, stubborn, envious" than when they are given the same words in reverse order.[148] This irrational primacy effect is independent of the primacy effect in memory in which the earlier items in a series leave a stronger memory trace.[148] Biased interpretation offers an explanation for this effect: seeing the initial evidence, people form a working hypothesis that affects how they interpret the rest of the information.[3]: 187 One demonstration of irrational primacy used colored chips supposedly drawn from two urns. Participants were told the color distributions of the urns, and had to estimate the probability of a chip being drawn from one of them.[148] In fact, the colors appeared in a prearranged order. The first thirty draws favored one urn and the next thirty favored the other.[3]: 187 The series as a whole was neutral, so rationally, the two urns were equally likely. However, after sixty draws, participants favored the urn suggested by the initial thirty.[148] Another experiment involved a slide show of a single object, seen as just a blur at first and in slightly better focus with each succeeding slide.[148] After each slide, participants had to state their best guess of what the object was. Participants whose early guesses were wrong persisted with those guesses, even when the picture was sufficiently in focus that the object was readily recognizable to other people.[3]: 187 Illusory association between events Main article: Illusory correlation Illusory correlation is the tendency to see non-existent correlations in a set of data.[149] This tendency was first demonstrated in a series of experiments in the late 1960s.[150] In one experiment, participants read a set of psychiatric case studies, including responses to the Rorschach inkblot test. The participants reported that the homosexual men in the set were more likely to report seeing buttocks, anuses or sexually ambiguous figures in the inkblots. In fact the fictional case studies had been constructed so that the homosexual men were no more likely to report this imagery or, in one version of the experiment, were less likely to report it than heterosexual men.[149] In a survey, a group of experienced psychoanalysts reported the same set of illusory associations with homosexuality.[149][150] Another study recorded the symptoms experienced by arthritic patients, along with weather conditions over a 15-month period. Nearly all the patients reported that their pains were correlated with weather conditions, although the real correlation was zero.[151] |