情報倫理

Information

Ethics, Ethics of Information Processing

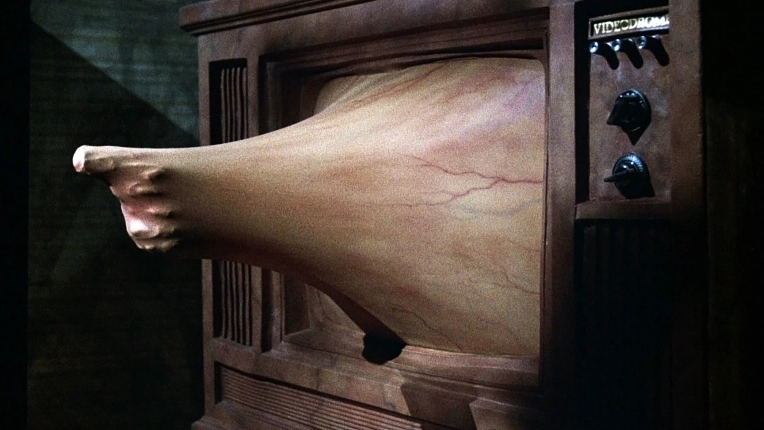

Videodrome,

directed by David Paul Cronenberg, 1982.

情報倫理(information

ethics)とは、情報の創造、組織、流通や配布・配信、利用などに関する一切の倫理規範(ethical

standards)と道徳コード(moral codes )に関することがらのことである。

情報処理学会の倫理綱領には、情報倫理を守るべき人として「社会 人、専門家、組織責任者」の3つのカテゴリーにわけて、それぞれ、4〜5項目の倫理要綱(コード)を掲載している。

つまり、社会人に は「1.1 他者の生命、安全、財産を侵害しない。1.2 他者の人格とプライバシーを尊重する。1.3 他者の知的財産権と知的成果を尊重する。1.4 情報システムや通信ネットワークの運用規則を遵守する。1.5 社会における文化の多様性に配慮する。」の5項目。

専門家に は、「2.1 たえず専門能力の向上に努め、業務においては最善を尽くす。2. 2 事実やデータを尊重する。2.3 情報処理技術がもたらす社会やユーザへの影響とリスクについて配慮する。2.4 依頼者との契約や合意を尊重し、依頼者の秘匿情報を守る。」の4項 目。

そして、組織責任者に は「3.1 情報システムの開発と運用によって影響を受けるすべての人々の要求に応 じ、その尊厳を損なわな いように配慮する。3.2 情報システムの相互接続について、管理方 針の異なる情報システムの存在することを認め、その接続がいかなる人々の人格をも侵害しないように配慮する。3.3 情報システムの開発と運用について、資源の正当かつ適切な利用のための規則を作成し、その実施 に責任を持つ。3.4 情報処理技術の原則、制約、リスクについて、 自己が属する組織の構成員が学ぶ機会を設ける。」の4項目である。

さらに、法令や他の社会的規範(たとえば「研究規 範」)などとの矛盾や齟齬をおこすことがらには「会員個人の判断」という、自己管理と自己責任もあることを謳っている。

つまり「本綱領は必ずしも会員個人が直面するすべて の場面に適用できるとは限らず、研究領域における他の倫理規範との矛盾が生じることや、個々の場面においてどの条項に準拠すべきであるか不明確(具体的な 行動に対して相互の条項が矛盾する場合を含む)であることもあり得る。したがって、具体的な場面における準拠条項の選択や優先度等の判断は、会員個人の責 任に委ねられるものとする」

また、同サイトには、情報倫理に造詣の深い名和小太 郎(倫理綱領調査委員会委員長)による「なぜ倫理綱領が 必要か」の付議もある。非常に重要な指摘であり、当該学会員以外の多くの一般の人にも必要な情報であるので、付記する。

関連する事項として「」「」があります。

■ アシロマAI会議(2017)におけるAI研究倫理(タグジャンプ→ASILOMAR AI PRINCIPLES)

| Code of Ethics of

the Information Processing Society of Japan Preamble: In recognition of information technologies having powerful and pervasive influence over society across national borders, and in the hope that information technologies will contribute to society and promote public welfare, we, the members of the Information Processing Society of Japan, shall abide by the following rules of conduct together with any applicable laws and orders in our research, development and use of information technologies. 1. As members of society: 1.1 We shall not cause harm to the life, safety and property of others. 1.2 We shall respect the person and privacy of others. 1.3 We shall honor intellectual property rights and the fruits of intellectual endeavors of others. 1.4 We shall observe the operational standards and rules of information systems and networks. 1.5 We shall give due consideration to cultural diversity in society. 2. As professionals: 2.1 We shall continuously strive to improve our professional competence and put in our best efforts in performing our professional works. 2.2 We shall honor facts and data. 2.3 We shall give due consideration to the influence and risks information technologies may impose upon society and users. 2.4 We shall honor contracts and agreements with clients and preserve the confidentiality of clients' privileged information. 3. As organizational leaders: 3.1 We shall meet the demands of all persons affected by the development and operation of information systems and give due consideration to preserving their dignity. 3.2 We shall, in interconnecting different information systems, acknowledge the existence of information systems with differing management policies, and give due consideration to such interconnection not causing harm to the person of any and all individuals. 3.3 We shall prepare rules for the proper and appropriate exploitation of resources with respect to the development and operation of information systems, and assume the responsibility of implementing such rules. 3.4 We shall provide opportunities to other members of organizations to which we belong to be educated in the principles, limitations and risks of information technologies. Note: This Code of Ethics will not necessarily be applicable to all situations a member would face, and it may conflict with other codes of ethics governing different areas of research, or it may be unclear which provision(s) hereof should govern in a given situation (including the case where certain provisions hereof conflict with each other with respect to a specific conduct). Therefore, it is the responsibility of each member himself or herself to make a determination as to the selection, prioritizing, etc., of the provision(s) hereof which should govern in a specific situation. Addendum: This Code of Ethics shall come into effect on 20 May, 1996. The Information Processing Society of Japan shall establish a committee, as needed, for the purpose of interpreting or reconsidering this Code of Ethics. cited from http://www.ipsj.or.jp/ipsjcode.html |

情報処理学会倫理綱領:http://www.ipsj.or.jp/ipsjcode.html 〈前文〉 我々情報処理学会会員は、情報処理技術が国境を越えて社会に対して強くかつ広い影響力を持つことを認識し、情報処理技術が社会に貢献し公益に寄 与することを願い、情報処理技術の研究、開発および利用にあたっては、適用される法令とともに、次の行動規範を遵守する。 〈1. 社会人として〉 1.1 他者の生命、安全、財産を侵害しない。 1.2 他者の人格とプライバシーを尊重する。 1.3 他者の知的財産権と知的成果を尊重する。 1.4 情報システムや通信ネットワークの運用規則を遵守する。 1.5 社会における文化の多様性に配慮する。 〈2.専門家として〉 2.1 たえず専門能力の向上に努め、業務においては最善を尽くす。 2.2 事実やデータを尊重する。 2.3 情報処理技術がもたらす社会やユーザへの影響とリスクについて配慮する。 2.4 依頼者との契約や合意を尊重し、依頼者の秘匿情報を守る。 〈3.組織責任者として〉 3.1 情報システムの開発と運用によって影響を受けるすべての人々の要求に応じ、その尊厳を損なわないように配慮する。 3.2 情報システムの相互接続について、管理方針の異なる情報システムの存在することを認め、その接続がいかなる人々の人格をも侵害しないように配慮す る。 3.3 情報システムの開発と運用について、資源の正当かつ適切な利用のための規則を作成し、その実施に責任を持つ。 3.4 情報処理技術の原則、制約、リスクについて、自己が属する組織の構成員が学ぶ機会を設ける。 注 本綱領は必ずしも会員個人が直面するすべての場面に適用できるとは限らず、研究領域における他の倫理規範との矛盾が生じることや、個々の場面においてど の条項に準拠すべきであるか不明確(具体的な行動に対して相互の条項が矛盾する場合を含む)であることもあり得る。したがって、具体的な場面における準拠 条項の選択や優先度等の判断は、会員個人の責任に委ねられるものとする。 本綱領は平成8(1996)年5月20日より施行する。 |

| ◎情報倫理の標準的な教科書編成 村田と折戸『情報倫理入門 : ICT社会におけるウェルビーイングの探求』ミネルヴァ書房、2021年 「スマートフォンのような情報機器や、SNSをはじめとするオンラインサービスは、私たちの生活をより便利にしている。しかし、その背後にはプライバシー や監視、ジェンダー、アイデンティティなどに関わるさまざまな倫理問題が存在している。こうした倫理問題に適切に対応し、真に豊かなICT社会を構築する ために、情報倫理への積極的な取り組みが、今まさに求められている」BOOK database, https://ci.nii.ac.jp/ncid/BC0643301X. 第1部 情報倫理とは何か 何が問題なのか ケースによる学び 情報化の進展と倫理問題 情報倫理の目的情報倫理の特質 第2部 情報倫理の諸問題 プライバシー 監視社会 ICTプロフェッショナリズム 情報社会における所有と共有 ジェンダーとコンピューティング 先端的ICTの倫理 情報倫理の未来—情報倫理研究者たちが描くこれからの情報倫理 ◎情報倫理を学ぶ人のためのリンク(サイト内) ソーシャル・ネット ワーク(映画)から入る情報倫理入門 コンピュータ倫理学 サイバー倫理学 情報収集 0620 情報メディア問題入門:2017 デジタル・メディアの理解 ビジネス倫理学 |

なぜ倫理綱領が必要か、名和小太郎(倫理綱領調査委員会委員長) なぜ、倫理綱領が必要か。 それは、情報処理技術が社会的に大きい影響力を持つアプリケーションを数多く産み出しつつあるという現実があり、これを受けて情報処理技術者は自己の行 動に対する責任を持たなければならないという考え方が生じてきたためである。 この視点で見たときに、情報処理技術者の環境はどうなっているのか。 第1に技術的な環境について。かつて情報処理技術のアプリケーションにかかわる関係者は開発者、メーカーはもちろんユーザまで専門家であった。しかも多 くの場合、彼らの行動は組織(企業、公的団体、教育研究機関など)の管理下に置かれ、この意味では特定多数者といってよかった。従って、ほとんどのアプリ ケーションは専門家によって一定のサービス水準を維持するように開発され運用されてきた。 パソコンの社会的な普及はこの状況を一変させた。パソコンのユーザは多くの場合、個人的な行動様式を持ち、かつ非専門家である。このためにアプリケー ションの運用責任はユーザ自身つまり非専門家に転嫁され、アプリケーションの信頼性水準は彼らの意図と能力に従って多様化した。このような非専門家ユーザ は増大し、従って専門家の制御できないアプリケーションが増大した。加えて、利用分野におけるダウンサイジング、アンバンドリング、アウトソーシングなど の動向は専門家のアプリケーションに対する管理責任を細分化した。 通信の分野においても同様な傾向が認められる。インターネットのような開放型かつ分散管理型のネットワークは、従来のユニバーサル・サービス方式のサー ビスと異なり、ネットワーク全体を管理する主体が存在しないネットワークを作り出してしまった。ここでも専門家でないユーザ自身がアプリケーションの開発 や運用について責任を背負わざるをえないような環境が出現したことになる。 第2に社会的な環境について。社会の成熟とともに情報処理分野にもさまざまな社会的価値観の持ち主が、専門家として、また利害関係者(事業者からユーザ まで)として参入してきた。さまざまな価値観とは、公共性、市場原理、自己責任、弱者保護、公序良俗などの理念に対する配慮の優先度や重みのかけ方を指 す。 価値観の多元化の中で、進展しつつある技術は次々と新しいアプリケーションを出現させている。このために現在の情報処理技術は多様な社会的検討課題を引 き起こしている。これは表現の自由、通信の秘密、個人情報保護、著作権保護、情報の共有、セキュリティ管理、暗号化政策などに関わる。 現在の情報処理に関する法制度はこのような社会的課題を十分に制御できないままに陳腐化し、空白部分を残した状態にある。これは多様な意見の合意が困難 なことによって、また既得権益を守ろうとする勢力が存在することによって、新しい法秩序を設けることが妨げられているためである。 アプリケーション管理責任の拡散と制御規律の不存在は、情報処理技術の社会に及ぼす影響を考えればそれを放置することはできない。ここで当面できる一つ の対策は、何人かがこの社会的課題についてその所在と意味とを広く一般の人々に訴え、それを制御するための倫理綱領的な性格を持つガイドラインを提案する ことであろう。 誰がそのような行動を起こしたら良いのか。まず、その分野の技術に習熟したものがこの行動に入るべきであろう。このためには専門家に対するコードが必要 となる。ここにガイドライン制定の第1の狙いがある。 当面する社会的問題に対する認識や価値観は、実は情報処理の専門家の間にあっても多様であることが想定される。従って、これに対して厳密かつ詳細なルー ルを設定することは困難である。成しうることは、緩いガイドラインを設定し、個々のケースへの対応に対しては各人の判断に委ねることである。 専門家の社会的活動は、一般人からも良く見えるような環境のもとで実行されなければならない。これは情報処理技術の専門家が判断の基礎とした専門的情報 を一般人に公開、説明し、一般人に情報処理技術の応用に関して意見を表明する機会を与えるための前提となる。つまり、これはの専門家の独善を防ぐために不 可欠の条件となる。ここにガイドライン制定の第2の狙いがある。 同じく社会的な影響力を持つ専門家として、医師、建築家、弁護士などがある。彼らに対しては、専門家として高い倫理性が法的に義務付けられている。この 点、情報処理技術者は現実には高度の専門性を求められているにもかかわらず、制度的には専門家として認められていない。この弱い立場を支えるためにも、情 報処理技術者は自律的な行動規範を持つ必要がある.これがガイドライン制定の第3の狙いである。 これまで多くの技術者は「なされうるものは、なされなければならない」というブレークスルーの理念を信じてきた。だが、これからは、このブレークスルー の理念は社会的に受容され共有されるガイドラインによって制約を受けるようになるだろう。 |

| ASILOMAR

AI PRINCIPLES |

アシロマのAI原則(2017

年アシロマAI会議) |

| Artificial

intelligence has

already provided beneficial tools that are used every day by people

around the world. Its continued development, guided by the following

principles, will offer amazing opportunities to help and empower people

in the decades and centuries ahead. Research Issues 1) Research Goal: The goal of AI research should be to create not undirected intelligence, but beneficial intelligence. 2) Research Funding: Investments in AI should be accompanied by funding for research on ensuring its beneficial use, including thorny questions in computer science, economics, law, ethics, and social studies, such as: How can we make future AI systems highly robust, so that they do what we want without malfunctioning or getting hacked? How can we grow our prosperity through automation while maintaining people’s resources and purpose? How can we update our legal systems to be more fair and efficient, to keep pace with AI, and to manage the risks associated with AI? What set of values should AI be aligned with, and what legal and ethical status should it have? 3) Science-Policy Link: There should be constructive and healthy exchange between AI researchers and policy-makers. 4) Research Culture: A culture of cooperation, trust, and transparency should be fostered among researchers and developers of AI. 5) Race Avoidance: Teams developing AI systems should actively cooperate to avoid corner-cutting on safety standards. Ethics and Values 6) Safety: AI systems should be safe and secure throughout their operational lifetime, and verifiably so where applicable and feasible. 7) Failure Transparency: If an AI system causes harm, it should be possible to ascertain why. 8) Judicial Transparency: Any involvement by an autonomous system in judicial decision-making should provide a satisfactory explanation auditable by a competent human authority. 9) Responsibility: Designers and builders of advanced AI systems are stakeholders in the moral implications of their use, misuse, and actions, with a responsibility and opportunity to shape those implications. 10) Value Alignment: Highly autonomous AI systems should be designed so that their goals and behaviors can be assured to align with human values throughout their operation. 11) Human Values: AI systems should be designed and operated so as to be compatible with ideals of human dignity, rights, freedoms, and cultural diversity. 12) Personal Privacy: People should have the right to access, manage and control the data they generate, given AI systems’ power to analyze and utilize that data. 13) Liberty and Privacy: The application of AI to personal data must not unreasonably curtail people’s real or perceived liberty. 14) Shared Benefit: AI technologies should benefit and empower as many people as possible. 15) Shared Prosperity: The economic prosperity created by AI should be shared broadly, to benefit all of humanity. 16) Human Control: Humans should choose how and whether to delegate decisions to AI systems, to accomplish human-chosen objectives. 17) Non-subversion: The power conferred by control of highly advanced AI systems should respect and improve, rather than subvert, the social and civic processes on which the health of society depends. 18) AI Arms Race: An arms race in lethal autonomous weapons should be avoided. Longer-term Issues 19) Capability Caution: There being no consensus, we should avoid strong assumptions regarding upper limits on future AI capabilities. 20) Importance: Advanced AI could represent a profound change in the history of life on Earth, and should be planned for and managed with commensurate care and resources. 21) Risks: Risks posed by AI systems, especially catastrophic or existential risks, must be subject to planning and mitigation efforts commensurate with their expected impact. 22) Recursive Self-Improvement: AI systems designed to recursively self-improve or self-replicate in a manner that could lead to rapidly increasing quality or quantity must be subject to strict safety and control measures. 23) Common Good: Superintelligence should only be developed in the service of widely shared ethical ideals, and for the benefit of all humanity rather than one state or organization. https://futureoflife.org/ai-principles/ |

世界中の人々が毎日使用する役に立つツー

ルとして、すでに人工知能は利用されています。人工知能の開発が今後以下で示す原則に基づいて行われるならば、それは数十年さらに数世紀にわたる将来にお

いて、人々に役立ち豊かな暮らしをもたらしうるでしょう。 研究課題 1) 研究目標:研究の目標となる人工知能は、無秩序な知能ではなく、有益な知能とすべきである。 2) 研究資金:コンピュータサイエンスだけでなく、経済、法律、倫理、および社会学における困難な問題を孕む有益な人工知能研究にも投資すべきである。そこに おける課題として、以下のようなものがある。 将来の人工知能システムに高度なロバスト性をもたせることで、不具合を起こしたりハッキングされたりせずに、私たちの望むことを行えるようにする方法。 人的資源および人々の目的を維持しながら、様々な自動化によって私たちをより繁栄させるための方法。 人工知能に関わるリスクを公平に管理する法制度を、その技術進展に遅れることなく効果的に更新する方法。 人工知能自身が持つべき価値観や、人工知能が占めるべき法的および倫理的な地位についての研究。 3) 科学と政策の連携:人工知能研究者と政策立案者の間では、建設的かつ健全な交流がなされるべきである。 4) 研究文化:人工知能の研究者と開発者の間では、協力、信頼、透明性の文化を育むべきである。 5) 競争の回避:安全基準が軽視されないように、人工知能システムを開発するチーム同士は積極的に協力するべきである。 倫理と価値 6) 安全性:人工知能システムは、運用寿命を通じて安全かつロバストであるべきで、適用可能かつ現実的な範囲で検証されるべきである。 7) 障害の透明性:人工知能システムが何らかの被害を生じさせた場合に、その理由を確認できるべきである。 8) 司法の透明性:司法の場においては、意思決定における自律システムのいかなる関与についても、権限を持つ人間によって監査を可能としうる十分な説明を提供 すべきである。 9) 責任:高度な人工知能システムの設計者および構築者は、その利用、悪用、結果がもたらす道徳的影響に責任を負いかつ、そうした影響の形成に関わるステーク ホルダーである。 10) 価値観の調和:高度な自律的人工知能システムは、その目的と振る舞いが確実に人間の価値観と調和するよう設計されるべきである。 11) 人間の価値観:人工知能システムは、人間の尊厳、権利、自由、そして文化的多様性に適合するように設計され、運用されるべきである。 12) 個人のプライバシー: 人々は、人工知能システムが個人のデータ分析し利用して生み出したデータに対し、自らアクセスし、管理し、制御する権利を持つべきである。 13) 自由とプライバシー:個人のデータに対する人工知能の適用を通じて、個人が本来持つまたは持つはずの自由を不合理に侵害してはならない。 14) 利益の共有:人工知能技術は、できる限り多くの人々に利益をもたらし、また力を与えるべきである。 15) 繁栄の共有:人工知能によって作り出される経済的繁栄は、広く共有され、人類すべての利益となるべきである。 16) 人間による制御:人間が実現しようとする目的の達成を人工知能システムに任せようとする場合、その方法と、それ以前に判断を委ねるか否かについての判断を 人間が行うべきである。 17) 非破壊:高度な人工知能システムがもたらす制御の力は、既存の健全な社会の基盤となっている社会的および市民的プロセスを尊重した形での改善に資するべき であり、既存のプロセスを覆すものであってはならない。 18) 人工知能軍拡競争:自律型致死兵器の軍拡競争は避けるべきである。 長期的な課題 19) 能力に対する警戒: コンセンサスが存在しない以上、将来の人工知能が持ちうる能力の上限について強い仮定をおくことは避けるべきである。 20) 重要性:高度な人工知能は、地球上の生命の歴史に重大な変化をもたらす可能性があるため、相応の配慮や資源によって計画され、管理されるべきである。 21) リスク: 人工知能システムによって人類を壊滅もしくは絶滅させうるリスクに対しては、夫々の影響の程度に応じたリスク緩和の努力を計画的に行う必要がある。 22) 再帰的に自己改善する人工知能:再帰的に自己改善もしくは自己複製を行える人工知能システムは、進歩や増殖が急進しうるため、安全管理を厳格化すべきであ る。 23) 公益:広く共有される倫理的理想のため、および、特定の組織ではなく全人類の利益のために超知能は開発されるべきである。 https://futureoflife.org/ai-principles-japanese/ |

●情報倫理のフィールドワーク:テーマ「若者とメディア・情報倫理 について」

"How young people think about the moral and ethical dilemmas they encounter when they share and use online content and participate in online communities. Fresh from a party, a teen posts a photo on Facebook of a friend drinking a beer. A college student repurposes an article from Wikipedia for a paper. A group of players in a multiplayer online game routinely cheat new players by selling them worthless virtual accessories for high prices. In Disconnected, Carrie James examines how young people and the adults in their lives think about these sorts of online dilemmas, describing ethical blind spots and disconnects. Drawing on extensive interviews with young people between the ages of 10 and 25, James describes the nature of their thinking about privacy, property, and participation online. She identifies three ways that young people approach online activities. A teen might practice self-focused thinking, concerned mostly about consequences for herself; moral thinking, concerned about the consequences for people he knows; or ethical thinking, concerned about unknown individuals and larger communities. James finds, among other things, that youth are often blind to moral or ethical concerns about privacy; that attitudes toward property range from "what's theirs is theirs" to "free for all"; that hostile speech can be met with a belief that online content is "just a joke"; and that adults who are consulted about such dilemmas often emphasize personal safety issues over online ethics and citizenship. Considering ways to address the digital ethics gap, James offers a vision of conscientious connectivity, which involves ethical thinking skills but, perhaps more important, is marked by sensitivity to the dilemmas posed by online life, a motivation to wrestle with them, and a sense of moral agency that supports socially positive online actions." - #Nielsen BookData.

リンク(教育情報)

リンク

文献

その他の情報

最後までページをスクロールしてくださったユーザー の方に、Videodrome, directed by David Paul Cronenberg, 1982.について解説します。

| Videodrome

is a 1983 Canadian science fiction body horror film written and

directed by David Cronenberg and starring James Woods, Sonja Smits, and

Debbie Harry. Set in Toronto during the early 1980s, it follows the CEO

of a small UHF television station who stumbles upon a broadcast signal

of snuff films. The layers of deception and mind-control conspiracy

unfold as he uncovers the signal's source, and loses touch with reality

in a series of increasingly bizarre hallucinations. Distributed by Universal Pictures, Videodrome was the first film by Cronenberg to gain backing from any major Hollywood studio. With the highest budget of any of his films to date, the film was a box-office bomb, recouping only $2.1 million from a $5.9 million budget. The film received praise for the special makeup effects, Cronenberg's direction, Woods and Harry's performances, its "techno-surrealist" aesthetic, and its cryptic, psychosexual themes.[3] Cronenberg won the Best Direction award and was nominated for seven other awards at the 5th Genie Awards.[4] Now considered a cult classic, the film has been cited as one of Cronenberg's best, and a key example of the body horror and science fiction horror genres.[5][6] |

ビデオドローム』は、1983年にカナダで公開されたSFボディホラー

映画で、デヴィッド・クローネンバーグが脚本・監督、ジェームズ・ウッズ、ソニア・スミッツ、デビー・ハリーが出演している。1980年代初頭のトロント

を舞台に、スナッフフィルムの放送信号を偶然発見した小さなUHFテレビ局のCEOを描く。信号の発信源を突き止めるにつれ、欺瞞とマインドコントロール

の陰謀が幾重にも展開され、次第に奇妙な幻覚の連続に現実感を失っていく。 ユニバーサル・ピクチャーズが配給した『ヴィデオドローム』は、クローネンバーグがハリウッドのメジャースタジオから支援を受けた最初の作品である。これ までの作品の中で最も高額な予算を投じたこの作品は、590万ドルの予算から210万ドルしか回収できず、興行的には大爆死となった。この映画は、特殊メ イクの効果、クローネンバーグの演出、ウッズとハリーの演技、「テクノ・シュールレアリスム」の美学、そして不可解で心理的なテーマで賞賛を受けた [3]。クローネンバーグは第5回ジニー賞で演出賞を受賞、その他7部門にノミネートされている[4]。 現在ではカルト的な古典とされ、クローネンバーグの最高傑作の1つであり、ボディホラーやSFホラーというジャンルの重要な例として引用されている[5] [6]。 |

| あらすじ:小さなケーブルTV局『CIVIC-TV』の社長を務める

マックス・レンは、放送の目玉となる刺激的な映像を日々探し求めていた。とくにこだわっているのは、セックスや暴力などを扱った過激なものである。そんな

ある日、彼はどこから放送されているともつかない「ヴィデオドローム」なる海賊番組の存在を知った。内容は筋書きもなく、ただ拷問や殺人の場面が延々繰り

返されるだけのものだが、マックスはその生々しさと迫力に驚かされてしまったのだ。 |

Max Renn is the president of

CIVIC-TV, a Toronto UHF television station specializing in

sensationalist programming. Harlan, the operator of CIVIC-TV's

unauthorized satellite dish, shows Max Videodrome, a plotless show

apparently being broadcast from Malaysia which depicts anonymous

victims being violently tortured and eventually murdered. Believing

this to be the future of television, Max orders Harlan to begin

unlicensed use of the show. Nicki Brand, a sadomasochistic radio

host[7] who becomes sexually involved with Max, is aroused by an

episode of Videodrome,[8] and goes to audition for the show when she

learns that it is being broadcast out of Pittsburgh, but never returns.

Max contacts Masha, a softcore pornographer, and asks her to help him

find out the truth about Videodrome. Through Masha, Max learns that not

only is the footage not faked, but it is the public "face" of a

political movement. Masha further informs him that the enigmatic media

theorist Brian O'Blivion knows about Videodrome. |

| 社のエンジニアによれば、放送は衛星中継され、海外からのもののように

偽装されているが、実は国内のピッツバーグが発信源であるという。「ヴィデオドローム」の存在を知っているのは、まだごく一部の人間だけと思われる。マッ

クスは何とか今のうちにこれを手に入れようと考えるが、しかし「ヴィデオドローム」は、何者が、どこで、どういった趣旨で作っているのかもまるでつかめ

ず、全てが謎に包まれていた。ビデオに夢中になるマックスに、深く関わるのは危険だと忠告する者も現れたが、彼が耳を貸すことはなかった。ビデオの拷問や

殺人が本物であると聞かされても、興奮を押しとどめることが出来ないのだ。 |

Max tracks down O'Blivion to a

homeless shelter where vagrants are encouraged to engage in marathon

sessions of television viewing. He discovers that O'Blivion's daughter

Bianca runs the mission, intending to help realize her father's vision

of a world in which television replaces every aspect of everyday life.

Later, Max views a videotape in which O'Blivion informs him that

Videodrome is a socio-political battleground in which a war is being

fought to control the minds of the people of North America before being

garrotted by Nicki; Max then hallucinates that Nicki speaks directly to

him and causes his television to undulate as he kisses the screen.

Disturbed, Max returns to O'Blivion's homeless shelter. Bianca tells

him Videodrome carries a broadcast signal that causes the viewer to

develop a malignant brain tumor. O'Blivion helped to create it as part

of his vision for the future, and viewed the hallucinations as a higher

form of reality. When he found out it was to be used for malevolent

purposes, he attempted to stop his partners; they used his own

invention to kill him. In the year before his death, O'Blivion recorded

tens of thousands of videos, which now form the basis of his television

appearances. |

| そんな中、彼とともにビデオを観たガールフレンドのニッキーは、被虐的

な体験に対する興味から一人でピッツバーグに向かい、「ヴィデオドローム」に出演しようと試みる。マックスは映像の生みの親とおぼしきオブリビアン教授に

接触を図り、ニッキーを取り戻そうともくろむが、教授に会うこともできず取り合ってもらえない。しかしその後、教授から送られてきたビデオテープには、驚

くべき物語が記録されていた。 |

Later that night, Max

hallucinates placing his handgun in a slit in his abdomen. He is

contacted by Videodrome's producer, Barry Convex of the Spectacular

Optical Corporation, an eyeglasses company that acts as a front for an

arms company. He uses a device to record Max's fantasies of whipping

Nicki. Max then wakes up to find Masha's corpse in his bed. He

frantically calls Harlan to photograph the body as evidence, but,

shortly after he arrives, her body is no longer anywhere to be found. Wanting to see the latest Videodrome broadcast, Max meets Harlan at his studio. There, Harlan reveals that he has been working with Convex with the goal of recruiting Max to their cause: to end North America's cultural decay by giving fatal brain tumors to anyone so obsessed with sex and violence that they would watch Videodrome. Convex then inserts a brainwashing Betamax tape into Max's torso. Under Convex's influence, Max murders his colleagues at CIVIC-TV. He later attempts to murder Bianca, who manages to stop him by showing him a videotape of Nicki's murder on the Videodrome set. Bianca then 'reprograms' Max to her father's cause: "Death to Videodrome. Long live the new flesh." On her orders, he kills Harlan and Convex. |

| それは「ヴィデオドローム」を視聴したことによって、現実が変容してい

くという恐ろしい体験を語ったもので、教授はすでにビデオの世界の中に取り込まれ、現実に戻ることもかなわないというのだ。そのイメージはすでにマックス

の前にも現れ、単なる幻覚とするには説明のつかない現象が起き始めていた。やがて完全に「ヴィデオドローム」のイメージに支配され、心の平衡を失ったマッ

クスは・・・。 |

Wanted for their murders as well

of those of his colleagues, Max takes refuge on a derelict boat in the

Port Lands. Appearing to him on a television, Nicki tells him he has

weakened Videodrome, but in order to completely defeat it, he must

ascend to the next level and "leave the old flesh". The television then

shows an image of Max shooting himself in the head, which causes the

set to explode. Reenacting what he has just seen on the television, Max

utters the words "Long live the new flesh" and shoots himself. |

リンク

文献

その他の情報

Copyleft,

CC, Mitzub'ixi Quq Chi'j, 1996-2099