On Human Error, 人間の過誤

On Human Error, 人間の過誤

ヒューマン・エラー(Human error; 人間の過誤)とは、人間が犯す過ちや失敗のことである。ヒューマンエラーは人間の過誤とも訳せる。意図した過誤は、エラーに分類されない ので、ヒューマン・エラーとは、人間が犯したことを事後的に察知した、意図しない結 果である過ちや失敗のことと言い換えてもよい。

"Human error refers to something having been done that was "not intended by the actor; not desired by a set of rules or an external observer; or that led the task or system outside its acceptable limits".Human error has been cited as a primary cause contributing factor in disasters and accidents in industries as diverse as nuclear power (e.g., the Three Mile Island accident), aviation (see pilot error), space exploration (e.g., the Space Shuttle Challenger Disaster and Space Shuttle Columbia disaster), and medicine (see medical error). Prevention of human error is generally seen as a major contributor to reliability and safety of (complex) systems. Human error is one of the many contributing causes of risk events."-.

ヒューマンエラーとは「行為者が意図しなかったこと、規則

や外部の観察者が望まなかったこと、タスクやシステムを許容範囲外に導いてしまったこ

と」をさす。ヒューマンエラーは、原子力(スリーマイル島事故など)、航空(パイロットの誤操作)、宇宙開発(スペースシャトル・チャレンジャー号事故、

スペースシャトル・コロンビア号事故[Space

Shuttle Columbia disaster]など)、医療(医療過誤など)など様々な業界で、災害や事故の主な原因となる要因として挙

げられてきた。一般に、ヒューマンエラーの防止は、(複雑な)システムの信頼性と安

全性に大きく貢献すると考えられています。ヒューマンエラーは、リスク事象の多くの原因の1つである。

| ジェームズ・リーズン(James

Reason, 1938-) |

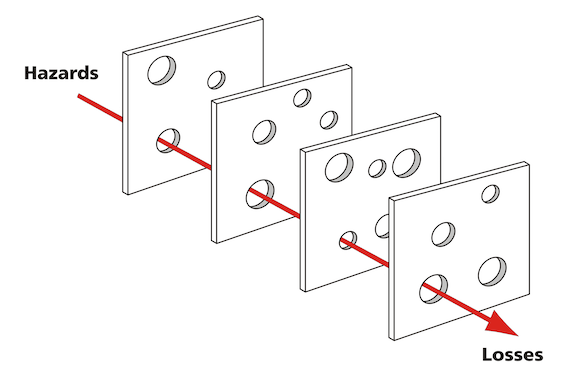

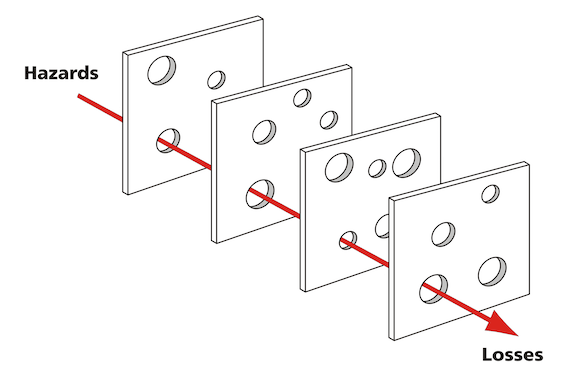

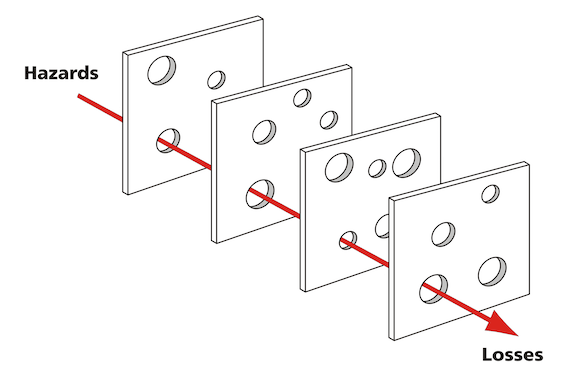

Le modèle des

plaques de James Reason de la causalité de l'accident illustre que,

bien que de nombreuses couches de protection soient disposées entre les

risques et les accidents, il y a des défauts dans chaque couche qui

peuvent permettre à l'accident de se produire. Ce modèle a été propose

par Dante Orlandella and James T. Reason de l'Université de Manchester.「ヒューマンエラーを「計画された一連の精神的または身体的活動が、意図した結果

に至らなかったものであり、これらの失敗には、他の偶発的事象の介在が原因となるものを除く」と定義している。ヒューマンエラーと

は、人間と機械やシステムとの関係の中で、機械側ではなく人間側のエラーをクローズアップしたものである。……リーズンは、事故につながりうる不安全行動

を意図的なものと意図しないものに分け、スリップとラプスを意図しないもの、ミステイクと違反行為を意図したものに配置し、ヒューマンエラーと、ルールか

ら逸脱すると知りながら敢えて行われる違反行為の関係を整理した」ヒューマンエラー. ジェームズ・リーズンのスイスチーズケーキモデル(日常にある様々な危険の「タネ」は多重的な抑止要因によって防がれているのにすぎない) |

| ドナルド・ノーマン(Donald

Arthur Norman, 1935- ) |

「ドナルド・ノーマンは、ヒューマンエラーと

なる一連の行動を「計画(意図の形成)の段階」と「実行の段階」の2つに分け、計画段階の間違いをミステイク(mistake)、実行段階の間違いをス

リップ(slip)と呼んだ。ミステイクはルールに従って実行しても発生する、計画自体に原因があるエラーであり、スリップはボタンの押し間違いなど

「うっかりミス」と呼ばれるもので、実施者の注意減少・混乱が原因とされる。ノーマンは、人間はある意図を形成させると脳内に知識や経験によって準備的な

スキーマを形成するが、作業には関係無いが部分的に共通する周辺スキーマも同時に活性化してしまい、注意力が減少した時に何かのきっかけで本来のスキーマ

ではなく周辺スキーマに飛びついてしまうという、ATS(Activation

Trigger-Schema)モデルを提唱した。他にノーマンは、意図した内容の保持に失敗する(例:何をしていたのか忘れた)など、記憶に関するエ

ラーをラプス(laps)、雑な扱いによるエラーをハンブル(humble)と呼んだ」ヒューマンエラー. |

| ファインマンさん |

ス

ペースシャトル「チャレンジャー」の事故(1986年1月28日)における事故調査委員会(ロジャーズ委員会 Rogers

Commission)に招かれたファインマンさんが、事故原因を探究するプロセスを、科学コミュニケーションの問題として考えると大きくわけて次の3つ

のポイントに絞られると思われる。1)

NASAの官僚制度のあり方。ポスト・アポロ計画における宇宙開発へ連邦政府の予算獲得のために、安全性よりも話題性(=広報)に力点が注がれ、肝心かな

めの飛行の安全性に関する問題解決がないがしろにされたこと。2)

NASAのシャトルの「安全率」の計算は、他のロケット開発のように設計がボトムアップにおこなわれる安全率の低さにくらべて、トップダウンで設計された

ために、安全率を高くみつもる(=事故率を低く見積もる)という問題が構造的にあった。3)

Oリングが、寒冷条件で硬化してその気密性が大いに損傷をうけ、致命的なものとなることについて、発射時の早朝に氷点下を示していたこと、また、現場では

Oリングの硬化については、早くから問題点が指摘されていたのに、改善されてこなかったこと。——チャレンジャーの発射時に氷点下を切っていたことは「不

運」であると同時に、氷点下時におけるリスクマネジメントの発想が「なかった」ということ。 |

| エリック・スティーブン・レイモンド |

6.学生(生徒)を授業の共同参画者と

して扱うのは、教育プログラムの高速改良と、プログラム上のエラーを学生じしんが発見してくれる楽な方法 だからだ(→「よい対話型教育プログラムのつくりかた」)。 |

| ドナルド・A・ノーマン |

6.エラーに備えたデザインをする。

Design for error.(デザインの手順の縮減) |

| 池田光穂 |

そ

れは、従来型の「〜すべし」「〜は絶対にやっちゃ

ならない」という命令タイプの倫理コントロールは、職場の技術者の倫理遵守には、100%の効果をもたらさないという私の経験からきている。その代わりに

「私たちは〈〜すべし〉〈〜は絶対にやっちゃならない〉

としても8,9割方は成功しても完璧ではない」と考えてみることが重要だ。そして「どうしても不可避な1〜2割の危険性を覚悟した上で、それが発生する直

前にさまざまな防止策をみんなで考えてお互いに助けあい、しっかりと話合うことで、その1〜2割の破局的なエラーを防ぐことができる」という信念をもつほ

うが重要だと考えるのである(→「工学倫理あるいは技術者倫理」)。 |

リンク

文献

その他の情報

Copyleft, CC, Mitzub'ixi Quq Chi'j, 1997-2099

++

Copyleft,

CC, Mitzub'ixi Quq Chi'j, 1996-2099