現代の骨相学とゲノムサイエンス

Scientific fetishism among modern

phrenologists and genome

scientists including physical anthropology

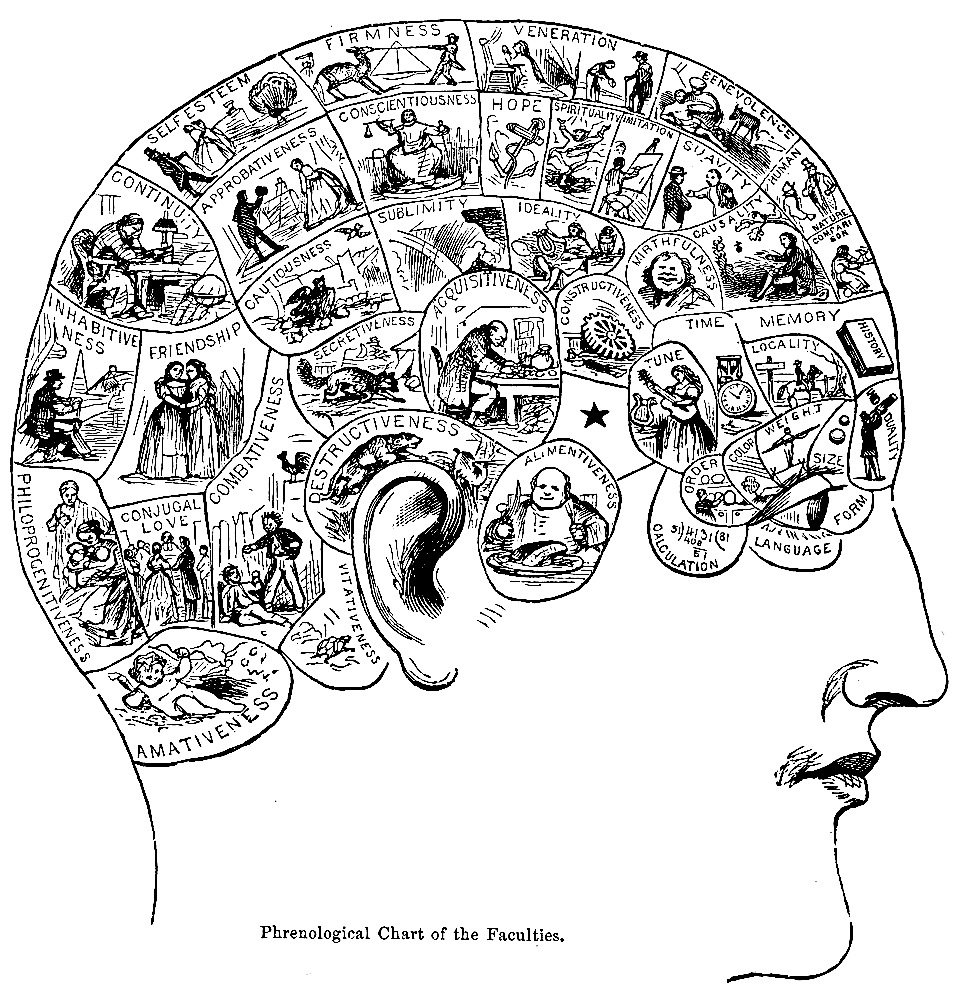

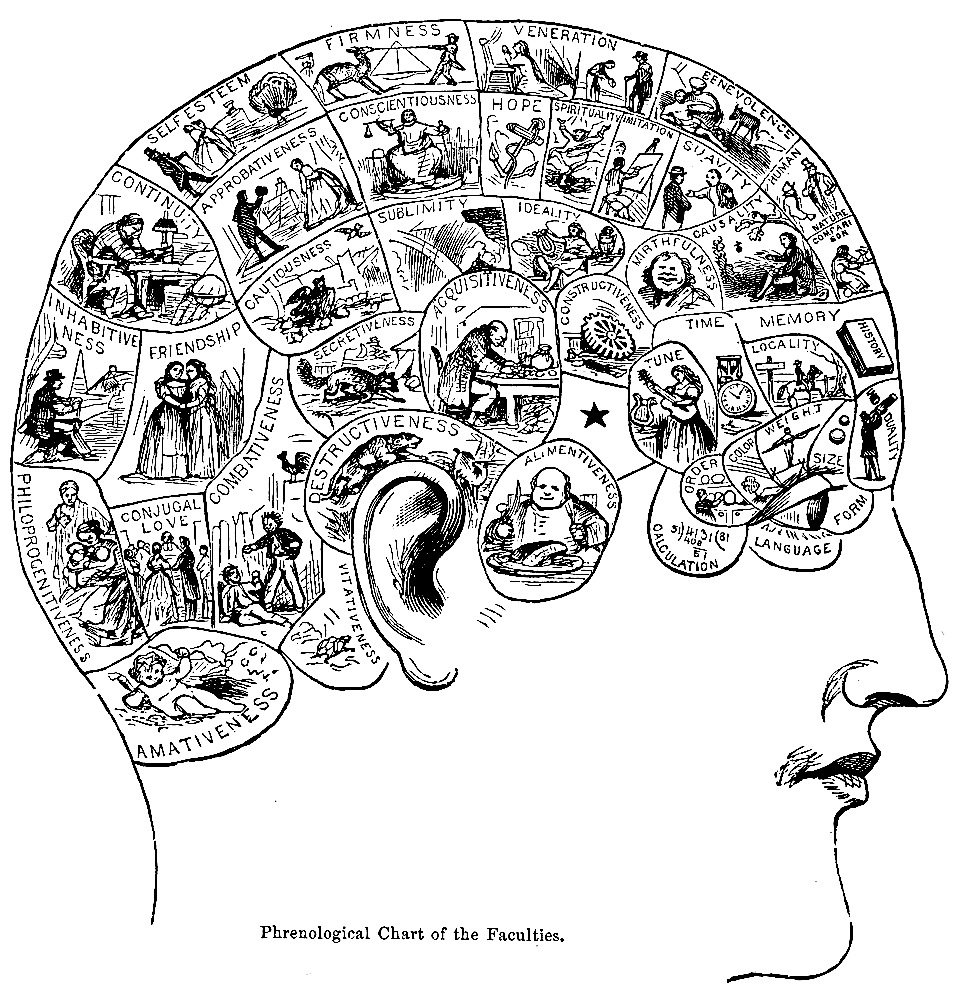

★このページは、骨相学には じ まる、科学的フェティシ ズムの歴史について考えるものである。骨相学は、精神的特徴を予測するために頭蓋骨の凸凹 を測定することを含む疑似科学である[1][2]。 それは、脳が心の器官であり、特定の脳領域が局所的、特定の機能またはモジュールを持っているという概念に基づいている[3] それらのアイデアは両方とも現実に根拠を持っていますが、骨相学は科学から逸脱した方法で経験的知識を超えて外挿されたものである。 [1796年にドイツの医師フランツ・ヨーゼフ・ガルによって開発され[6]、この学問は19世 紀、特に1810年頃から1840年まで影響力を持った。イギリスの骨相学の中心はエジンバラで、1820年にエジンバラ骨相学協会が設立された(→「フェティシズム」「商品フェティシズム」)。

★ゲノミクスは、ゲノムの構造、

機能、進化、マッピング、編集に焦点を当てた分子生物学の学

際的分野である。ゲノムとは、生物のDNAの完全な集合であり、すべての遺伝子とその階層的、3次元的な構造構成を含む。個々の遺伝子と遺伝におけるその

役割の研究を指す遺伝学とは対照的に、ゲノミクスは、生物のすべての遺伝子、それらの相互関係、および生物への影響の集合的な特徴づけと定量化を目指す。

その結果、タンパク質は臓器や組織などの身体構造を構成するとともに、化学反応を制御し、細胞間のシグナルを伝達する。ゲノミクスはまた、ゲノム全体の機

能と構造を組み立て、解析するための高スループットDNA配列決定とバイオインフォマティクスの利用によるゲノムの配列決定と解析も含む。ゲノミクスの進

歩は、脳のような最も複雑な生物学的システムの理解を促進するために、発見に基づく研究とシステム生物学における革命を引き起こした。

この分野には、エピスタシス(ある遺伝子が別の遺伝子に及ぼす影響)、プレイオトロピー(1つの遺伝子が複数の形質に影響を及ぼす)、ヘテロシス(雑種強

勢)などのゲノム内(ゲノム内)の現象や、ゲノム内の遺伝子座や対立遺伝子間の相互作用の研究も含まれる。

| Phrenology Phrenology is "a pseudoscience which involves the measurement of bumps on the skull to predict mental traits.[1][2] It is based on the concept that the brain is the organ of the mind, and that certain brain areas have localized, specific functions or modules.[3] Although both of those ideas have a basis in reality, phrenology extrapolated beyond empirical knowledge in a way that departed from science.[1][4] The central phrenological notion that measuring the contour of the skull can predict personality traits is discredited by empirical research.[5] Developed by German physician Franz Joseph Gall in 1796,[6] the discipline was influential in the 19th century, especially from about 1810 until 1840. The principal British centre for phrenology was Edinburgh, where the Edinburgh Phrenological Society was established in 1820." - Phrenology. |

骨相学 骨相学は、精神的特徴を予測するために頭蓋骨の凸凹を測定することを含 む疑似科学である[1][2]。 それは、脳が心の器官であり、特定の脳領域が局所的、特定の機能またはモジュールを持っているという概念に基づいている[3] それらのアイデアは両方とも現実に根拠を持っていますが、骨相学は科学から逸脱した方法で経験的知識を超えて外挿されたものである。 [1796年にドイツの医師フランツ・ヨーゼフ・ガルによって開発され[6]、この学問は19世 紀、特に1810年頃から1840年まで影響力を持った。イギリスの骨相学の中心はエジンバラで、1820年にエジンバラ骨相学協会が設立された。 |

| Phrenology is today recognized

as pseudoscience.[1][2][7][8][9][10] The methodological rigor of

phrenology was doubtful even for the standards of its time, since many

authors already regarded phrenology as pseudoscience in the 19th

century.[11][12][13][14] There have been various studies conducted that

discredited phrenology, most of which were done with ablation

techniques. Marie-Jean-Pierre Flourens demonstrated through ablation

that the cerebrum and cerebellum accomplish different functions. He

found that the impacted areas never carried out the functions that were

proposed through the pseudoscience, phrenology. However, Paul Broca was

the one who demolished the idea that phrenology was a science when he

discovered and named the "Broca's area". The patient's ability to

produce language was lost while their ability to understand language

remained intact. Through an autopsy examining their brains, he found

that there was damage to the left frontal lobe. He concluded that this

area of the brain was responsible for language production. Between

Flourens and Broca, the claims to support phrenology were dismantled.

Phrenological thinking was influential in the psychiatry and psychology

of the 19th century. Gall's assumption that character, thoughts, and

emotions are located in specific areas of the brain is considered an

important historical advance toward neuropsychology.[15][16] He

contributed to the idea that the brain is spatially organized, but not

in the way he proposed. There is a clear division of labor in the brain

but none of which even remotely correlates to the size of the head or

the structure of the skull. While it contributed to the advancement in

understanding the brain and its functions, remaining skeptical is

something that was learnt overtime. Phrenology was argued to be a

science, when in fact it is a pseudoscience. While phrenology itself has long been discredited, the study of the inner surface of the skulls of archaic human species allows modern researchers to obtain information about the development of various areas of the brains of those species, and thereby infer something about their cognitive and communicative abilities,[17] and possibly even something about their social life.[18] Due to its limitations, this technique is sometimes criticized as "paleo-phrenology".[18] |

骨相学は今日では疑似科学と認識されている[1][2][7][8]

[9][10]が、19世紀にはすでに多くの著者が骨相学を疑似科学としており、当時の水準から見てもその方法論の厳密さは疑問であった。

11][12][13][14]

骨相学を否定する研究はさまざま行われたが、多くは剥離技術によってなされたものであった。マリー=ジャン=ピエール・フルーランスは、大脳と小脳が異な

る機能を果たすことを切除によって証明した。その結果、大脳と小脳は、疑似科学である骨相学で提唱されたような機能を果たしていないことがわかったので

す。しかし、骨相学が科学であるという考えを打ち破ったのは、ポール・ブローカが「ブローカ野」を発見し命名したときであった。この患者さんは、言葉を発

する能力は失われていたが、言葉を理解する能力は残っていた。検死で彼らの脳を調べたところ、左前頭葉に損傷があることがわかった。彼は、この脳の領域が

言語生成を担っていると結論づけた。フローレンスとブローカの間で、骨相学を支持する主張は解体された。骨相学的な考え方は、19世紀の精神医学や心理学

に影響を及ぼした。性格、思考、感情が脳の特定の領域にあるというガルの仮定は、神経心理学に向けた重要な歴史的進歩であると考えられている[15]

[16]。

彼は脳が空間的に組織化されているという考えに貢献したが、彼が提案したような形では無かった。脳には明確な分業があるが、そのどれもが頭の大きさや頭蓋

骨の構造とは微塵も相関していないのである。脳とその機能の解明には貢献したが、懐疑的であり続けることは、長い時間をかけて学んできたことである。骨相

学は科学であると主張されたが、実際は疑似科学である。 骨相学自体は長い間信用されていないが、古代の人類の頭蓋骨の内側を研究することによって、現代の研究者はそれらの種の脳の様々な領域の発達に関する情報 を得ることができ、それによって彼らの認知能力やコミュニケーション能力に関する何か、そしておそらく彼らの社会生活に関する何かさえ推測することができ る[17]。 その限界から、この手法は「古骨相学」として批判されることもある[18]。 |

| Mental faculties Phrenologists believe that the human mind has a set of various mental faculties, each one represented in a different area of the brain. For example, the faculty of "philoprogenitiveness", from the Greek for "love of offspring", was located centrally at the back of the head (see illustration of the chart from Webster's Academic Dictionary). These areas were said to be proportional to a person's propensities. The importance of an organ was derived from relative size compared to other organs. It was believed that the cranial skull—like a glove on the hand—accommodates to the different sizes of these areas of the brain, so that a person's capacity for a given personality trait could be determined simply by measuring the area of the skull that overlies the corresponding area of the brain. Phrenology, which focuses on personality and character, is distinct from craniometry, which is the study of skull size, weight and shape, and physiognomy, the study of facial features. |

精神能力 骨相学者は、人間の心には様々な精神能力があり、それぞれが脳の異なる部位に代表することができると考えている。例えば、ギリシャ語で「子孫を愛する」と いう意味の「philoprogenitiveness」という能力は、後頭部の中央に位置していた(ウェブスター学術辞典の図表を参照)。 これらの部位は、その人の性向に比例すると言われていた。臓器の重要性は、他の臓器との相対的な大きさから導き出された。頭蓋骨は手のひらにはめる手袋の ようなもので、脳の各領域の大きさに対応できると考えられていた。そのため、ある性格特性に対するその人の能力は、対応する脳の領域に重なる頭蓋骨の面積 を測定するだけで判断できると考えられていた。 頭蓋骨の大きさ、重さ、形状を調べるクラニオメトリーや、顔の特徴を調べる人相学とは異なり、性格や個性に着目するのが骨相学である。 |

| Method Phrenology is a process that involves observing and/or feeling the skull to determine an individual's psychological attributes. Franz Joseph Gall believed that the brain was made up of 27 individual organs that determined personality, the first 19 of these 'organs' he believed to exist in other animal species. Phrenologists would run their fingertips and palms over the skulls of their patients to feel for enlargements or indentations.[19] The phrenologist would often take measurements with a tape measure of the overall head size and more rarely employ a craniometer, a special version of a caliper. In general, instruments to measure sizes of cranium continued to be used after the mainstream phrenology had ended. The phrenologists put emphasis on using drawings of individuals with particular traits, to determine the character of the person and thus many phrenology books show pictures of subjects. From absolute and relative sizes of the skull the phrenologist would assess the character and temperament of the patient. Gall's list of the "brain organs" was specific. An enlarged organ meant that the patient used that particular "organ" extensively. The number—and more detailed meanings—of organs were added later by other phrenologists. The 27 areas varied in function, from sense of color, to religiosity, to being combative or destructive. Each of the 27 "brain organs" was located under a specific area of the skull. As a phrenologist felt the skull, he would use his knowledge of the shapes of heads and organ positions to determine the overall natural strengths and weaknesses of an individual. Phrenologists believed the head revealed natural tendencies but not absolute limitations or strengths of character. The first phrenological chart gave the names of the organs described by Gall; it was a single sheet, and sold for a cent. Later charts were more expansive.[20] |

方法 骨相学とは、頭蓋骨を観察したり、触ったりして、個人の心理的特性を判断する方法である。フランツ・ヨーゼフ・ガルは、脳は人格を決定する27の器官から 構成されていると考え、このうち最初の19の器官は他の動物種にも存在すると考えていました。骨相学者は、患者の頭蓋骨を指先や手のひらでなぞり、肥大や へこみを感じ取る[19]。骨相学者は、しばしば巻尺で頭全体のサイズを測り、より稀にノギスの特別バージョンであるクラニオメータを使用する。一般に、 頭蓋の大きさを測る器具は、骨相学の主流が終わった後も使用され続けた。また、骨相学者は、特定の特徴を持つ人物の絵を用いて、その人物の性格を判断する ことに重きを置いていたため、多くの骨相学の本には被験者の写真が掲載されている。骨相学者は、頭蓋骨の絶対的、相対的な大きさから、患者の性格や気質を 判断した。 ガルは「脳の器官」を具体的にリストアップした。臓器が肥大しているということは、その患者がその "臓器 "を多用することを意味する。その後、他の骨相学者によって、器官の数やより詳細な意味が追加された。27の部位は、色彩感覚、宗教性、闘争性、破壊性な ど、さまざまな機能をもっていた。27の「脳の器官」は、それぞれ頭蓋骨の特定の部位に位置していた。骨相学者が頭蓋骨を触ると、頭の形や臓器の位置に関 する知識を駆使して、その人の生まれ持った長所と短所を判断することができる。骨相学者は、頭部を見れば生まれつきの傾向はわかるが、絶対的な限界や性格 の強さはわからないと考えた。最初の骨相表は、ガルが説明した器官の名称を示したもので、1枚で1セントで売られていた。後のチャートでは、より拡大され た[20]。 |

| https://en.wikipedia.org/wiki/Phrenology | 続きは、「骨相

学」へ |

| Genomics is an

interdisciplinary

field of molecular biology focusing on the structure, function,

evolution, mapping, and editing of genomes. A genome is an organism's

complete set of DNA, including all of its genes as well as its

hierarchical, three-dimensional structural configuration.[1][2][3][4]

In contrast to genetics, which refers to the study of individual genes

and their roles in inheritance, genomics aims at the collective

characterization and quantification of all of an organism's genes,

their interrelations and influence on the organism.[5] Genes may direct

the production of proteins with the assistance of enzymes and messenger

molecules. In turn, proteins make up body structures such as organs and

tissues as well as control chemical reactions and carry signals between

cells. Genomics also involves the sequencing and analysis of genomes

through uses of high throughput DNA sequencing and bioinformatics to

assemble and analyze the function and structure of entire

genomes.[6][7] Advances in genomics have triggered a revolution in

discovery-based research and systems biology to facilitate

understanding of even the most complex biological systems such as the

brain.[8] The field also includes studies of intragenomic (within the genome) phenomena such as epistasis (effect of one gene on another), pleiotropy (one gene affecting more than one trait), heterosis (hybrid vigour), and other interactions between loci and alleles within the genome.[9] |

ゲノミクスは、ゲノムの構造、機能、進化、マッピング、編集に焦点を当

てた分子生物学の学際的分野である。ゲノムとは、生物のDNAの完全な集合であり、すべての遺伝子とその階層的、3次元的な構造構成を含む[1][2]

[3][4]。個々の遺伝子と遺伝におけるその役割の研究を指す遺伝学とは対照的に、ゲノミクスは、生物のすべての遺伝子、それらの相互関係、および生物

への影響の集合的な特徴づけと定量化を目指す[5]。その結果、タンパク質は臓器や組織などの身体構造を構成するとともに、化学反応を制御し、細胞間のシ

グナルを伝達する。ゲノミクスはまた、ゲノム全体の機能と構造を組み立て、解析するための高スループットDNA配列決定とバイオインフォマティクスの利用

によるゲノムの配列決定と解析も含む[6][7]。ゲノミクスの進歩は、脳のような最も複雑な生物学的システムの理解を促進するために、発見に基づく研究

とシステム生物学における革命を引き起こした[8]。 この分野には、エピスタシス(ある遺伝子が別の遺伝子に及ぼす影響)、プレイオトロピー(1つの遺伝子が複数の形質に影響を及ぼす)、ヘテロシス(雑種強 勢)などのゲノム内(ゲノム内)の現象や、ゲノム内の遺伝子座や対立遺伝子間の相互作用の研究も含まれる[9]。 |

| History Etymology From the Greek ΓΕΝ[10] gen, "gene" (gamma, epsilon, nu, epsilon) meaning "become, create, creation, birth", and subsequent variants: genealogy, genesis, genetics, genic, genomere, genotype, genus etc. While the word genome (from the German Genom, attributed to Hans Winkler) was in use in English as early as 1926,[11] the term genomics was coined by Tom Roderick, a geneticist at the Jackson Laboratory (Bar Harbor, Maine), over beers with Jim Womack, Tom Shows and Stephen O’Brien at a meeting held in Maryland on the mapping of the human genome in 1986.[12] First as the name for a new journal and then as a whole new science discipline.[13] Early sequencing efforts Following Rosalind Franklin's confirmation of the helical structure of DNA, James D. Watson and Francis Crick's publication of the structure of DNA in 1953 and Fred Sanger's publication of the Amino acid sequence of insulin in 1955, nucleic acid sequencing became a major target of early molecular biologists.[14] In 1964, Robert W. Holley and colleagues published the first nucleic acid sequence ever determined, the ribonucleotide sequence of alanine transfer RNA.[15][16] Extending this work, Marshall Nirenberg and Philip Leder revealed the triplet nature of the genetic code and were able to determine the sequences of 54 out of 64 codons in their experiments.[17] In 1972, Walter Fiers and his team at the Laboratory of Molecular Biology of the University of Ghent (Ghent, Belgium) were the first to determine the sequence of a gene: the gene for Bacteriophage MS2 coat protein.[18] Fiers' group expanded on their MS2 coat protein work, determining the complete nucleotide-sequence of bacteriophage MS2-RNA (whose genome encodes just four genes in 3569 base pairs [bp]) and Simian virus 40 in 1976 and 1978, respectively.[19][20] DNA-sequencing technology developed  Frederick Sanger  Walter Gilbert Frederick Sanger and Walter Gilbert shared half of the 1980 Nobel Prize in Chemistry for Independently developing methods for the sequencing of DNA. In addition to his seminal work on the amino acid sequence of insulin, Frederick Sanger and his colleagues played a key role in the development of DNA sequencing techniques that enabled the establishment of comprehensive genome sequencing projects.[9] In 1975, he and Alan Coulson published a sequencing procedure using DNA polymerase with radiolabelled nucleotides that he called the Plus and Minus technique.[21][22] This involved two closely related methods that generated short oligonucleotides with defined 3' termini. These could be fractionated by electrophoresis on a polyacrylamide gel (called polyacrylamide gel electrophoresis) and visualised using autoradiography. The procedure could sequence up to 80 nucleotides in one go and was a big improvement, but was still very laborious. Nevertheless, in 1977 his group was able to sequence most of the 5,386 nucleotides of the single-stranded bacteriophage φX174, completing the first fully sequenced DNA-based genome.[23] The refinement of the Plus and Minus method resulted in the chain-termination, or Sanger method (see below), which formed the basis of the techniques of DNA sequencing, genome mapping, data storage, and bioinformatic analysis most widely used in the following quarter-century of research.[24][25] In the same year Walter Gilbert and Allan Maxam of Harvard University independently developed the Maxam-Gilbert method (also known as the chemical method) of DNA sequencing, involving the preferential cleavage of DNA at known bases, a less efficient method.[26][27] For their groundbreaking work in the sequencing of nucleic acids, Gilbert and Sanger shared half the 1980 Nobel Prize in chemistry with Paul Berg (recombinant DNA). Complete genomes The advent of these technologies resulted in a rapid intensification in the scope and speed of completion of genome sequencing projects. The first complete genome sequence of a eukaryotic organelle, the human mitochondrion (16,568 bp, about 16.6 kb [kilobase]), was reported in 1981,[28] and the first chloroplast genomes followed in 1986.[29][30] In 1992, the first eukaryotic chromosome, chromosome III of brewer's yeast Saccharomyces cerevisiae (315 kb) was sequenced.[31] The first free-living organism to be sequenced was that of Haemophilus influenzae (1.8 Mb [megabase]) in 1995.[32] The following year a consortium of researchers from laboratories across North America, Europe, and Japan announced the completion of the first complete genome sequence of a eukaryote, S. cerevisiae (12.1 Mb), and since then genomes have continued being sequenced at an exponentially growing pace.[33] As of October 2011, the complete sequences are available for: 2,719 viruses, 1,115 archaea and bacteria, and 36 eukaryotes, of which about half are fungi.[34][35]  "Hockey stick" graph showing the exponential growth of public sequence databases. The number of genome projects has increased as technological improvements continue to lower the cost of sequencing. (A) Exponential growth of genome sequence databases since 1995. (B) The cost in US Dollars (USD) to sequence one million bases. (C) The cost in USD to sequence a 3,000 Mb (human-sized) genome on a log-transformed scale. Most of the microorganisms whose genomes have been completely sequenced are problematic pathogens, such as Haemophilus influenzae, which has resulted in a pronounced bias in their phylogenetic distribution compared to the breadth of microbial diversity.[36][37] Of the other sequenced species, most were chosen because they were well-studied model organisms or promised to become good models. Yeast (Saccharomyces cerevisiae) has long been an important model organism for the eukaryotic cell, while the fruit fly Drosophila melanogaster has been a very important tool (notably in early pre-molecular genetics). The worm Caenorhabditis elegans is an often used simple model for multicellular organisms. The zebrafish Brachydanio rerio is used for many developmental studies on the molecular level, and the plant Arabidopsis thaliana is a model organism for flowering plants. The Japanese pufferfish (Takifugu rubripes) and the spotted green pufferfish (Tetraodon nigroviridis) are interesting because of their small and compact genomes, which contain very little noncoding DNA compared to most species.[38][39] The mammals dog (Canis familiaris),[40] brown rat (Rattus norvegicus), mouse (Mus musculus), and chimpanzee (Pan troglodytes) are all important model animals in medical research.[27] A rough draft of the human genome was completed by the Human Genome Project in early 2001, creating much fanfare.[41] This project, completed in 2003, sequenced the entire genome for one specific person, and by 2007 this sequence was declared "finished" (less than one error in 20,000 bases and all chromosomes assembled).[41] In the years since then, the genomes of many other individuals have been sequenced, partly under the auspices of the 1000 Genomes Project, which announced the sequencing of 1,092 genomes in October 2012.[42] Completion of this project was made possible by the development of dramatically more efficient sequencing technologies and required the commitment of significant bioinformatics resources from a large international collaboration.[43] The continued analysis of human genomic data has profound political and social repercussions for human societies.[44] The "omics" revolution  General schema showing the relationships of the genome, transcriptome, proteome, and metabolome (lipidome) Main articles: Omics and Human proteome project The English-language neologism omics informally refers to a field of study in biology ending in -omics, such as genomics, proteomics or metabolomics. The related suffix -ome is used to address the objects of study of such fields, such as the genome, proteome, or metabolome (lipidome) respectively. The suffix -ome as used in molecular biology refers to a totality of some sort; similarly omics has come to refer generally to the study of large, comprehensive biological data sets. While the growth in the use of the term has led some scientists (Jonathan Eisen, among others[45]) to claim that it has been oversold,[46] it reflects the change in orientation towards the quantitative analysis of complete or near-complete assortment of all the constituents of a system.[47] In the study of symbioses, for example, researchers which were once limited to the study of a single gene product can now simultaneously compare the total complement of several types of biological molecules.[48][49] |

歴史 語源 ギリシャ語のΓΕΝ[10]gen、「なる、創る、創造、誕生」を意味する「遺伝子」(γ、ε、ν、ε)、およびそれに続く変化形:系図、創世記、遺伝 学、genic、genomere、genotype、genusなどから。ゲノムという言葉(ドイツ語のGenomに由来し、ハンス・ウィンクラーによ るとされる)は、早くも1926年には英語で使われていたが[11]、ゲノミクスという言葉は、1986年にメリーランド州で開催されたヒトゲノムのマッ ピングに関する会議で、ジャクソン研究所(メイン州バーハーバー)の遺伝学者であるトム・ロデリックが、ジム・ウォマック、トム・ショウズ、スティーブ ン・オブライエンとビールを飲みながら考えた造語である[12]。 初期の配列決定の取り組み ロザリンド・フランクリンがDNAのらせん構造を確認し、ジェームズ・D・ワトソンとフランシス・クリックが1953年にDNAの構造を発表し、フレッ ド・サンガーが1955年にインスリンのアミノ酸配列を発表したのに続き、核酸配列決定は初期の分子生物学者の主要な標的となった。この研究を発展させ、 マーシャル・ニレンバーグとフィリップ・レダーは、遺伝暗号の三重項性を明らかにし、彼らの実験で64コドンのうち54コドンの配列を決定することができ た[17]。 [1972年、ゲント大学分子生物学研究所(ベルギー、ゲント)のウォルター・フィアーズと彼のチームは、バクテリオファージMS2コートタンパク質の遺 伝子という遺伝子の塩基配列を初めて決定した[18]。フィアーズのグループはMS2コートタンパク質の研究を発展させ、1976年と1978年にそれぞ れバクテリオファージMS2-RNA(そのゲノムは3569塩基対[bp]に4つの遺伝子しかコードしていない)とシミアンウイルス40の完全な塩基配列 を決定した[19][20]。 DNA配列決定技術が開発される  フレデリック・サンガー  ウォルター・ギルバート フレデリック・サンガーとウォルター・ギルバートは、DNAの塩基配列決定法を独自に開発したとして、1980年のノーベル化学賞の半分を分け合った。 1975年、サンガーとアラン・コールソンは、DNAポリメラーゼと放射性標識ヌクレオチドを用いた塩基配列決定法を発表し、これをプラス・マイナス法と 呼んだ[21][22]。これらはポリアクリルアミドゲル上の電気泳動(ポリアクリルアミドゲル電気泳動と呼ばれる)によって分画され、オートラジオグラ フィーを用いて可視化された。この方法では一度に80塩基までの塩基配列を決定することができ、大きな進歩であったが、それでも非常に手間のかかるもので あった。それでも1977年、彼のグループは一本鎖のバクテリオファージφX174の5,386ヌクレオチドのほとんどを配列決定することができ、初めて DNAベースのゲノムを完全に配列決定した。プラス・マイナス法を改良した結果、連鎖終結法、すなわちサンガー法(下記参照)が生まれ、その後の四半世紀 にわたる研究で最も広く使われたDNA配列決定、ゲノムマッピング、データ保存、バイオインフォマティクス解析の技術の基礎となった。 [24][25]同年、ハーバード大学のウォルター・ギルバートとアラン・マクサムは、既知の塩基におけるDNAの優先的切断を伴う、DNA配列決定のマ クサム・ギルバート法(化学的方法としても知られる)を独自に開発したが、これはあまり効率的な方法ではなかった[26][27]。 核酸の配列決定における画期的な業績により、ギルバートとサンガーは、ポール・バーグ(組み換えDNA)と共に1980年のノーベル化学賞の半分を受賞し た。 完全なゲノム このような技術の出現により、ゲノム配列決定プロジェクトの範囲と完了スピードは急速に強化された。真核生物の小器官であるヒトのミトコンドリア (16,568 bp、約16.6 kb [キロベース])の最初の完全なゲノム配列が1981年に報告され[28]、最初の葉緑体ゲノムが1986年に続いた。 [1992年には、最初の真核生物の染色体、ビール酵母サッカロマイセス・セレビシエのIII番染色体(315kb)の塩基配列が決定された[31]。 翌年、北米、ヨーロッパ、日本の研究者からなるコンソーシアムが、真核生物であるセレビシエ(12.1Mb)の完全なゲノム配列の完成を発表した: 2011年10月現在、2,719のウイルス、1,115の古細菌とバクテリア、36の真核生物(そのうちの約半数は真菌である)についての完全な配列が 利用可能である[34][35]。  公開配列データベースの指数関数的な成長を示す「ホッケースティック」グラフ。 ゲノムプロジェクトの数は、技術的な改善によって配列決定のコストが下がり続けるにつれて増加している。(A)1995年以降のゲノム配列データベースの 指数関数的な増加。(B)100万塩基の塩基配列を決定するのにかかった費用(米ドル)。(C)対数変換した3,000 Mb(ヒトサイズ)のゲノムの配列決定にかかる費用(USD)。 ゲノムが完全に解読された微生物のほとんどは、インフルエンザ菌のような問題のある病原体であり、その結果、微生物の多様性の広さと比較して、系統学的分 布に顕著な偏りが生じている[36][37]。酵母(Saccharomyces cerevisiae)は長い間、真核細胞の重要なモデル生物であり、ミバエ(Drosophila melanogaster)は(特に初期の分子遺伝学において)非常に重要なツールであった。線虫は多細胞生物の単純なモデルとしてよく使われる。ゼブラ フィッシュ(Brachydanio rerio)は分子レベルでの多くの発生研究に使われ、シロイヌナズナ(Arabidopsis thaliana)は顕花植物のモデル生物である。ニホンフグ(Takifugu rubripes)とマダラフグ(Tetraodon nigroviridis)は、ゲノムが小さくコンパクトで、ほとんどの種に比べてノンコーディングDNAをほとんど含まないという点で興味深い[38] [39]。 哺乳類のイヌ(Canis familiaris)、[40]ヒメネズミ(Rattus norvegicus)、マウス(Mus musculus)、チンパンジー(Pan troglodytes)はすべて、医学研究の重要なモデル動物である[27]。 2003年に完了したこのプロジェクトでは、特定の一人のゲノムの全塩基配列が決定され、2007年までにこの塩基配列が「完成した」(20,000塩基 中の1塩基未満の誤りしかなく、すべての染色体が組み合わされている)と宣言された[41]。それ以来数年間で、他の多くの個人のゲノムの塩基配列が決定 され、その一部は1000人ゲノムプロジェクトの支援の下で行われ、2012年10月に1,092のゲノムの塩基配列決定が発表された[42]。 [42]。このプロジェクトの完了は、飛躍的に効率的なシーケンス技術の開発によって可能となり、大規模な国際共同研究による多大なバイオインフォマティ クスリソースの投入を必要とした[43]。ヒトゲノムデータの継続的な解析は、人類社会にとって政治的・社会的に重大な影響を及ぼす[44]。 「オミックス」革命  ゲノム、トランスクリプトーム、プロテオーム、メタボローム(リピドーム)の関係を示す一般的な図式。 主な記事 オミックスとヒトプロテオームプロジェクト 英語のomicsという新語は、非公式には、ゲノミクス、プロテオミクス、メタボロミクスなど、-omicsで終わる生物学の研究分野を指す。関連する接 尾辞-omeは、それぞれゲノム、プロテオーム、メタボローム(リピドーム)など、このような分野の研究対象を指すのに使われる。分子生物学で用いられる 接尾辞-omeは、ある種の全体性を意味する。同様に、オミクスは大規模で包括的な生物学的データセットの研究全般を指すようになった。この用語の使用の 増加により、一部の科学者(ジョナサン・アイゼンなど[45])は、この用語は過剰に販売されていると主張するようになったが[46]、システムのすべて の構成要素の完全な、またはほぼ完全な品揃えの定量的分析への方向性の変化を反映している[47]。 |

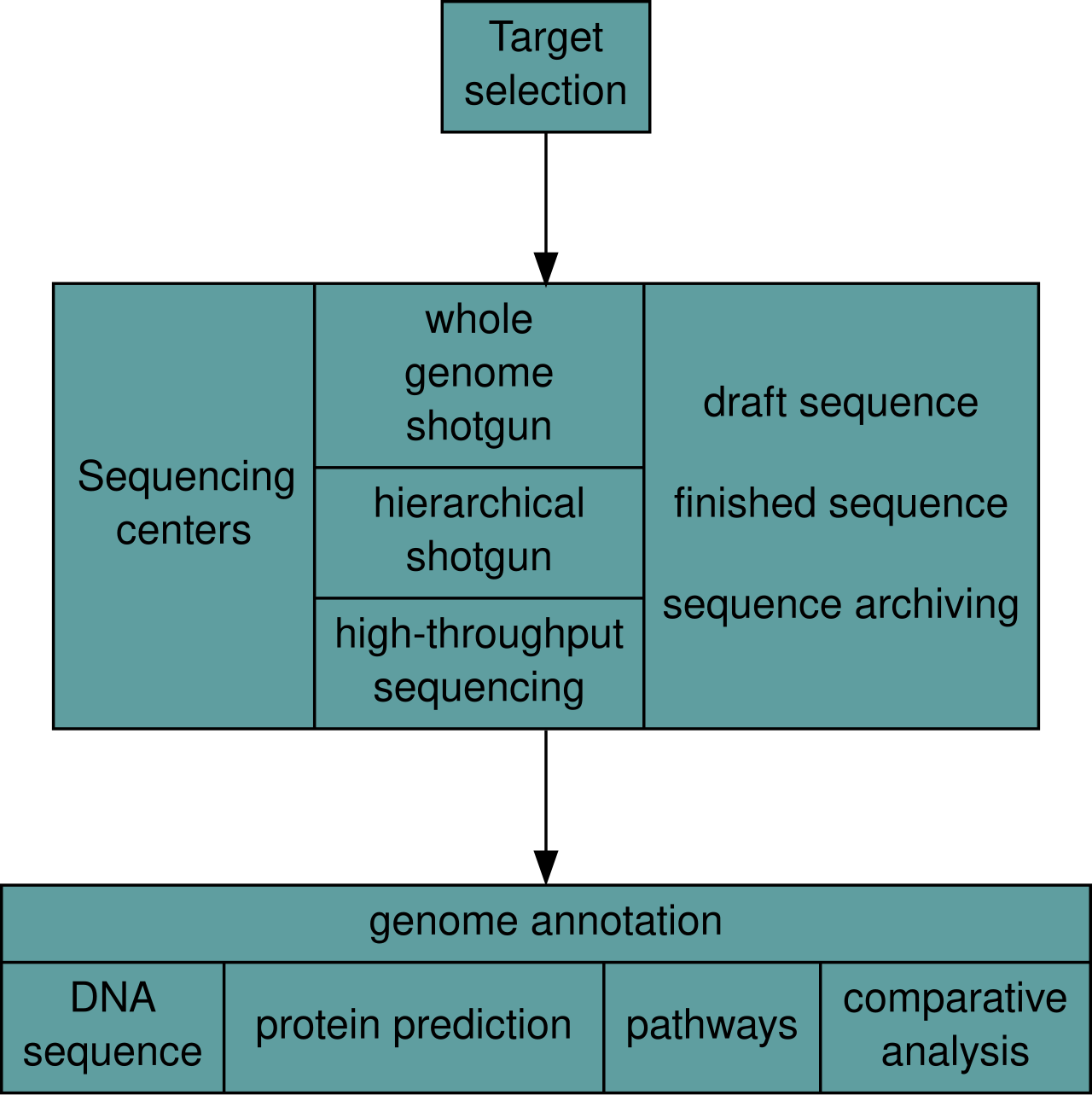

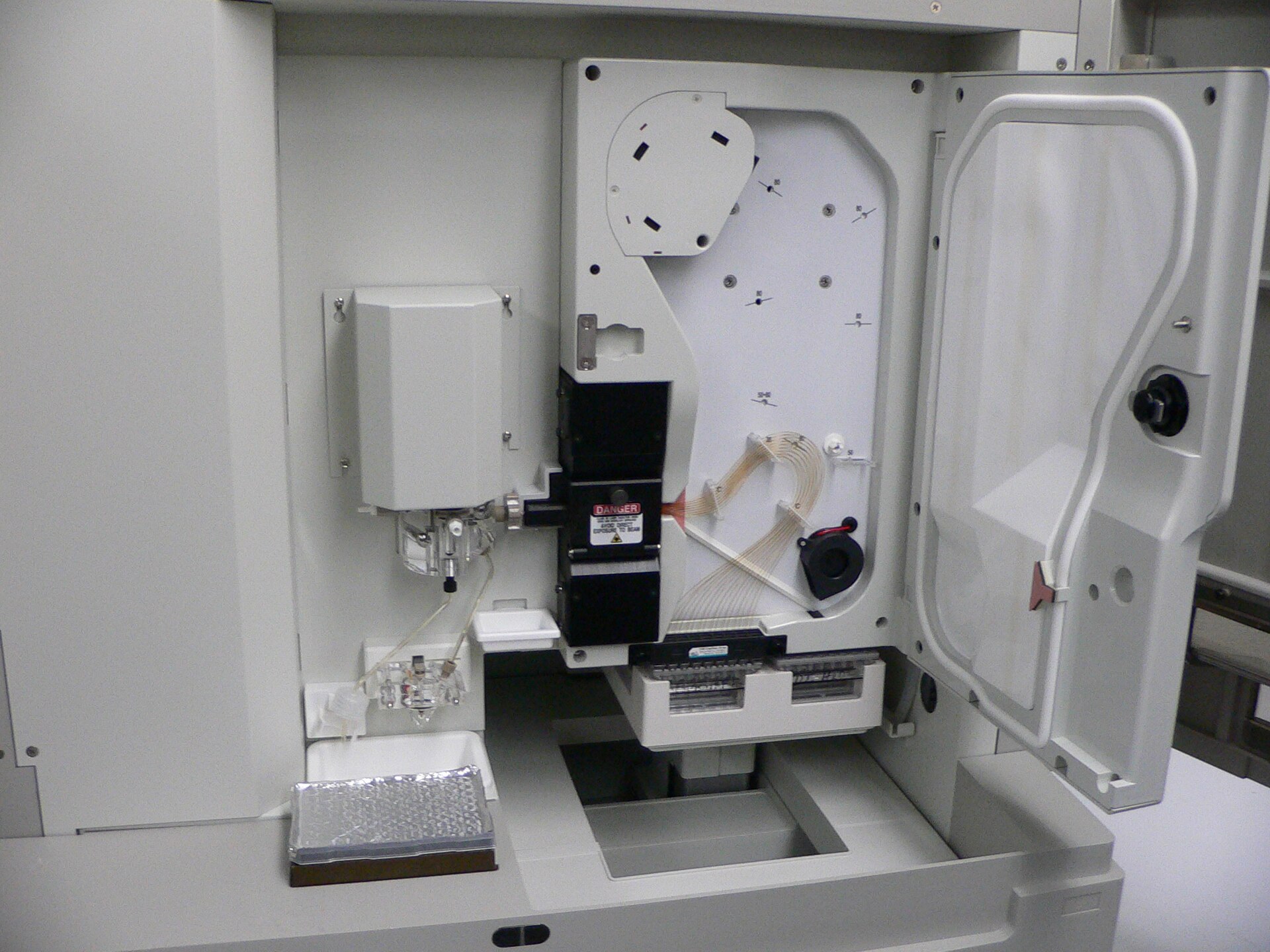

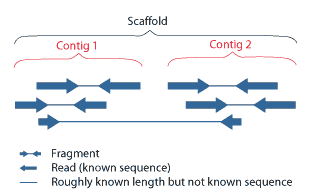

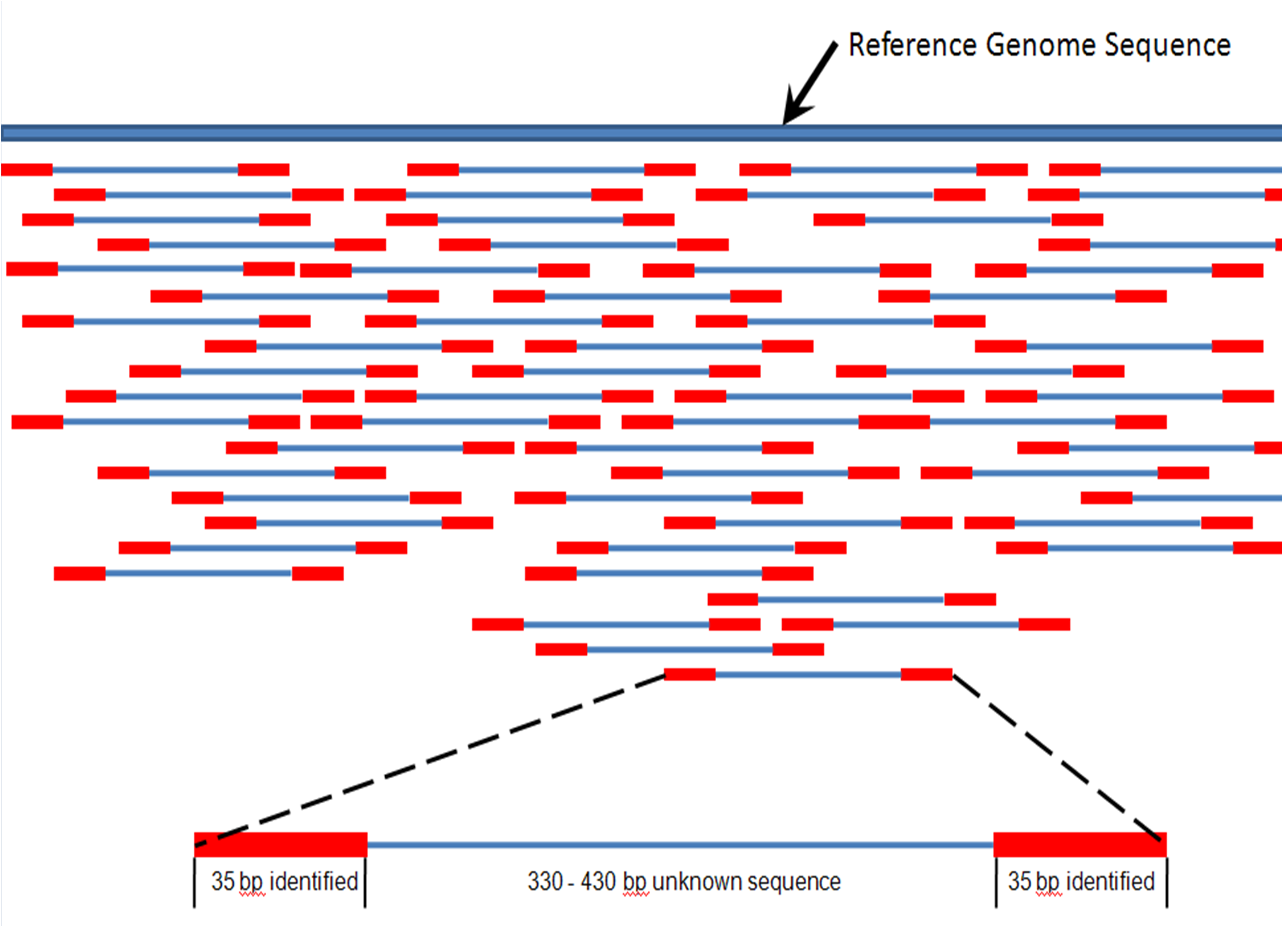

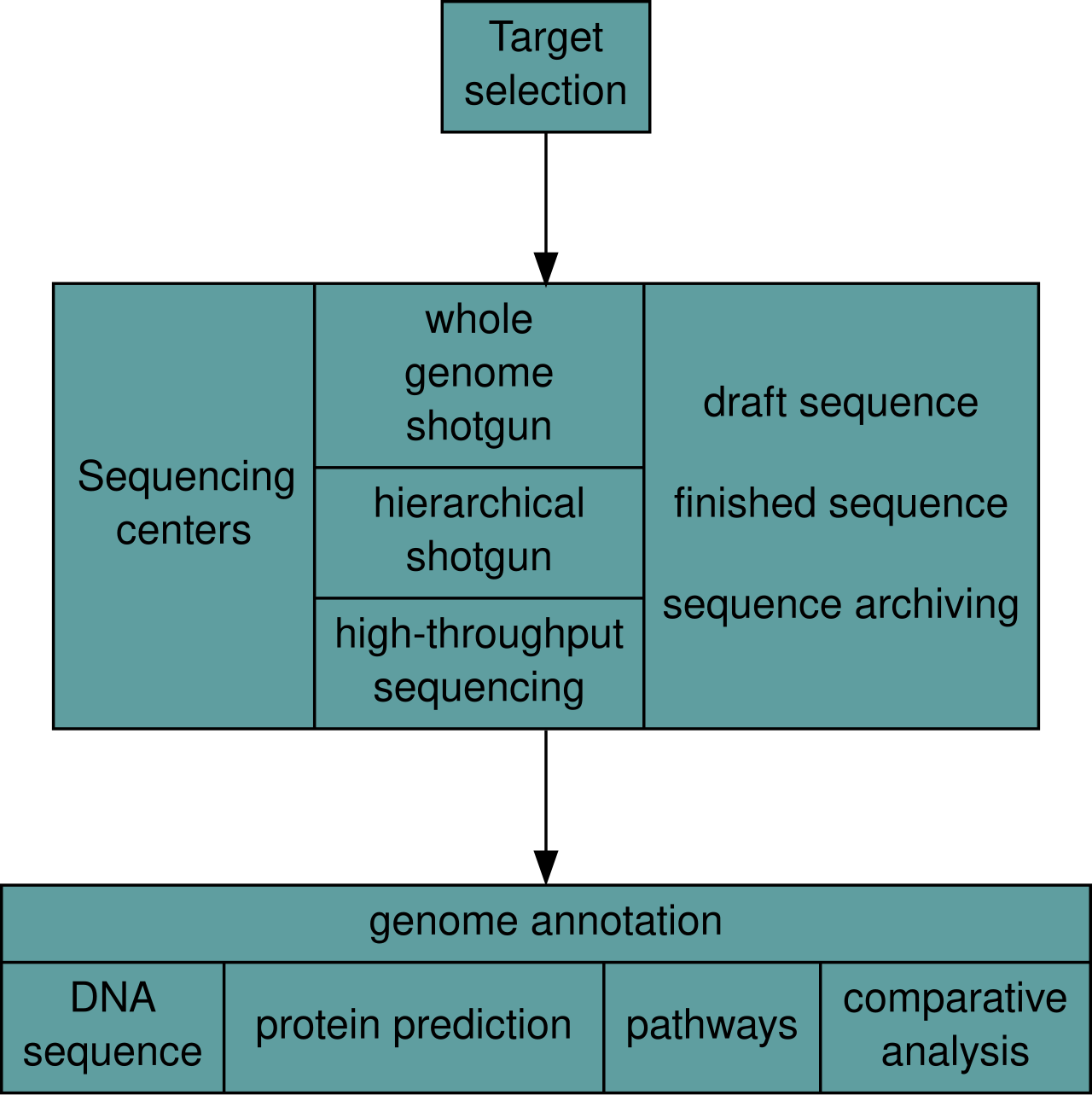

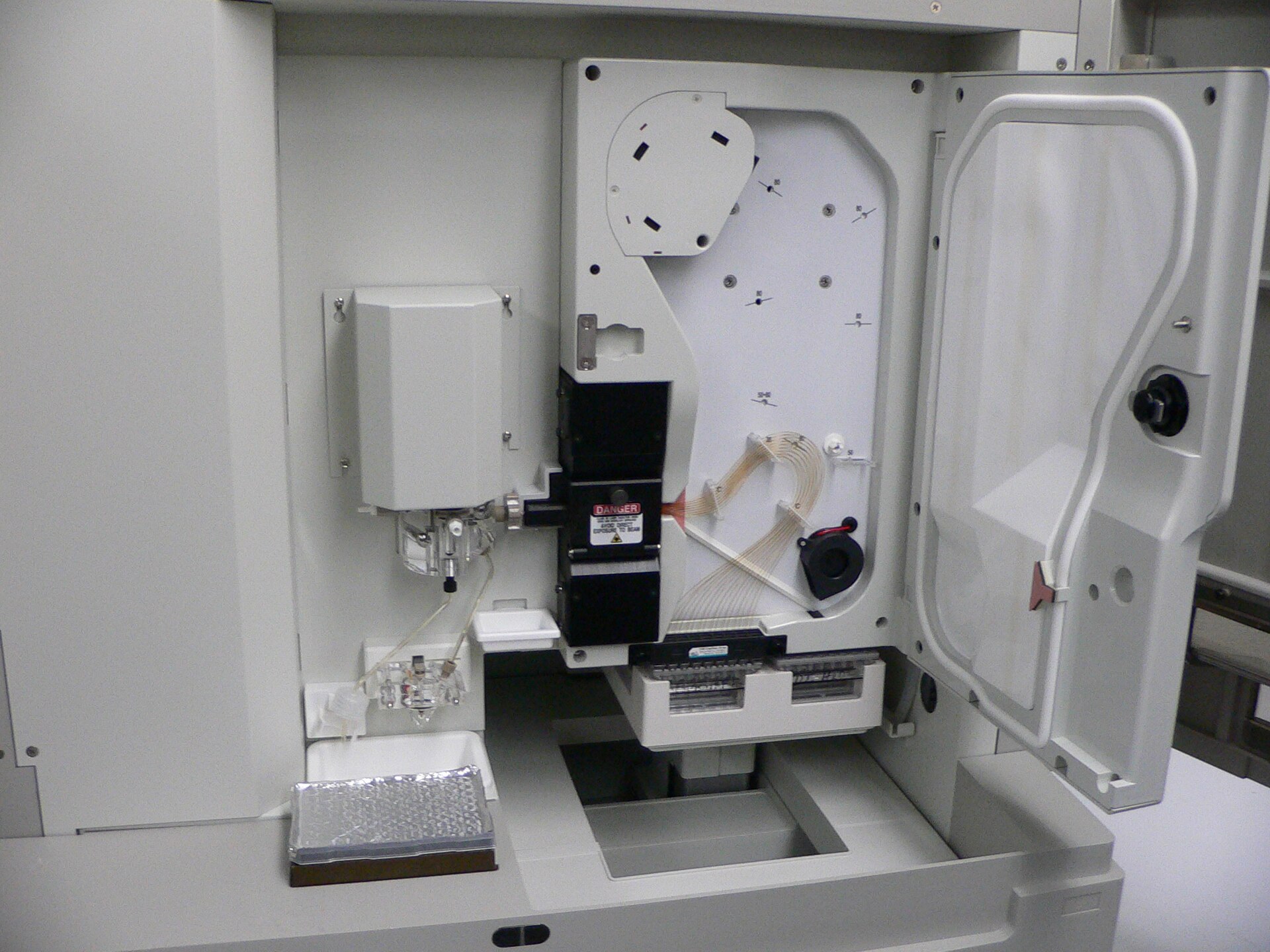

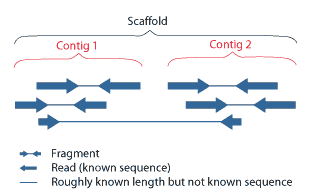

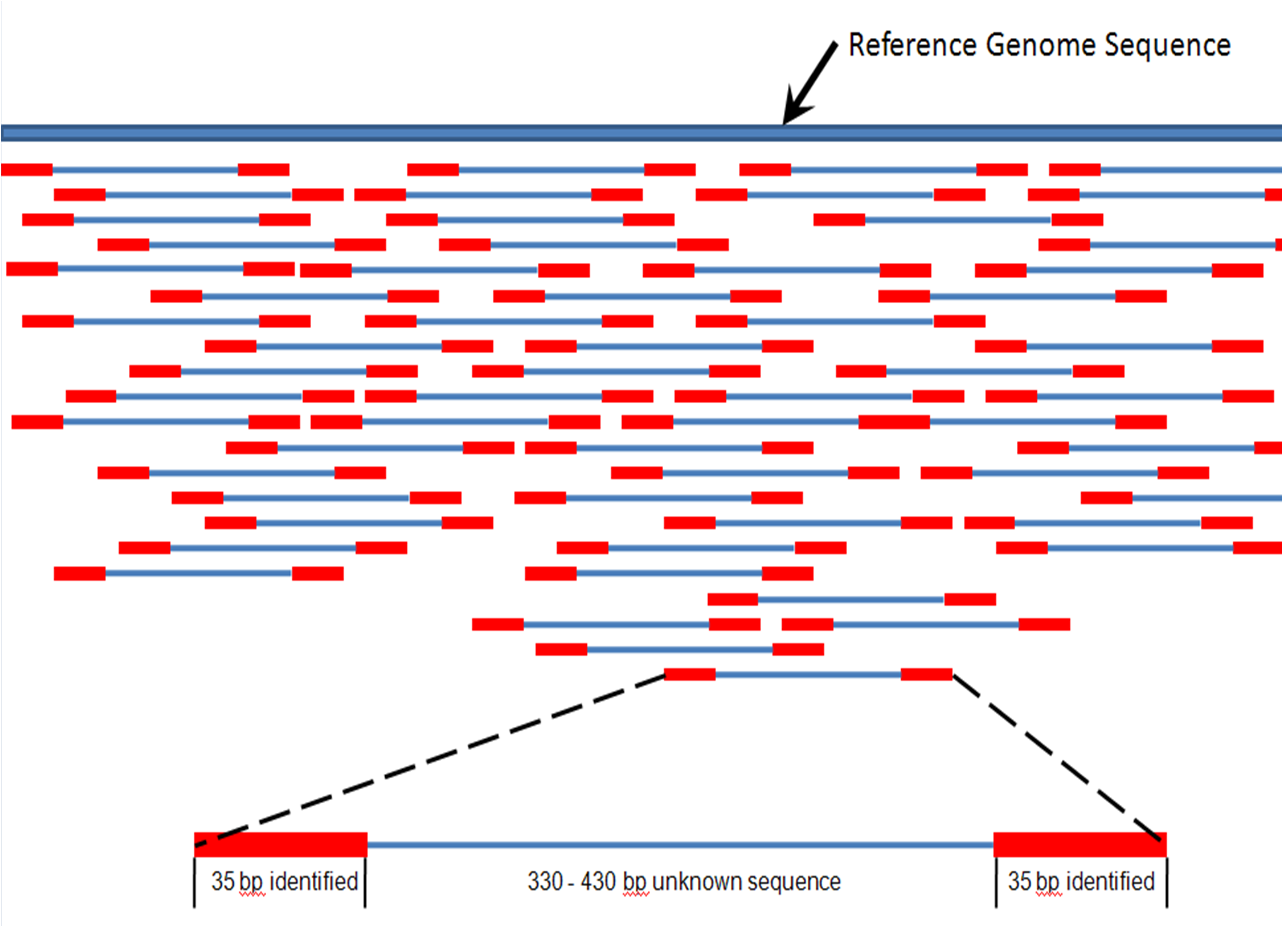

| Genome analysis Main article: Genome project After an organism has been selected, genome projects involve three components: the sequencing of DNA, the assembly of that sequence to create a representation of the original chromosome, and the annotation and analysis of that representation.[9]  Overview of a genome project. First, the genome must be selected, which involves several factors including cost and relevance. Second, the sequence is generated and assembled at a given sequencing center (such as BGI or DOE JGI). Third, the genome sequence is annotated at several levels: DNA, protein, gene pathways, or comparatively. Sequencing Main article: DNA Sequencing Historically, sequencing was done in sequencing centers, centralized facilities (ranging from large independent institutions such as Joint Genome Institute which sequence dozens of terabases a year, to local molecular biology core facilities) which contain research laboratories with the costly instrumentation and technical support necessary. As sequencing technology continues to improve, however, a new generation of effective fast turnaround benchtop sequencers has come within reach of the average academic laboratory.[50][51] On the whole, genome sequencing approaches fall into two broad categories, shotgun and high-throughput (or next-generation) sequencing.[9] Shotgun sequencing  An ABI PRISM 3100 Genetic Analyzer. Such capillary sequencers automated early large-scale genome sequencing efforts. Main article: Shotgun sequencing Shotgun sequencing is a sequencing method designed for analysis of DNA sequences longer than 1000 base pairs, up to and including entire chromosomes.[52] It is named by analogy with the rapidly expanding, quasi-random firing pattern of a shotgun. Since gel electrophoresis sequencing can only be used for fairly short sequences (100 to 1000 base pairs), longer DNA sequences must be broken into random small segments which are then sequenced to obtain reads. Multiple overlapping reads for the target DNA are obtained by performing several rounds of this fragmentation and sequencing. Computer programs then use the overlapping ends of different reads to assemble them into a continuous sequence.[52][53] Shotgun sequencing is a random sampling process, requiring over-sampling to ensure a given nucleotide is represented in the reconstructed sequence; the average number of reads by which a genome is over-sampled is referred to as coverage.[54] For much of its history, the technology underlying shotgun sequencing was the classical chain-termination method or 'Sanger method', which is based on the selective incorporation of chain-terminating dideoxynucleotides by DNA polymerase during in vitro DNA replication.[23][55] Recently, shotgun sequencing has been supplanted by high-throughput sequencing methods, especially for large-scale, automated genome analyses. However, the Sanger method remains in wide use, primarily for smaller-scale projects and for obtaining especially long contiguous DNA sequence reads (>500 nucleotides).[56] Chain-termination methods require a single-stranded DNA template, a DNA primer, a DNA polymerase, normal deoxynucleosidetriphosphates (dNTPs), and modified nucleotides (dideoxyNTPs) that terminate DNA strand elongation. These chain-terminating nucleotides lack a 3'-OH group required for the formation of a phosphodiester bond between two nucleotides, causing DNA polymerase to cease extension of DNA when a ddNTP is incorporated. The ddNTPs may be radioactively or fluorescently labelled for detection in DNA sequencers.[9] Typically, these machines can sequence up to 96 DNA samples in a single batch (run) in up to 48 runs a day.[57] High-throughput sequencing See also: Illumina dye sequencing and Ion semiconductor sequencing The high demand for low-cost sequencing has driven the development of high-throughput sequencing technologies that parallelize the sequencing process, producing thousands or millions of sequences at once.[58][59] High-throughput sequencing is intended to lower the cost of DNA sequencing beyond what is possible with standard dye-terminator methods. In ultra-high-throughput sequencing, as many as 500,000 sequencing-by-synthesis operations may be run in parallel.[60][61]  Illumina Genome Analyzer II System. Illumina technologies have set the standard for high-throughput massively parallel sequencing.[50] The Illumina dye sequencing method is based on reversible dye-terminators and was developed in 1996 at the Geneva Biomedical Research Institute, by Pascal Mayer and Laurent Farinelli.[62] In this method, DNA molecules and primers are first attached on a slide and amplified with polymerase so that local clonal colonies, initially coined "DNA colonies", are formed. To determine the sequence, four types of reversible terminator bases (RT-bases) are added and non-incorporated nucleotides are washed away. Unlike pyrosequencing, the DNA chains are extended one nucleotide at a time and image acquisition can be performed at a delayed moment, allowing for very large arrays of DNA colonies to be captured by sequential images taken from a single camera. Decoupling the enzymatic reaction and the image capture allows for optimal throughput and theoretically unlimited sequencing capacity; with an optimal configuration, the ultimate throughput of the instrument depends only on the A/D conversion rate of the camera. The camera takes images of the fluorescently labeled nucleotides, then the dye along with the terminal 3' blocker is chemically removed from the DNA, allowing the next cycle.[63] An alternative approach, ion semiconductor sequencing, is based on standard DNA replication chemistry. This technology measures the release of a hydrogen ion each time a base is incorporated. A microwell containing template DNA is flooded with a single nucleotide, if the nucleotide is complementary to the template strand it will be incorporated and a hydrogen ion will be released. This release triggers an ISFET ion sensor. If a homopolymer is present in the template sequence multiple nucleotides will be incorporated in a single flood cycle, and the detected electrical signal will be proportionally higher.[64] Assembly Main article: Sequence assembly  Overlapping reads form contigs; contigs and gaps of known length form scaffolds.  Paired end reads of next generation sequencing data mapped to a reference genome. Multiple, fragmented sequence reads must be assembled together on the basis of their overlapping areas. Sequence assembly refers to aligning and merging fragments of a much longer DNA sequence in order to reconstruct the original sequence.[9] This is needed as current DNA sequencing technology cannot read whole genomes as a continuous sequence, but rather reads small pieces of between 20 and 1000 bases, depending on the technology used. Third generation sequencing technologies such as PacBio or Oxford Nanopore routinely generate sequencing reads 10-100 kb in length; however, they have a high error rate at approximately 1 percent.[65][66] Typically the short fragments, called reads, result from shotgun sequencing genomic DNA, or gene transcripts (ESTs).[9] Assembly approaches Assembly can be broadly categorized into two approaches: de novo assembly, for genomes which are not similar to any sequenced in the past, and comparative assembly, which uses the existing sequence of a closely related organism as a reference during assembly.[54] Relative to comparative assembly, de novo assembly is computationally difficult (NP-hard), making it less favourable for short-read NGS technologies. Within the de novo assembly paradigm there are two primary strategies for assembly, Eulerian path strategies, and overlap-layout-consensus (OLC) strategies. OLC strategies ultimately try to create a Hamiltonian path through an overlap graph which is an NP-hard problem. Eulerian path strategies are computationally more tractable because they try to find a Eulerian path through a deBruijn graph.[54] Finishing Finished genomes are defined as having a single contiguous sequence with no ambiguities representing each replicon.[67] Annotation Main article: Genome annotation The DNA sequence assembly alone is of little value without additional analysis.[9] Genome annotation is the process of attaching biological information to sequences, and consists of three main steps:[68] identifying portions of the genome that do not code for proteins identifying elements on the genome, a process called gene prediction, and attaching biological information to these elements. Automatic annotation tools try to perform these steps in silico, as opposed to manual annotation (a.k.a. curation) which involves human expertise and potential experimental verification.[69] Ideally, these approaches co-exist and complement each other in the same annotation pipeline (also see below). Traditionally, the basic level of annotation is using BLAST for finding similarities, and then annotating genomes based on homologues.[9] More recently, additional information is added to the annotation platform. The additional information allows manual annotators to deconvolute discrepancies between genes that are given the same annotation. Some databases use genome context information, similarity scores, experimental data, and integrations of other resources to provide genome annotations through their Subsystems approach. Other databases (e.g. Ensembl) rely on both curated data sources as well as a range of software tools in their automated genome annotation pipeline.[70] Structural annotation consists of the identification of genomic elements, primarily ORFs and their localisation, or gene structure. Functional annotation consists of attaching biological information to genomic elements. Sequencing pipelines and databases The need for reproducibility and efficient management of the large amount of data associated with genome projects mean that computational pipelines have important applications in genomics.[71] |

ゲノム解析 主な記事 ゲノムプロジェクト ゲノムプロジェクトには、DNAの塩基配列の決定、その塩基配列を組み立てて元の染色体の表現を作成すること、そしてその表現の注釈付けと解析という3つ の要素が含まれる[9]。  ゲノムプロジェクトの概要 まず、ゲノムを選択しなければならないが、これにはコストや関連性などいくつかの要素が関係する。第二に、所定のシーケンスセンター(BGIやDOE JGIなど)で配列が作成され、組み立てられる。第三に、ゲノム配列はいくつかのレベルでアノテーションされる: DNA、タンパク質、遺伝子パスウェイ、比較などである。 シーケンス 主な記事 DNAシーケンス 歴史的には、シーケンシングはシーケンシングセンターで行われてきた。シーケンシングセンターは、集中型の施設(年間数十テラベースのシーケンシングを行 うJoint Genome Instituteのような大規模な独立機関から、地域の分子生物学コア施設まで)で、高価な装置と必要な技術サポートを備えた研究室を有している。しか し、シーケンシング技術が向上し続けるにつれて、新世代の効果的な高速ターンアラウンドのベンチトップシーケンサーは、平均的な学術研究室にも手が届くよ うになった[50][51]。全体として、ゲノムシーケンシングのアプローチは、ショットガンシーケンシングとハイスループットシーケンシング(または次 世代シーケンシング)の2つに大別される[9]。 ショットガンシーケンス  ABI PRISM 3100 Genetic Analyzer。このようなキャピラリーシーケンサーは、初期の大規模ゲノムシーケンス作業を自動化した。 主な記事 ショットガンシーケンス ショットガンシーケンスは、染色体全体を含む1000塩基対より長いDNA配列の解析用に設計されたシーケンス手法である[52]。ショットガンの急速に 拡大する準ランダム発射パターンになぞらえて命名された。ゲル電気泳動シーケンシングはかなり短い配列(100~1000塩基対)にしか使用できないた め、長いDNA配列はランダムな小さなセグメントに分割しなければならない。この断片化と塩基配列決定を数回繰り返すことで、標的DNAについて複数の重 複したリードが得られる。ショットガンシーケンスはランダムサンプリングプロセスであり、所定のヌクレオチドが再構築された配列に確実に含まれるようにす るにはオーバーサンプリングが必要である。 その歴史の大部分において、ショットガンシーケンスの基礎となる技術は古典的な鎖終結法または「サンガー法」であり、これはin vitroでのDNA複製中にDNAポリメラーゼが鎖終結ジデオキシヌクレオチドを選択的に組み込むことに基づく[23][55]。しかし、サンガー法 は、主に小規模なプロジェクトや、特に長い連続DNA配列リード(>500ヌクレオチド)を得るために広く使われている[56]。鎖終結法は、一本 鎖DNAテンプレート、DNAプライマー、DNAポリメラーゼ、通常のデオキシヌクレオシド三リン酸(dNTPs)、およびDNA鎖の伸長を終結させる修 飾ヌクレオチド(ジデオキシNTPs)を必要とする。これらの鎖終結ヌクレオチドは、2つのヌクレオチド間のホスホジエステル結合形成に必要な3'-OH 基を持たないため、ddNTPが組み込まれるとDNAポリメラーゼはDNAの伸長を停止する。ddNTPは、DNAシーケンサーで検出するために、放射性 標識または蛍光標識することができる[9]。通常、これらの装置は、1バッチ(ラン)で最大96のDNAサンプルを、1日に最大48回シーケンスすること ができる[57]。 ハイスループットシーケンス 以下も参照のこと: イルミナ色素シーケンスおよびイオン半導体シーケンス 低コストのシーケンシングに対する高い需要が、シーケンシングプロセスを並列化し、一度に数千から数百万のシーケンスを生成するハイスループットシーケン シング技術の開発を後押ししている[58][59]。ハイスループットシーケンシングは、標準的な色素ターミネーター法で可能な以上にDNAシーケンシン グのコストを下げることを目的としている。超高スループットシーケンスでは、50万ものシーケンスバイシンセシス操作が並行して実行される可能性がある [60][61]。  イルミナGenome Analyzer IIシステム。イルミナの技術は、ハイスループット大量並列シーケンスの標準となっている[50]。 イルミナの色素シーケンス法は、可逆的な色素ターミネーターに基づくもので、1996年にジュネーブ生物医学研究所でPascal MayerとLaurent Farinelliによって開発された[62]。この方法では、まずDNA分子とプライマーをスライド上に付着させ、ポリメラーゼで増幅することで、当初 「DNAコロニー」と呼ばれた局所的なクローンコロニーが形成される。塩基配列を決定するために、4種類の可逆的ターミネーター塩基(RT塩基)が付加さ れ、取り込まれなかったヌクレオチドは洗浄される。パイロシークエンシングとは異なり、DNA鎖は一度に1ヌクレオチドずつ伸長され、画像取得は遅れた瞬 間に行うことができるため、非常に大きなDNAコロニーのアレイを、1台のカメラから撮影した連続画像で捉えることができる。酵素反応と画像キャプチャを 切り離すことで、最適なスループットと理論上無制限のシーケンス能力が可能になる。最適な構成では、装置の究極のスループットはカメラのA/D変換レート にのみ依存する。カメラは蛍光標識されたヌクレオチドの画像を撮影し、その後、末端の3'ブロッカーとともに色素がDNAから化学的に除去され、次のサイ クルが可能になる[63]。 イオン半導体シーケンシングという別のアプローチは、標準的なDNA複製化学に基づいている。この技術は、塩基が組み込まれるたびに水素イオンが放出され ることを測定する。鋳型DNAを含むマイクロウェルに1つのヌクレオチドを流し、そのヌクレオチドが鋳型鎖と相補的であれば取り込まれ、水素イオンが放出 される。この放出がISFETイオンセンサーのトリガーとなる。鋳型配列にホモポリマーが存在する場合、1回のフラッドサイクルで複数のヌクレオチドが取 り込まれ、それに比例して検出される電気信号も高くなる[64]。 アセンブリ 主な記事 配列アセンブリー  オーバーラップしたリードはコンティグを形成し、コンティグと既知の長さのギャップはスキャフォールドを形成する。  次世代シーケンスデータのペアエンドリードを参照ゲノムにマッピングする。 断片化された複数のシーケンスリードは、重複する領域を基にアセンブルする必要がある。 配列アセンブリーとは、元の配列を再構築するために、はるかに長いDNA配列の断片を整列させて結合することを指す[9]。現在のDNAシーケンス技術で は、ゲノム全体を連続した配列として読み取ることができず、使用する技術によって20塩基から1000塩基の小さな断片を読み取るため、この作業が必要と なる。PacBioやOxford Nanoporeなどの第3世代シーケンシング技術では、長さ10~100kbのシーケンシングリードを日常的に生成しているが、エラー率は約1%と高い [65][66]。一般的に、リードと呼ばれる短い断片は、ゲノムDNAや遺伝子転写産物(EST)をショットガンでシーケンシングした結果である [9]。 アセンブルアプローチ アセンブルは、過去に配列決定されたゲノムと類似していないゲノムを対象とするde novoアセンブルと、アセンブル時に近縁の生物の既存の配列を参照として使用する比較アセンブルの2つのアプローチに大別される[54]。比較アセンブ ルと比較して、de novoアセンブルは計算が難しく(NP-hard)、ショートリードNGS技術には不向きである。de novoアセンブリーのパラダイムには、オイラーパス戦略とオーバーラップ・レイアウト・コンセンサス(OLC)戦略という2つの主要なアセンブリー戦略 がある。OLC戦略は、最終的にオーバーラップグラフを通るハミルトニアン経路を作成しようとするもので、NP困難問題である。オイラーパス戦略は、 deBruijnグラフを通るオイラーパスを見つけようとするため、計算上より扱いやすい[54]。 フィニッシング 完成したゲノムは、各レプリコンを表すあいまいさのない単一の連続した配列を持つものと定義される[67]。 注釈付け(→ゲノムアノテーション) 主な記事 ゲノムアノテーション ゲノムアノテーションとは、配列に生物学的情報を付加するプロセスであり、主に以下の3つのステップからなる[68]。 タンパク質をコードしていないゲノム部分を特定する。 ゲノム上のエレメントを同定する(遺伝子予測と呼ばれるプロセス)。 これらの要素に生物学的情報を付加する。 自動アノテーションツールは、これらのステップをインシリコで実行しようとするものであり、人間の専門知識と潜在的な実験的検証を伴う手動アノテーション (別名キュレーション)とは対照的である[69]。理想的には、これらのアプローチは同じアノテーションパイプラインの中で共存し、互いに補完し合う(下 記も参照)。 伝統的に、基本的なアノテーションレベルは、類似性を見つけるためにBLASTを使用し、相同性に基づいてゲノムをアノテーションすることである。この追 加情報により、同じアノテーションが付与された遺伝子間の矛盾を手作業で解決することができる。データベースによっては、ゲノムコンテキスト情報、類似度 スコア、実験データ、他のリソースの統合を利用して、Subsystemsアプローチでゲノムアノテーションを提供している。他のデータベース (Ensemblなど)は、自動化されたゲノムアノテーションパイプラインにおいて、様々なソフトウェアツールだけでなく、キュレートされたデータソース の両方に依存している[70]。構造アノテーションは、ゲノム要素、主にORFとその局在、または遺伝子構造の同定からなる。機能アノテーションは、ゲノ ム要素に生物学的情報を付加することである。 シーケンスパイプラインとデータベース ゲノムプロジェクトに関連する大量のデータの再現性と効率的な管理の必要性から、計算パイプラインはゲノミクスにおいて重要な用途を持つ[71]。 |

| 続きは、https://en.wikipedia.org/wiki/Genomics |

続きは「ゲノミクス」

へ |

●現代の骨相学:ゲノムサイエンス

東京大学の医科学研究所のヒトゲノム解析センター (Human Genome Center)は次のように その学問の目的がかかれてある(2021年3月19日採集)。

"The purpose of human genome research is to contribute to our human society through the diagnosis, prevention, and development of treatment methods for cancer, infectious diseases and other difficult diseases. The mission of the center is to promote this human genome research, greatly develop genomic medicine, and establish a new genomic medicine in the Society 5.0 era, and simultaneously build their foundations. To that end, we promote genomic medical science, medical informatics, artificial intelligence research for clinical translation of genomic information, and research on ethical, legal, and social issues. In addition, we operate a supercomputer system SHIROKANE for all researchers in life science regardless of academic or non-academic institutions/companies, and at the same time, provide seminars such as technical guidance course for users. We also accept researchers aiming at genomic research from all over the world and provide intensive courses for training." https://www.ims.u-tokyo.ac.jp/imsut/en/lab/hgclink/index.html

「ヒトゲノム研究の目的は、がんや感染症などの難治

性疾患の診断、予防、治療法の開発を通じて、人類社会に貢献することである。当センターの使命は、このヒトゲノム研究を推進し、ゲノム医療を飛躍的に発展

させ、Society

5.0時代の新しいゲノム医療を確立することであり、同時にその基盤を構築することである。そのため、ゲノム医療科学、医療情報学、ゲノム情報の臨床応用

に向けた人工知能研究、倫理・法・社会問題研究を推進している。また、学術・非学術機関・企業を問わず、生命科学の研究者向けにスーパーコンピュータシス

テム「SHIROKANE」を運用し、同時に利用者向け技術講習会などのセミナーも実施している。また、ゲノム研究を目指す世界中の研究者を受け入れ、集

中的なトレーニングコースを提供している」

★DNA Myth

リンク

文献

その他の情報

Copyleft,

CC, Mitzub'ixi Quq Chi'j, 1996-2099